RGB-D SLAM系统评估的基准---TUM

翻译:A Benchmark for the Evaluation of RGB-D SLAM Systems

原文链接:https://www.researchgate.net/publication/261353760_A_benchmark_for_the_evaluation_of_RGB-D_SLAM_systems

摘要:

本文提出了一种用于RGB-D SLAM系统评估的新的基准。我们用运动捕捉系统的高精度、时间同步的地面真相相相机姿态记录了来自微软Kinect的大量图像序列。在视频帧速率(30赫兹)中,序列包含全传感器分辨率(640×480)的颜色和深度图像。从八个高速跟踪摄像机(100 Hz)的运动捕捉系统获得地面真实轨迹。数据集由记录在办公室环境和工业大厅中的39个序列组成。数据集涵盖了大量的场景和相机运动。我们提供的序列与缓慢运动调试以及更长的轨迹有无闭环。大多数序列是从手持Kinect中记录的,具有不受限制的6自由度运动,但我们还提供了安装在先锋3机器人上的Kinect的序列,该Kinect是在杂乱的室内环境中手动导航的。为了促进不同方法的比较,我们提供了用于视觉里程计系统漂移评估和SLAM系统全局姿态误差评估的自动评估工具。基准网站[1]包含所有数据、场景的详细描述、数据格式的规范、示例代码和评估工具。

介绍

公共数据集和基准极大地支持了对算法的科学评价和客观比较。在计算机视觉领域中成功的基准测试的几个例子已经表明,公共数据集和清晰的评估度量可以显著地帮助推动最先进的状态。在机器人技术中,一个高度相关的问题是所谓的同时定位(SLAM)问题,其目标是从传感器数据中恢复相机轨迹和地图。SLAM问题已经被详细研究了传感器,如声纳、激光、摄像机和飞行时间传感器。最近,新型低成本的RGB-D传感器,例如Kinect变得可用,并且使用这些传感器的第一SLAM系统已经出现[2]–[4]。其他算法专注于融合深度图到相干3D模型〔5〕。然而,所计算的3D模型的精度很大程度上取决于如何精确地确定个体相机姿态。有了这个数据集,我们提供了一个完整的基准,可以用来评估在RGB-D数据上的视觉SLAM和测距系统。为了刺激比较,我们提出两个评价指标,并提供自动评估工具。

我们的数据集包括39个序列,我们记录在两个不同的室内环境。每个序列包含颜色和深度图像,以及来自运动捕捉系统的地面真实轨迹。我们仔细校准和时间同步Kinect传感器到运动捕捉系统。校准后,我们测量运动捕捉系统的精度,以验证校准。所有数据可在创作共享属性许可证(CC-3)网上获得。

http://vision.in.tum.de/data/datasets/rgbd-dataset

该网站包含关于数据格式、校准数据和示例代码视频的附加信息,以便对数据集进行简单的视觉检查。

相关工作

同时定位和映射(或结构efrom-.)问题在机器人[6]-[12]和计算机视觉[9],[13]-[16]中都有很长的历史。过去已经探索了不同的传感器模式,包括2D激光扫描仪[17]、[18]、3D扫描仪[19]-[21]、单目相机[9]、[14]-[16]、[22]-[24]、立体声系统[25]、[26]以及最近RGB-D传感器,例如Microsoft Kinect[2]-[4]。

激光和摄像机的SLAM系统,有几个著名的数据集,如Freiburg、因特尔、rawseeds和newcollege集[ 27 ]–[29 ]。盖革等人。〔30〕最近提出了一种基于地面真实姿态的立体图像的视觉测径基准。然而,没有提供深度图,因此需要额外的预处理步骤。波梅洛等。〔31〕在运动捕捉工作室中记录了来自Kinect的无纹理点云的数据集。也有相关的鲍等人的工作。[32 ] WHO旨在评估语义映射和定位方法。然而,在他们的数据集从Kinect相机姿态估计的彩色图像,使地面真理是不够准确的为我们的目的。据我们所知,因此,我们的数据集是适合视觉SLAM的评价第一RGB-D数据集(和视觉里程计)系统,因为它包含的颜色和深度图像和相关的地面真实相机的姿势。我们的基准的早期版本是最近提出的[ 33 ]。从我们收到的反馈,我们扩展了原有的数据集的动态序列,更长的轨迹,并从安装在移动机器人Kinect记录序列。

仅次于数据本身,SLAM解决方案的基准测试需要合适的评估度量。一个常用的评价指标,甚至不需要地面真理是衡量内在的错误后,地图优化,如重投影误差或者,更普遍的是,2的χ错误[ 12 ],[ 34 ]。然而,明显低χ2错误不保证良好的地图或轨迹的准确估计,平凡不使用任何传感器的数据导致零误差。因此,从实践的角度,我们提倡类似于奥尔森等人。[ 34 ]:通过比较其输出评估整个系统的端到端性能(地图或轨迹)与地面的真相。例如,地图可以通过叠加在楼层平面图上并搜索差异来进行评估。虽然,在原则上,差分图像两者之间的映射可以自动计算[ 35 ],往往表现为只有肉眼判断寻找薄结构,扭结或鬼像双壁。

地图比较的选择是通过比较估计摄像机运动轨迹与真实评价SLAM系统。两种常用的方法是相对位姿误差(RPE)和绝对轨迹误差(ATE)。RPE测量估计运动与真实运动之间的差异。它可以用来评估一个视觉测距系统[ 36 ]或闭合环的SLAM系统[ 37 ]精度的漂移,[ 38 ]如果只有稀疏尤其有用,相对关系可作为地面真理。而不是评估相对构成差异,ATE首先对齐两轨迹并评价直接绝对构成差异。这种方法很适合视觉SLAM系统[ 34 ] [ 39 ]的评价,但需要绝对的真实姿态是可用的。当我们提供密集和绝对地面真理轨迹,这两种度量是适用的。对于这两种措施,我们提供了一个参考实现,计算各自的错误估计与地面真实轨迹。

在本文中,我们提出了一个新的基准评估的视觉SLAM和视觉测距系统上的RGB-D数据。灵感来自于成功的基准,在计算机视觉等明德光流数据[ 40 ]和[ 30 ]在视觉的基准测试套件,我们打出了集分为训练和测试的一部分。当训练序列进行离线评估完全可用,测试序列只能评估基准网站[ 1 ]避免过度拟合。

数据集

Kinect传感器由近红外激光、红外摄像机和彩色摄像机组成,近红外激光将折射图案投射到场景中。由于投影模式是已知的,有可能使用块匹配技术来计算视差。注意,图像校正和块匹配在硬件中实现并且在传感器内部发生。

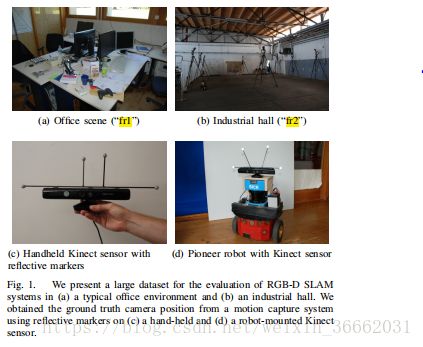

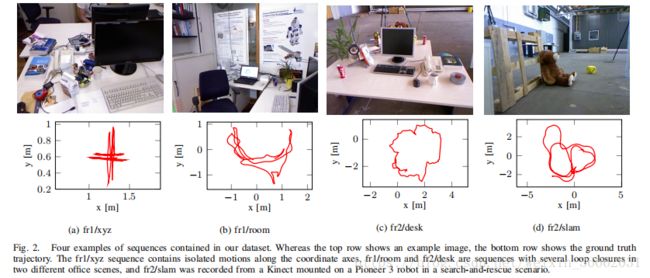

我们从Kinect获得了包含RGB-D数据和从运动捕获系统获得的地面真实姿态估计的大量数据序列。我们在典型的办公环境(“fr1”,6×6m2)和大型工业大厅(“fr2”,10×12m2)中记录了这些轨迹,如图1所示。在大多数录音中,我们使用手持式Kinect来浏览场景。此外,我们还记录了安装在轮式机器人上的Kinect的附加序列。表I总结了19个训练序列的统计数据,图2显示了四的图像。

它们伴随着相应的摄像机轨迹。平均而言,FR1序列的相机速度高于FR2的相机速度。除了特别指出之外,我们确保每个序列包含几个循环闭合,以允许SLAM系统识别之前访问过的区域,并使用它来减少相机漂移。我们将记录的序列分为“校准”、“测试和调试”、“手持式SLAM”和“机器人SLAM”。

在下文中,我们简要总结了根据这些类别的记录序列。

a)校准:为了校准Kinect和运动捕获系统的内部和外部参数,我们为每个Kinect记录

●一个序列,带有由固定Kinect记录的具有20mm平方尺寸的手持式8×6棋盘的颜色和深度图像,

●用一个固定的Kinect记录一个手持8×6棋盘的具有20平方毫米大小的红外图像的一个序列,

●一个序列,带有由手持Kinect记录的108mm正方形的8×7固定棋盘的颜色和深度图像。

b)测试和调试:这些序列旨在促进沿Kinect主轴和围绕Kinect主轴分别运动的新算法的开发。在“xyz”序列中,相机大致沿着X-、Y-和Z-轴(左/右、上/下、前/后)移动,几乎没有转动部件(参见图2a)。类似地,在两个“rpy”(摇摆-俯仰-偏航)序列中,相机大多仅围绕主轴旋转,几乎没有平移运动。

C)手持式SLAM:我们用手持式Kinect,即6自由度摄像机运动记录了11个序列。对于“FR1/360”序列,我们通过在房间的中心摇动Kinect来覆盖整个办公室。“FR1/地板”序列包含相机扫过木地板。“fr1/desk”、“fr1/desk2”和“fr1/.”序列分别覆盖两张桌子、四张桌子和整个房间(参见图2b)。在“fr2/360半球”序列中,我们在现场旋转Kinect,并将其指向工业大厅的墙壁和天花板。在“fr2/360绑架”序列中,我们用手简单地覆盖传感器几秒钟,以测试SLAM系统从传感器故障中恢复的能力。对于“fr2/desk”序列,我们在运动捕捉区域中间设置了一个办公环境,该环境由两个表组成,这些表具有各种附件,如监视器、键盘、书籍,参见图2c。在一个课桌上,不断地移动几个物体。

此外,我们记录了两个大型旅行通过工业大厅,部分具有较差的照明和很少的视觉特征。在“FR2/大无回路”序列中,特别注意在轨迹中不存在视觉重叠。我们的目的是提供一个序列来测量长期漂移(否则循环闭合)SLAM系统。相反,“fr2/.with.”序列在序列的开始和结束之间有很大的重叠,因此存在较大的循环。应该指出的是,这些游览是如此之大,以至于我们不得不离开工业大厅中间的运动捕捉区。因此,地面真实姿态信息只存在于序列的开始和结束。

D)机器人SLAM:我们还记录了四个序列,其中Kinect安装在ActudiMeLoad先锋3机器人上(见图1D)。有了这些序列,就有可能证明SLAM系统对轮式机器人的适用性。我们把Kinect水平对准,向前看机器人的驱动方向,这样地平线大致位于图像的中心。注意,Kinect的运动并不严格限于平面,因为偶尔的震动(由于地板上的颠簸和电线的结果)偏转了Kinect的方向。在记录过程中,我们手动通过场景手动操纵机器人。

在“FR2/先锋360”序列中,我们驾驶机器人绕着(主要是)空大厅的中心兜圈子。由于大厅的大尺寸,Kinect不能观察到部分序列的远壁的深度。此外,我们在大厅中设置了一个搜索和救援场景,该场景由几个办公容器、箱子和其他功能较差的对象组成,参见图2d。因此,这些序列具有深度,但是对于依赖于特定关键点的方法极具挑战性。三个序列“fr2/pioneer slam”、“fr2/pioneer slam2”和“fr2/pioneer slam3”在实际轨迹上不同,但是都包含几个循环闭包。

数据采集

所有数据都以全分辨率(640×480)和全帧速率(30Hz)记录在Linux笔记本电脑上,运行Ubuntu 10.10和ROS Diamondback。为了记录RGB-D数据,我们使用了两个不同的现成的Microsoft Kinect传感器(一个用于“fr1”序列,另一个用于“fr2”)。为了访问颜色和深度图像,我们在ROS中使用openni相机包,它内部包装PrimeSense的OpenNI驱动程序[41]。由于从两个不同的照相机观察深度图像和彩色图像,所以所观察(原始)图像最初不对准。为了达到这个目的,OpenNI驱动程序可以自动地使用Z缓冲器将深度图像注册到彩色图像。这是通过将深度图像投影到3D并随后将其投影到彩色摄像机的视图来实现的。OpenNI驱动程序用于此注册,工厂校准存储在内部存储器上。此外,我们使用Kinect Aux驱动程序记录Kinect在500赫兹的加速度计数据。

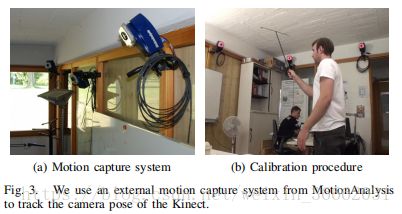

为了获得Kinect传感器的相机姿态,我们使用了来自运动分析(42)的外部运动捕捉系统。我们的设置包括八个RAPTRO-E相机,相机分辨率高达1280×1024像素,高达300赫兹(见图3A)。运动捕捉系统通过三角测量跟踪被动标记的三维位置。为了增强这些标记的对比度,运动捕捉相机配备有红外LED来照亮场景。我们验证了Kinect和运动捕获系统不干扰:运动捕获LED在Kinect红外图像中表现为暗灯,对生成的深度图没有影响,而Kinect的投影仪完全没有被运动捕获相机检测到。最后,我们还用外部摄像机录下了所有实验,从不同的角度捕捉摄像机的运动和场景。所有的序列和电影可在我们的网站[ 1 ]。

文件格式、工具和示例代码

每个序列作为单个压缩TGZ存档提供,它由以下文件和文件夹组成:

“RGB//”:一个包含所有彩色图像的文件夹(PNG格式,3个通道,每个通道8位),

“depth/”:深度图像相同(PNG格式,1通道,每通道16位,按系数缩放的距离为5000),

“RGB .txt”:一个文本文件,具有连续的所有彩色图像列表(格式:时间戳文件名),

“depth.txt”:与深度图像相同(格式:时间戳文件名),

“IMU.TXT”:包含时间戳加速度计数据的文本文件(格式:时间戳FX FY FZ),

•“groundtruth..txt”:包含作为时间戳翻译向量和单位四元数(格式:timestamp tx ty tz qy qz qw)存储的地面真实轨迹的文本文件。

此外,所有序列还可以以ROS包格式1和移动机器人编程工具包(MRPT)2的罗拉格格式获得。此外,我们提供了一套有用的工具和示例代码在我们的网站上的数据关联,评估和转换[ 1 ]。

校准与同步

我们设置的所有组件,即彩色相机、深度传感器、运动捕捉系统都需要内部和外部校准。此外,由于各个传感器的预处理、缓冲和数据传输中的时间延迟,传感器消息的时间戳需要同步。

A.运动捕捉系统校准

我们使用运动分析软件(42)提供的皮层软件对运动捕捉系统进行校准。如图3b所示,校准过程需要在运动捕捉区域广泛地挥动带有三个标记的校准棒。从这些点对应,系统计算运动捕捉相机的姿态。为了验证此校准程序的结果,我们在两端装有长度约2米的金属杆,并检查其观察长度在运动捕捉区域的不同位置是否恒定。这个实验背后的想法是,如果并且仅当金属棒的长度在场景的所有部分中是恒定的,那么整个运动捕捉区域是欧几里德的。在本实验中,我们测量了棒子长度在整个运动捕捉区域7×7上的标准偏差1.96mm。由此和进一步的实验,我们得出运动捕捉系统的位置估计是高度精确的、欧几里德的并且随时间是稳定的。

B.Kinect标定

接下来,我们使用OpenCV库从“rgb”和“ir”校准序列估计彩色和红外相机的内部相机参数。通过这种标定,我们得到了两台相机的焦距(fx/fy)、光学中心(cx/cy)和畸变参数。这些参数在Tab中得到了总结。二。其次,我们通过比较RGB图像中棋盘上四个不同点的深度来验证Kinect的深度测量。如图4A所示,两个Kinects的值不完全匹配。

由校准RGB相机的棋盘探测器计算的实际深度,但尺度略有不同。在Tab中给出了深度图像的估计校正因子。二。我们已经将这个校正因子应用到数据集,因此不需要来自用户的进一步动作。我们评估了深度值中的残余噪声作为棋盘的距离的函数。实验的结果如图4b所示。从图中可以看出,深度值中的噪声在1cm左右直到2m距离,在5cm左右在4m距离。Kinect校准和由此产生的精度的详细分析最近已由SmiSek等人出版[43 ]。

C. Extrinsic校准

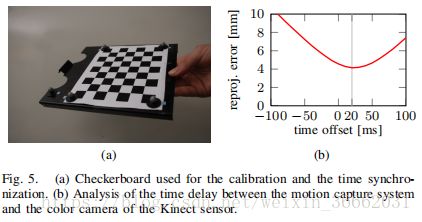

为了跟踪场景中的刚体(如Kinect传感器或棋盘),运动捕获系统需要至少三个反射标记。在我们的实验中,我们在每个Kinect传感器上附加了四个反射标记(参见图1c+1d)和校准棋盘上的五个标记(参见图5a)。我们将四个标记尽可能精确地放置在棋盘的外角,这样就可以知道视觉棋盘和运动捕捉标记之间的转换。给定这些点观测值和点模型,我们可以计算它相对于运动捕获系统的坐标系的姿态。

我们测量了点观测值与模型之间的平均误差,在办公室为0.60mm(“fr1”),在工业大厅为0.86mm(“fr2”)。考虑到这些噪声值,我们估计误差在0.34°和0.49°左右的估计方向上。虽然这个误差相当低,但读者应该记住,这意味着,在给定运动捕获系统的姿态(假设当前为无噪声的深度图像)的重建3D模型在距摄像机5米的距离内将分别具有30毫米和43毫米的误差。因此,我们强调运动捕捉系统的姿态估计不能直接用于生成(或评估)场景的高精度3D模型。然而,对于视觉SLAM系统的轨迹精度评价,绝对的亚毫米波和亚度精度足够高来评价当前(和潜在的未来)的艺术状态的方法。

作为下一个校准步骤,我们估计之间的位姿变换从运动捕捉系统和光学架的Kinect使用校准棋盘。我们验证了我们的校准测量的棋盘的四个角点的距离作为观察到的RGB图像的角点的动作捕捉系统预测。我们测量的平均误差为3.25毫米的“FR1”Kinect和4.03毫米的“FR2”Kinect。请注意,这些残留物含有噪声的运动捕捉系统诱导视觉棋盘检测引起的噪声。关于

高精度的运动捕捉系统,我们将这些误差主要归因于棋盘检波器的(零均值)噪声。

根据我们在校准期间获得的测量结果,我们得出结论,在地面真值数据中,帧到帧的相对误差低于在Kinect的光学中心测量的1mm和0.5°。此外,整个运动捕捉区域的绝对误差小于10mm和0.5°,因此,只要这些系统具有(RPE和ATE)明显高于这些值的误差,我们的数据集对于评估视觉里程计和可视化SLAM系统的性能是有效的。

D.时间同步

我们使用相同的方法确定运动捕获系统和Kinect的彩色相机之间的时间延迟,即,我们评估不同时间延迟的残差以确定延迟(参见图5b)。在这个实验中,我们发现来自运动捕捉系统的姿态比Kinect的彩色图像早大约20ms。我们已经在数据集中对这个延迟进行了校正,因此用户不需要进一步的动作。

Kinect递送的颜色和深度图像之间也存在小的时间延迟。在对我们自己的SLAM和视觉里程计系统进行评估时,我们发现深度图像平均比彩色图像晚20ms左右。然而,我们决定保持未修改的时间戳的颜色和深度图像在数据集。为了简化用户对颜色和深度图像的关联,我们提供了“associate.py”脚本,该脚本根据用户偏好(如时间偏移和最大时差)输出颜色和深度图像对。

用户应该记住的图像数据中的另一个挑战是,Kinect为彩色相机使用滚动快门,当相机快速移动时可能导致图像失真。由于Kinect根据场景照明自动选择曝光时间,因此这种效果的强度在数据集中的一些序列中可以显著变化。

评价指标

SLAM系统通常输出所估计的摄像机轨迹以及所得到的MAP的估计。虽然原则上可以评估所得地图的质量,但是很难获得准确的地面真值图。因此,我们建议从给定的RGBD图像的输入序列来估计估计轨迹的质量。该方法大大简化了评价过程。然而,应当指出,好的轨迹并不一定意味着好的地图,例如,即使地图上的一个小错误也可能阻止机器人在环境(门口的障碍)中工作。对于评估,我们假设我们从估计轨迹P1,给出了一系列姿态。…PN-SE(3)和地面真实轨迹Q1,。…,QN SE(3)。为了简化记法,我们假设序列是时间同步的,均等地采样,并且都具有长度n。实际上,这两个序列通常具有不同的采样率、长度和潜在的缺失数据,因此额外的数据关联和插值步骤是r相等的。这两个序列由表示RGB光学帧的姿态的齐次变换矩阵组成。

Kinect从(任意)参考帧。对于两个序列,该参考帧不必相同,即,估计序列可以始于原点,而地面真值序列是在校准期间定义的绝对坐标帧。虽然原则上,Kinect上的参考帧的选择也是任意的,但我们决定使用RGB光学帧作为参考,因为我们数据集中的深度图像已经注册到这个帧中。在本节的其余部分,我们定义了两种常用的视觉测距和视觉SLAM评价的评价指标。对于两个评估度量,我们提供易于使用的评估脚本,以便在我们的网站上下载,以及该脚本的在线版本,以简化和标准化用户的评估过程。

A 相对位姿误差(RPE)

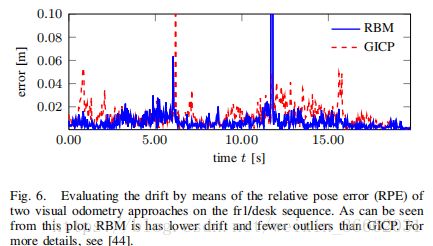

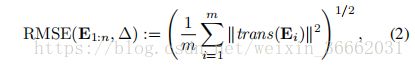

相对位姿误差在一定的时间间隔内测量轨迹的局部精度。因此,相对位姿误差对应的轨迹,这是特别有用的视觉里程计系统评价的漂移。在时间步长I中定义相对位姿误差。

从N个摄像机姿态序列中,我们得到了沿序列的m=n=个体相对位姿误差。根据这些误差,我们建议计算平移分量的所有时间索引上的均方根误差(RMSE),如

其中反式(EI)指的是相对位姿误差Ei的平移分量。应该指出的是,一些研究者更喜欢评估平均误差,而不是对离群值影响较小的均方根误差。或者,也可以计算中值而不是均值,这对离群值的影响更小。如果需要,还可以评估旋转误差,但是通常我们发现通过平移误差的比较就足够了(因为当相机移动时,旋转误差表现为平移误差)。

此外,还需要选择时间参数。对于匹配连续帧的视觉里程测量系统,=1是一个直观的选择;然后RMSE(E1:n)给出漂移perframe。对于使用多于一个先前帧的系统,较大的_值也可以是适当的,例如,=30给出以30Hz记录的序列的每秒漂移。应当注意,一个常见的(但是很糟糕的)选择是设置=n,这意味着开始点与结束点直接进行比较。这个度量可能会产生误导,因为它惩罚了轨迹开始时的旋转误差,而不是朝向终点[37]、[45]。对于SLAM系统的评估,因此平均而言是有意义的。

可能的时间间隔,即,计算

注意,该表达式的计算复杂度在轨迹长度上是二次的。因此,我们建议通过从固定的相对姿态样本中计算它来近似它。我们的自动评估脚本允许精确的评估以及对给定数量的样本的近似。在图6中给出了相对位姿误差的一个例子。这里,相对姿态误差已经被评估为两个视觉测径方法〔44〕。从这个图中可以看出,与GICP相比,RBM方法具有更低的漂移和更少的离群值。

B:绝对轨迹误差(ATE)

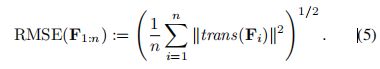

另外,对于视觉SLAM系统,估计轨迹的全局一致性是一个重要的量。全局一致性可以通过比较估计和地面真实轨迹之间的绝对距离来评估。由于两个轨迹都可以在任意坐标系中指定,所以它们首先需要对齐。这可以使用HORM〔46〕的方法在闭合形式下实现,它找到刚体变换S对应于最小二乘解,该映射将估计轨迹P1:N映射到地面真轨迹Q1:n。步骤i可以计算为

与相对位姿误差相似,我们建议在平移分量的所有时间指标上计算均方根误差,即,

在图7a中给出了绝对轨迹误差的可视化表示。

或者,也可以使用RPE通过平均所有可能的时间间隔来评估轨迹的全局误差。注意,RPE考虑平移和旋转误差,而ATE只考虑平移误差。结果,RPE总是比ATE稍大(或者如果没有旋转误差相等)。这在图7b中也是可视化的,其中RPE和ATE都是根据RGB-D SLAM系统的各种估计轨迹计算的。因此,RPE度量提供了一种优雅的方式将旋转和平移误差合并成一个单一的度量。然而,旋转误差通常也以错误的翻译表现出来,因此也间接地被ATE捕获。从实用的角度来看,ATE具有直观的可视化,便于视觉检查。然而,这两个指标是紧密相关的:在我们的所有实验中,我们从未遇到使用RPE和ATE的情况之间的实质性差异。事实上,通常相对顺序与实际使用的方法保持独立。

结论

在本文中,我们提出了一个基准的RGB-D SLAM系统的评价。数据集包含彩色图像、深度图和相关地面真实摄像机姿态信息。此外,我们提出了两个评估指标,可用于评估视觉里程计和可视化SLAM系统的性能。精确的校准和严格的验证确保了所得到的数据集的高质量。我们通过对自己最近的方法[44]、[47]的评价来验证数据集和相应的评估度量的有效性。最后,我们提出了一个高质量的数据集,它具有一组合适的评估度量,构成了一个可视化SLAM系统评估的完整基准。

致谢

作者想感谢Jorg M·Uulle和米迦勒·Runnk的帮助和支持与运动捕捉系统。此外,我们感谢弗兰克·斯坦布鲁克、雷纳·库默尔、圣伊潘·马格纳特、弗朗西斯·科拉斯和弗朗索瓦·波默洛富有成果的讨论。我们还感谢Jose Luis Blanco通过将数据集转换为RAWLOG格式,使得移动机器人编程工具包(MRPT)的用户能够使用我们的数据集。

参考文献

[1] http://vision.in.tum.de/data/datasets/rgbd-dataset.

[2] P. Henry, M. Krainin, E. Herbst, X. Ren, and D. Fox, “RGB-D mapping: Using depth cameras for dense 3D modeling of indoor environments,” in Intl. Symp. on Experimental Robotics (ISER), 2010.

[3] N. Engelhard, F. Endres, J. Hess, J. Sturm, and W. Burgard, “Realtime 3D visual SLAM with a hand-held RGB-D camera,” in RGB-D Workshop on 3D Perception in Robotics at the European Robotics Forum, 2011.

[4] C. Audras, A. Comport, M. Meilland, and P. Rives, “Real-time dense appearance-based SLAM for RGB-D sensors,” in Australasian Conf. on Robotics and Automation, 2011.

[5] R. Newcombe, S. Izadi, O. Hilliges, D. Molyneaux, D. Kim, A. Davison, P. Kohli, J. Shotton, S. Hodges, and A. Fitzgibbon, “KinectFusion: Real-time dense surface mapping and tracking,” in Intl. Symposium on Mixed and Augmented Reality (ISMAR), 2011.

[6] F. Lu and E. Milios, “Globally consistent range scan alignment for environment mapping,” Autonomous Robots, vol. 4, no. 4, pp. 333– 349, 1997.

[7] F. Dellaert, “Square root SAM,” in Proc. of Robotics: Science and Systems (RSS), Cambridge, MA, USA, 2005.

[8] E. Olson, J. Leonard, and S. Teller, “Fast iterative optimization of pose graphs with poor initial estimates,” in IEEE Intl. Conf. on Robotics and Automation (ICRA), 2006.

[9] G. Klein and D. Murray, “Parallel tracking and mapping for small AR workspaces,” in IEEE and ACM Intl. Symposium on Mixed and Augmented Reality (ISMAR), 2007.

[10] M. Kaess, A. Ranganathan, and F. Dellaert, “iSAM: Incremental smoothing and mapping,” IEEE Trans. on Robotics, TRO, vol. 24, no. 6, pp. 1365–1378, Dec 2008.

[11] G. Grisetti, C. Stachniss, and W. Burgard, “Non-linear constraint network optimization for efficient map learning,” IEEE Transactions on Intelligent Transportation systems, vol. 10, no. 3, pp. 428–439, 2009.

[12] R. Kummerle, G. Grisetti, H. Strasdat, K. Konolige, and W. Bur- ¨ gard, “g2o: A general framework for graph optimization,” in IEEE Intl. Conf. on Robotics and Automation (ICRA), 2011.

[13] H. Jin, P. Favaro, and S. Soatto, “Real-time 3-D motion and structure of point features: Front-end system for vision-based control and interaction,” in IEEE Conf. on Computer Vision and Pattern Recognition (CVPR), 2000.

[14] M. Pollefeys and L. Van Gool, “From images to 3D models,” Commun. ACM, vol. 45, pp. 50–55, July 2002.

[15] D. Nister, “Preemptive ransac for live structure and motion estimation,” ´Machine Vision and Applications, vol. 16, pp. 321–329, 2005.

[16] J. Stuhmer, S. Gumhold, and D. Cremers, “Real-time dense geometry ¨ from a handheld camera,” in DAGM Symposium on Pattern Recognition (DAGM), 2010.

[17] M. Montemerlo, S. Thrun, D. Koller, and B. Wegbreit, “FastSLAM:A factored solution to the simultaneous localization and mapping problem,” in Prof. of the National Conf. on Artificial Intelligence (AAAI), 2002.

[18] G. Grisetti, C. Stachniss, and W. Burgard, “Improved techniques for grid mapping with rao-blackwellized particle filters,” IEEE Transactions on Robotics (T-RO), vol. 23, pp. 34–46, 2007.

[19] A. Nuchter, K. Lingemann, J. Hertzberg, and H. Surmann, “6D SLAM ¨ – 3D mapping outdoor environments: Research articles,” J. Field Robot., vol. 24, pp. 699–722, August 2007.

[20] M. Magnusson, H. Andreasson, A. Nuchter, and A. Lilienthal, “Auto- ¨matic appearance-based loop detection from 3D laser data using the normal distributions transform,” Journal of Field Robotics, vol. 26, no.11–12, pp. 892–914, 2009.

[21] A. Segal, D. Haehnel, and S. Thrun, “Generalized-icp,” in Robotics: Science and Systems (RSS), 2009.

[22] K. Koeser, B. Bartczak, and R. Koch, “An analysis-by-synthesis camera tracking approach based on free-form surfaces,” in German Conf. on Pattern Recognition (DAGM), 2007.

[23] K. Konolige and J. Bowman, “Towards lifelong visual maps,” in IEEE/RSJ Intl. Conf. on Intelligent Robots and Systems (IROS), 2009.

[24] H. Strasdat, J. Montiel, and A. Davison, “Scale drift-aware large scale monocular SLAM,” in Proc. of Robotics: Science and Systems (RSS),2010.

[25] K. Konolige, M. Agrawal, R. Bolles, C. Cowan, M. Fischler, and B. Gerkey, “Outdoor mapping and navigation using stereo vision,” in Intl. Symp. on Experimental Robotics (ISER), 2007.

[26] A. Comport, E. Malis, and P. Rives, “Real-time quadrifocal visual odometry,” Intl. Journal of Robotics Research (IJRR), vol. 29, pp. 245–266, 2010.

[27] C. Stachniss, P. Beeson, D. Hahnel, M. Bosse, J. Leonard, ¨ B. Steder, R. Kummerle, C. Dornhege, M. Ruhnke, G. Grisetti, ¨ and A. Kleiner, “Laser-based SLAM datasets.” [Online]. Available: http://OpenSLAM.org

[28] “The Rawseeds project,” http://www.rawseeds.org/rs/datasets/.

[29] M. Smith, I. Baldwin, W. Churchill, R. Paul, and P. Newman, “The new college vision and laser data set,” Intl. Journal of Robotics Research (IJRR), vol. 28, no. 5, pp. 595–599, 2009.

[30] A. Geiger, P. Lenz, and R. Urtasun, “Are we ready for autonomous driving? the KITTI vision benchmark suite,” in IEEE Conf. on Computer Vision and Pattern Recognition (CVPR), Providence, USA,

June 2012.

[31] F. Pomerleau, S. Magnenat, F. Colas, M. Liu, and R. Siegwart, “Tracking a depth camera: Parameter exploration for fast ICP,” in IEEE/RSJ Intl. Conf. on Intelligent Robots and Systems (IROS), 2011.

[32] S. Bao and S. Savarese, “Semantic structure from motion,” in IEEE Intl. Conf. on Computer Vision and Pattern Recognition (CVPR), 2011.

[33] J. Sturm, S. Magnenat, N. Engelhard, F. Pomerleau, F. Colas, W. Burgard, D. Cremers, and R. Siegwart, “Towards a benchmark for RGB-D SLAM evaluation,” in RGB-D Workshop on Advanced Reasoning with Depth Cameras at RSS, June 2011.

[34] E. Olson and M. Kaess, “Evaluating the performance of map optimization algorithms,” in RSS Workshop on Good Experimental Methodology in Robotics, 2009.

[35] R. Vincent, B. Limketkai, M. Eriksen, and T. De Candia, “SLAM in real applications,” in RSS Workshop on Automated SLAM Evaluation, 2011.

[36] K. Konolige, M. Agrawal, and J. Sola, “Large scale visual odometry ` for rough terrain,” in Intl. Symposium on Robotics Research (ISER), 2007.

[37] R. Kummerle, B. Steder, C. Dornhege, M. Ruhnke, G. Grisetti, ¨ C. Stachniss, and A. Kleiner, “On measuring the accuracy of SLAM algorithms,” Autonomous Robots, vol. 27, pp. 387–407, 2009.

[38] W. Burgard, C. Stachniss, G. Grisetti, B. Steder, R. Kummerle, ¨ C. Dornhege, M. Ruhnke, A. Kleiner, and J. Tardos, “A comparison ´ of SLAM algorithms based on a graph of relations,” in IEEE/RSJ Intl. Conf. on Intelligent Robots and Systems (IROS), 2009.

[39] W. Wulf, A. Nuchter, J. Hertzberg, and B. Wagner, “Ground truth ¨evaluation of large urban 6D SLAM,” in IEEE/RSJ Intl. Conf. on Intelligent Robots and Systems (IROS), 2007.

[40] S. Baker, D. Scharstein, J. Lewis, S. Roth, M. Black, and R. Szeliski, “A database and evaluation methodology for optical flow,” Intl. Journal of Computer Vision (IJCV), vol. 92, no. 1, 2011.

[41] PrimeSense, Willow Garage, SideKick and Asus, “Introducing OpenNI,” http://http://www.openni.org.

[42] MotionAnalysis, “Raptor-E Digital RealTime System,” http://www.motionanalysis.com/html/industrial/raptore.html.

[43] J. Smisek, M. Jancosek, and T. Pajdla, “3D with Kinect,” in ICCV Workshop on Consumer Depth Cameras for Computer Vision, 2011.

[44] F. Steinbrucker, J. Sturm, and D. Cremers, “Real-time visual odometry ¨from dense RGB-D images,” in ICCV Workshop on Live Dense Reconstruction with Moving Cameras, 2011.

[45] A. Kelly, “Linearized error propagation in odometry,” Intl. Journal of Robotics Research (IJRR), vol. 23, no. 2, 2004.

[46] B. Horn, “Closed-form solution of absolute orientation using unit quaternions,” Journal of the Optical Society of America A, vol. 4, pp. 629–642, 1987.

[47] F. Endres, J. Hess, N. Engelhard, J. Sturm, D. Cremers, and W. Burgard, “An evaluation of the RGB-D SLAM system,” in IEEE Intl. Conf. on Robotics and Automation (ICRA), 2012