准备工作

- 首先安装好python(本文默认版本为3.6)

- 搭建python运行环境,加载第三方扩展库

pip install re # 正则表达式库

pip install collections # 词频统计库

pip install numpy # numpy数据处理库

pip install jieba # 结巴分词

pip install wordcloud # 词云展示库

pip install PIL # 图像处理库

pip install matplotlib.pyplot # 图像展示库

- 准备好打算统计文字的文件,命名为article.txt,保存到与程序文件相同目录中

- 准备一个做背景的图片,命名为background.jpg,同样保存到与程序文件相同目录中

编写代码

开启一个空python文件,命名为 wordcloud.py,输入如下代码

# 导入扩展库

import re # 正则表达式库

import collections # 词频统计库

import numpy as np # numpy数据处理库

import jieba # 结巴分词

import wordcloud # 词云展示库

from PIL import Image # 图像处理库

import matplotlib.pyplot as plt # 图像展示库

# 读取文件

fn = open('article.txt') # 打开文件

string_data = fn.read() # 读出整个文件

fn.close() # 关闭文件

# 文本预处理

pattern = re.compile(u'\t|\n|\.|-|:|;|\)|\(|\?|"') # 定义正则表达式匹配模式

string_data = re.sub(pattern, '', string_data) # 将符合模式的字符去除

# 文本分词

seg_list_exact = jieba.cut(string_data, cut_all = False) # 精确模式分词

object_list = []

remove_words = [u'的', u',',u'和', u'是', u'随着', u'对于',u'对',u'等',u'能',u'都',u'。',

u' ',u'、',u'中',u'在',u'了',u'通常',u'如果',u'我们',u'需要'] # 自定义去除词库

for word in seg_list_exact: # 循环读出每个分词

if word not in remove_words: # 如果不在去除词库中

object_list.append(word) # 分词追加到列表

# 词频统计

word_counts = collections.Counter(object_list) # 对分词做词频统计

word_counts_top10 = word_counts.most_common(10) # 获取前10最高频的词

print (word_counts_top10) # 输出检查

# 词频展示

mask = np.array(Image.open('background.jpg')) # 定义词频背景

wc = wordcloud.WordCloud(

background_color='white', # 设置背景颜色

font_path='/System/Library/Fonts/Hiragino Sans GB.ttc', # 设置字体格式

mask=mask, # 设置背景图

max_words=200, # 最多显示词数

max_font_size=100 , # 字体最大值

scale=32 # 调整图片清晰度,值越大越清楚

)

wc.generate_from_frequencies(word_counts) # 从字典生成词云

image_colors = wordcloud.ImageColorGenerator(mask) # 从背景图建立颜色方案

wc.recolor(color_func=image_colors) # 将词云颜色设置为背景图方案

wc.to_file("/Users/ownpro/Desktop/temp.jpg") # 将图片输出为文件

plt.imshow(wc) # 显示词云

plt.axis('off') # 关闭坐标轴

plt.show() # 显示图像

图片输出

图片没有正常显示 新手关于plt.savefig的用法

这里我用plt.savefig("生成图片的路径")来存储生成的云词图。

一开始,将plt.savefig放在plt.show之后,结果只是生成了空白的图。后来在这篇文章《【Python】解决使用plt.savefig保存图片时一片空白》中了解到:

“在plt.show() 后实际上已经创建了一个新的空白的图片(坐标轴),这时候你再plt.savefig() 就会保存这个新生成的空白图片。”

所以,只要把plt.savefig放在plt.show之前即可解决这个问题。

我生成云词图的最后几行代码如下:

plt.imshow(my_wc)

plt.axis("off")

plt.savefig("/Users/ownpro/Desktop/temp.jpg",dpi=200) # 用反斜杠的话会报错

plt.show()

另一种输出图像的方式 .to_file

在WordCloud中,自带.to_file可以将云词图输出到文件(文章源代码使用的方法)

具体方法:将上述代码中plt.savefig一行替换为

wc.to_file("H:/temp/temp.jpg")

即可。

可以发现两种输出方式的区别:

- plt.savefig默认尺寸是和终端中显示差不多的缩略版的图(大小432×288),可以通过dpi调节精度改善清晰度,具体可见本文中“图片大小和精度的影响”的描述。

- .to_file,则输出的是每个字都精确显示的完整云词图,非常清晰,放大后可以看到连最小的字都是清晰完整地显示,当然默认尺寸也很大。

为方便对比,可见本文后面“WordCloud参数的调节”这部分里scale=2(使用plt.savefig输出,dpi=200)、scale=32(使用plt.savefig输出,dpi=200)、scale=2(使用.to_file输出)的3个云词图。

生成图像清晰度的调节

图片大小和精度的影响

因为这次用plt.savefig默认生成的图感觉不是很清晰,尺寸不够大,所以这里在plt.savefig中加上了参数dpi调整精度。

当然,同样一张图,精度越高,自然尺寸也是越大的。

不过,至于精度调整成多少合适(只为了肉眼看起来清晰),是看情况而定。虽然理论上精度越大就越清晰,但是在遮罩图、词数量等因素确定的情况下,有时候更大的精度只是把图的尺寸放大,但肉眼可见的清晰程度并不会真的就提高。

如果图太小太密集,那么可能是默认精度的局限导致不清晰。需要调整精度参数dpi放大图片。

但是如果图片足够大,字看起来也不小,但是仍然不清晰,或者布局不自然,那么有可能是云词图生成时本身的参数设置问题。可见下面的描述。

WordCloud参数的调节

这里简要讲下几个会影响图像清晰问题的WordCloud的参数:

-

mask:遮罩图,字的大小布局和颜色都会依据遮罩图生成。其实理论上这对字大小和清晰程度的影响不大,但是遮罩图色和背景色background_color如果易混淆,则可能是一个导致看起来不清晰的因素;另外遮罩图自身各个颜色之间的对比不强烈,也可能使图看起来层次感不够。

- 比如,一些图明度比较高,再加上背景白色,有可能导致字色太浅(背景色

background_color又是白色)于是看起来不够“清晰”。

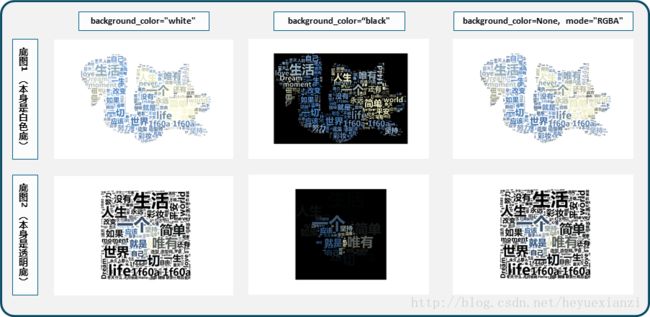

background_color:背景色,默认黑。这个本来其实也不怎么影响清晰度,但是,就像之前在mask中提到的,如果遮罩图像颜色过浅、背景设置白色,可能导致字看起来“不清晰”。而实际上,我对一个浅色遮罩图分别用白、黑两种背景色后发现,黑色背景的强烈对比之下会有若干很浅也很小的词浮现出来,而之前因背景色、字色过于相近而几乎无法用肉眼看出这些词。mode:默认“RGB”。根据说明文档,如果想设置透明底色的云词图,那么可以设置background_color=None, mode="RGBA"

生成云词图效果对比,除background_color和mode参数以外其它参数不变:

-

max_font_size:最大字号。源文件中也有讲到,图的生成会依据最大字号等因素去自动判断词的布局。经测试,哪怕同一个图像,只要图本身尺寸不一样(比如我把一个300×300的图拉大到600×600再去当遮罩),那么同样的字号也是会有不同的效果。原理想想也很自然,字号决定了字的尺寸,而图的尺寸变了以后,最大字相对于图的尺寸比例自然就变了。所以,需要根据期望显示的效果,去调整最大字号参数值。 -

min_font_size:最小字号。不设置的情况下,默认是4。尝试了设置比4大的字号,例如8、10,结果就是原本小于设定值且大于4号的词都直接不显示了,其它内容和未设置该值时都一样。 -

relative_scaling:表示词频和云词图中字大小的关系参数,默认0.5。为0时,表示只考虑词排序,而不考虑词频数;为1时,表示两倍词频的词也会用两倍字号显示。本文中的案例,均用的默认值,未特别设置该参数。 -

scale:根据说明文档,当云词图很大的,加大该值会比使用更大的图更快,但值越高也会越慢(计算更复杂)。默认值是1。实际测试中,更大的值,确实输出图像看起来更精细(较小较浅的词会颜色更重,也感觉清楚,大的词差异不明显)。不过,可能由于我选的图不大、词也没有很多,所以差距并没有很大,缩小排列一下就基本上辨别不出多少差别了。

- 经测试发现,在词没有很多(这里len(word_space_split)=6310)和图没有很大的情况下,词不变,图不变,则

scale越大,运行速度越慢。实际上,本案例中取“32”时已经比“2”慢了很多秒,这个时间差可以体会体会到,本文暂不对时间差和效率问题进行精确研究了。- 另外经测试发现,其它参数完全相同情况下,

scale越大,图片占空间越小。这里scale分别取“2”“10”“32”时,获得的图片大小分别为207K、110K、75.8K。(这里图用plt.savefig输出,dpi=200,实际输出尺寸为1200×800。)

下面scale分别取“2”“10”“32”的缩略效果:

是不是没看出什么区别?那么下面放下“

2”“

32”对应的云词图本身。

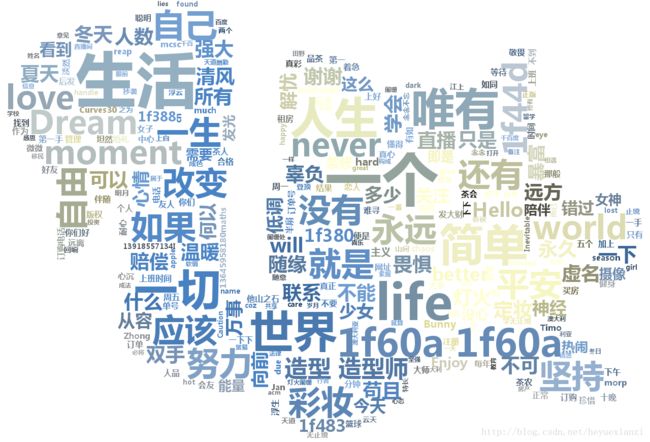

scale=2的云词图如下(使用

plt.savefig输出,

dpi=200):

scale=32的云词图如下(使用

plt.savefig输出,

dpi=200):

scale=2的云词图如下(使用

.to_file输出):

注:可以注意上面3个图中,右上方“唯有”字样的右上角“ 如同”字样(较小字)的显示差异,进行对比。

-

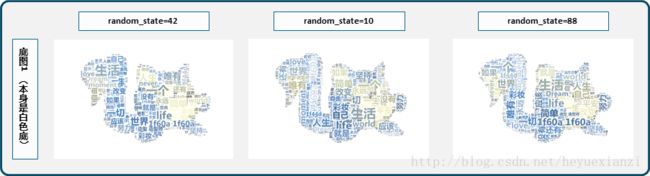

random_state:不同的值会让字图的分布不一样。

附上源文件wordcloud.py中对WordCloud这一函数的各个参数的解释:

Word cloud object for generating and drawing.

Parameters

----------

font_path : string

Font path to the font that will be used (OTF or TTF).

Defaults to DroidSansMono path on a Linux machine. If you are on

another OS or don't have this font, you need to adjust this path.

width : int (default=400)

Width of the canvas.

height : int (default=200)

Height of the canvas.

prefer_horizontal : float (default=0.90)

The ratio of times to try horizontal fitting as opposed to vertical.

If prefer_horizontal < 1, the algorithm will try rotating the word

if it doesn't fit. (There is currently no built-in way to get only

vertical words.)

mask : nd-array or None (default=None)

If not None, gives a binary mask on where to draw words. If mask is not

None, width and height will be ignored and the shape of mask will be

used instead. All white (#FF or #FFFFFF) entries will be considerd

"masked out" while other entries will be free to draw on. [This

changed in the most recent version!]

scale : float (default=1)

Scaling between computation and drawing. For large word-cloud images,

using scale instead of larger canvas size is significantly faster, but

might lead to a coarser fit for the words.

min_font_size : int (default=4)

Smallest font size to use. Will stop when there is no more room in this

size.

font_step : int (default=1)

Step size for the font. font_step > 1 might speed up computation but

give a worse fit.

max_words : number (default=200)

The maximum number of words.

stopwords : set of strings or None

The words that will be eliminated. If None, the build-in STOPWORDS

list will be used.

background_color : color value (default="black")

Background color for the word cloud image.

max_font_size : int or None (default=None)

Maximum font size for the largest word. If None, height of the image is

used.

mode : string (default="RGB")

Transparent background will be generated when mode is "RGBA" and

background_color is None.

relative_scaling : float (default=.5)

Importance of relative word frequencies for font-size. With

relative_scaling=0, only word-ranks are considered. With

relative_scaling=1, a word that is twice as frequent will have twice

the size. If you want to consider the word frequencies and not only

their rank, relative_scaling around .5 often looks good.

.. versionchanged: 2.0

Default is now 0.5.

color_func : callable, default=None

Callable with parameters word, font_size, position, orientation,

font_path, random_state that returns a PIL color for each word.

Overwrites "colormap".

See colormap for specifying a matplotlib colormap instead.

regexp : string or None (optional)

Regular expression to split the input text into tokens in process_text.

If None is specified, ``r"\w[\w']+"`` is used.

collocations : bool, default=True

Whether to include collocations (bigrams) of two words.

.. versionadded: 2.0

colormap : string or matplotlib colormap, default="viridis"

Matplotlib colormap to randomly draw colors from for each word.

Ignored if "color_func" is specified.

.. versionadded: 2.0

normalize_plurals : bool, default=True

Whether to remove trailing 's' from words. If True and a word

appears with and without a trailing 's', the one with trailing 's'

is removed and its counts are added to the version without

trailing 's' -- unless the word ends with 'ss'.

Attributes

----------

``words_`` : dict of string to float

Word tokens with associated frequency.

.. versionchanged: 2.0

``words_`` is now a dictionary

``layout_`` : list of tuples (string, int, (int, int), int, color))

Encodes the fitted word cloud. Encodes for each word the string, font

size, position, orientation and color.

Notes

-----

Larger canvases with make the code significantly slower. If you need a

large word cloud, try a lower canvas size, and set the scale parameter.

The algorithm might give more weight to the ranking of the words

than their actual frequencies, depending on the ``max_font_size`` and the

scaling heuristic.

转载自

作者:热锅上的刺猬

来源:CSDN

原文:https://blog.csdn.net/heyuexianzi/article/details/76851377