完整复现何恺明ICCV获奖论文结果并开源 !(附论文&开源代码)

![]()

整理自:AI科技评论、AI科技大本营、图森未来

本文长度为1434字,建议阅读3分钟

本文为你介绍何恺明ICCV 2017两篇获奖论文,并附上完整复现论文结果的开源代码!

ICCV 作为计算机视觉的顶级会议,2017年共收到2143篇论文投稿,比上一届ICCV2015的1698篇增加了26.2%。共621篇被选为大会论文,录用比例28.9%;poster、spotlight、oral 比例分别为24.61%、2.61%和2.09%。

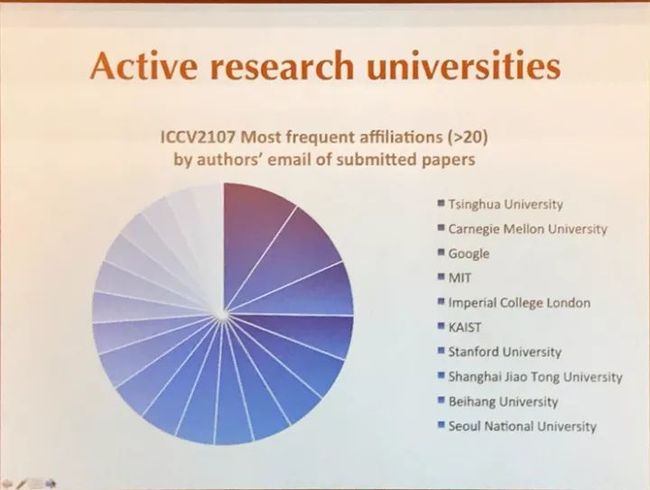

组委会根据作者署名统计了不同大学的研究数目,清华大学超过CMU、MIT、ICL、斯坦福以及谷歌名列第一,上海交通大学、北京航空航天大学也在前10当中。

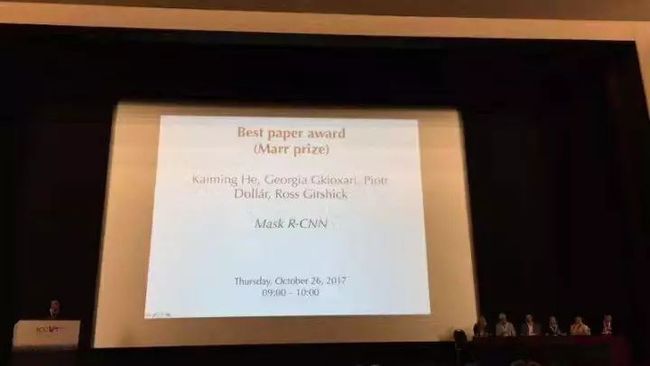

而此次大会最大的新闻一定是何恺明大神在 ICCV 上拿下了双best paper!继两次荣获 CVPR 最佳论文奖之后,何恺明参与的两篇最新论文又分别摘下 ICCV 2017 的最佳论文奖(Best Paper Award)和最佳学生论文(Best Student Paper Award)两项大奖。

这两篇获奖论文分别是今年 4 月发布的《Mask R-CNN》以及今年 8 月发布的《Focal Loss for Dense Object Detection》,两者都是今年发布,而且相隔仅仅 4 个月。要知道 ICCV 是计算机视觉领域顶级会议之一,且两年举办一次,而何恺明作为两篇论文的第一作者和第四作者,足以证明他的实力。

两篇获奖论文简介:

suorce:知乎

论文简介:我们提出了一个简单、灵活和通用的对象实例分割框架。我们的方法能有效检测图像中的对象,同时为每个实例生成高质量的 segmentation mask。这种被称为 Mask R-CNN 的方法通过添加用于预测 object mask 的分支来扩展 Faster R-CNN,该分支与用于边界框识别的现有分支并行。Mask R-CNN 训练简单,只需在以 5fps 运行的 Faster R-CNN 之上增加一个较小的 overhead。此外,Mask R-CNN 很容易推广到其他任务,例如它可以允许同一个框架中进行姿态估计。我们在 COCO 系列挑战的三个轨道任务中均取得了最佳成果,包括实例分割、边界对象检测和人关键点检测。没有任何 tricks,Mask R-CNN 的表现优于所有现有的单一模型取得的成绩,包括 COCO 2016 挑战赛的冠军。

论文地址:

https://arxiv.org/abs/1703.06870

suorce:知乎

论文简介:目前准确度最高的目标检测器采用的是一种常在 R-CNN 中使用的 two-stage 方法,这种方法将分类器应用于一个由候选目标位置组成的稀疏样本集。相反,one-stage 检测器则应用于一个由可能目标位置组成的规则密集样本集,而且更快更简单,但是准确度却落后于 two-stage 检测器。在本文中,我们探讨了造成这种现象的原因。

我们发现,在训练密集目标检测器的过程中出现的严重的 foreground-background 类别失衡,是造成这种现象的主要成因。我们解决这种类别失衡(class imbalance )的方案是,重塑标准交叉熵损失,使其减少分类清晰的样本的损失的权重。Focal Loss 将训练集中在一个稀疏的困难样本集上,并防止大量简单负样本在训练的过程中淹没检测器。为了评估该损失的有效性,我们设计并训练了一个简单的密集目标检测器—RetinaNet。试验结果证明,当使用 Focal Loss训练时,RetinaNet 不仅能赶上 one-stage 检测器的检测速度,而且还在准确度上超越了当前所有最先进的 two-stage 检测器。

我们提出了一种新的损失函数 Focal Loss(焦点损失),这个损失函数在标准的交叉熵标准上添加了一个因子 (1- pt) γ 。设定 γ > 0 可以减小分类清晰的样本的相对损失(pt > .5),使模型更加集中于困难的错误分类的样本。试验证明,在存在大量简单背景样本(background example)的情况下,我们提出的 Focal Loss 函数可以训练出准确度很高的密集对象检测器。

论文地址

https://arxiv.org/abs/1708.02002

大家纷纷表达对恺明大神的崇拜以及对最优秀的学术研究人员表达敬意。与此同时,很多从业者更关心的问题是:什么时候能看到开源代码?

一家AI科技企业——图森未来表示:致敬大神最好的方式,或许就是完整复现论文结果,然后再开源了。他们完整复现了何恺明大神的论文结果(Mask R-CNN 和 Feature Pyramid Network),并将对应代码进行了开源!这也是第一份能够完整复现何恺明大神论文结果的开源代码。

后台回复关键词“开源”,获取完整复现何恺明论文中结果的开源代码,希望能够给大家的工作带来帮助!

题外八卦何大神的开挂人生

![]()

此次ICCV获两项论文大奖并不是何恺明大神第一次展现他开挂的能力。

2003 年,何恺明以广东省理科高考状元的身份进入清华大学。

2009 年,在 IEEE 举办的 CVPR 大会上,还在微软亚研院(MSRA)实习的何恺明的第一篇论文“Single Image Haze Removal Using Dark Channel Prior”艳惊四座,获最佳论文,这是第一次完全由中国人组成的团队获得该奖项。

2016年,何恺明所在团队的另一篇论文“Deep Residual Learning for Image Recognition”再获 CVPR 最佳论文奖。

同年 8 月,何恺明离开 MSRA,加入 FAIR(Facebook AI Research),担任科学家。

在加入 Facebook 之后,何恺明马上又成为 Faster R-CNN 和 Mask R-CNN 的主要贡献者,根本没有适应期一说。

如今,何恺明又成为 ICCV 的最佳论文得主,再一次拉开与我等普通人的差距,让人望尘莫及。

然而,这还不是最令人绝望的,看看何恺明的微博,旅游、玩游戏......统统没有落下。所以说,大神终究是大神...

小编只能默默跪拜大神...

欢迎大家留言交流一下感想![]()

![]()