precision and recall

首先强调multi-class 和multi-label是不同的,前者是每个样本只属于一个类别,后者是每个样本可以有多个类别标记,即多个类别

在模式识别,信息检索,二分类等问题中常常需要对结果进行评价,评价的几个指标通常是准确率(accuracy),精确率(precision)和召回率(recall)

1、分类问题

举个二分类的问题,类别狗为正,猫为负。测试用例12只动物,7只狗,5只猫。识别出8只狗,4只猫,有5只确实是狗

TP:正确“地”标为正。本来为正而且识别为正的数量,比如识别出8只狗,有5只确实是狗,TP=5

FP:错误“地”标为正。本来为负却识别为正的数量,如上述例子剩余的3只实际是猫却识别为狗FP=3-------也叫误报,或一类错误

TP+FP表示识别为正(不管真是情况)的总数即8

TN:正确“地”标为负。把本来是负的确实识别为负的数量,上述例子识别出4只猫,有3只确实是猫即TN=8-5=3

FN:错误“地”标为负。把本来为正的识别为负的数量,如上述例子,识别为猫的有一只实际是狗FN=7-5=2-------也叫漏报,或二类错误

最重要的就是理解清楚上面TP,FP,TN,FN的含义

TP+FN表示“整个测试集中” “实际为正”的数量,如上述例子本来是狗识别为狗和本来为狗却识别为猫即7

上面的TF是用来表示识别正确性的,即T,F表示正确与否,P,N 表示正负类

精确率的含义是识别为正的所有数量中,正确是识别数量结果(识别为正,确实为正)所占的比例,也就是说识别为正的结果中,有的识别对了,有的识别错了,因此会有精确的问题

召回率的含义是正确识别为正的数量在测试集中正类总数中所占的比例,就是说,没有识别出所有位正的测试用例,因此是 “是否完全性” 的问题

In a classification task

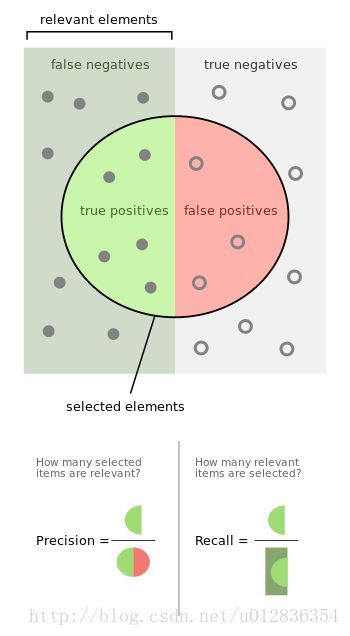

precision for a class is the number oftrue positives (i.e. the number of items correctly labeled as belonging to the positive class) divided by thetotal number of elements labeled as belonging to the positive class (i.e. the sum of true positives and false positives, which are items incorrectly labeled as belonging to the class).

Recall in this context is defined as the number oftrue positives divided by the total number of elements thatactually belong to the positive class (i.e. the sum of true positives and false negatives, which are items which were not labeled as belonging to the positive class but should have been).

2、检索问题

在文献检索的应用中,输入一个关键词,那么文献数据库中有一部分是相关的(事实上有相关性),根据关键词会检索出来一部分系统认为相关的文献,那么系统检索出来的文献会出现什么结果呢?最有可能的结果是检索出来的这些文献(系统认为相关)只有一部分事实相关,另外一部分不相关但系统误以为相关而被检索出来。在这种背景下,precision和recall的定义如下

分子表示检索出来的文献而且是确实相关的数量(检索出来的文献的一部分),分母表示检索出来的文献的总数量

分子表示检索出来的文献而且确实相关的数量(检索出来的文献的一部分),分母表示文献数据库中真实相关的文献的总数量

In aninformation retrieval scenario, the instances are documents and the task is to return a set of relevant documents given a search term; or equivalently, to assign each document to one of two categories, "relevant" and "not relevant". In this case, the "relevant" documents are simply those that belong to the "relevant" category.

Recall is defined as the number of relevant documents retrieved by a search divided by the total number of existing relevant documents,

precision is defined as the number of relevant documents retrieved by a search divided by the total number of documents retrieved by that search.

3、precision和recall的关系

通常情况下precision和recall有一种相反的关系,两者通常不是单独讨论的,一般的做法是在一方的值设定的情况下评价并优化另一个值,或者将两者结合起来综合评价,这就出现了F-measure(一会再说),正阳率,假阳率曲线常画在一起形成ROC曲线,从而获得平衡。

4、有了前文定义的TP,FP,TN,FN我们还可以定义其他的指标

Accuracy(正确率): ,就是识别的正确的数量(不管正类负类),与总测试样本的比值

,就是识别的正确的数量(不管正类负类),与总测试样本的比值

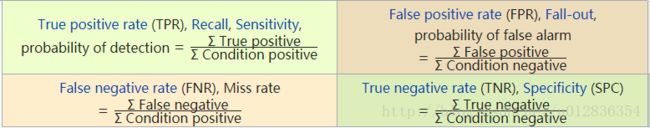

recall的同义词:sensitivity,hit rate, true positive rate(TPR)即敏感性,击中率,正阳率

precision的同义词positive predictive value(PPV)即正的预测值

漏报率miss rate或者假阴率false negative rate(FNR)

missrate=![]() 怎么理解呢,漏报应当是正类没有是被识别为正类,却错误的识别为负类,或者对于正类来说,漏掉了这一部分,分母表示真实为正类的总量。

怎么理解呢,漏报应当是正类没有是被识别为正类,却错误的识别为负类,或者对于正类来说,漏掉了这一部分,分母表示真实为正类的总量。

误报率fall out或者假阳率 false positive rate(FPR)

![]() ,怎么理解呢?误报就是本为负类却误识别为正类,这一部分在真实所有负类中所占的比例

,怎么理解呢?误报就是本为负类却误识别为正类,这一部分在真实所有负类中所占的比例

F-measure或balance F1-score: 即F-measure是precision和recall的harmonic mean(调和平均数或倒数的平均数),是各分量倒数平均数的倒数

即F-measure是precision和recall的harmonic mean(调和平均数或倒数的平均数),是各分量倒数平均数的倒数

有时候F-measure 评价并不好,因为precision和recall的权重不应看做一样,因此更一般的是![]()

正阴率true negative rate(TNR)或specify

false discovery rate (FDR)

false omission rate(FOR)

matthews correlation coefficient(MCC):

informedness或bookmarker informdness(BM):

![]()

Markedness(MK):

![]()

5、在多分类这样的更一般的情况下precision recall accuracy 等的定义

改正一下,下图不是multi-class(多分类的评价指标定义)

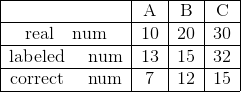

举个例子多分类的情况下precision和recall的计算是怎样的?谁为正谁为负?对于这种情况讨论到某类时将该类作为正类,不是该类就作为负类,比如A,B,C,3个类别,各类别的真是数量和识别数量分别为

precision=(7+12+15)/(13+15+32)

recall=(7+12+15)/(10+20+30)

上述例子不正确,在多分类(不是多标签)问题中,precision 和recall一般是每个类别单独计算,但是对于accuracy却不应该单独算而是整体算。

---------------------------------------------------------------

几种平均数

1、geometric mean几何平均数 ![]()