本文主要介绍mongodb3.0新特性、集群部署及从mongodb2.6中数据迁移到mongodb3.0。

mongodb3.0介绍

一、mongodb3.0新特性

引入了插件式存储引擎API

新增WiredTiger存储引擎

支持文档级别的锁

二、WiredTiger存储引擎特性介绍

文档级别锁

WiredTiger通过MVCC实现文档级别的并发控制,即文档级别锁。这就允许多个客户端请求同时更新一个集合内存的多个文档,再也不需要在排队等待库级别的写锁。这在提升数据库读写性能的同时,大大提高了系统的并发处理能力。

磁盘数据压缩

WiredTiger支持对所有集合和索引进行Block压缩和前缀压缩(如果数据库启用了journal,journal文件一样会压缩),已支持的压缩选项包括:不压缩、Snappy压缩和Zlib压缩。这为广大Mongo使用者们带来了又一福音,因为很多Mongo数据库都是因为MMAP存储引擎消耗了过多的磁盘空间而不得已进行扩容。其中Snappy压缩为数据库的默认压缩方式,用户可以根据业务需求选择适合的压缩方式。理论上来说,Snappy压缩速度快,压缩率OK,而Zlib压缩率高,CPU消耗多且速度稍慢。当然,只要选择使用压缩,Mongo肯定会占用更多的CPU使用率,但是考虑到Mongo本身并不是十分耗CPU,所以启用压缩完全是值得的。

存储方式上的改进

旧版本Mongo在数据库级别分配文件,数据库中的所有集合和索引都混合存储在数据库文件中,所以即使删掉了某个集合或者索引,占用的磁盘空间也很难及时自动回收。WiredTiger在集合和索引级别分配文件,数据库中的所有集合和索引均存储在单独的文件中,集合或者索引删除后,对应的存储文件随即删除。当然,因为存储方式不同,低版本的数据库无法直接升级到WiredTiger存储引擎,只能通过导出导入数据的方式来实现。

安装部署

一、系统环境

平台:Centos6.6_x86_64

实验环境:三台主机部署副本集模式集群

主机:192.168.115.21、192.168.115.22、192.168.115.23

规划:21为master节点,22为副本节点,23为副本节点

二、软件安装

1.软件安装

软件包:mongodb-linux-x86_64-rhel62-3.0.6.tgz

下载地址:wget https://fastdl.mongodb.org/linux/mongodb-linux-x86_64-rhel62-3.0.6.tgz

# tar xf mongodb-linux-x86_64-rhel62-3.0.6.tgz

# mv mongodb-linux-x86_64-rhel62-3.0.6 /usr/local/mongodb3.0.6

# cd /usr/local/mongodb3.0.6

# mkdir {etc,logs}

2.创建配置文件

# vi /usr/local/mongodb3.0.6/etc/mongodb.conf fork = true quiet = true port = 27017 dbpath = /data/mongodb3.0.6 logpath = /usr/local/mongodb3.0.6/logs/server.log logappend = true journal = true rest = true httpinterface = true storageEngine = wiredTiger

3.启动服务

# /usr/local/mongodb3.0.6/bin/mongod -f /usr/local/mongodb3.0.6/etc/mongodb.conf

4.连接数据库,插入一条数据

# /usr/local/mongodb3.0.6/bin/mongo 192.168.115.21:27017

> db.test.insert({"a":1})

通过查看数据目录文件,mongodb3.0数据存储方式不在是预分配空间

三、集群配置

1.每个节点修改配置文件添加如下一行

replSet = hnrtest/192.168.115.21:27017,192.168.115.22:27017,192.168.115.23:27017

2.每个节点启动mongodb服务

3.连接mongodb初始化集群

# /usr/local/mongodb3.0.6/bin/mongo 192.168.115.21:27017

> use admin

>db.runCommand({"replSetInitiate"

: { "_id" : "hnrtest" ,"members" : [ {

"_id" : 1, "host" : "192.168.115.21:27017"},{

"_id" : 2, "host" : "192.168.115.22:27017"},{

"_id" : 3, "host" : "192.168.115.23:27017"}]}})

四、数据迁移

使用mongodump、mongorestore工具的方式:

1.将测试环境2.6.9版本mongodb数据迁移到3.0.6版本

连接主节点192.168.1.227

# /usr/local/mongodb2.6.9/bin/mongo 192.168.1.227:27017

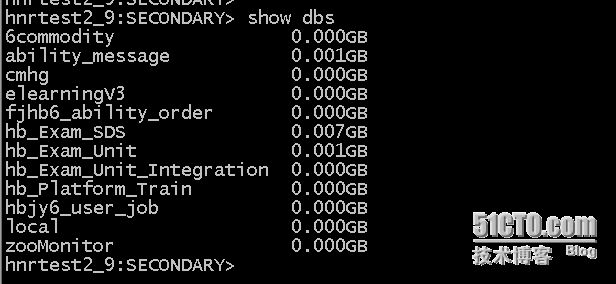

2.查询当前所有的库

3.备份所有库

# /usr/local/mongodb2.6.9/bin/mongodump -h 192.168.1.227:27017 -o /tmp/6.0test_alldb.dmp

4.导入数据

在192.168.115.21上导入数据

# /usr/local/mongodb3.0.6/bin/mongorestore -h 192.168.115.21:27017 /tmp/6.0test_alldb.dmp

5.验证数据

在192.168.115.21上查看6commodity库

在192.168.1.227上查看6commodity库

使用数据同步方式:

1.在2.6.9集群中加入一台部署3.0.6版本的mongodb节点

2.6.9版本集群信息:

192.168.115.22:37017安装3.0.6版本mongodb,并加入到上述集群中

2.连接主节点,添加一个节点

hnrtest2_9:PRIMARY> rs.add("192.168.115.22:37017")

连接上192.168.115.22:37017

# /usr/local/mongodb3.0.6/bin/mongo 192.168.115.22:37017

数据正常同步

数据同步完成后将3.0.6版本的mongodb节点(192.168.115.22:37017)移除2.6.9集群

3.重新构建基于3.0.6版本的mongodb集群

192.168.115.22:37017为主节点

192.168.115.21:37017为从节点

连接上192.168.115.22:37017

> use admin

switched to db admin

>db.runCommand({"replSetInitiate" : { "_id" :

"hnrtest3_0" ,"members" : [ { "_id" : 1,

"host" : "192.168.115.22:37017"},{ "_id" : 2,

"host" : "192.168.115.21:37017"}]}})

{

"info" : "try querying

local.system.replset to see current configuration",

"ok" : 0,

"errmsg" : "already

initialized",

"code" : 23

}

出现以上错误信息,是由于该节点先前已加入过2.6.9集群中需要先删除相关信息

>db.system.replset.find()

{ "_id" :

"hnrtest2_9", "version" : 3, "members" : [ {

"_id" : 1, "host" : "192.168.115.23:27017",

"arbiterOnly" : false, "buildIndexes" : true,

"hidden" : false, "priority" : 1, "tags" : { }, "slaveDelay" : 0,

"votes" : 1 }, { "_id" : 2, "host" :

"192.168.115.24:27017", "arbiterOnly" : false,

"buildIndexes" : true, "hidden" : false,

"priority" : 1, "tags" : {

}, "slaveDelay" : 0, "votes" : 1 } ],

"settings" : { "chainingAllowed" : true,

"heartbeatTimeoutSecs" : 10, "getLastErrorModes" : { }, "getLastErrorDefaults" : {

"w" : 1, "wtimeout" : 0 } } }

>db.system.replset.remove({ "_id" : "hnrtest2_9",

"version" : 3, "members" : [ { "_id" : 1,

"host" : "192.168.115.23:27017", "arbiterOnly" :

false, "buildIndexes" : true, "hidden" : false,

"priority" : 1, "tags" : {

}, "slaveDelay" : 0, "votes" : 1 }, {

"_id" : 2, "host" : "192.168.115.24:27017",

"arbiterOnly" : false, "buildIndexes" : true,

"hidden" : false, "priority" : 1, "tags" : { }, "slaveDelay" : 0,

"votes" : 1 } ], "settings" : { "chainingAllowed"

: true, "heartbeatTimeoutSecs" : 10, "getLastErrorModes" :

{ }, "getLastErrorDefaults" :

{ "w" : 1, "wtimeout" : 0 } } })

WriteResult({

"nRemoved" : 1 })

再重新初始化集群就不会报错,并且集群正常运行