- HarmonyOS NEXT开发实战:短信服务

我很英俊 小名男男

OpenHarmonyHarmonyOS鸿蒙开发harmonyos华为前端开发语言鸿蒙移动开发鸿蒙系统

鸿蒙开发实战往期文章必看:HarmonyOSNEXT应用开发性能实践总结一分钟了解”纯血版!鸿蒙HarmonyOSNext应用开发!“非常详细的”鸿蒙Har

- Java Stream 去重的多种方法

坎布里奇

javajavapython开发语言

在JavaStream中实现去重有多种方法,具体取决于需求和场景。以下是常见的几种方法及示例:1.使用distinct()方法适用于对象已正确实现equals()和hashCode(),基于对象整体去重并保留顺序:ListuniquePersons=persons.stream().distinct().collect(Collectors.toList());2.根据对象的属性去重方法一:使用C

- HarmonyOS NEXT开发笔记:@Computed装饰器计算属性

我很英俊 小名男男

OpenHarmony鸿蒙开发HarmonyOSharmonyos华为开发语言前端鸿蒙移动开发鸿蒙系统

鸿蒙开发往期必看:一分钟了解”纯血版!鸿蒙HarmonyOSNext应用开发!“非常详细的”鸿蒙HarmonyOSNext应用开发学习路线!(从零基础入门到精通)

- java数组

TwitCoder

java算法

目录一、数组概念二、数组的声明与初始化三、数组操作示例四、数组属性与注意事项五、内存结构分析六、常见操作七、二维数组八、稀疏数组一、数组概念数组是Java中用于存储相同类型数据的有序集合,具有以下特性:类型一致性:所有元素必须属于同一数据类型有序性:元素按顺序排列,通过索引访问长度固定:创建后无法改变容量二、数组的声明与初始化声明数组//推荐写法int[]numbers;初始化方式:动态初始化nu

- R语言使用table1包绘制(生成)三线表实战:单变量分列构建三线表、编写自定义函数在三线表中添加p值

statistics.insight

R语言入门课r语言数据挖掘机器学习

R语言使用table1包绘制(生成)三线表实战:单变量分列构建三线表、编写自定义函数在三线表中添加p值目录R语言使用table1包绘制(生成)三线表、使用单变量分列构建三线表、编写自定义函数在三线表中添加p值#三线表是什么?#导入包并构建仿真数据#R语言使用table1包绘制(生成)三线表、使用单变量分列构建三线表、编写自定义函数在三线表中添加p值#三线表是什么?三线表本来是微软公司的word编辑

- 【Attention】SEAttention

shanks66

Attention各种深度学习模块人工智能深度学习python

SEAttention摘要卷积神经网络(CNNs)的核心构建模块是卷积算子,它使网络能够通过在每一层的局部感受野内融合空间和通道信息来构建有价值的特征。此前大量研究聚焦于这种关系中的空间成分,试图通过在整个特征层级中提升空间编码质量来增强CNN的表征能力。在这项工作中,我们将重点放在通道关系上,并提出一种新颖的架构单元,称为“挤压与激励”(Squeeze-and-Excitation,简称SE)模

- Java开发-面试题-0014-@Component, @Controller, @Repository,@Mapper,@Service有何区别

CodeZeng1998

面试题java开发语言springboot

更多内容欢迎关注我(持续更新中,欢迎Star✨)Github:CodeZeng1998/Java-Developer-Work-Note技术公众号:CodeZeng1998(纯纯技术文)生活公众号:好锅(Lifeismorethancode)其他平台:CodeZeng1998、好锅@Component,@Controller,@Repository,@Mapper,@Service有何区别:@Co

- 算法学习之路——贪心算法

蒋楠鑫

算法算法贪心算法

文章目录一、前言二、什么是算法三、什么是贪心算法1.含义2.基本思路3.适用场景四、代码实现五、经典例题分析六、总结一、前言先来看一道简单的数学问题:小明有30元钱,每瓶酒要5元钱,每3个空瓶子可以换1瓶酒,请问小明最多可以喝到多少瓶酒?这道题目显然是一道求最优解的问题,由于数据量小我们可以用最简单最直接的枚举法来解决,但是如果将题目泛化一下呢:小明现在购买了m瓶酒,每n个空瓶子可以换1瓶酒,请问

- python网格插值站点_在python中,在二维零网格上两点之间插值一条值线

weixin_39965490

python网格插值站点

TLDR:在2dnumpy数组中找到2个点后,如何在0数组中在它们之间插值一条1行?在上下文:目前我正在尝试从二值化的医学图像数据(0和1)对一个3d数组执行2d操作。最终目标是在填充体素/像素(即第一个和最后一个实例)的起点和终点之间添加一条1s的线。在为此,我使用SimpleITK分割一行,然后将其转换为numpy数组。在其他示例之后,我编写了返回一组数组的函数,这些数组显示填充(1)个像素和

- python 网格数据插值_python – 网格数据的快速插值

weixin_39747399

python网格数据插值

当然!有两个选项可以做不同的事情,但是既能利用原始数据的定期网格性质。第一个是scipy.ndimage.zoom.如果你只想通过内插原始数据生成一个更加密集的规则网格,那就是要走的路。第二个是scipy.ndimage.map_coordinates.如果你想在你的数据中插入一些(或许多)任意点,但仍然利用原始数据的定期网格性质(例如,不需要四叉树),那就是去的方式。作为一个快速示例(这将使用三

- springboot是如何在没有web.xml的情况下在外部tomcat启动的

菜鸟王老汉

spring

最近在公司部署测试环境的时候遇到了问题,本地用springboot内嵌tomcat启动没有问题,部署到测试环境的外部tomcat就不加载,在咨询了同事之后在启动类上继承了SpringBootServletInitializer之后就没有了问题,但并没有深入去想。由于servlet的规范是要配置web.xml的,包括Struts2和spring都是要在web.xml配置的,有一天在服务器上看编译后的

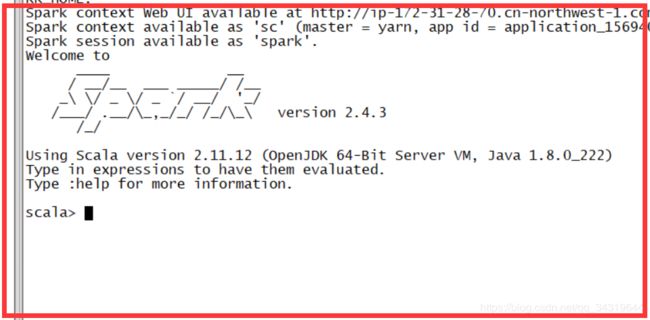

- PySpark安装及WordCount实现(基于Ubuntu)

uui1885478445

ubuntulinux运维

在Ubuntu上安装PySpark并实现WordCount,需要以下步骤:安装PySpark:安装Java:PySpark需要Java运行环境。你可以使用以下命令安装OpenJDK:sudoaptupdatesudoaptinstalldefault-jredefault-jdk安装Scala:PySpark还需要Scala,可以使用以下命令安装:sudoaptinstallscala安装Pyth

- CMake 保姆级教程

爱吃巧克力的程序媛

CMakec++

CMake是一个跨平台的构建工具,用于生成适合不同平台和编译器的构建系统文件(如Makefile或VisualStudio项目文件)。在Windows下使用CMake构建项目时,CMake会根据CMakeLists.txt文件生成适合Windows的构建系统文件(如VisualStudio项目文件)。以下是Windows下使用CMake的基本规则和步骤:https://subingwen.cn/c

- Mybatis传递多个不同类型的参数

我的身前一尺是我的世界

Mybatis传递多个参数

一、同时传递List和String实现类@OverridepublicListfun(StringshopId,Listlist){Mapmap=newHashMap();map.put("shopId",shopId);map.put("list",list);ListlistCommodity=appCommodityMapper.fun(map);returnlistCommodity;}m

- 地理数据中的分辨率转换

木叶清风666

地理信息数据处理matlabpython开发语言

数据分辨率问题气象海洋数据在实际应用中,常常涉及到重采样,即分辨率的提高或降低等操作。本文提供了matlab以及python的样例程序,以降低(网格平均)或提高(线性插值)数据的分辨率。1.高分辨率——>低分辨率可以使用循环逐个网格进行操作,但循环次数过多,存在效率低下的问题。%---需要的分辨率0.25°,以及经纬度网格点deg=0.25;lat_era=16:deg:47.75;lon_era

- 学习SpringBoot过程中常见问题汇总及多工程项目使用 IntelliJ IDEA 打开

KunQian_smile

springBoot

一:SpringBoot:redisClientine.test.serviceImpl.RedisServiceImplrequiredabeanoftype‘com.examp1:没有自动注入导致。service类上面没有@service注解或者mapper上没有@Repository注解,但是这种情况比较少见,一般不会忘记。2:配置了mybatis,但没有指定扫描的包。(1)直接在生成出来的

- Spring Data JDBC 详解

m0_74823933

面试学习路线阿里巴巴springjava数据库

目录一、JPA背景?二、SpringBoot整合SpringdataJDBC??1.配置数据源?2.配置Druid的admin后台??3.Spring-data-jdbc常用接口查询策略1)?CrudRepository增删改查2)PagingAndSortingRepository分页排序一、JPA背景早期的JPA的特性是懒加载和关联查询,一下能查出所有的关联信息,但我们开发者在查询SQL的时候

- SpringBoot中Server层以及Mapper层常用注解

π大星的日常

javajava-rabbitmq

最近看了一下SpringBoot2的课程,发现好多的注解并不是很了解,只是简单的会用,但是真是发生的作用却不知道,最近花了一些时间把这些注解进行了一下整理,针对不同的层级进行了细致的划分,最近几天会依次给大家更新关于注解的内容,对大家有帮助的话点赞支持一下哦!4.Service层注解@Service注解一般写在业务层的接口实现类上,而不是接口上。4.1@Service@Service:@Servi

- HarmonyOS NEXT开发实战:Navigation页面跳转对象传递案例

一晃有一秋

鸿蒙实例鸿蒙harmonyos华为鸿蒙鸿蒙系统android

介绍本示例主要介绍在使用Navigation实现页面跳转时,如何在跳转页面得到转入页面传的类对象的方法。实现过程中使用了第三方插件class-transformer,传递对象经过该插件的plainToClass方法转换后可以直接调用对象的方法,效果图预览使用说明从首页进入本页面时,会传递一个类对象UserBookingInfo。点击“换个座位”按钮会调用该类对象的generateRandSeatN

- HarmonyOS NEXT开发实战:视频全屏切换案例

一晃有一秋

鸿蒙鸿蒙实例harmonyos华为鸿蒙鸿蒙系统android音视频

介绍本示例介绍了@ohos.multimedia.media组件和@ohos.window接口实现媒体全屏的功能。该场景多用于首页瀑布流媒体播放等。效果图预览使用说明:点击全屏按钮,横屏媒体窗口。点击恢复窗口按钮,恢复媒体窗口。实现步骤初始化@ohos.multimedia.media的AVPlayer。asyncInit():Promise{awaitthis.release();constco

- 【C++游戏开发】零基础手写完整飞机大战游戏(基于EasyX图形库/详细注释/源码分享)

小乌龟登顶记

stm32单片机嵌入式硬件

一、开发环境与资源准备1.1环境要求VisualStudio2019+(推荐2022)EasyX图形库(官网下载适配VS版本)WindowsSDK(安装VS时勾选)1.2资源文件在项目目录创建res文件夹,存放以下素材(素材自备):plane.png玩家飞机(50x50)enemy.png敌机(50x50)bullet.png子弹(10x20)bg.jpg滚动背景(600x700)boom.wav

- AI 大模型应用数据中心建设:高性能计算与存储架构

AI智能涌现深度研究

AI大模型应用入门实战与进阶javapythonjavascriptkotlingolang架构人工智能

AI大模型、数据中心、高性能计算、存储架构、分布式训练、GPU加速、数据管理1.背景介绍近年来,人工智能(AI)技术取得了飞速发展,特别是深度学习模型的突破性进展,催生了一系列基于大规模数据训练的强大AI模型,例如GPT-3、BERT、DALL-E等。这些AI大模型在自然语言处理、计算机视觉、语音识别等领域展现出强大的应用潜力,但也对计算资源和数据存储提出了极高的要求。传统的计算架构难以满足AI大

- 解决注入mapper报红的问题

Jyannis

springSpringBootspringmybatisspringbootjavabean

在spring系列集成mybatis时,我们经常遇到这样的问题:明明注入没有问题,但是intellijidea会报红。这是因为我们没有手动在代码里把mapper接口注入spring容器中,而@Autowired注入方式默认要求注入的对象必须是在spring容器中存在的。所以idea认为这里的userMapper不存在,而用户(我们)选择注入,是一种错误操作,就报红。那么怎么解决这个问题呢?以下提供

- [QMT量化交易小白入门]-二十二、deepseek+cline+vscode,让小白使用miniQMT量化交易成为可能

python自动化工具

QMT量化交易小白入门vscodeide编辑器

本专栏主要是介绍QMT的基础用法,常见函数,写策略的方法,也会分享一些量化交易的思路,大概会写100篇左右。QMT的相关资料较少,在使用过程中不断的摸索,遇到了一些问题,记录下来和大家一起沟通,共同进步,自己淋过雨了,希望大家都有一把伞。文章目录相关阅读DeepSeek新用户注册cline集成指令测试相关阅读小白也能做量化:零门槛QMT、Ptrade免费送量化交易入门:如何在QMT中配置Pytho

- Storyboard 之segue用法总结

月未央

iOS学习总结iOS

Storyboard的好玩之处在于它可以帮我们省略了很多要手动写的代码,其中segue的功劳功不可没,现总结一下学习心得,若有错误之处,望指正。创建工程,选择SingleViewApplication,给工程起个名字,这里是SegueDemo,注意要把下面的UseStoryboard选项勾选上,我使用ARC,这里可以随意。点选工程文件中的MainStoryboard.storyboard文件,可以

- ubuntu 24.10安装mysql

linuxxx110

ubuntumysql

1.更新软件包列表在安装MySQL之前,先更新系统的软件包列表sudoaptupdate2、安装MySQL服务器sudoaptinstallmysql-server3.启动MySQL服务sudosystemctlstatusmysql4、运行安全脚本MySQL提供了一个安全脚本,用于设置root密码、移除匿名用户、禁止远程root登录等。运行以下命令sudomysql_secure_install

- JavaScript 全面教程:从基础到高级实践

幼儿园扛把子\

javascript开发语言ecmascript

JavaScript全面教程:从基础到高级实践目录JavaScript全面教程:从基础到高级实践2.JavaScript基础语法2.1变量与数据类型2.1.1变量声明2.1.2数据类型2.2条件语句与循环2.2.1条件语句2.2.2循环2.3函数2.3.1函数定义2.3.2参数默认值3.对象与数组3.1对象3.2数组4.高级特性与最佳实践4.1作用域与闭包4.1.1闭包示例4.2事件循环(Even

- ServerStatus牛逼!!

架构文摘JGWZ

学习工具开源软件

作为一名攻城狮,面对各种服务器内存飙高、CPU猛增、磁盘打满等等服务器问题,可谓是伤透了我们的心。不仅要开发,还要处理这些问题,大把的时间浪费了,这时候一个好的全面的监控工具尤为重要了。所以,带着这个问题,为大家一个酷炫高逼格的服务器探针的监控工具:ServerStatus介绍ServerStatus是一个免费开源的监控工具,并且提供了一个直观的Web页面,极大的方便了开发人员。特性实时监控,如在

- SQLite?低调不是小众...

架构文摘JGWZ

sqlite数据库学习后端

前几天在一个群里看到一位同学说:“SQLite这么小众的数据库,到底是什么人在用啊?”首先要说的是SQLite可不是小众的数据库,相反,SQLite是世界上装机量最多的数据库,远超MySQL,只不过比较低调而已。低调到我想在官网上找一个好看的用来当插图的图片都找不到,只能截一张官网首页来撑一撑,看起来十分朴素。我最早听说SQLite是刚毕业工作的时候,我们部门做微软内容管理产品的二次开发,其中有一

- 一个简单的语音识别实现---百度在线语音识别REST API SDK(Python)简单使用

DerrickOzil

语音识别pythonsdk语音识别

百度在线语音识别RESTAPISDK(Python)简单使用首先申请开发者权限注册开发者信息完成注册创建新应用下载SDK并查看key在应用管理中,选择查看key,记录AppID、APIKey、SecretKey三个参数值。测试音频链接:http://pan.baidu.com/s/1o8Ue4B4密码:o5r1]注意事项音频格式限制pcm(不压缩)、wav、amr采样频率及位数支持评测8k/16k

- 用MiddleGenIDE工具生成hibernate的POJO(根据数据表生成POJO类)

AdyZhang

POJOeclipseHibernateMiddleGenIDE

推荐:MiddlegenIDE插件, 是一个Eclipse 插件. 用它可以直接连接到数据库, 根据表按照一定的HIBERNATE规则作出BEAN和对应的XML ,用完后你可以手动删除它加载的JAR包和XML文件! 今天开始试着使用

- .9.png

Cb123456

android

“点九”是andriod平台的应用软件开发里的一种特殊的图片形式,文件扩展名为:.9.png

智能手机中有自动横屏的功能,同一幅界面会在随着手机(或平板电脑)中的方向传感器的参数不同而改变显示的方向,在界面改变方向后,界面上的图形会因为长宽的变化而产生拉伸,造成图形的失真变形。

我们都知道android平台有多种不同的分辨率,很多控件的切图文件在被放大拉伸后,边

- 算法的效率

天子之骄

算法效率复杂度最坏情况运行时间大O阶平均情况运行时间

算法的效率

效率是速度和空间消耗的度量。集中考虑程序的速度,也称运行时间或执行时间,用复杂度的阶(O)这一标准来衡量。空间的消耗或需求也可以用大O表示,而且它总是小于或等于时间需求。

以下是我的学习笔记:

1.求值与霍纳法则,即为秦九韶公式。

2.测定运行时间的最可靠方法是计数对运行时间有贡献的基本操作的执行次数。运行时间与这个计数成正比。

- java数据结构

何必如此

java数据结构

Java 数据结构

Java工具包提供了强大的数据结构。在Java中的数据结构主要包括以下几种接口和类:

枚举(Enumeration)

位集合(BitSet)

向量(Vector)

栈(Stack)

字典(Dictionary)

哈希表(Hashtable)

属性(Properties)

以上这些类是传统遗留的,在Java2中引入了一种新的框架-集合框架(Collect

- MybatisHelloWorld

3213213333332132

//测试入口TestMyBatis

package com.base.helloworld.test;

import java.io.IOException;

import org.apache.ibatis.io.Resources;

import org.apache.ibatis.session.SqlSession;

import org.apache.ibat

- Java|urlrewrite|URL重写|多个参数

7454103

javaxmlWeb工作

个人工作经验! 如有不当之处,敬请指点

1.0 web -info 目录下建立 urlrewrite.xml 文件 类似如下:

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE u

- 达梦数据库+ibatis

darkranger

sqlmysqlibatisSQL Server

--插入数据方面

如果您需要数据库自增...

那么在插入的时候不需要指定自增列.

如果想自己指定ID列的值, 那么要设置

set identity_insert 数据库名.模式名.表名;

----然后插入数据;

example:

create table zhabei.test(

id bigint identity(1,1) primary key,

nam

- XML 解析 四种方式

aijuans

android

XML现在已经成为一种通用的数据交换格式,平台的无关性使得很多场合都需要用到XML。本文将详细介绍用Java解析XML的四种方法。

XML现在已经成为一种通用的数据交换格式,它的平台无关性,语言无关性,系统无关性,给数据集成与交互带来了极大的方便。对于XML本身的语法知识与技术细节,需要阅读相关的技术文献,这里面包括的内容有DOM(Document Object

- spring中配置文件占位符的使用

avords

1.类

<?xml version="1.0" encoding="UTF-8"?><!DOCTYPE beans PUBLIC "-//SPRING//DTD BEAN//EN" "http://www.springframework.o

- 前端工程化-公共模块的依赖和常用的工作流

bee1314

webpack

题记: 一个人的项目,还有工程化的问题嘛? 我们在推进模块化和组件化的过程中,肯定会不断的沉淀出我们项目的模块和组件。对于这些沉淀出的模块和组件怎么管理?另外怎么依赖也是个问题? 你真的想这样嘛? var BreadCrumb = require(‘../../../../uikit/breadcrumb’); //真心ugly。

- 上司说「看你每天准时下班就知道你工作量不饱和」,该如何回应?

bijian1013

项目管理沟通IT职业规划

问题:上司说「看你每天准时下班就知道你工作量不饱和」,如何回应

正常下班时间6点,只要是6点半前下班的,上司都认为没有加班。

Eno-Bea回答,注重感受,不一定是别人的

虽然我不知道你具体从事什么工作与职业,但是我大概猜测,你是从事一项不太容易出现阶段性成果的工作

- TortoiseSVN,过滤文件

征客丶

SVN

环境:

TortoiseSVN 1.8

配置:

在文件夹空白处右键

选择 TortoiseSVN -> Settings

在 Global ignote pattern 中添加要过滤的文件:

多类型用英文空格分开

*name : 过滤所有名称为 name 的文件或文件夹

*.name : 过滤所有后缀为 name 的文件或文件夹

--------

- 【Flume二】HDFS sink细说

bit1129

Flume

1. Flume配置

a1.sources=r1

a1.channels=c1

a1.sinks=k1

###Flume负责启动44444端口

a1.sources.r1.type=avro

a1.sources.r1.bind=0.0.0.0

a1.sources.r1.port=44444

a1.sources.r1.chan

- The Eight Myths of Erlang Performance

bookjovi

erlang

erlang有一篇guide很有意思: http://www.erlang.org/doc/efficiency_guide

里面有个The Eight Myths of Erlang Performance: http://www.erlang.org/doc/efficiency_guide/myths.html

Myth: Funs are sl

- java多线程网络传输文件(非同步)-2008-08-17

ljy325

java多线程socket

利用 Socket 套接字进行面向连接通信的编程。客户端读取本地文件并发送;服务器接收文件并保存到本地文件系统中。

使用说明:请将TransferClient, TransferServer, TempFile三个类编译,他们的类包是FileServer.

客户端:

修改TransferClient: serPort, serIP, filePath, blockNum,的值来符合您机器的系

- 读《研磨设计模式》-代码笔记-模板方法模式

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.ResultSet;

- 配置心得

chenyu19891124

配置

时间就这样不知不觉的走过了一个春夏秋冬,转眼间来公司已经一年了,感觉时间过的很快,时间老人总是这样不停走,从来没停歇过。

作为一名新手的配置管理员,刚开始真的是对配置管理是一点不懂,就只听说咱们公司配置主要是负责升级,而具体该怎么做却一点都不了解。经过老员工的一点点讲解,慢慢的对配置有了初步了解,对自己所在的岗位也慢慢的了解。

做了一年的配置管理给自总结下:

1.改变

从一个以前对配置毫无

- 对“带条件选择的并行汇聚路由问题”的再思考

comsci

算法工作软件测试嵌入式领域模型

2008年上半年,我在设计并开发基于”JWFD流程系统“的商业化改进型引擎的时候,由于采用了新的嵌入式公式模块而导致出现“带条件选择的并行汇聚路由问题”(请参考2009-02-27博文),当时对这个问题的解决办法是采用基于拓扑结构的处理思想,对汇聚点的实际前驱分支节点通过算法预测出来,然后进行处理,简单的说就是找到造成这个汇聚模型的分支起点,对这个起始分支节点实际走的路径数进行计算,然后把这个实际

- Oracle 10g 的clusterware 32位 下载地址

daizj

oracle

Oracle 10g 的clusterware 32位 下载地址

http://pan.baidu.com/share/link?shareid=531580&uk=421021908

http://pan.baidu.com/share/link?shareid=137223&uk=321552738

http://pan.baidu.com/share/l

- 非常好的介绍:Linux定时执行工具cron

dongwei_6688

linux

Linux经过十多年的发展,很多用户都很了解Linux了,这里介绍一下Linux下cron的理解,和大家讨论讨论。cron是一个Linux 定时执行工具,可以在无需人工干预的情况下运行作业,本文档不讲cron实现原理,主要讲一下Linux定时执行工具cron的具体使用及简单介绍。

新增调度任务推荐使用crontab -e命令添加自定义的任务(编辑的是/var/spool/cron下对应用户的cr

- Yii assets目录生成及修改

dcj3sjt126com

yii

assets的作用是方便模块化,插件化的,一般来说出于安全原因不允许通过url访问protected下面的文件,但是我们又希望将module单独出来,所以需要使用发布,即将一个目录下的文件复制一份到assets下面方便通过url访问。

assets设置对应的方法位置 \framework\web\CAssetManager.php

assets配置方法 在m

- mac工作软件推荐

dcj3sjt126com

mac

mac上的Terminal + bash + screen组合现在已经非常好用了,但是还是经不起iterm+zsh+tmux的冲击。在同事的强烈推荐下,趁着升级mac系统的机会,顺便也切换到iterm+zsh+tmux的环境下了。

我为什么要要iterm2

切换过来也是脑袋一热的冲动,我也调查过一些资料,看了下iterm的一些优点:

* 兼容性好,远程服务器 vi 什么的低版本能很好兼

- Memcached(三)、封装Memcached和Ehcache

frank1234

memcachedehcachespring ioc

本文对Ehcache和Memcached进行了简单的封装,这样对于客户端程序无需了解ehcache和memcached的差异,仅需要配置缓存的Provider类就可以在二者之间进行切换,Provider实现类通过Spring IoC注入。

cache.xml

<?xml version="1.0" encoding="UTF-8"?>

- Remove Duplicates from Sorted List II

hcx2013

remove

Given a sorted linked list, delete all nodes that have duplicate numbers, leaving only distinct numbers from the original list.

For example,Given 1->2->3->3->4->4->5,

- Spring4新特性——注解、脚本、任务、MVC等其他特性改进

jinnianshilongnian

spring4

Spring4新特性——泛型限定式依赖注入

Spring4新特性——核心容器的其他改进

Spring4新特性——Web开发的增强

Spring4新特性——集成Bean Validation 1.1(JSR-349)到SpringMVC

Spring4新特性——Groovy Bean定义DSL

Spring4新特性——更好的Java泛型操作API

Spring4新

- MySQL安装文档

liyong0802

mysql

工作中用到的MySQL可能安装在两种操作系统中,即Windows系统和Linux系统。以Linux系统中情况居多。

安装在Windows系统时与其它Windows应用程序相同按照安装向导一直下一步就即,这里就不具体介绍,本文档只介绍Linux系统下MySQL的安装步骤。

Linux系统下安装MySQL分为三种:RPM包安装、二进制包安装和源码包安装。二

- 使用VS2010构建HotSpot工程

p2p2500

HotSpotOpenJDKVS2010

1. 下载OpenJDK7的源码:

http://download.java.net/openjdk/jdk7

http://download.java.net/openjdk/

2. 环境配置

▶

- Oracle实用功能之分组后列合并

seandeng888

oracle分组实用功能合并

1 实例解析

由于业务需求需要对表中的数据进行分组后进行合并的处理,鉴于Oracle10g没有现成的函数实现该功能,且该功能如若用JAVA代码实现会比较复杂,因此,特将SQL语言的实现方式分享出来,希望对大家有所帮助。如下:

表test 数据如下:

ID,SUBJECTCODE,DIMCODE,VALUE

1&nbs

- Java定时任务注解方式实现

tuoni

javaspringjvmxmljni

Spring 注解的定时任务,有如下两种方式:

第一种:

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http

- 11大Java开源中文分词器的使用方法和分词效果对比

yangshangchuan

word分词器ansj分词器Stanford分词器FudanNLP分词器HanLP分词器

本文的目标有两个:

1、学会使用11大Java开源中文分词器

2、对比分析11大Java开源中文分词器的分词效果

本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那要用的人结合自己的应用场景自己来判断。

11大Java开源中文分词器,不同的分词器有不同的用法,定义的接口也不一样,我们先定义一个统一的接口:

/**

* 获取文本的所有分词结果, 对比