Windows10下部署开发环境(伪分布式环境)

电脑环境:Windows10 家庭中文版

Eclipse版本:Oxygen.3a Release (4.7.3a)

Hadoop版本:hadoop-2.8.3

插件制作相关的环境:

ANT: apache-ant-1.9.12

hadooponwindows-master

hadoop2x-eclipse-plugin-master.zip

(一)环境准备

1.配置Java环境(不再描述)

2.安装eclipse(不再描述)

3.hadoop环境配置(不再描述)

4.Ant环境配置

Ant的安装路径:D:\soft\ant\apache-ant-1.9.12

(二)插件制作

1.修改配置文件:libraries.properties

文件路径:D:\hadoop2x-eclipse-plugin-master\hadoop2x-eclipse-plugin-master\ivy

修改内容:

当Hadoop版本为2.8.3的时候直接用附件的替换,否则自己根据Hadoop版本的依赖包更改依赖的jar包的版本

根据ant和Hadoop版本修改下面两个

hadoop.version=2.8.3

hadoop-ant.version=1.9.12

2.修改build.xml文件的jar包名称

文件路径:D:\hadoop2x-eclipse-plugin-master\hadoop2x-eclipse-plugin-master\src\contrib\eclipse-plugin

更改内容:版本为2.8.3可以直接用附件覆盖:

覆盖后根据自己的eclipse路径和Hadoop路径进行更改

3.制作插件:

指令:进入编译路径:

D:\hadoop2x-eclipse-plugin-master\hadoop2x-eclipse-plugin-master\src\contrib\eclipse-plugin>

编译指令:D:\soft\ant\apache-ant-1.9.12\bin\ant jar

一路没错,就有了jar插件了:

插件所在的路径:

D:\hadoop2x-eclipse-plugin-master\hadoop2x-eclipse-plugin-master\build\contrib\eclipse-plugin

制作的插件:

将插件放到eclipse的C:\soft\eclipse\plugins目录下重启eclipse就会有如下图标:

(三)配置Hadoop开发环境

1.文件配置

(1)core-site.xml文件的配置

配置内容:

hadoop.tmp.dir

/D:/workspace/hadoop/tmp

dfs.name.dir

/D:/workspace/hadoop/name

fs.default.name

hdfs://localhost:9000

tmp、name路径需要自己创建

(2)hdfs-site.xml文件的配置

dfs.replication

1

dfs.data.dir

/D:/workspace/hadoop/data

dfs.permissions

false

If "true", enable permission checking in HDFS.

If "false", permission checking is turned off,

but all other behavior is unchanged.

Switching from one parameter value to the other does not change the mode,

owner or group of files or directories.

其中data路径需要自己创建

(3)mapred-site.xml文件的配置

mapreduce.framework.name

yarn

mapred.job.tracker

hdfs://localhost:9001

(4)yarn-site.xml文件的配置

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.aux-services.mapreduce.shuffle.class

org.apache.hadoop.mapred.ShuffleHandler

2.启动集群测&试集群

(1)启动集群

进入到Hadoop目录:

目录:D:\soft\hadoop\hadoop-2.8.3\bin

指令:cd D:\soft\hadoop\hadoop-2.8.3\bin

先格式化一下文件系统:

指令:hdfs dfs namenode -format

由于教程是成功后几天才写的,这一步会遇到很多问题,基本都是配置的问题,就没有遇到的问题的截图了。

格式化只能格式格式化一次,需要第二次格式 化,需要将配置的tmp、name、data三个目录下的所有内容删除(个人开发环境的方法,不适用于生产环境)

启动集群:

进入sbin路径:D:\soft\hadoop\hadoop-2.8.3\sbin\

指令:cd D:\soft\hadoop\hadoop-2.8.3\sbin\

启动指令:start-all.cmd

就愉快的当作启动成功,会有四个cmd窗口

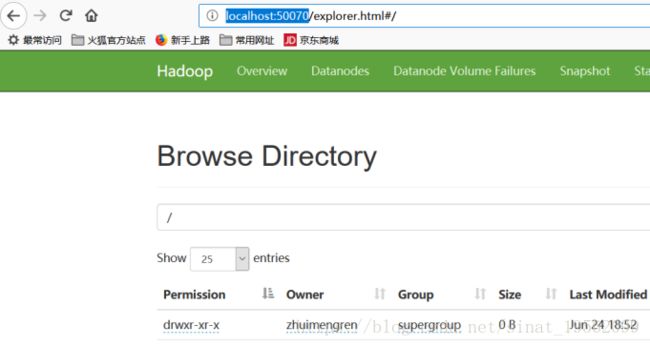

(2)测试集群

测试文件上传下载功能:

切换到bin目录:

指令:cd ../bin/

新建一个目录demo1

指令:hdfs dfs -mkdir /demo1

查看是否创建成功:

指令:hdfs dfs -ls /

上传个文件到目录demo1中:

指令:.\hdfs dfs -put hdfs.lib /demo1

查看文件是否上传成功:

指令:.\hdfs dfs -ls /demo1

下载文件:

指令: .\hdfs dfs -get /demo1/hdfs.lib d:/

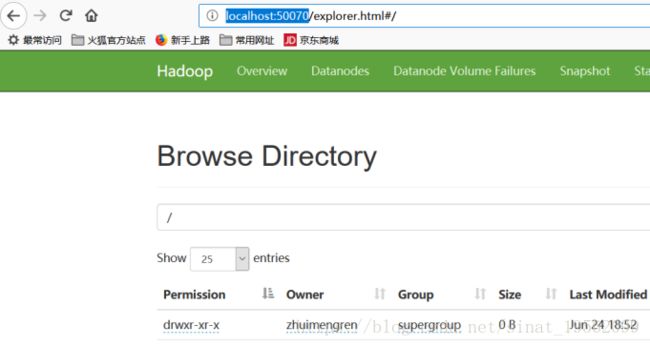

登陆看看呗:

地址:http://localhost:8088/cluster

地址:http://localhost:50070

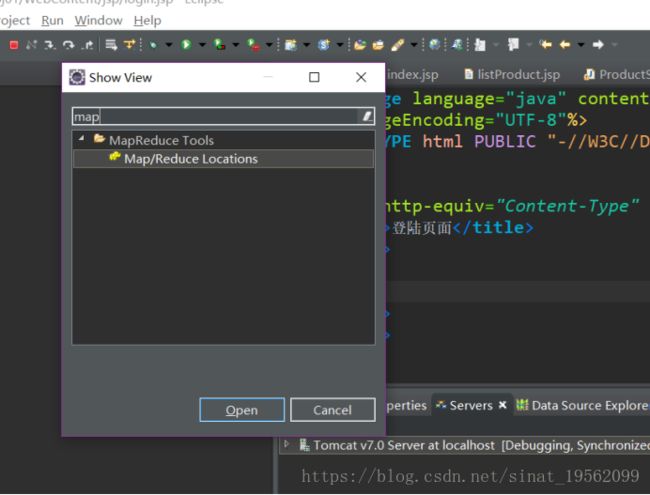

3.Eclipse上配置

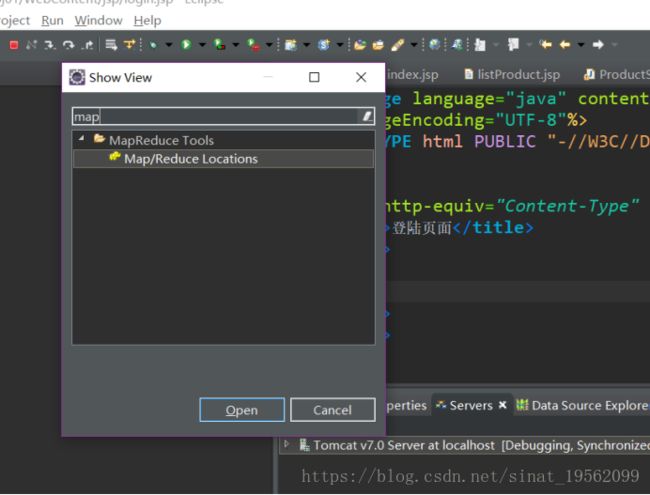

将mapreduce展示出来:

Window-->show view -->mapreduce Locations

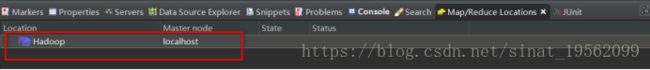

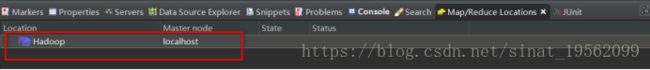

配置如下填写:

红框的两个端口号需要和配置文件一致,其他随便

点击finish出现如下:

就愉快的连上了,然后就是第一个测试程序了,到此window环境搭建完毕

参考资料:https://blog.csdn.net/familyshizhouna/article/details/78892500

Eclipse版本:Oxygen.3a Release (4.7.3a)

Hadoop版本:hadoop-2.8.3

插件制作相关的环境:

ANT: apache-ant-1.9.12

hadooponwindows-master

hadoop2x-eclipse-plugin-master.zip

(一)环境准备

1.配置Java环境(不再描述)

![]()

2.安装eclipse(不再描述)

3.hadoop环境配置(不再描述)

![]()

4.Ant环境配置

Ant的安装路径:D:\soft\ant\apache-ant-1.9.12

(二)插件制作

1.修改配置文件:libraries.properties

文件路径:D:\hadoop2x-eclipse-plugin-master\hadoop2x-eclipse-plugin-master\ivy

修改内容:

当Hadoop版本为2.8.3的时候直接用附件的替换,否则自己根据Hadoop版本的依赖包更改依赖的jar包的版本

根据ant和Hadoop版本修改下面两个

hadoop.version=2.8.3

hadoop-ant.version=1.9.12

2.修改build.xml文件的jar包名称

文件路径:D:\hadoop2x-eclipse-plugin-master\hadoop2x-eclipse-plugin-master\src\contrib\eclipse-plugin

更改内容:版本为2.8.3可以直接用附件覆盖:

覆盖后根据自己的eclipse路径和Hadoop路径进行更改

3.制作插件:

指令:进入编译路径:

D:\hadoop2x-eclipse-plugin-master\hadoop2x-eclipse-plugin-master\src\contrib\eclipse-plugin>

编译指令:D:\soft\ant\apache-ant-1.9.12\bin\ant jar

一路没错,就有了jar插件了:

插件所在的路径:

D:\hadoop2x-eclipse-plugin-master\hadoop2x-eclipse-plugin-master\build\contrib\eclipse-plugin

制作的插件:

将插件放到eclipse的C:\soft\eclipse\plugins目录下重启eclipse就会有如下图标:

(三)配置Hadoop开发环境

1.文件配置

(1)core-site.xml文件的配置

配置内容:

tmp、name路径需要自己创建

(2)hdfs-site.xml文件的配置

If "true", enable permission checking in HDFS.

If "false", permission checking is turned off,

but all other behavior is unchanged.

Switching from one parameter value to the other does not change the mode,

owner or group of files or directories.

其中data路径需要自己创建

(3)mapred-site.xml文件的配置

(4)yarn-site.xml文件的配置

2.启动集群测&试集群

(1)启动集群

进入到Hadoop目录:

目录:D:\soft\hadoop\hadoop-2.8.3\bin

指令:cd D:\soft\hadoop\hadoop-2.8.3\bin

先格式化一下文件系统:

指令:hdfs dfs namenode -format

由于教程是成功后几天才写的,这一步会遇到很多问题,基本都是配置的问题,就没有遇到的问题的截图了。

格式化只能格式格式化一次,需要第二次格式 化,需要将配置的tmp、name、data三个目录下的所有内容删除(个人开发环境的方法,不适用于生产环境)

启动集群:

进入sbin路径:D:\soft\hadoop\hadoop-2.8.3\sbin\

指令:cd D:\soft\hadoop\hadoop-2.8.3\sbin\

启动指令:start-all.cmd

就愉快的当作启动成功,会有四个cmd窗口

(2)测试集群

测试文件上传下载功能:

切换到bin目录:

指令:cd ../bin/

新建一个目录demo1

指令:hdfs dfs -mkdir /demo1

查看是否创建成功:

指令:hdfs dfs -ls /

上传个文件到目录demo1中:

指令:.\hdfs dfs -put hdfs.lib /demo1

查看文件是否上传成功:

指令:.\hdfs dfs -ls /demo1

下载文件:

指令: .\hdfs dfs -get /demo1/hdfs.lib d:/

登陆看看呗:

地址:http://localhost:8088/cluster

地址:http://localhost:50070

3.Eclipse上配置

将mapreduce展示出来:

Window-->show view -->mapreduce Locations

配置如下填写:

红框的两个端口号需要和配置文件一致,其他随便

点击finish出现如下:

就愉快的连上了,然后就是第一个测试程序了,到此window环境搭建完毕

参考资料:https://blog.csdn.net/familyshizhouna/article/details/78892500