Adaboost:adaptive Boosting。

Boosting 是 Ensemble Learning 算法的一个类别。Boost 的意思为“提升”,这类算法的思想是“给定仅比随机猜测略好的弱学习算法 ,将其提升为强学习算法”

AdaBoost最基本的性质是它能在学习过程中不断减少训练误差,即在训练数据集上的分类误差率。

a.boosting与bagging区别

一、关于bagging算法(bootstrap aggregating))

Bagging即套袋法,其算法过程如下:

1、从原始样本集中抽取训练集。每轮从原始样本集中使用Bootstraping的方法抽取n个训练样本(在训练集中,有些样本可能被多次抽取到,而有些样本可能一次都没有被抽中)。共进行k轮抽取,得到k个训练集。(k个训练集之间是相互独立的,新数据集合原数据集的大小相等)

2、每次使用一个训练集得到一个模型,k个训练集共得到k个模型。(注:这里并没有具体的分类算法或回归方法,我们可以根据具体问题采用不同的分类或回归方法,如决策树、感知器等)

3、对分类问题:将上步得到的k个模型采用投票的方式得到分类结果;对回归问题,计算上述模型的均值作为最后的结果。(所有模型的重要性相同)

二、boosting(提升方法)

其主要思想是将弱分类器组装成一个强分类器。在PAC(概率近似正确)学习框架下,则一定可以将弱分类器组装成一个强分类器。

需要注意的是:

1、通过提高那些在前一轮被弱分类器分错样例的权值,减小前一轮分对样例的权值,来使得分类器对误分的数据有较好的效果。

2、通过加法模型将弱分类器进行线性组合,比如AdaBoost通过加权多数表决的方式,即增大错误率小的分类器的权值,同时减小错误率较大的分类器的权值。而提升树通过拟合残差的方式逐步减小残差,将每一步生成的模型叠加得到最终模型。

参考链接:

机器学习中Bagging和Boosting的区别

Bagging和Boosting 概念及区别

b.adaboost算法的基本思路

基本思路是:通过反复修改训练数据的权值分布,构建系列基本分类器(弱分类器),并将这些基本分类器线性组合,构成一个强分类器。

袁春风老师的教学PPT如下:

c.adaboost分类问题的损失函数优化

Q:每一轮如何改变训练数据的权值或概率分布?

AdaBoost: 提高那些被前一轮弱分类器错误分类样本的权值, 降低那些被正确分类样本的权值。

Q:如何将弱分类器组合成一个强分类器?

AdaBoost: 加权多数表决, 加大分类误差率小的弱分类器的权值, 使其在表决中起较大的作用, 减小分类误差率大的弱分类器的权值, 使其在表决中起较小的作用。

GBDT相关参考链接,强烈推荐博客:梯度提升树(GBDT)原理小结,写的很清晰。

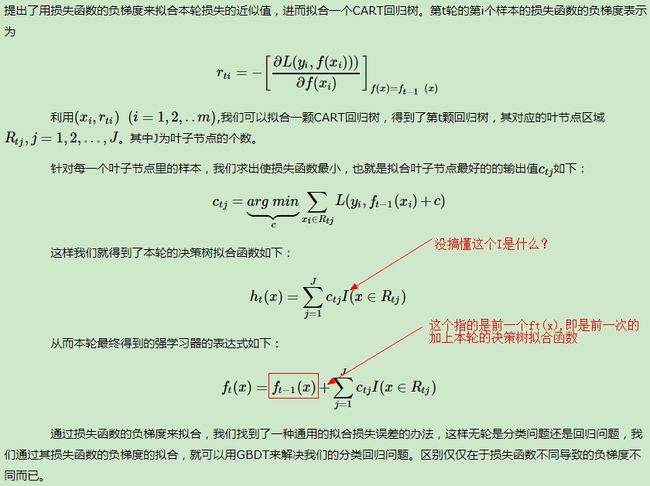

d.GBDT的负梯度拟合

GBDT(又称Gradient Boosted Decision Tree/Grdient Boosted Regression Tree),是一个基于迭代累加的决策树算法,它通过构造一组弱的学习器(树),并把多颗决策树的结果累加起来作为最终的预测输出。

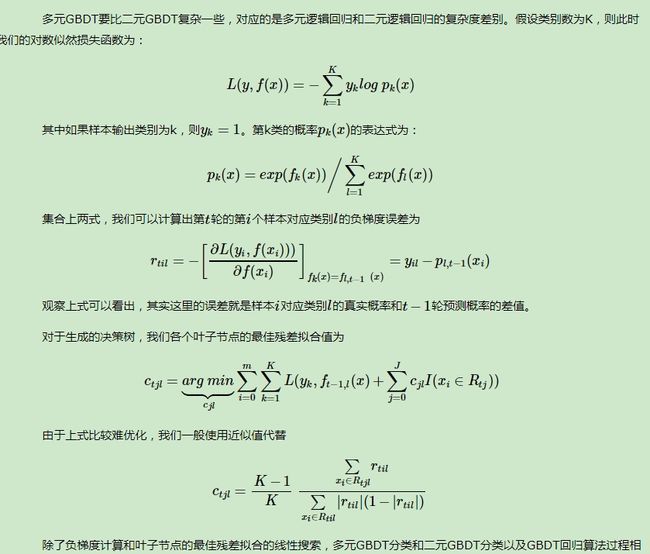

e.GBDT回归和分类算法

1、GBDT的回归算法。

2、GBDT的二分类和多分类问题。

调用机器学习包

In [2]: import numpy as np

...: import pandas as pd

...: from sklearn.datasets import load_iris

...: from sklearn.model_selection import train_test_split

...: import matplotlib.pyplot as plt

In [3]: def create_data():

...: iris = load_iris()

...: df = pd.DataFrame(iris.data, columns=iris.feature_names)

...: df['label'] = iris.target

...: df.columns = ['sepal length', 'sepal width', 'petal length', 'petal width', 'label']

...: data = np.array(df.iloc[:100, [0, 1, -1]])

...: for i in range(len(data)):

...: if data[i,-1] == 0:

...: data[i,-1] = -1

...: # print(data)

...: return data[:,:2], data[:,-1]

In [4]: X, y = create_data()

...: X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

In [6]: from sklearn.ensemble import AdaBoostClassifier

...: clf = AdaBoostClassifier(n_estimators=100, learning_rate=0.5)

...: clf.fit(X_train, y_train)

...:

Out[6]:

AdaBoostClassifier(algorithm='SAMME.R', base_estimator=None,

learning_rate=0.5, n_estimators=100, random_state=None)

In [7]: clf.score(X_test, y_test)

Out[7]: 0.95

# 可以看到其实与上几个算法相比,这个分数并不高

参考链接:

《统计学习方法》知乎参考读物

Bagging和Boosting 概念及区别

机器学习(四)--- 从gbdt到xgboost

机器学习算法总结--GBDT

梯度提升树(GBDT)原理小结