linux下安装hadoop(CentOS7)

安装前的准备

配置jdk环境(Sun)

1.利用filezilla拷贝jdk文件到/opt/softWare/java目录下

点击下载jdk

2.解压

# tar -zxvf jdk-8u141-linux-x64.tar.gz

3.配置环境变量

# vi /etc/profile

在合适的地方添加

export JAVA_HOME=/opt/softWare/java/jdk1.8.0_141

export CLASSPATH=$JAVA_HOME/lib

export PATH=$PATH:$JAVA_HOME/bin

保存刷新

# source /etc/profile

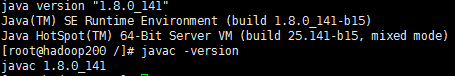

测试

# java -version

# javac -version

配置hadoop环境

利用filezilla拷贝hadoop文件到/opt/softWare/hadoop目录下

点击下载hadoop

解压

# tar -zxvf hadoop-2.7.3.tar.gz

配置环境变量

# vi /etc/profile

在合适的地方添加

export HADOOP_HOME=/opt/softWare/hadoop/hadoop-2.7.3

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

保存刷新

# source /etc/profile

主机名与ip建立映射关系

# vi /etc/hosts

在文件里添加

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

#ip 主机名(域名)

192.168.**.** sanqian

修改hadoop配置文件

# cd /opt/softWare/hadoop/hadoop-2.7.3/etc/hadoop/

1.修改hadoop-env.sh

# vi hadoop-env.sh

export JAVA_HOME=${JAVA_HOME}改成

export JAVA_HOME=/opt/softWare/java/jdk1.8.0_141

2.修改core-site.xml

# vi core-site.xml

在< configuration>中添加

fs.defaultFS

hdfs://sanqian:9000

hadoop.tmp.dir

/zhiyou/hadoop/tmp

3.修改hdfs-site.xml

# vi hdfs-site.xml

在< configuration>中添加

dfs.replication

1

4.修改mapred-site.xml

由于没有mapred-site.xml,需要复制一个

# mv mapred-site.xml.template mapred-site.xml

# vi mapred-site.xml

在< configuration>中添加

mapreduce.framework.name

yarn

5.修改yarn-site.xml

# vi yarn-site.xml

在< configuration>中添加

yarn.resourcemanager.hostname

zhiyou01

yarn.nodemanager.aux-services

mapreduce_shuffle

启动hadoop

第一次启动需要格式化

# hadoop namenode -format

输入 yes 和密码 1234 只有有密码就一直输这个

# start-all.sh

测试

# jps

3153 SecondaryNameNode

3298 ResourceManager

3682 Jps

2883 NameNode

3572 NodeManager

3001 DataNode

关闭防火墙

# systemctl stop firewalld.service #停止firewall

# systemctl disable firewalld.service #禁止firewall开机启动

在浏览器上打开

http://主机ip:50070 hdfs的路径

http://主机ip:8088 yarn的路径

配置免密登陆

# ssh sanqian

输入密码

1.生成密钥

# cd ~/.ssh

# ssh-keygen -t rsa 然后按约四个回车

# ls

2.把公钥发送到需要对其免密的机器上

# ssh-copy-id 192.168.**.***

# ll

-rw-------. 1 root root 395 9月 28 16:57 authorized_keys

-rw-------. 1 root root 1679 9月 28 16:54 id_rsa

-rw-r--r--. 1 root root 395 9月 28 16:54 id_rsa.pub

-rw-r--r--. 1 root root 525 9月 28 16:31 known_hosts

再次启动hadoop会发现不需要密码了