代码初读(二)

解决识别圆圈下数字的部分:

- 如何根据颜色识别出大体的方框,首先读取源码中的几个函数:

cvtColor

split

equalizeHist

函数cvtColor(imgOriginal, imgHSV, COLOR_BGR2HSV); // 用于颜色空间转换

C++: void cvtColor(InputArray src, OutputArray dst, int code, int dstCn=0 );

参数解释:

. InputArray src: 输入图像即要进行颜色空间变换的原图像,可以是Mat类

. OutputArray dst: 输出图像即进行颜色空间变换后存储图像,也可以Mat类

. int code: 转换的代码或标识,即在此确定将什么制式的图片转换成什么制式的图片,后面会详细将

. int dstCn = 0: 目标图像通道数,如果取值为0,则由src和code决定

void split(const Mat& src,Mat *mvBegin);

第一个参数为要进行分离的图像矩阵,第二个参数可以是Mat数组的首地址,或者一个vector对象第一个参数为要进行分离的图像矩阵,第二个参数可以是Mat数组的首地址,或者一个vector对象

此外,如果split函数输入的图像为HSV的,则分离后,channels[0]对应H,channels[1]对应S,channels[2]对应V

OpenCV中的inRange()函数可实现二值化功能(这点类似threshold()函数),更关键的是可以同时针对多通道进行操作,使用起来非常方便!

void inRange(InputArray src, InputArray lowerb, InputArray upperb, OutputArray dst)

官方文档中的解释:Checks if array elements lie between the elements of two other arrays.即检查数组元素是否在另外两个数组元素值之间。这里的数组通常也就是矩阵Mat或向量。请注意:该函数输出的dst是一幅二值化之后的图像。

void merge(

const vectorcv::Mat& mv, // 输入的多通道序列(n个单通道序列)

cv::OutputArray dst // 输出图像,包含mv

);

equalizeHist(src, dst);

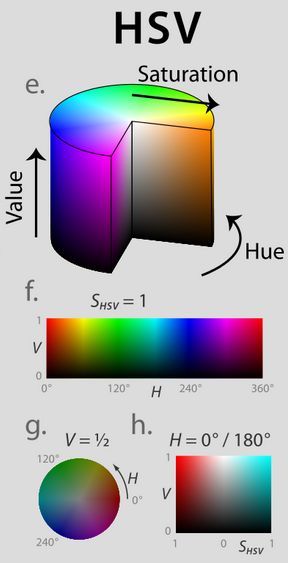

RGB是为了让机器更好的显示图像,对于人类来说并不直观,HSV更为贴近我们的认知,所以通常我们在针对某种颜色做提取时会转换到HSV颜色空间里面来处理.

用到的scalar,目前理解就是对于通道的赋值。

getStructuringElement函数—获取结构化元素,

矩形:MORPH_RECT;

交叉形:MORPH_CROSS;

椭圆形:MORPH_ELLIPSE;

理解:能够做形态学操作的图像必须是二值化的,所以图片在表示上只有0,1.

这个结构化的核也是0,1构成。然后用这个核从图像左上角开始滑动,进行计算。

如下函数,是进行更为高级的形态学操作。

关于MORPH_OPEN的开运算的一篇介绍,有效果图

https://blog.csdn.net/zangle260/article/details/52980992

CV_EXPORTS_W void morphologyEx( InputArray src, OutputArray dst,

int op, InputArray kernel,

Point anchor = Point(-1,-1), int iterations = 1,

int borderType = BORDER_CONSTANT,

const Scalar& borderValue = morphologyDefaultBorderValue() );

void cvCanny(

const CvArr* image, //第一个参数表示输入图像,必须为单通道灰度图

CvArr* edges, //第二个参数表示输出的边缘图像,为单通道黑白图

double threshold1,

double threshold2, //第三个参数和第四个参数表示阈值,这二个阈值中当中的小阈值用来控制边缘连接,

大的阈值用来控制强边缘的初始分割即如果一个像素的梯度大与上限值,则被认为

是边缘像素,如果小于下限阈值,则被抛弃。如果该点的梯度在两者之间则当这个

点与高于上限值的像素点连接时我们才保留,否则删除。

int aperture_size=3 //第五个参数表示Sobel 算子大小,默认为3即表示一个3*3的矩阵。Sobel 算子与

高斯拉普拉斯算子都是常用的边缘算子

);

一个关于提取蓝色物体的示例代码。

HSV = cv2.cvtColor(Img, cv2.COLOR_BGR2HSV)

H, S, V = cv2.split(HSV)

LowerBlue = np.array([100, 100, 50])

UpperBlue = np.array([130, 255, 255])

mask = cv2.inRange(HSV, LowerBlue, UpperBlue)

BlueThings = cv2.bitwise_and(Img, Img, mask=mask

opencv中提供findContours()函数来寻找图像中物体的轮廓,并结合drawContours()函数将找到的轮廓绘制出。首先看一下findContours(),opencv中提供了两种定义形式

void cv::findContours ( InputOutputArray image,

OutputArrayOfArrays contours,

OutputArray hierarchy,

int mode,

int method,

Point offset = Point()

)

参数解释

image:输入图像,图像必须为8-bit单通道图像,图像中的非零像素将被视为1,0像素保留其像素值,故加载图像后会自动转换为二值图像。我们同样可以使用cv::compare,cv::inRange,cv::threshold,cv::adaptiveThreshold,cv::Canny等函数来创建二值图像,,如果第四个参数为cv::RETR_CCOMP或cv::RETR_FLOODFILL,输入图像可以是32-bit整型图像(CV_32SC1)

contours:检测到的轮廓,每个轮廓都是以点向量的形式进行存储即使用point类型的vector表示

hierarchy:可选的输出向量(std::vector),包含了图像的拓扑信息,作为轮廓数量的表示hierarchy包含了很多元素,每个轮廓contours[i]对应hierarchy中hierarchy[i][0]~hierarchy[i][3],分别表示后一个轮廓,前一个轮廓,父轮廓,内嵌轮廓的索引,如果没有对应项,则相应的hierarchy[i]设置为负数。

approxPolyDP 主要功能是把一个连续光滑曲线折线化,对图像轮廓点进行多边形拟合。

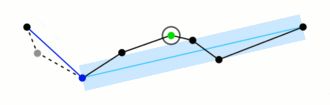

原理图:对比之前黑点连线,之后蓝色连线:

C++: void approxPolyDP(InputArray curve, OutputArray approxCurve, double epsilon, bool closed)

参数详解;

InputArray curve:一般是由图像的轮廓点组成的点集

OutputArray approxCurve:表示输出的多边形点集

double epsilon:主要表示输出的精度,就是另个轮廓点之间最大距离数,5,6,7,,8,,,,

bool closed:表示输出的多边形是否封闭

以下函数主要用于图像拼接:

https://www.cnblogs.com/skyfsm/p/7411961.html

cv::warpPerspective()

透视变换(Perspective Transformation)是将成像投影到一个新的视平面(Viewing Plane),也称作投影映射(Projective Mapping)。如图1,通过透视变换ABC变换到A’B’C’。

cv::mat::at 函数

源码为:

template inline

_Tp& Mat::at(int i0, int i1)

{

CV_DbgAssert(dims <= 2);

CV_DbgAssert(data);

CV_DbgAssert((unsigned)i0 < (unsigned)size.p[0]);

CV_DbgAssert((unsigned)(i1 * DataType<_Tp>::channels) < (unsigned)(size.p[1] * channels()));

CV_DbgAssert(CV_ELEM_SIZE1(traits::Depth<_Tp>::value) == elemSize1());

return ((_Tp*)(data + step.p[0] * i0))[i1];

}

opencv3中图形存储基本为Mat格式,如果我们想获取像素点的灰度值或者RGB值,可以通过image.at(i,j)的方式轻松获取。其中i对应y坐标,j对应x坐标。来获取或改变该点的值,而RGB通道的则可以使用:

image.at(i, j)[0]

image.at(i, j)[1]

image.at(i, j)[2]

需要注意的是H的取值范围为0°~360°,从红色开始按逆时针方向计算,红色为0°,绿色为120°,蓝色为240°,想提取红色时需注意取值应为-10~10(打比方)OpenCV中H的取值范围为0-180(8bit存储时),

然后会用到cv::split函数,这个函数的意义是把各个通道区分开。