CVPR 2020丨微软亚洲研究院精选论文一览

![]()

编者按:本文汇总了部分微软亚洲研究院CVPR2020精选论文,涵盖姿态估计、动作检测与识别、分割与检测、底层视觉等领域。

01

HigherHRNet: 自下而上姿态估计中的多尺度表征学习

HigherHRNet: Scale-Aware Representation Learningfor Bottom-Up Human Pose Estimation

论文地址:https://arxiv.org/pdf/1908.10357.pdf

2D 人体姿态估计是计算机视觉领域的基本研究方向之一,多人 2D 姿态估计(Multi-Person Pose Estimation)是该方向上的一个经典难题。自下而上的框架在速度上有优势,但是由于卷积神经网络对于尺度不敏感,而图片中人的多尺度的难题导致目前的结果和自上而下框架还有一定差距。为此,在我们在 CVPR 2019 和 TPAMI 发表的HRNet[1,2](https://github.com/HRNet)工作的基础上,提出了 HigherHRNet 来解决自下而上方法中的多尺度难题。

图1:HigherHRNet 框架图

目前主流的自下而上检测关键点的热度图(heatmap)分辨率使用1/4 ,我们发现这个分辨率用于做关键点的精确度还是不够高。为解决此问题,我们在 HRNet 的基础上通过 transposed convolution 得到更高分辨率的特征。

为了解决多尺度问题,我们进一步设计了一个高分辨率特征金字塔。传统的特征金字塔一般从一个很小的分辨率(比如1/32)开始,通过一系列上采样操作得到1/4 分辨率的特征。我们提出的高分辨率特征金字塔则是从1/4 分辨率出发,通过 transposed convolution 得到更高分辨率的特征。

在训练的过程中,我们使用多分辨率监督让不同层的特征能学习不同尺度的信息。我们也利用多分辨率融合,把不同分辨率的热度图统一放大到原图大小并且融合到一起,从而得到一个对尺度敏感的特征。

在 COCO test-dev 上,HigherHRNet 取得了自下而上的最佳结果,达到了 70.5%AP。尤其在小尺度的人体姿态估计上,HigherHRNet 比之前的方法高出了 2.5%AP。为了测试 HigherHRNet 对于拥挤(crowd)场景的鲁棒性,我们在 CrowdPose 上也进行了实验,并且取得了 67.6%AP 的结果,超越了之前所有的方法。

HigherHRNet 已经开源:

https://github.com/HRNet/HigherHRNet-Human-Pose-Estimation

02

基于可穿戴式惯性传感器和多摄像头融合的人体姿态估计:一种几何方法

Fusing Wearable IMUs with Multi-View Images for Human Pose Estimation: A Geometry Approach

论文地址:https://arxiv.org/pdf/2003.11163.pdf

高精度 3D 人体姿态估计目前主要有两种商业化解决方案:

第一种采用基于标记的多摄像头系统,其估计精度高,但仅适用于室内环境;

另外一种方案则基于穿戴式的惯性传感器,估计精度低,尤其存在漂移的问题,但好处是可以应用于自然场景中。

在学术界,近年来一些工作开始关注将无标记的多摄像头系统与惯性传感器结合起来,希望其既能应用于室外环境,同时又能取得较高的精度。我们可以将这些工作大概分为两类:

第一类方法通过优化一个全局的人体模型的参数,使得其所对应的人体姿态能够同时被传感器和图像所解释,该方法可解释性强,但缺点是对应的优化问题通常很难找到最优解,因此结果较差;

另外一类方法则是通过黑盒的方式将传感器和图像的特征融合在一起,这种不可解释的融合方式导致其结果并不稳定,很难用于商业方案。

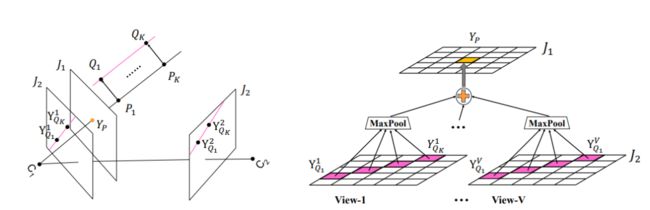

图2:左,三维空间中特定角度下的 P、Q 两点,在不同视角下的图像中的位置关系;右,基于几何位置关系的特征融合。

在本工作中,我们通过几何的方式将传感器和图像融合在一起,相比于黑盒方式,该方式具有更好的可解释性,从而也更加稳定。具体来说,惯性传感器提供了其所关联的两个节点的角度信息,我们利用该信息对两个节点进行相互增强。通过这种方式,我们可以大幅提高某一节点存在遮挡时的精度。

在 Total Capture 数据集上,我们的方法将之前最好方法的误差从34.1mm降到了24.6mm。而如果只关注那些比较困难的例子,本方法带来的提升会更加明显。相关代码已在 GitHub 上开源。

03

基于平行标架的 3D 曲面卷积神经网络

PFCNN:Convolutional Neural Networks on 3D Surfaces Using Parallel Frames

论文地址:http://haopan.github.io/surfacecnn.html

三维数据是视觉数据的重要组成部分,相当一部分三维数据以表面网格(surface mesh)的形式高效表达。与图像相比,表面网格由不规则的顶点(vertices)和面片(faces)连接组成,并且具有曲面的非欧几何(non Euclidean geometry)。这些特点阻止了人们把图像域的 CNN 和深度学习技术直接推广到表面网格上。

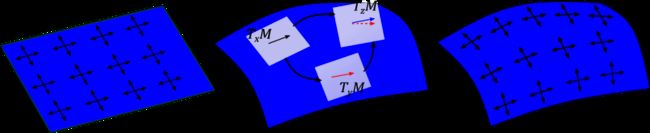

试图解决这一问题的工作形成了几何深度学习(Geometric deep learning)领域。该领域以推广深度学习至非欧几何空间为目标,涵盖了曲面、图等空间结构。

以曲面上的深度学习为例,诸多工作都试图把曲面整体映射到或局部展开为平面,从而允许直接使用图像(欧式几何)上定义的标准 CNN。然而问题的关键在于,图像域 CNN 的每层卷积操作(convolution)都具有内蕴的平移共变属性(translation equivariance),即平移与卷积两者符合交换律;

这一属性导致了信号可以在图像上传播,是 CNN 相比于简单的 MLP 在视觉任务中更有效率的关键。以往的工作,或是因为整体曲面映射导致了平移的严重扭曲,或是因为局部展开在各点处的不协调而失去了欧式平移的结构,都导致所定义的曲面 CNN 不够有效。

图3:左,图像的欧式平面上的平移;中,曲面上的测地平移;右,我们构造的平行标架定义的曲面上的平移。曲面上的平移在不同点处难以协调,而我们构造的曲面平移在局部与欧式空间一致,由此定义的 CNN 具有平移共变性和更高的特征学习效率。

鉴于曲面非欧几何的本质,在本文中,我们使用平行标架场(parallel frames)来构造局部的平直联络(locally flat connection)和欧式平移结构,从而允许在局部定义具有平移共变性的标准卷积和 CNN,故而命名 PFCNN。

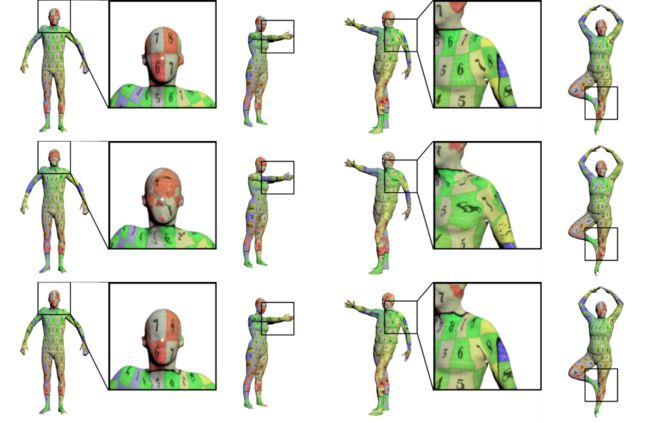

平行标架场导出平直联络是离散微分几何中的工具,可以在给定曲面网格上快速计算,并且能够对齐和捕捉曲面的重要几何特征。更多细节请参考文章正文。通过使用 PFCNN 框架,我们在曲面网格表示的数据集和各类任务上都取得了优于已有方法的结果。下图展示了人体表面分割和注册的例子;更多结果请参考文章。

图4:人体表面分割结果。上中下行依次为:人工标注的 ground truth 分割、SOTA 方法的结果、我们的结果。可以看到,我们的结果更准确合理。

图5:人体表面注册结果。上中下行依次为:标注的 ground truth 注册对应的纹理映射、SOTA 方法的结果、我们的结果。可以看到,我们的结果注册扭曲更小,对于表面拓扑的变化更鲁棒。

04

语义引导下的基于人体骨架的高效行为识别

Semantics-Guided Neural Networks for Efficient Skeleton-Based Human Action Recognition

论文链接:https://arxiv.org/pdf/1904.01189.pdf

基于人体骨架的行为识别近年来获得越来越多的关注。该任务旨在通过人体骨架序列来识别发生的事件或行为的类别。人体骨架可以通过对视频进行人体姿态估计(pose estimation)获得,也可以通过深度摄像机(例如 Kinect)获取,表达了人体的姿态和运动信息。

为了取得满意的识别精度,近年来,人们针对基于骨架的行为识别探索了各种各样的网络结构,包括递归神经网络(RNN)、卷积神经网络(CNN)、以及图神经网络(GCN),或者组合其中两种网络的混合网络。

RNN 适合于处理时间序列数据,并且参数量低,但性能不及卷积神经网络。CNN 常用于处理图像或者视频数据中像素点(pixel)排列成整齐矩阵的数据。以便于利用 CNN 进行行为分类,人们将骨架序列数据重排成矩阵(图像),不同行表示不同的关节点,不同列对应不同时间,关节点的两维(2D)或 三维(3D)坐标值作为图像的像素值。骨架序列作为结构化的数据,图卷积网络也被用于挖掘节点间的相关性。

然而这些方法的研究大多只考虑性能的提升,而忽略了网络的优化设计和复杂度。在实际应用中,如何设计高性能的轻量级模型也非常重要。

另外,对于表达一个关节点,除了坐标位置信息(我们称为 Dynamics)外,节点类型(joint type)和所处的帧(frame index)这些语义信息(Semantics)也对行为识别至关重要。例如两个运动轨迹相同的节点,会由于所属节点类型的不同,而对应不同的行为类别。然而,以往的工作往往忽略了对语义信息的显式利用。

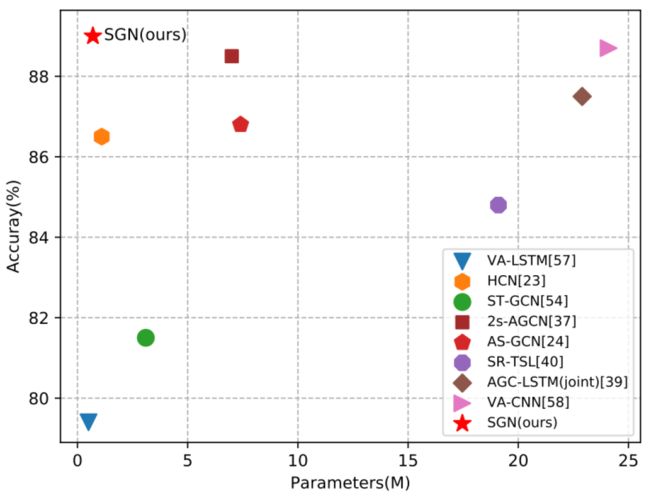

图6:不同方法在 NTU60 数据库(CS setting)上的性能比较。横坐标表示模型参数量,纵坐标表示识别精度。我们的方法 SGN 在非常少的参数量情况下,实现了最好的识别精度。

本文中,我们设计了语义引导的轻量神经网络 Semantics-Guided Neural Network(SGN)。如图6所示, SGN 方案仅需非常小的参数量(仅0.69M)就实现了很高的识别精度。

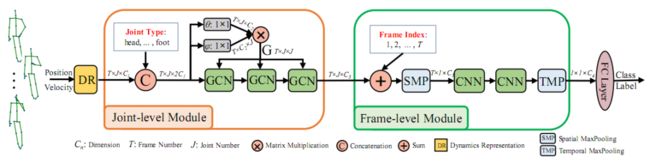

图7:Semantics-Guided Neural Network(SGN)框图

图7展示了 SGN 的网络结构。我们利用三层 GCN 和两层 CNN 搭建了一个强的基础网络(Strong Baseline), 并在此基础上引入了节点类型(Joint Type)和帧位置(Frame Index)的语义信息。

该网络由 Joint-level Module(JL)和 Frame-level Module(FL)组成。JL 模块实现同一帧内节点间相关性的挖掘和信息的传递。节点类型信息和节点位置信息联合学习图(Graph)的连接,并参与信息传递。而以前的方法忽略了语义信息的利用,片面地将节点位置信息作为节点的代表。FI 模块实现帧间信息的挖掘,通过显式地将帧位置(时间顺序信息)嵌入到时域 CNN 网络中,从而更好地识别行为。该方法在多个数据库上均表现出了较高的识别精度。

05

基于记忆增强的全局-局部整合网络:更准确的视频物体检测方法

Memory Enhanced Global-Local Aggregation for Video Object Detection

论文地址:https://arxiv.org/abs/2003.12063

在视频物体检测任务中,由于相机失焦、物体遮挡等问题,仅基于图像的目标检测器很可能达不到令人满意的效果。一般来说,人类主要通过两类信息来辅助对质量较差的帧进行物体检测,即局部定位信息与全局语义信息。从这个角度出发,我们发现目前的视频物体检测方法都仅单独考虑了其中一种信息进行辅助目标检测。除此之外,另一个在现存方法中存在的问题就是整合规模不足,也就是关键帧能够使用信息的范围较少。

图8:模型结构示意图

针对这两个问题,我们提出了基于记忆增强的全局-局部整合网络,其架构如图8所示,分为以下两部分。

第一步:解决全局信息和局部信息单独考虑的问题。我们设计了简洁的基础模型来完成这项任务。首先,我们使用区域候选网络从关键帧的相邻帧和全局帧中生成一些候选区域。第二是使用关联模块(relation module)将全局帧中候选区域对应的特征给整合到局部帧的候选区域的特征中。之后,局部帧内部会再过若干层关联模块得到增强后的关键帧特征。由此,我们的关键帧特征就同时得到了全局和局部两方面的信息。

第二步:解决整合规模太小的问题。如果只有基础模型,我们关键帧能够得到的全局和局部信息仍然很少。为了解决这个问题,我们设计了一个简洁高效的长时记忆模块(Long Range Memory,LRM),在做完对某一帧的检测后将其特征保存下来,并在下一帧的检测中使用该特征来辅助检测,由于关系模块的多层结构,可以极大地增加了关键帧能够看到的范围。

不仅如此,这两部分结构还互相受益:长时记忆模块使得关键帧能够获得更多的全局和局部信息,反过来,这些帧又能够提供一个更加健壮的记忆。

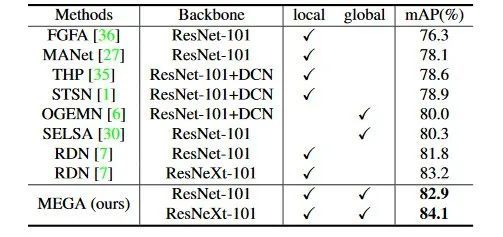

表1:实验结果

我们在广泛使用的视频物体检测数据集 ImageNet VID 上对我们的方法进行了实验,上表中总结了我们的方法与其他方法相比的表现。在本文新提出的模块的辅助下,我们训练出来的视频物体检测器取得了在该数据集上的至今最佳结果。

参考文献:

[1] Ke Sun, Bin Xiao, Dong Liu, Jingdong Wang: Deep High-Resolution Representation Learning for Human Pose Estimation. CVPR 2019: 5693-5703

[2] Jingdong Wang, Ke Sun, Tianheng Cheng, Borui Jiang, Chaorui Deng, Yang Zhao, Dong Liu, Yadong Mu, Mingkui Tan, Xinggang Wang, Wenyu Liu, Bin Xiao: Deep High-Resolution Representation Learning for Visual Recognition. To appear in TPAMI

END

![]()

备注:Papers

![]()

Papers交流群

学术论文撰写交流,会议期刊投稿等信息,

若已为CV君其他账号好友请直接私信。

我爱计算机视觉

微信号:aicvml

QQ群:805388940

微博知乎:@我爱计算机视觉

网站:www.52cv.net

![]()

在看,让更多人看到 ![]()