hadoop集群环境搭建之完全分布式集群环境搭建(二)

我们在上一篇 hadoop集群环境搭建之伪分布式集群环境搭建(一)中介绍了hadoop伪分布式集群环境的搭建,下面我们介绍下完全分布式集群环境搭建。

完全分布式集群是指在多台机器上部署hadoop的服务。下面我以三台机器(server1,server2,server3)为例。搭建一个完全分布式的集群环境。

1、Linux机器环境配置

首先在使用VMware虚拟机创建一台虚拟机server1。配置好虚拟机的基本环境。

1.1 修改主机名

切换成root用户

su root

编辑/etc/sysconfig/network文件

vim /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=server1 # 主机名

1.2 修改ip

编辑/etc/sysconfig/network-scripts/ifcfg-eno16777736文件

vim /etc/sysconfig/network-scripts/ifcfg-eno16777736

修改内容如下:

TYPE=Ethernet

DEFROUTE=no # 设置no

BOOTPROTO=none # 设置none

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

NAME=eno16777736

UUID=2ce59a48-ae92-483b-a73c-7844147b6ba0

HWADDR=00:0C:29:21:8D:08

PREFIX0=24

ONBOOT=yes # 开始机自动网络

IPADDR=192.168.108.99 # 设置IP

NETMASK=255.255.255.0 # 子网掩码

GATEWAY0=192.168.108.2 # 设置网关

1.3 修改主机名和ip映射关系

编辑/etc/hosts文件

# 编辑/etc/hosts文件

vim /etc/hosts

192.168.108.11 server1

编辑/etc/hostname文件

vim /etc/hostname

zhang

1.4 关闭防火墙

chkconfig iptables off

1.5 给hadoop用户添加root操作权限

修改/etc/sudoers权限

chmod u+w /etc/sudoers

编辑/etc/sudoers文件,给hadoop用户添加root操作权限

# hadoop 用户名

hadoop ALL=(root) NOPASSWD:ALL

1.6 关闭linux图形化界面

centos 7以下版本:

vim /etc/inittab

id:5:initdefault:

改为

id:3:initdefault:

centos 7.x版本:

- 删除已经存在的符号链接

rm /etc/systemd/system/default.target

- 默认级别转换为3

# 默认级别转换为3(文本模式)

ln -sf /lib/systemd/system/multi-user.target /etc/systemd/system/default.target

# 默认级别转换为5(图形模式)

ln -sf /lib/systemd/system/graphical.target /etc/systemd/system/default.target

- 重启

reboot

如果需要切换图形界面执行命令:startx

2、java环境搭建

2.1 删除自带的jdk

执行

java -version查看java环境,如果没有则可以忽略查看自带的jdk,

rpm -qa | grep jdk删除自带的jdk,

yum -y remove java-1.7.0-openjdk-xxxx

2.2 上传jdk压缩包

通过Windows客户端,上传jdk压缩包。(使用git命令窗口)

scp D:/dsoftmanager/jdk-8u151-linux-x64.tar.gz [email protected]:/home/hadoop

2.3 解压jdk,配置环境变量

创建/java目录,

sudo mkdir /java-

将上传的jdk压缩包复制到

/java目录sudo cp /home/hadoop/jdk-8u151-linux-x64.tar.gz /java -

解压压缩包

# 切换到/java目录 cd /java # 解压jdk sudo tar -zxvf jdk-8u151-linux-x64.tar.gz -

配置java环境变量

# 编辑/etc/profile文件 vim /etc/profile # java环境变量 JAVA_HOME=/java/jdk1.8.0_151 PATH=$PATH:$JAVA_HOME/bin:/usr/bin:/usr/sbin:/bin:/sbin:/usr/X11R6/bin CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar export JAVA_HOME PATH CLASSPATH 重启后,测试

java -version,出现如下,表示成功

java version "1.8.0_151"

Java(TM) SE Runtime Environment (build 1.8.0_151-b12)

Java HotSpot(TM) 64-Bit Server VM (build 25.151-b12, mixed mode)

3、克隆机器修改Linux基本的配置

3.1 克隆机器server2,server3

关于VMware虚拟机克隆,这里不截图展示,在克隆时,选择完全克隆。

3.2 修改server2和server3的配置

需要修改server2和server3的如下文件:

- 3.2.1 修改

/etc/sysconfig/network

vim /etc/sysconfig/network

# server2机器HOSTNAME改为server2,server3机器HOSTNAME改为server3

HOSTNAME=server2

- 3.2.2 修改

/etc/sysconfig/network-scripts/ifcfg-eno16777736

vim /etc/sysconfig/network-scripts/ifcfg-eno16777736

# server2机器将ip改为192.168.108.12,server3的ip改为192.168.108.13

IPADDR=192.168.108.12

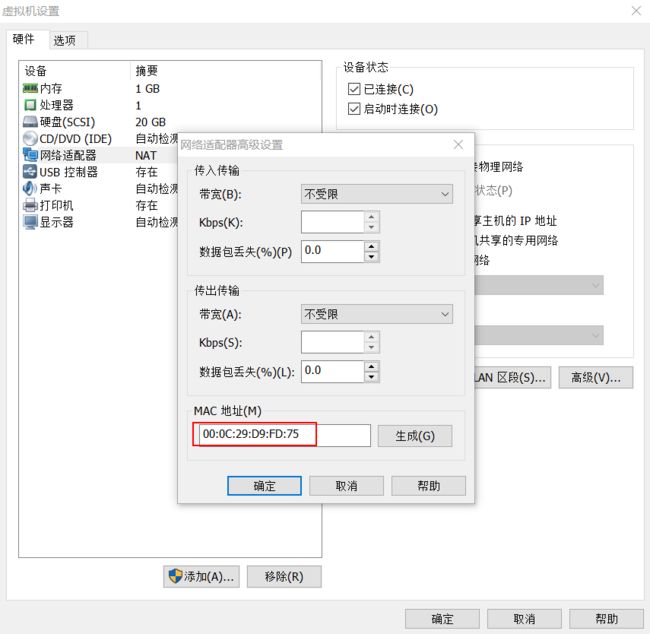

在克隆时,会把网卡信息也一起克隆,所以需要修改网卡的mac值。

修改/etc/sysconfig/network--scripts/ifcfg-eno16777736中的HWADDR的mac值。mac值是每台机器唯一的。

mac值获取,如图:

具体参考:Linux虚拟机复制后eth0不能启动解决方法

- 3.2.3 修改

/etc/hostname

# server2机器改为server2,server3机器改为server3

server2

- 3.2.4 修改

/etc/hosts

将server1,server2,server3的/etc/hosts都改为

192.168.108.11 server1

192.168.108.12 server2

192.168.108.13 server3

- 3.2.5 重启后相互

ping一下,能ping通就没问题

ping 192.168.108.11

ping 192.168.108.12

ping 192.168.108.13

4、SSH无秘登录

以下操作,每台机器都需要执行

4.1 在server1,server2,server3分别生成公钥,私钥

执行ssh-keygen -t rsa命令,一路回车就行

ssh-keygen -t rsa

4.2 将生成好的公钥,发送到其他的主机上

ssh-copy-id server1

ssh-copy-id server2

ssh-copy-id server3

4.3 相互以ssh 主机名进行切换

ssh server1

ssh server2

ssh server3

如果不需要输入密码,表示无秘登入成功

5、hadoop的压缩包解压及环境变量配置

hadoop的完全分布式集群,先server1机器将hadoop的环境配置好,通过scp命令同步到server2和server3机器上。

5.1 上传hadoop的压缩包

scp d:/dsoftmanager/hadoop-2.7.5.tar.gz [email protected]:/home/hadoop

5.2 压缩hadoop包

- 5.2.1 创建

/hadoop目录

sudo mkdir /hadoop

- 5.2.2 将hadoop压缩包复制到

/hadoop目录

sudo cp /home/hadoop/hadoop-2.7.5.tar.gz /hadoop

- 5.2.3 解压hadoop包

# 进入/hadoop目录

cd /hadoop

# 解压hadoop包

sudo tar -zxvf hadoop-2.7.5.tar.gz

5.3 配置hadoop环境变量

打开/etc/profile文件,配置hadoop环境变量

sudo vim /etc/profile

export HADOOP_HOME=/hadoop/hadoop-2.7.5

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

5.4 重启,测试hadoop环境变量

echo ${HADOOP_HOME}

输出:/hadoop/hadoop2.7.5

6、hadoop的服务基本环境配置

在配置环境之前,我们需要对server1,server2,server3进行hadoop服务分配。

分配如下:

| server1 | server2 | server3 |

|---|---|---|

| namenode | --- | --- |

| datanode | datanode | datanode |

| --- | secondarynode | --- |

| resourcemanager | --- | --- |

| nodemanager | nodemanager | nodemanager |

| --- | --- | historyserver |

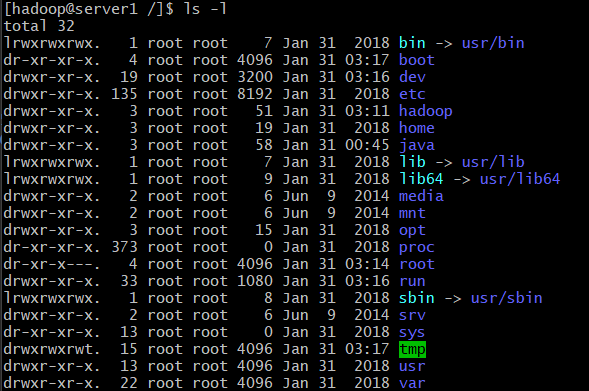

6.1 hadoop开发目录权限设置

把当前目录切换到根目录/。执行ls -l目录。

我们可以看到hadoop目录是root用户权限。我们需要将权限更改为hadoop用户。

# 更改/hadoop目录权限

sudo chown -R hadoop:hadoop /hadoop

6.2 hadoop-env.sh文件配置

修改hadoop-env.sh的JAVA_HOME环境

# 将目录切换到${HADOOP_HOME}目录下

cd ${HADOOP_HOME}

# 打开etc/hadoop/hadoop-env.sh文件

sudo vim etc/hadoop/hadoop-env.sh

# 修改JAVA_HOME路径

JAVA_HOME=/java/jdk1.8.0_151

6.3 core-site.xml文件配置

在${HADOOP_HOME}目录下创建data/tmp目录

# 创建data目录

mkdir data

# 切换到data目录

cd data

# 创建tmp目录

mkdir tmp

修改core-site.xml文件

# 进入${HADOOP_HOME}

cd ${HADOOP_HOME}

# 打开 etc/hadoop/core-site.xml文件

sudo vim etc/hadoop/core-site.xml

修改内容:

fs.defaultFS

hdfs://server1:8020

hadoop.tmp.dir

/hadoop/hadoop-2.7.5/data/tmp

6.4 hdfs-site.xml文件配置

修改 etc/hadoop/hdfs-site.xml文件

sudo vim etc/hadoop/hdfs-site.xml

修改内容:

dfs.replication

3

dfs.namenode.secondary.http-address

server2:50090

6.5 配置slaves

打开slaves文件

sudo vim etc/hadoop/slaves

修改内容如下:

server1

server2

server3

6.5 yarn-site.xml文件配置

打开yarn-site.xml文件

sudo vim etc/hadoop/yarn-site.xml

修改内容:

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.hostname

server1

yarn.log-aggregation-enable

true

yarn.log-aggregation.retain-seconds

106800

6.6 mapred-site.xml文件配置

从mapred-site.xml.template复制一个mapred-site.xml

sudo cp etc/hadoop/mapred-site.xml.template etc/hadoop/mapred-site.xml

修改mapred-site.xml文件

sudo vim etc/hadoop/mapred-site.xml

修改内容:

mapreduce.framework.name

yarn

mapreduce.jobhistory.address

server3:10020

mapreduce.jobhistory.webapp.address

server3:19888

7 将/hadoop目录通过scp命令传输到server2和server3机器

7.1 分别在server2和server3机器上创建一个/hadoop目录

sudo mkdir /hadoop

7.2 修改/hadoop用户权限

sudo chown -R hadoop:hadoop /hadoop

7.3 scp命令将server1的/hadoop/hadoop2.7.5目录发送到server2和server3的/hadoop目录

# 将server1的/hadoop/hadoop2.7.5通过scp发送到server2的/hadoop目录

scp /hadoop/hadoop2.7.5 server2:/hadoop

scp /hadoop/hadoop2.7.5 server3:/hadoop

7.4 配置server2和server3的hadoop环境变量

server2和server3的hadoop的环境配置

sudo vim /etc/profile

export HADOOP_HOME=/hadoop/hadoop-2.7.5

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

8、格式化namenode

bin/hdfs namenode -format

9、hadoop的服务启动

9.1 server1启动dfs服务

sbin/start-dfs.sh

9.2 server1启动yarn服务

sbin/start-yarn.sh

9.3 启动server3的historyserver

sbin/mr-jobhistory-daemon.sh start historyserver

9、hadoop的wordcount案例测试

9.1 创建一个wc.input文件

在/home/hadoop目录下,创建一个wc.input文件

vim /home/hadoop/wc.input

9.2 在HDFS创建输入目录/wordcounttest/input

bin/hdfs dfs -mkdir -p /wordcounttest/input

9.3 将wc.inpt文件上传到hdfs中

bin/hdfs dfs -put /home/hadoop/wc.input /wordcounttest/input

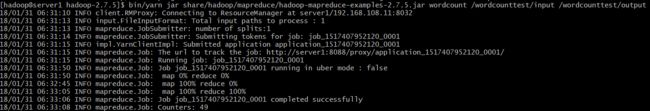

9.4 运行wordcount的demo

bin/yarn jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.5.jar wordcount /wordcounttest/input /wordcounttest/output

9.5 运行结果查看

- 9.5.1 查看输出目录

bin/hdfs dfs -ls /wordcounttest/output/

结果:

Found 2 items

-rw-r--r-- 3 hadoop supergroup 0 2018-01-31 06:33 /wordcounttest/output/_SUCCESS

-rw-r--r-- 3 hadoop supergroup 140 2018-01-31 06:33 /wordcounttest/output/part-r-00000

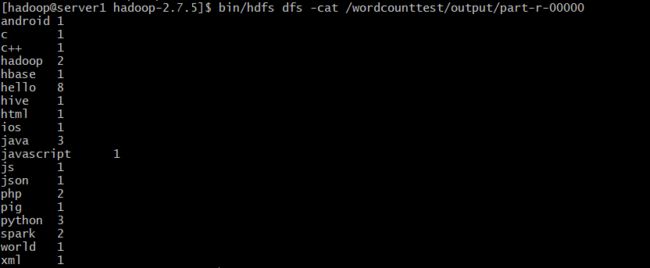

- 9.5.2 查看输出结果

bin/hdfs dfs -cat /wordcounttest/output/part-r-00000

10、关闭服务

10.1 关闭dfs服务

sbin/stop-dfs.sh

10.2关闭yarn服务

sbin/stop-yarn.sh

10.3 关闭historyserver服务

sbin/mr-jobhistory-daemon.sh stop historyserver

10.4 关闭所有服务

sbin/stop-all.sh