Intel MKL是一个非常高性能的矩阵库,Matlab的矩阵计算核心就是链接了这个库。但可惜国内学习资源不多,而且语法跟Matlab、Numpy等相差甚远,因此比较少用。但是我们可以用MKL来加速语法风格跟Matlab、Numpy很像的Eigen库,使得用了Eigen库的C++矩阵计算程序在一定程度上赶超Matlab的矩阵运算性能。//使用Eigen编码,Intel MKL优化

Eigen库是一个高层次的C++矩阵库,支持包括固定大小、任意大小的所有矩阵操作,甚至是稀疏矩阵;支持所有标准的数值类型,并且可以扩展为自定义的数值类型;支持多种矩阵分解及其几何特征的求解;它不支持的模块生态系统提供了许多专门的功能,如非线性优化,矩阵功能,多项式解算器,快速傅立叶变换等。

多的不说了,下面开始进行Intel MKL的安装:

一.Intel MKL安装及VS2015下的属性配置:(谨记:要先安装VS再安装MKL!)

我安装的是2018版本。于是我下载parallel_studio_xe_2018。推荐从官网下载,安装文件在3.4G左右。

在官网用邮箱注册可以获得试用的下载码以及lic激活文件(我们可以认为它是免费的了)。

打开该文件,居然是要解压才能继续安装……

点击setup.exe进行安装……

我选择的路径是:D:\Program Files\IntelSWTools

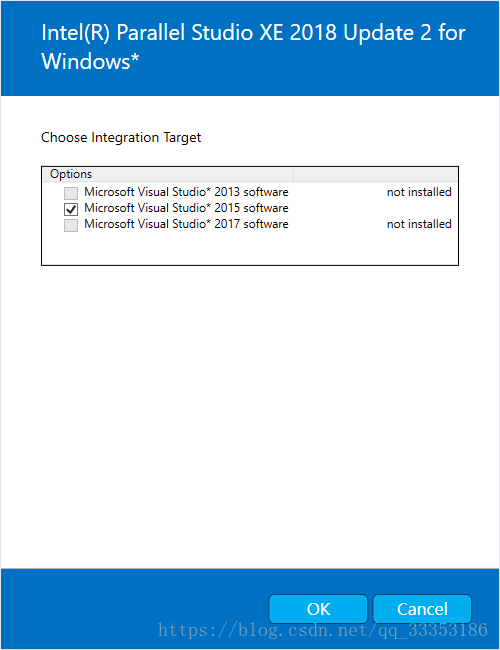

选择Integration Target为VS2015:

然后根据步骤安装即可。

安装后是这个样子的:此时环境变量已经自动设置好,就差VS2015里面的相关配置了。

下面开始配置VS2015使其能够调用Intel MKL库:

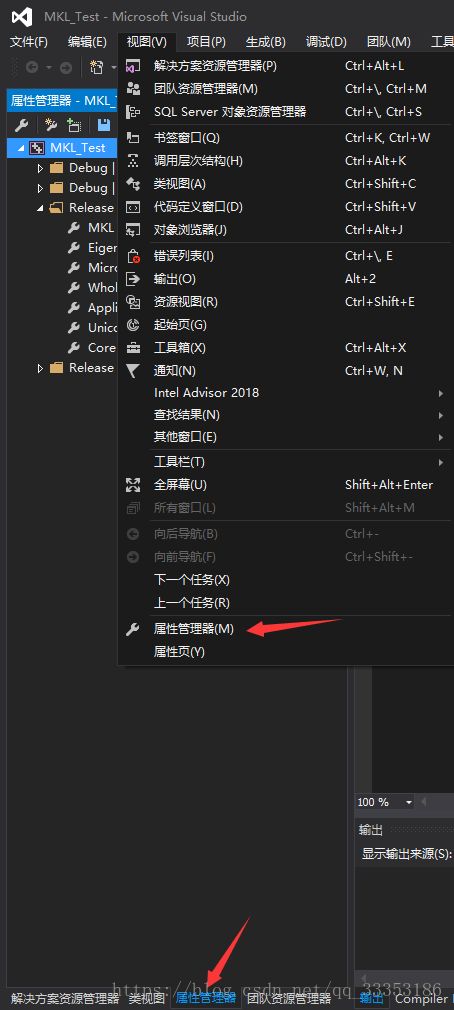

新建一个C++控制台项目,打开该项目的“属性管理器”:

这里Debug和Release的属性配置方法都是一样的,不同的是32位和64位的配置。

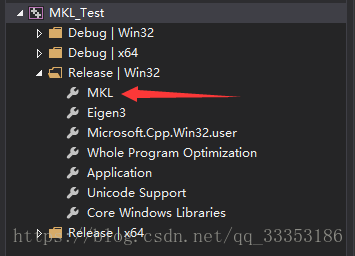

在Release|Win32下新建一个MKL属性:

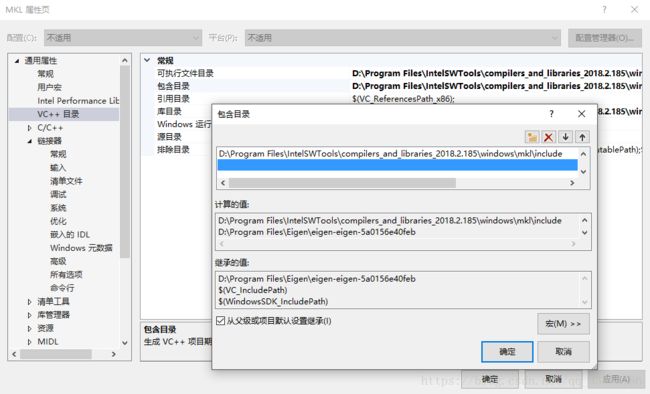

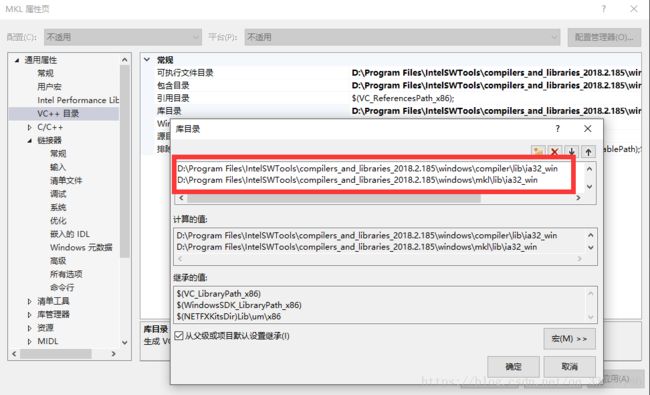

双击刚刚新建的属性配置文件,依次配置:VC++目录->可执行目录;VC++目录->包含目录;VC++目录->库目录;链接器->附加依赖项。具体的配置内容如图所示:

这样就OK了。下面配置Release|x64的属性:

同理创建好属性配置文件:

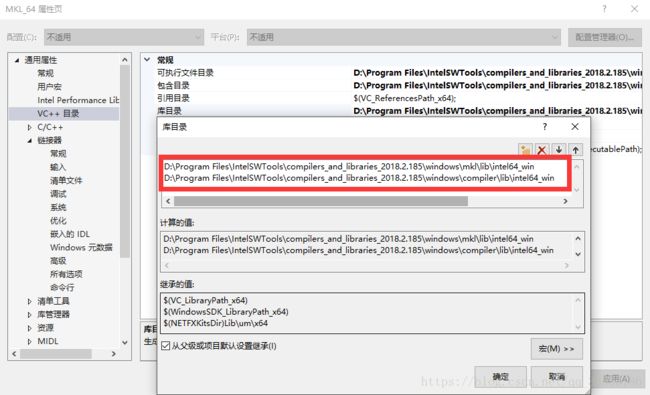

双击刚刚新建的属性配置文件,依次配置:VC++目录->可执行目录;VC++目录->包含目录;VC++目录->库目录;链接器->附加依赖项。注意:其中的“VC++目录->可执行目录;VC++目录->包含目录”两项配置内容跟前面的win32配置是一样的。后面的两项“VC++目录->库目录;链接器->附加依赖项”配置就有点不同了!这两项的详细配置内容如下图:

OK,完成上述步骤之后就可以在VS2015的该项目上调用Intel MKL库了。

实例代码不急着看……等讲完Eigen的安装与配置再放测试代码。

二. Eigen3的安装及VS2015中的属性配置:

1. 安装Eigen3相对简单很多,只需在官网上下载一个压缩包,然后解压到某个文件夹上即可:具体如下:

(当然也可以在github中下载到)

2. 解压到喜欢的文件夹下:

3. VS2015中的属性配置:此时无论是Debug模式还是Release模式,无论是Win32还是x64,都是一样的配置方法(因此只需建立一个配置文件,然后在属性管理器的其他模式下添加该配置文件即可)。

一步到位:C/C++->常规->附加包含目录

下面就可以来测试Eigen与Intel MKL结合的运行效果了:

代码如下:

//使用Eigen编码,Intel MKL优化//加这两行,用于调用Intel MKL库进行优化

#define EIGEN_USE_MKL_ALL

#define EIGEN_VECTORIZE_SSE4_2

#include

#include

#include

#include

#include

#include

using namespace std;

using namespace Eigen;

int main(int argc, char *argv[])

{

mkl_set_dynamic(4); // Intel MKL库里面的一个函数,用来指定使用4个CPU进行计算

double start = clock();

MatrixXd a = MatrixXd::Random(300, 300); // 随机初始化矩阵

MatrixXd b = MatrixXd::Random(300, 300);

// 循环5000次以测试性能与Matlab对比

for (int i = 0; i < 5000; i++) {

MatrixXd c = a * b; // 矩阵相乘

c = a.inverse(); // 求逆矩阵

c = a + b; // 矩阵相加

c = a.cwiseProduct(b); // 矩阵a和b按元素相乘(对应于Matlab的 .* )

}

double endd = clock();

double thisTime = (double)(endd - start) / CLOCKS_PER_SEC; // 输出运行时间

cout << thisTime << "秒" << endl;

return 0;

}

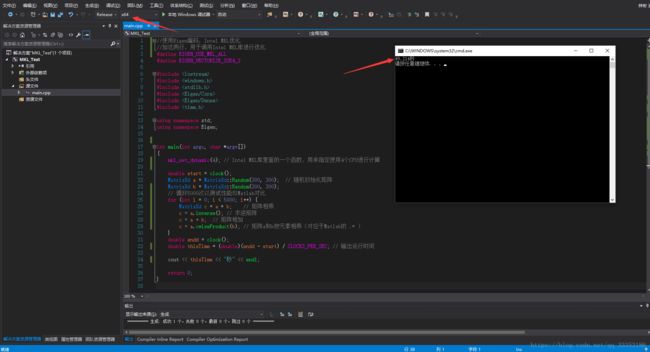

运行效果:

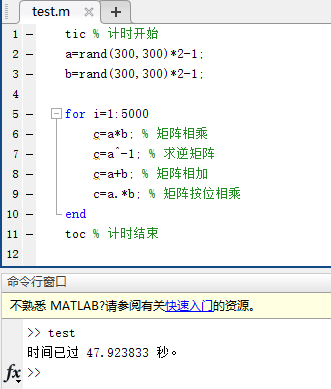

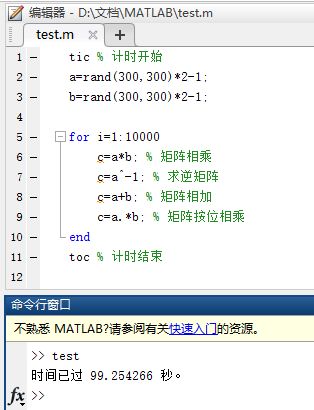

为了对比,用Matlab写一个相同功能的进行效率对比:

看到这个结果不要对C++的Eigen结合Intel MKL的方法感到失望。虽然Eigen本身也是个高性能的矩阵库,但也不如Intel MKL针对英特尔的CPU的特殊优化。本例中,因为毕竟是结合Intel MKL优化,而不是纯粹地用MKL。而Matlab是高度优化地用了Intel MKL进行矩阵计算的。因此这个C++的Eigen结合Intel MKL在矩阵计算上只能匹的得上Matlab,但是至于赶超,还需要纯粹地用Intel MKL或者再进行深度优化。

但是,C++在循环上效率是远超Matlab的,因此,假如上面的程序执行10000次,那么效率如下:

可见当大量进行循环时,用C++的Eigen结合Intel MKL方法,效率会比Matlab好,而且,开发效率也不比Matlab低。更不用说python了,python的numpy+mkl也难以跟上这个效率。关键是,Eigen是开源免费的,而Intel MKL我们可以用邮箱申请到非商业版,也等于是免费的了。相比要收费的Matlab而言,是越来越受到学生和开发者们的青睐了。

有人可能会认为搞矩阵搞机器学习人工智能,就应该用matlab、就应该用python,而不应该用折腾人的C++。这点我不否定,但其实python可以轻松地与C++结合。tensorflow也是如此,它的内核是用C++的,只是给python提供了接口以便用Python进行快速构建。顺便一提,tensorflow的矩阵库也是用eigen的,因此可以用python进行快速开发,同时也保证了极高的效率。