【学习笔记】Language+Vision数据集

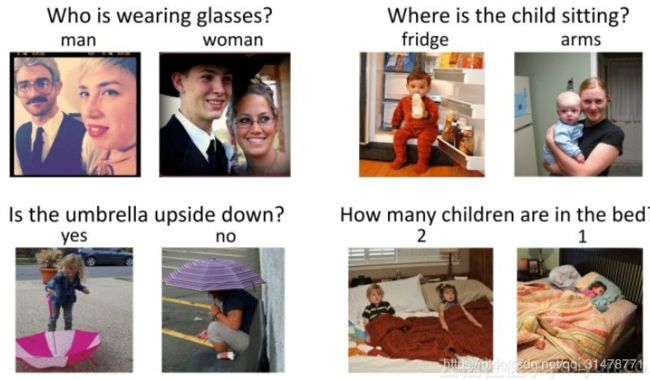

VQA数据集

DAQUAR

DAQUAR是最早提出的VQA数据集,也是最小的VQA数据集。DAQUAR中的图像来自于NYU-Depth v2 数据集,都是室内场景的RGBD图像,795张用于训练,654张用于测试。DAQUAR中的QA Pairs主要有两种类型:自动生成的和人工标注的。

COCO-QA

COCO-QA数据集中的图像来自于MS-COCO数据集,包括123287张图像,其中有72738张训练图像,38948张测试图像,并且每张图像都有一个QA Pair,每个Answer都是一个单词。这些QA Pairs都是根据MS-COCO中的图像描述自动生成的。根据Answer可以将Question分为四类:object、number、color 和location。由于问题都是自动生成的,所以存在一定的重复率。

FM-IQA

FM-IQA也是基于MS-COCO,包含123,287张图像。它的QA Pair是通过Amazon Mechanical Turk crowd-sourcing platform自动生成的。注释的人可以提出任何和图像相关的问题,使得FM-IQA相对于之前的数据集更加复杂。FM-IQA中的QA Pair是中文的,之后才将其翻译成英文的。

VQA

VQA数据集是在MS-COCO数据集的基础上添加了614K问题答案对,VQA1.0发布于2015年,由于这个数据集很新,所以还存在一些问题:你可以用简单的通过死记硬背来回答对很多问题,获得 ok 的效果。比如说 yes/no 问题,如果永远回答 yes,你就能答对大部分。所以这个数据集的答案有一定先验,不是很平衡。

在VQA1.0的基础上,采集了新的数据,发布了 VQA-2.0 的版本,这个版本比之前的版本又大了一倍。一共有 650000 的问题答案对,涉及 120000 幅不同的图片。这个新的数据库主要解决了答案不平衡的问题。对于同一个问题,他们保证,有两张不同的图片,使得他们对这个问题的答案是不同的。这使得VQA系统为了生成正确的答案不得不更多的利用图片特征,从而使视觉特征在VQA中扮演了更重要的角色。

C-VQA

CVQA 是对于 VQAv1 数据集的重新切分,使其可以用来研究语言的组合性问题。例如训练集中询问红灯、绿板,测试集中询问绿灯、红板,以测试回答未见过的问题组合的能力。

VQA-CP v2

VQA-CP v2数据集包含 219K 张图像数据,658K 条问题数据以及 6.6M 答案数据。该数据集提供了标准的训练测试过程,并将问题分解为不同的类型:如答案为肯定/否定类型,答案是数字类型,以及其他类型等,这有助于我们用每种问题类型准确性来评估网络架构的性能。

Visual Genome

Visual Genome包含108,249张图像,这些图像来自于YFCC100M和MS-COCO数据集,平均每张图像有17个QA pairs。在Visual Genome数据集中,主要包括两种形式的QA:基于整张图片的freedom QAs和基于特定图片内特定regions的region-based QAs。对于每张图片,作者收集了6中不同类型的question:what,where,how,when,who和why。

Visual7W

Visual7W是Visual Genome的一个子集,包含47,300张图像。Visual7W的问题主要由What, Where, How, When, Who,Why, and Which构成。Visual7W的问题是多选问题,每个问题都有四个候选答案。

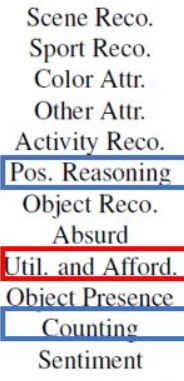

TDIUC

TDIUC数据集包含167,437张图像,1,654,167个QA pairs。它将问题的类型分成了十二种类型。

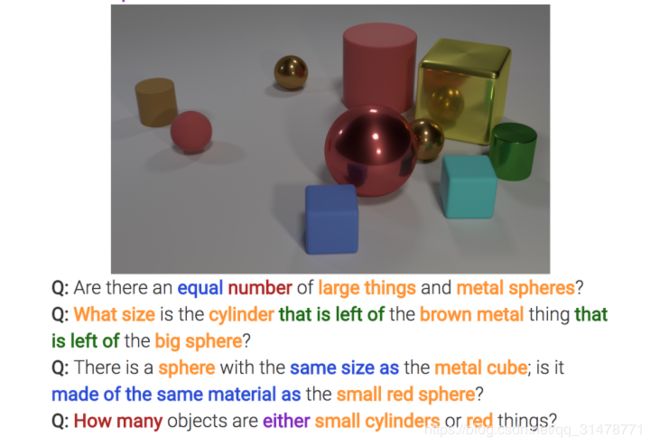

CLEVR

CLEVR 是一个合成数据库,由 100K 张 3D 渲染图像组成,如球体、圆柱体等。训练集包含70K张图像和699,989个问题;验证集包含15K张图像和149,991个问题;测试集包含15K张图像和14,988个问题。这些问题被分作五部分:查询属性、比较属性、是否存在、整体比较和计数。虽然视觉任务相对简单,但解决这个数据集也需要推理目标间的复杂关系。

CLEVR-CoGenT

CLEVR-CoGenT测试和处理未知概念组合和记忆已知概念组合的能力。它分为了CoGenT-A 和CoGenT-B,两个数据集含有互斥的形状和颜色组合。如果在CoGenT-A 上训练的模型在不微调的情况下在CoGenT-B上表现良好,表示模型对新组合的泛化能力强;如果在CoGenT-B上微调的模型在CoGenT-A 上表现良好,说明模型能记住旧概念组合。