算法面试必备-----决策树

算法面试必备-----决策树

- 算法面试必备-----决策树

- 建立决策树基本流程

- 划分选择的准则(不同的启发函数)

- 准则一:最大信息增益(ID3算法)

- 信息熵

- 信息增益

- ID3算法公式推导(使用信息增益)

- 公式

- 算法流程推导

- ID3算法的不足

- 为什么信息增益会偏向于取值多的特征

- 准则二:最大信息增益率(C4.5算法)

- 信息增益率

- 特点及使用

- C4.5 算法公式推导(使用信息增益率)

- 公式

- C4.5算法的不足

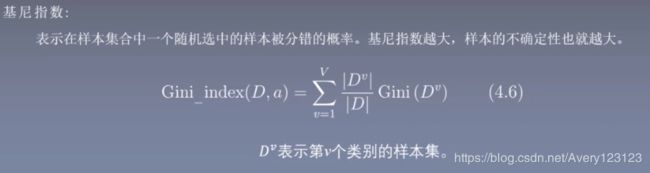

- 准则三:最大基尼指数(CART算法)

- 基尼指数

- CART算法公式推导

- 分类树:基尼指数最小原则

- 样本集合D的Gini指数

- 回归树:平方误差最小准则

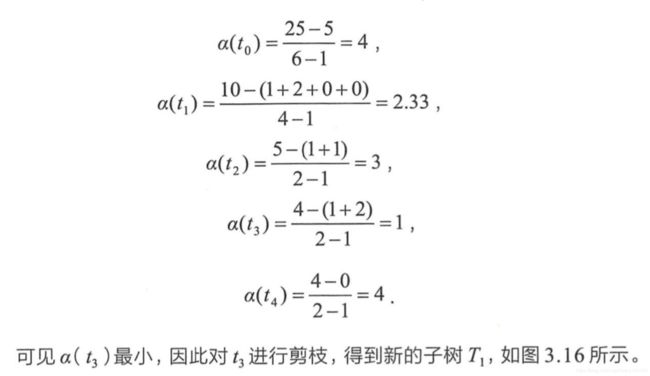

- 剪枝处理

- 预剪枝

- 后剪枝

算法面试必备-----决策树

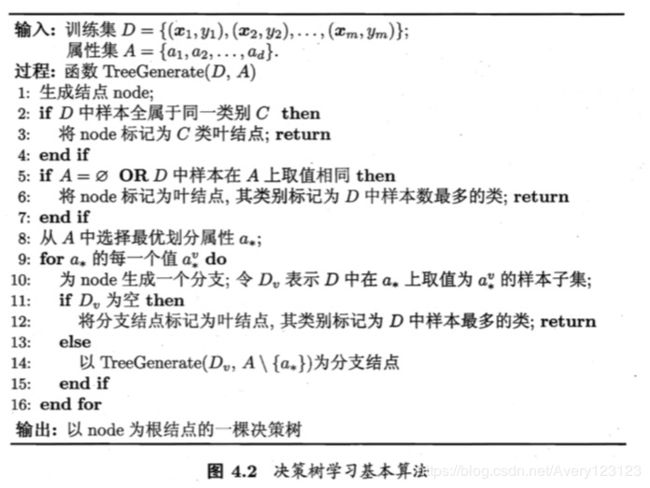

建立决策树基本流程

划分选择的准则(不同的启发函数)

准则一:最大信息增益(ID3算法)

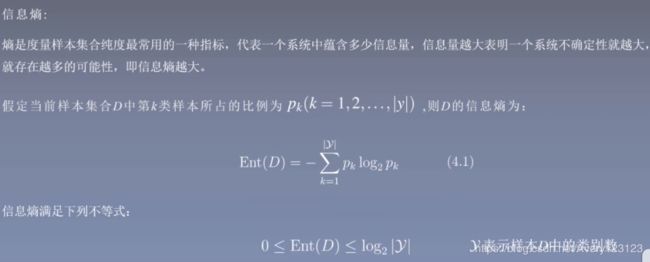

信息熵

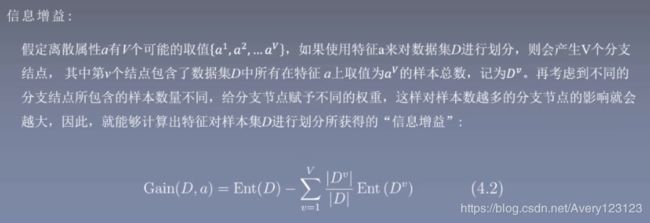

信息增益

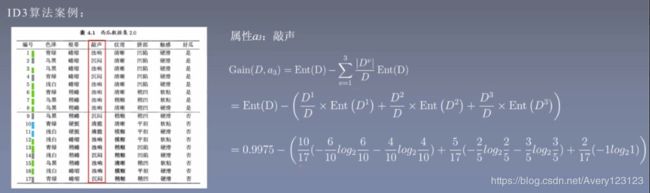

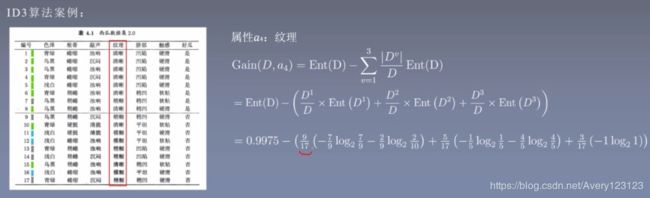

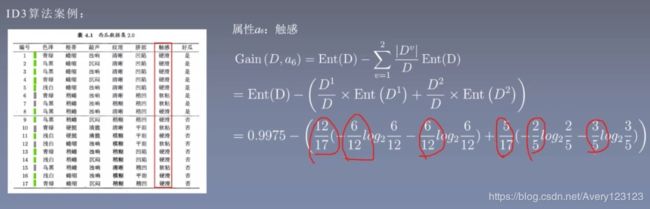

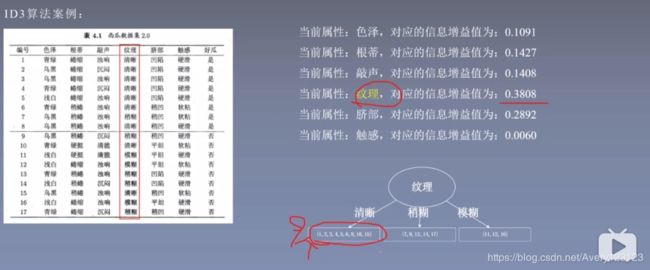

ID3算法公式推导(使用信息增益)

公式

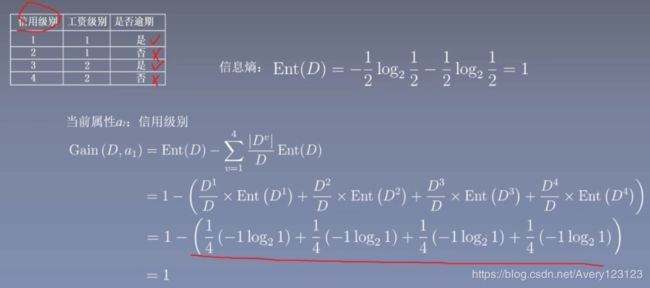

算法流程推导

从根节点信息熵开始

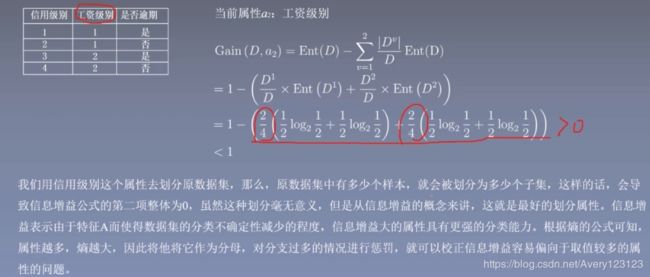

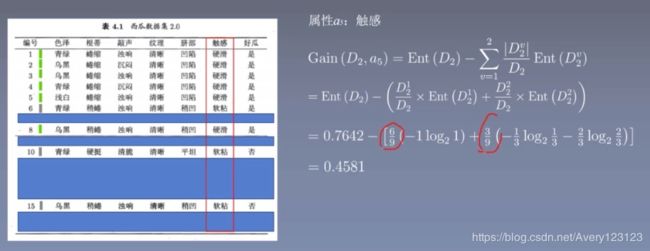

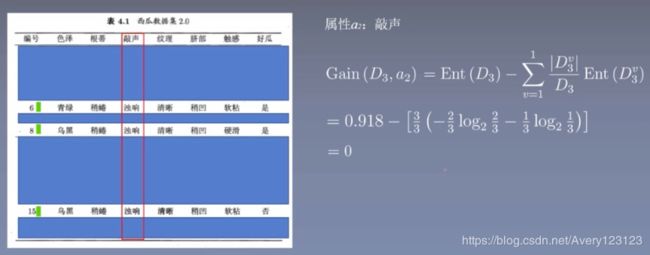

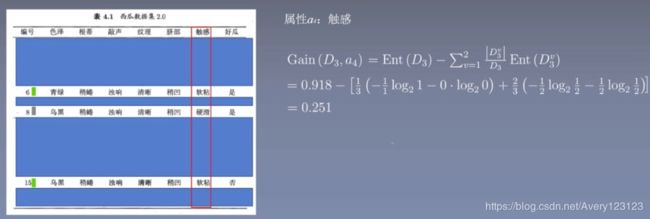

分别计算每个特征的信息增益

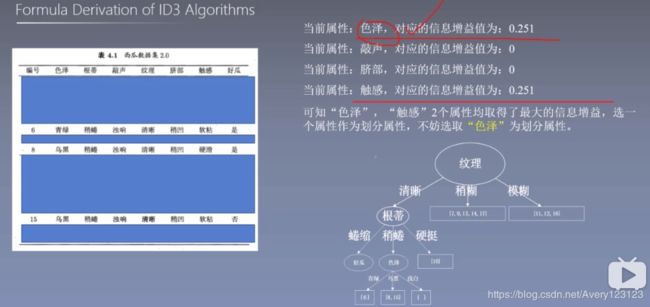

选取最大的信息增益

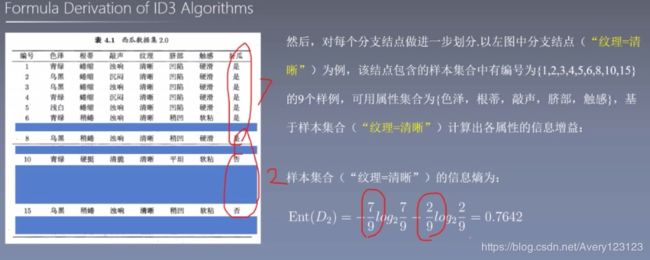

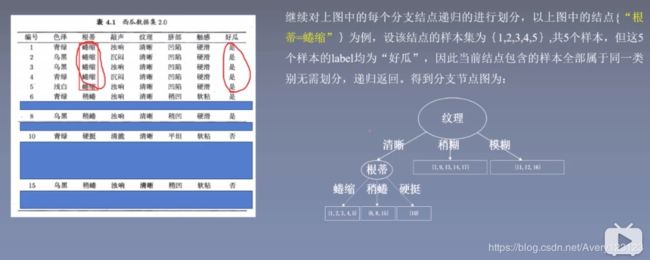

进一步划分,选一个新的信息划分起点

再次选取最大信息增益

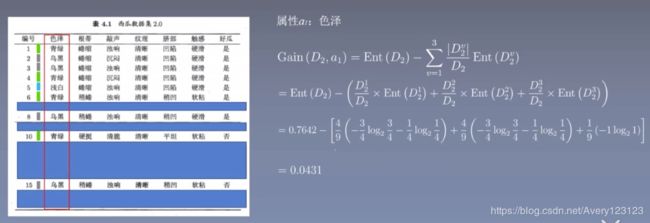

进一步划分,选一个新的信息划分起点

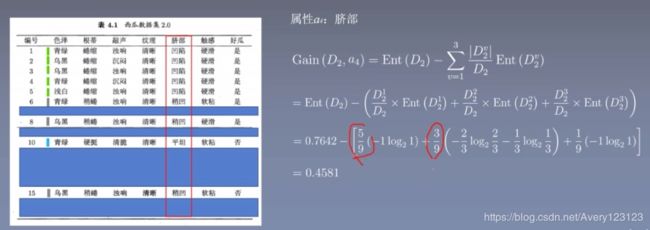

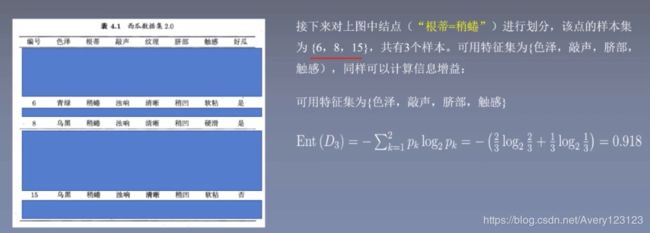

进一步划分,选一个新的信息划分起点

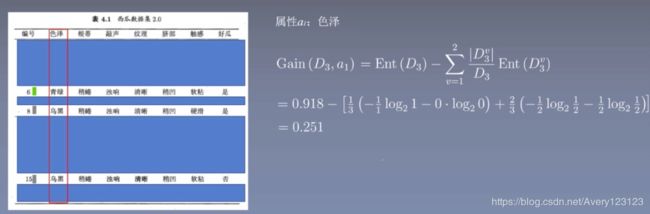

再次选取最大信息增益

其他的特征也一样

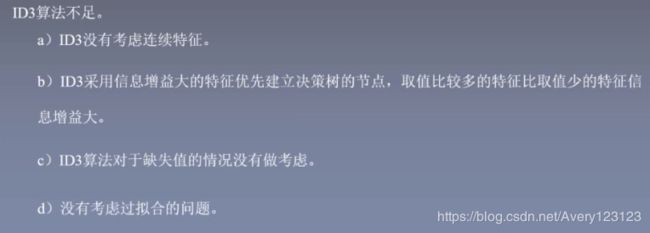

ID3算法的不足

为什么信息增益会偏向于取值多的特征

准则二:最大信息增益率(C4.5算法)

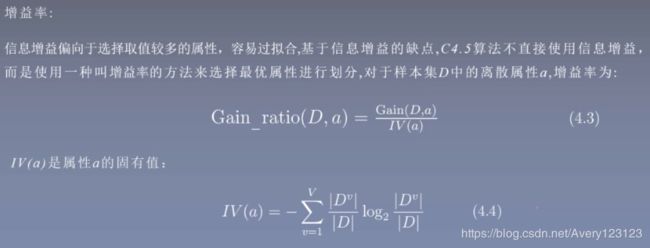

应对 ID3算法利用信息增益划分,造成划分倾向于划分属性多的特征

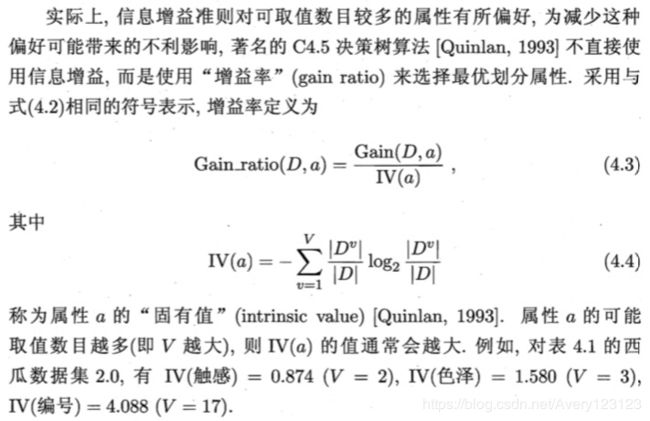

信息增益率

特点及使用

对可取数目较少的属性有所偏好

C4.5 算法公式推导(使用信息增益率)

公式

C4.5算法的不足

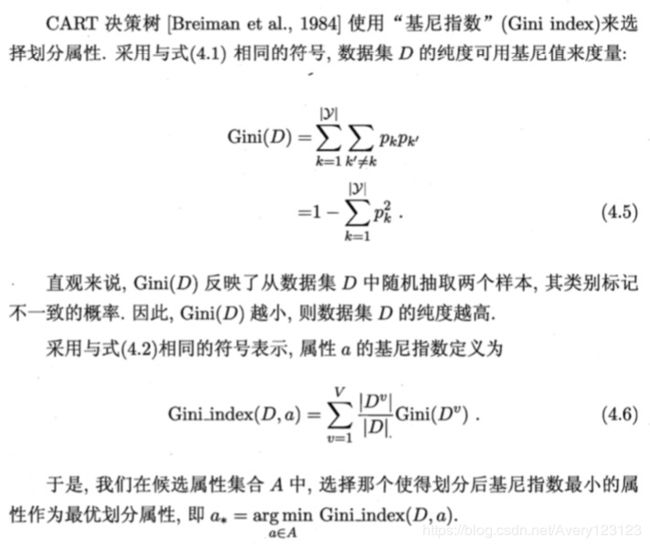

准则三:最大基尼指数(CART算法)

基尼指数

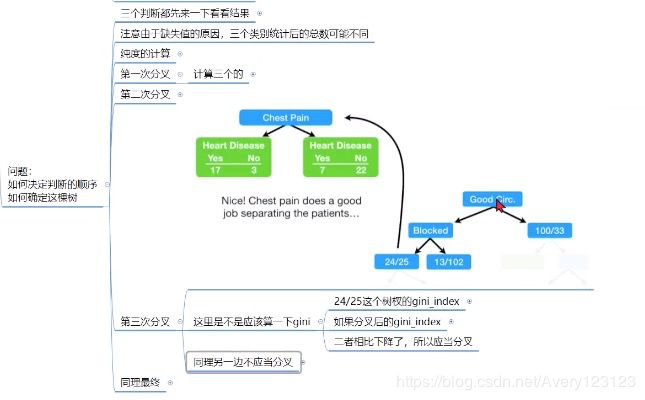

CART算法公式推导

分类树:基尼指数最小原则

样本集合D的Gini指数

回归树:平方误差最小准则

剪枝处理

预剪枝

容易造成欠拟合

后剪枝

过程复杂,但是效果好!