OpenMV实现多色块监测功能、测距功能---robomaster飞镖制导一种思路

OpenMV简介

简单的来说,它是一个可编程的摄像头,通过MicroPython语言,可以实现你的逻辑。而且摄像头本身内置了一些图像处理算法,很容易使用。OpenMV只有30万的像素,通常使用320_240的分辨率来处理图像,OpenMV3 Cam M7采集图像采集图像分辨率最高可以达到640_480,无法获得更高的像素。这使得它支持一些简易的识别算法,而对一般复杂的算法无法提供更多的硬件支持

项目简介

接触到OpenMV是因为团队在robomaster的飞镖系统实现上的一种构想,如果没有外部因素如场地的风、无人机的机翼等因素的干扰,计算模型直接打靶不知道行不行···反正OpenMV很轻便,如果通过识别可以让飞镖进行姿态调整的话也是极好的2333由于目前还没开学!很多想法得不到实验呜呜呜!

代码

目前随便写了个多色块识别(貌似有指示灯),剩下的只能等开学再更了···

# 色块监测 例子

#

# 这个例子展示了如何通过find_blobs()函数来查找图像中的色块

# 这个例子查找的颜色是深绿色

import sensor, image, time

from pyb import UART

import json

# 颜色追踪的例子,一定要控制环境的光,保持光线是稳定的。

green_threshold = (0, 100, -74, -40, 11, 58)

red_threshold = (0, 100, 33, 106, 11, 64)

#green_threshold = (45, 70, -60, -40, 20, 60)

#设置绿色的阈值,括号里面的数值分别是L A B 的最大值和最小值(minL, maxL, minA,

# maxA, minB, maxB),LAB的值在图像左侧三个坐标图中选取。如果是灰度图,则只需

#设置(min, max)两个数字即可。

sensor.reset() # 初始化摄像头

sensor.set_pixformat(sensor.RGB565) # 格式为 RGB565.

sensor.set_framesize(sensor.QQVGA) # 使用 QQVGA 速度快一些

sensor.skip_frames(time = 2000) # 跳过2000s,使新设置生效,并自动调节白平衡

sensor.set_auto_gain(False) # 关闭自动自动增益。默认开启的,在颜色识别中,一定要关闭白平衡。

sensor.set_auto_whitebal(False)

#关闭白平衡。白平衡是默认开启的,在颜色识别中,一定要关闭白平衡。

clock = time.clock() # 追踪帧率

K = 6000

uart = UART(3,115200)

while(True):

clock.tick() # Track elapsed milliseconds between snapshots().

img = sensor.snapshot(1.8) # 从感光芯片获得一张图像

blobs = img.find_blobs([green_threshold,red_threshold],pixels_threshold = 24,area_threshold = 5,merge = True)

#blobr = img.find_blobs([red_threshold],pixels_threshold = 24,area_threshold = 5,merge = True)

#bloba = blobr.add(blobg)

if blobs:

#如果找到了目标颜色

output_str = json.dumps(blobs)

for b in blobs: #循环效果不好,会有很多误识别,采用单个矩形采样方便返回坐标

#迭代找到的目标颜色区域

x = b[0]

y = b[1]

width = b[2]

height = b[3]

# Draw a rect around the blob.

img.draw_rectangle([x,y,width,height]) # rect

#用矩形标记出目标颜色区域

img.draw_cross(b[5], b[6]) # cx, cy

#在目标颜色区域的中心画十字形标记

print('send:',output_str)

uart.write(output_str+'\n')

Lm = (b[2]+b[3])/2

length = K/Lm

print(length)

print(clock.fps()) # 注意: 你的OpenMV连到电脑后帧率大概为原来的一半

#如果断开电脑,帧率会增加

首先和大家说下!OpenMV的官方里的资料非常的全,绝大多数的问题里面都已经写好教程了,或者可以查阅技术文档

https://book.openmv.cc/

剩下就是代码之间整合一下就OK了,建议大家去下载下OpenMV的环境,很方便,加快开发速度。

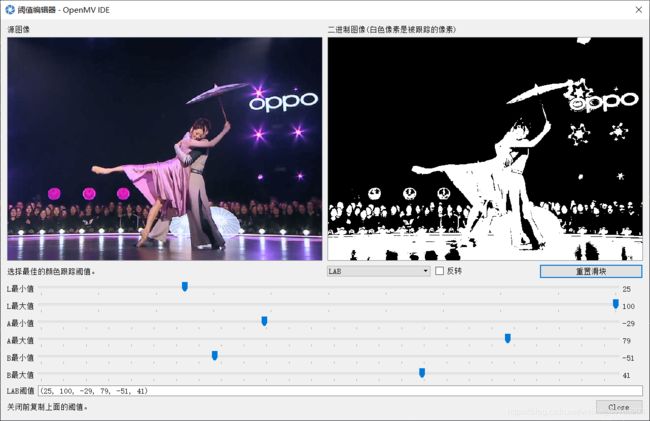

比如说这个阈值编辑器,很方便的就可以获取到想要的阈值有木有

然后说下思路8····

我们要实现的是双色检测,即红色和绿色,所以我们需要定义这俩颜色对应的阈值

green_threshold = (0, 100, -74, -40, 11, 58) red_threshold = (0, 100, 33, 106, 11, 64)然后就是参数的配置,这里在识别颜色的时候一定要关闭白平衡!!否则会出现很多误识别。

sensor.snapshot(1.8)去鱼眼化接下来就是核心的算法 find_blobs(thresholds, roi=Auto, x_stride=2, y_stride=1, invert=False, area_threshold=10, pixels_threshold=10, merge=False, margin=0, threshold_cb=None, merge_cb=None)

这个图像的一个类方法,它返回的是很多个色块对象,可以看作是一个list

roi为感兴趣区域

x_stride 就是查找的色块的x方向上最小宽度的像素,默认为2

y_stride 就是查找的色块的y方向上最小宽度的像素,默认为1

invert 反转阈值,把阈值以外的颜色作为阈值进行查找

area_threshold 面积阈值,如果色块被框起来的面积小于这个值,会被过滤掉

pixels_threshold 像素个数阈值,如果色块像素数量小于这个值,会被过滤掉

merge 合并,如果设置为True,那么合并所有重叠的blob为一个。

注意:这会合并所有的blob,无论是什么颜色的。如果你想混淆多种颜色的blob,只需要分别调用不同颜色阈值的find_blobs。

margin 边界,如果设置为1,那么两个blobs如果间距1一个像素点,也会被合并

blob有多个方法:

-

blob.rect() 返回这个色块的外框——矩形元组(x, y, w, h),可以直接在image.draw_rectangle中使用。

-

blob.x() 返回色块的外框的x坐标(int),也可以通过blob[0]来获取。

-

blob.y() 返回色块的外框的y坐标(int),也可以通过blob[1]来获取。

-

blob.w() 返回色块的外框的宽度w(int),也可以通过blob[2]来获取。

-

blob.h() 返回色块的外框的高度h(int),也可以通过blob[3]来获取。

-

blob.pixels() 返回色块的像素数量(int),也可以通过blob[4]来获取。

-

blob.cx() 返回色块的外框的中心x坐标(int),也可以通过blob[5]来获取。

-

blob.cy() 返回色块的外框的中心y坐标(int),也可以通过blob[6]来获取。

-

blob.rotation() 返回色块的旋转角度(单位为弧度)(float)。如果色块类似一个铅笔,那么这个值为0~180°。如果色块是一个圆,那么这个值是无用的。如果色块完全没有对称性,那么你会得到0~360°,也可以通过blob[7]来获取。

-

blob.code() 返回一个16bit数字,每一个bit会对应每一个阈值。举个例子:

blobs = img.find_blobs([red, blue, yellow], merge=True)

如果这个色块是红色,那么它的code就是0001,如果是蓝色,那么它的code就是0010。注意:一个blob可能是合并的,如果是红色和蓝色的blob,那么这个blob就是0011。这个功能可以用于查找颜色代码。也可以通过blob[8]来获取。

-

blob.count() 如果merge=True,那么就会有多个blob被合并到一个blob,这个函数返回的就是这个的数量。如果merge=False,那么返回值总是1。也可以通过blob[9]来获取。

-

blob.area() 返回色块的外框的面积。应该等于(w * h)

-

blob.density() 返回色块的密度。这等于色块的像素数除以外框的区域。如果密度较低,那么说明目标锁定的不是很好。

比如,识别一个红色的圆,返回的blob.pixels()是目标圆的像素点数,blob.area()是圆的外接正方形的面积

blobs = img.find_blobs([green_threshold,red_threshold],pixels_threshold = 24,area_threshold = 5,merge = True)这里我们选择两种颜色,所以需要拼接这两个阈值,使用pixels和area综合来过滤掉细小的像素识别。

然后画出矩形,采用上面的blobs方法可以获取到矩形的中心坐标cx,cy

然后采用JSON传输数据并返回在串行终端里。

output_str = json.dumps(blobs)因为后期可能需要实现测距功能,我这里提前把测距给写了,运用到的是简单的比例关系,推导在官方文档有。

距离=常数/像素直径

K = 6000Lm = (b[2]+b[3])/2length = K/Lm这三行是主要的测距代码,其中K为常数,是需要测算的。

可以先把测算的物体固定在一个给定距离的位置上,然后再乘以打印出来的小球像素值,即可得到K值。

这里的K值需要不同场景重新测算一遍嗷!!

关于这个像素直径,用勾股定理来算也是可以的。

忘记了···最后附上运行的录屏,串口的json数据就不放上来了···有兴趣想看的同学或者觉得我说的不对的同学可以私信我呀!

OPENMV多色识别

看到这里不容易

祝你完事都如意看到这儿的小伙伴有空的就点个赞吧!

不是同一个时间,但是是同一个博客,期待你我下次再会!