云计算与虚拟化工具之KVM

很多人会将云计算和虚拟化弄混,我下面为大家介绍一下

云计算指的是资源使用和交互的一种模式 虚拟化指的是技术,可以将物理计算机虚拟成多个逻辑计算机(VMware)

他俩是彼此独立,互不影响,但是云计算又需要使用虚拟化技术。我们也可以说成云计算包含虚拟化,他们两个是无法相比较的。

如果我们不想使用KVM,也可以使用LXD来替代KVM虚拟化技术

拓展知识:

LXD是容器虚拟化技术,可以用来替代KVM。测试的性能是远远的超过KVM,它是lxc的管理工具来实现的。LXD是一个完整的操作系统

相关文章链接请点我

LXC是容器是一种内核虚拟化技术。

相关文章链接请点我

LXCFS主要是用作docker隔离,例如我们执行uptime,出来的时间是物理机的而不是容器里面的proc下面的文件docker是无法隔离的,我们可以使用LXCFS技术进行隔离

相关文章链接请点我

云计算介绍

传统数据中心面临的问题:

资源利用率低

资源分配不合理

自动化能力差

初始成本高

IDC托管传统流程:买台机器-放到IDC-安装系统-部署应用-买个域名-绑定上去-对外访问-ICP备-ICP证-文网文

一、云计算是什么?

云计算是一种模式云计算必须通过网络来使用弹性计算、按需付费、快速扩展 (VPS就无法做到)不需要关心太多基础设施,都有云计算提供商提供

二、云计算分类

私有云 解释:私有云就是自己构建一个云计算平台

公有云 解释:公有云提供商来进行提供云计算服务

混合云 解释:既有私有云又包含公有云

提示:现在私有云在国内比较火

三、云计算分层

提示:有了云计算以后,下面绿色的才是我们需要维护的

三种不同的场景

1.IDC环境 需要考虑网络、服务器、机房位置、带宽等,都需要考虑

2.基础设施环境 平台级别,类似于阿里云的ces 提供一个平台 服务是我们自己搭建的

3.平台环境 软件级别类似于腾讯企业邮箱,只需要买用户就可以安全措施腾讯有提供服务

云计算是一种资源通过网络交互的一种模式,同时这个资源要具有弹性扩展、按需付费等特性

提示:现在大多数互联网基本上都是SaaS,只卖服务,不卖产品

四、什么是KVM?

KVM是内核级虚拟化技术

KVM全称Kernel-based Virtual Machine

提示:在虚拟化中,每台系统之间都是不会相互影响的。

五、虚拟化分类

1.硬件虚拟化 硬件虚拟化代表:

KVM

2.软件虚拟化 软件虚拟化代表:Qemu

提示:硬件虚拟化是需要CPU支持,如果CPU不支持将无法创建KVM虚拟机

六、虚拟化技术

全虚拟化:全虚拟化代表有:`KVM`半虚拟化:半虚拟化代表有:`Hypervisor`针对`IO层面半虚拟化`要比全虚拟化要好,因为`磁盘IO`多一层必定会慢。一般说IO就是网络IO和磁盘IO 因为这两个相对而言是比较`慢`的提示: Qemu和KVM的最大区别就是,如果一台物理机内存直接4G,创建一个vm虚拟机分配内存分4G,在创建一个还可以分4G。支持超配,但是qemu不支持

七、虚拟化使用场景分类

服务器虚拟化:解决资源利用率低的问题

桌面虚拟化:有一些弊端,图形显示层面会有问题

应用虚拟化:没接触过,公司比较穷买不起,基本上只有银行等国企才会用`**Xenapp ICA

八、虚拟化工具KVM介绍

KVM 全称:Kernel-based Virtual Machine(内核级虚拟化机器)

原本由以色列人创建,现在被红帽收购 ESXI 虚拟套件,现在是免费使用

VMware vSphere Hypervisor – 安装和配置

提示:一台服务器首选ESXI

九、KVM安装

调整虚拟机

虚拟化Intel使用的是intel VT-X AMD使用的是AMD-V

创建虚拟机步骤

1.准备虚拟机硬盘

2.需要系统iso镜像

3.需要安装一个vnc的客户端来连接

查看系统环境

[root@linux-node1 ~]# cat /etc/redhat-releaseCentOS Linux release 7.2.1511 (Core)[root@linux-node1 ~]# uname -r3.10.0-327.36.2.el7.x86_64

Centos7下载:http://pan.baidu.com/s/1c2MHsGg 密码:5w1u

检查是否有vmx或者svm

[root@linux-node1 ~]# grep -E '(vmx|svm)' /proc/cpuinfoflags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts mmx fxsr sse sse2 ss syscall nx pdpe1gb rdtscp lm constant_tsc arch_perfmon pebs bts nopl xtopology tsc_reliable nonstop_tsc aperfmperf eagerfpu pni pclmulqdq vmx ssse3 fma cx16 pcid sse4_1 sse4_2 x2apic movbe popcnt tsc_deadline_timer aes xsave avx f16c rdrand hypervisor lahf_lm abm 3dnowprefetch ida arat epb pln pts dtherm hwp hwp_noitfy hwp_act_window hwp_epp tpr_shadow vnmi ept vpid fsgsbase tsc_adjust bmi1 hle avx2 smep bmi2 invpcid rtm rdseed adx smap xsaveopt

安装kvm用户态模块

[root@linux-node1 ~]# yum list|grep kvmlibvirt-daemon-kvm.x86_64 1.2.17-13.el7_2.5 updatespcp-pmda-kvm.x86_64 3.10.6-2.el7 baseqemu-kvm.x86_64 10:1.5.3-105.el7_2.7 updatesqemu-kvm-common.x86_64 10:1.5.3-105.el7_2.7 updatesqemu-kvm-tools.x86_64 10:1.5.3-105.el7_2.7 updates[root@linux-node1 ~]# yum install qemu-kvm qemu-kvm-tools libvirt -ylibvirt 用来管理kvmkvm属于内核态,不需要安装。但是需要一些类似于依赖的

启动

[root@linux-node1 ~]# systemctl start libvirtd.service[root@linux-node1 ~]# systemctl enable libvirtd.service

启动之后我们可以使用ifconfig进行查看,libvirtd已经为我们安装了一个桥接网卡

[root@linux-node1 ~]# ifconfigeth0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet 192.168.56.11 netmask 255.255.255.0 broadcast 192.168.56.255inet6 fe80::20c:29ff:fef4:affe prefixlen 64 scopeid 0x20<link>ether 00:0c:29:f4:af:fe txqueuelen 1000 (Ethernet)RX packets 34379 bytes 41300995 (39.3 MiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 11590 bytes 1384679 (1.3 MiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536inet 127.0.0.1 netmask 255.0.0.0inet6 ::1 prefixlen 128 scopeid 0x10<host>loop txqueuelen 0 (Local Loopback)RX packets 103 bytes 7866 (7.6 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 103 bytes 7866 (7.6 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0virbr0: flags=4099<UP,BROADCAST,MULTICAST> mtu 1500inet 192.168.122.1 netmask 255.255.255.0 broadcast 192.168.122.255ether 52:54:00:f6:bd:c9 txqueuelen 0 (Ethernet)RX packets 0 bytes 0 (0.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 0 bytes 0 (0.0 B)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

libvirtd为我们启动了一个dnsmasqp,这个主要是用来dhcp连接的,这个工具会给我们的虚拟机分配IP地址

[root@linux-node1 ~]# ps -ef|grep dnsnobody 5233 1 0 14:27 ? 00:00:00 /sbin/dnsmasq --conf-file=/var/lib/libvirt/dnsmasq/default.conf --leasefile-ro --dhcp-script=/usr/libexec/libvirt_leaseshelperroot 5234 5233 0 14:27 ? 00:00:00 /sbin/dnsmasq --conf-file=/var/lib/libvirt/dnsmasq/default.conf --leasefile-ro --dhcp-script=/usr/libexec/libvirt_leaseshelperroot 5310 2783 0 14:31 pts/0 00:00:00 grep --color=auto dns

查看磁盘空间大小

最好是20G以上

[root@linux-node1 tmp]# df -hFilesystem Size Used Avail Use% Mounted on/dev/mapper/centos-root 48G 1.7G 46G 4% /devtmpfs 1.9G 0 1.9G 0% /devtmpfs 1.9G 0 1.9G 0% /dev/shmtmpfs 1.9G 8.6M 1.9G 1% /runtmpfs 1.9G 0 1.9G 0% /sys/fs/cgroup/dev/sda1 497M 167M 330M 34% /boottmpfs 378M 0 378M 0% /run/user/0

上传镜像

提示:如果使用rz上传镜像可能会出现错误,所以我们使用dd命令,复制系统的镜像。只需要挂载上光盘即可

[root@linux-node1 opt]# dd if=/dev/cdrom of=/opt/CentOS-7.2.iso[root@linux-node1 opt]# lltotal 33792-rw-r--r-- 1 root root 34603008 Jun 12 18:18 CentOS-7.2-x86_64-DVD-1511.iso

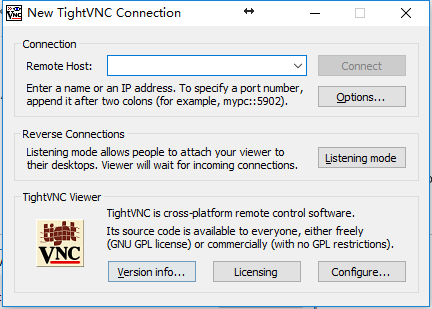

下载VNC

下载地址:http://www.tightvnc.com/download/2.8.5/tightvnc-2.8.5-gpl-setup-64bit.msi

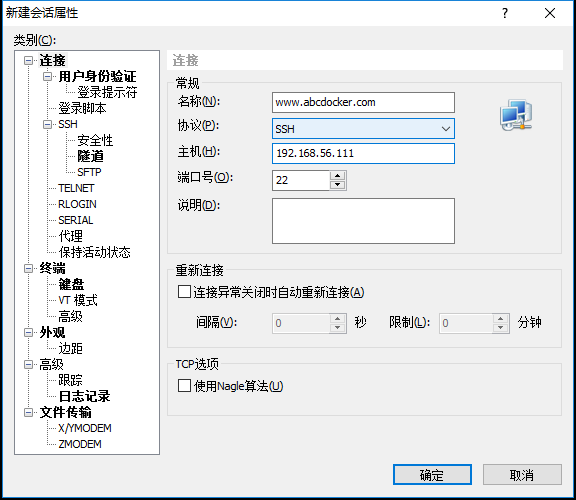

安装完VNC如下图

创建磁盘

提示: qemu-img软件包是我们安装qemu-kvm-tools 依赖给安装上的

[root@linux-node1 opt]# qemu-img create -f raw /opt/CentOS-7.2-x86_64.raw 10GFormatting '/opt/Centos-7-x86_64.raw', fmt=raw size=10737418240[root@linux-node1 opt]#[root@linux-node1 opt]# ll /opt/Centos-7-x86_64.raw-rw-r--r-- 1 root root 10737418240 Oct 26 14:53 /opt/Centos-7-x86_64.raw-f 制定虚拟机格式,raw是裸磁盘/opt/Centos 存放路径10G 代表镜像大小

安装启动虚拟机的包

[root@linux-node1 tmp]# yum install -y virt-install

安装虚拟机

可以使用—help查看相关存储

[root@linux-node1 tmp]# virt-install --help我们可以指定虚拟机的CPU、磁盘、内存等

安装虚拟机

[root@linux-node1 opt]# virt-install --name CentOS-7.2-x86_64 --virt-type kvm --ram 1024 --cdrom=/opt/CentOS-7.2.iso --disk path=/opt/CentOS-7.2-x86_64.raw --network network=default --graphics vnc,listen=0.0.0.0 --noautoconsole--name = 给虚拟机起个名字--ram = 内存大小--cdrom = 镜像位置,就是我们上传iso镜像的位置,我放在/tmp下了--disk path = 指定磁盘--network network= 网络配置 default 就会用我们刚刚ifconfig里面桥接的网卡--graphics vnc,listen= 监听vnc,

默认连接端口是从5900开始的

[root@linux-node1 tmp]# netstat -lntupActive Internet connections (only servers)Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program nametcp 0 0 0.0.0.0:3306 0.0.0.0:* LISTEN 2036/mysqldtcp 0 0 0.0.0.0:5900 0.0.0.0:* LISTEN 5767/qemu-kvmtcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 4401/rpcbindtcp 0 0 0.0.0.0:4369 0.0.0.0:* LISTEN 1163/epmdtcp 0 0 192.168.122.1:53 0.0.0.0:* LISTEN 5233/dnsmasqtcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1105/sshdtcp 0 0 0.0.0.0:15672 0.0.0.0:* LISTEN 1101/beamtcp 0 0 127.0.0.1:25 0.0.0.0:* LISTEN 1701/mastertcp 0 0 0.0.0.0:25672 0.0.0.0:* LISTEN 1101/beamtcp6 0 0 :::111 :::* LISTEN 4401/rpcbindtcp6 0 0 :::4369 :::* LISTEN 1163/epmdtcp6 0 0 :::22 :::* LISTEN 1105/sshdtcp6 0 0 ::1:25 :::* LISTEN 1701/mastertcp6 0 0 :::5672 :::* LISTEN 1101/beamudp 0 0 192.168.122.1:53 0.0.0.0:* 5233/dnsmasqudp 0 0 0.0.0.0:67 0.0.0.0:* 5233/dnsmasqudp 0 0 0.0.0.0:111 0.0.0.0:* 4401/rpcbindudp 0 0 0.0.0.0:123 0.0.0.0:* 866/chronydudp 0 0 127.0.0.1:323 0.0.0.0:* 866/chronydudp 0 0 0.0.0.0:760 0.0.0.0:* 4401/rpcbindudp6 0 0 :::111 :::* 4401/rpcbindudp6 0 0 ::1:323 :::* 866/chronydudp6 0 0 :::760 :::* 4401/rpcbind

提示:因为vnc默认是从5900开始的,所以我们如果是第一台不需要输入端口号

安装界面如下:

因为centos7 默认网卡发生改变,我们需要修改内核参数,使用eth0作为网卡

光标移动到Install CentOS上,按tab键 输入net.ifnames=0 biosdevname=0 回车

分区说明

提示:我们不分交换分区,因为公有云上的云主机都是没有交换分区的

分区如下:

然后我们点击Done

本次分配分区按照10G内存进行分配

分配标准分区

温馨提示:在虚拟机的世界里,越简单越好。像阿里云系统分区以前是给20个G,现在是给40个G

装系统步骤不详细说明了,过于简单,请自行百度

虚拟机安装完成后是关闭了,我们需要启动

[root@linux-node1 ~]# virsh list --all[root@linux-node1 ~]# virsh start CentOS-7.2-x86_64#CentOS-7.2-x86_64 是虚拟机的名字,是我们创建的时候定义的

启动之后将虚拟机网络进行修改

重启/etc/init.d/network restart 或者systemctl restart network

我们还需要修改一下DNS

现在我们就可以安装软件包了

我们启动的这个虚拟机在宿主机上显示这只是一个进程

提示:只有虚拟机启动才可以使用vnc进行连接

十、Libvirt介绍

libvirt是一个开源免费管理工具,可以管理KVM、VMware等

他需要起一个后台的进程,它提供了API。像openstack就是通过libvirt API来管理虚拟机

像我们virt-install 等命令底层都是通过libvirt来完成的

[root@linux-node1 ~]# ll /etc/libvirt/qemutotal 4-rw------- 1 root root 3896 Oct 26 16:34 CentOS-7.2-x86_64.xmldrwx------ 3 root root 40 Oct 26 16:11 networks

kvm虚拟机都是靠libvirt xml来定义的,我们是无法对他进行修改的,可以使用virsh edit CentOS-7.2-x86_64进行编辑

我们可以查看一下配置文件,大多数都是可以看的懂的

KVM管理命令

[root@abcdocker ~]# virt-install #建立kvm虚拟机[root@abcdocker ~]# virsh list #查看正在运行的KVM虚拟机[root@abcdocker ~]# virsh list --all #查看所有KVM虚拟机[root@abcdocker ~]# virsh start name #启动KVM虚拟机[root@abcdocker ~]# virsh shutdown name #正常关闭KVM虚拟机[root@abcdocker ~]# virsh destroy name #强制关闭KVM虚拟机(类似于直接断电)[root@abcdocker ~]# virsh suspend name #挂起KVM虚拟机[root@abcdocker ~]# virsh resume name #恢复挂起的KVM虚拟机[root@abcdocker ~]# virsh dumpxml name #查看KVM虚拟机配置文件[root@abcdocker ~]# virsh edit name #编辑KVM虚拟机的xml配置文件[root@abcdocker ~]# virsh undefine name #彻底删除KVM虚拟机,不可逆,如果想找回来,需要备份/etc/libvirt/qemu的xml文件[root@abcdocker ~]# virsh snapshot-create name #创建快照[root@linux-node1 ~]# virsh snapshot-create CentOS-7.2-x86_64error: unsupported configuration: internal snapshot for disk vda unsupported for storage type raw提示:kvm默认有一个镜像,我们现在做的镜像只是虚拟机修改过的地方做的快照.raw磁盘格式无法进行快照.我们在安装的时候需要修改为qcow2.具体介绍可以看下方io优化部分[root@abcdocker ~]# virsh snapshot-delete name #删除快照[root@abcdocker ~]# virsh snapshot-dumpxml name #导出XML[root@abcdocker ~]# virsh snapshot-list name #查看快照[root@linux-node1 ~]# virsh snapshot-list CentOS-7.2-x86_64Name Creation Time State------------------------------------------------------------

十一、KVM虚拟机配置

1、CPU设置

修改CPU的数量,我们在创建的时候就可以指定cpu数量

[root@linux-node1 ~]# virt-install --help | grep cpu--vcpus VCPUS Number of vcpus to configure for your guest. Ex:--vcpus 5--vcpus 5,maxcpus=10,cpuset=1-4,6,8--vcpus sockets=2,cores=4,threads=2,--cpu CPU CPU model and features. Ex:--cpu coreduo,+x2apic--cpu host

修改CPU我们只能修改虚拟机XML的配置

[root@linux-node1 ~]# head /etc/libvirt/qemu/CentOS-7.2-x86_64.xml<domain type='kvm'><name>CentOS-7.2-x86_64name><uuid>9c00c23f-505e-4e77-9fcd-34c0c834fc8duuid>

这里已经提示我们需要使用virsh edit CentOS-7.2-x86_64进行编辑修改

修改前

现在是静态的,不能进行改变。 我们修改为auto动态

<vcpu placement='auto' current="1">4vcpu>Auto=动态 static=静态Current=当前cpu数量4= 最大是4

动态修改不需要重启

[root@linux-node1 ~]# virsh setvcpus CentOS-7.2-x86_64 2 --live正常情况需要重启虚拟机,但是我们可以使用virsh setvcpus 使它动态获取2 表示cpu的个数

还可以使用

[root@linux-node1 ~]# virsh shutdown CentOS-7.2-x86_64[root@linux-node1 ~]# virsh start CentOS-7.2-x86_64

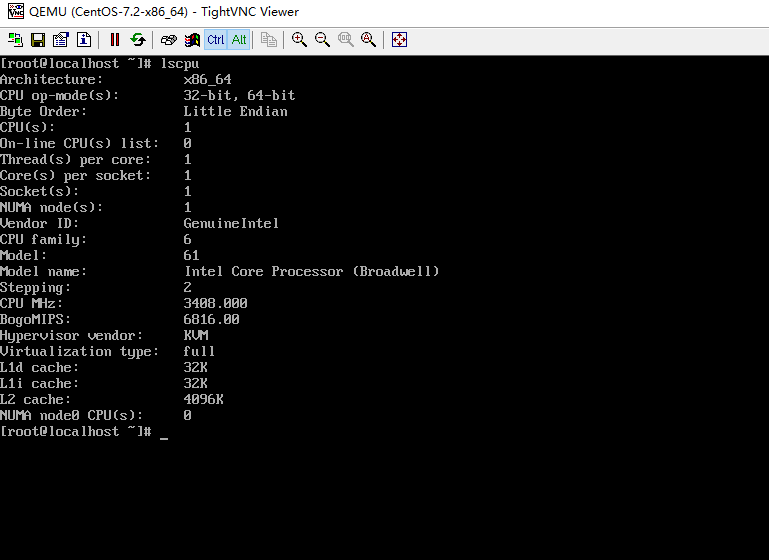

效果图如下:

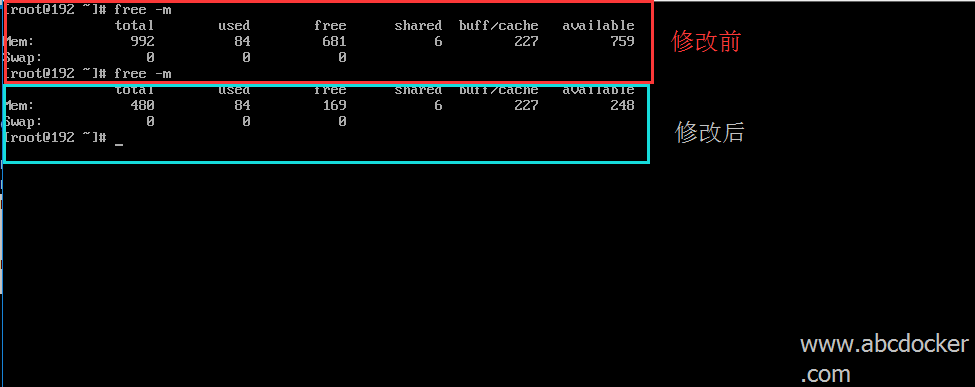

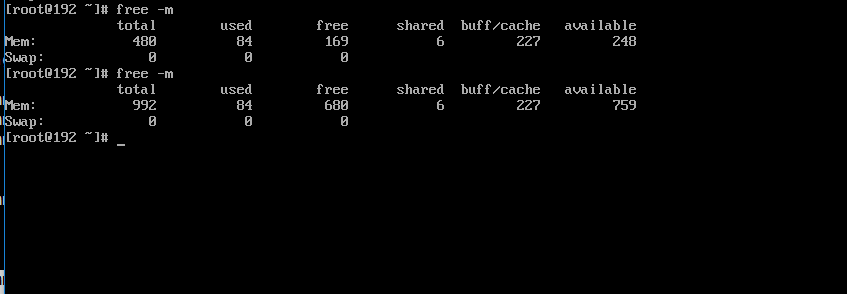

2、内存设置

内存是我们在安装的时候制作的,现在无法进行扩展,但是可以进行缩小。无法扩展的意思是我们执行virsh –install分配内存多大在如何修改也不可以超过设定的这个数

修改内存为512

[root@linux-node1 ~]# virsh qemu-monitor-command CentOS-7.2-x86_64 --hmp --cmd balloon 512[root@linux-node1 ~]# virsh qemu-monitor-command CentOS-7.2-x86_64 --hmp --cmd#第一条命令是修改,第二条命令是查看

[root@linux-node1 ~]# virsh qemu-monitor-command CentOS-7.2-x86_64 --hmp --cmd balloon 1024[root@linux-node1 ~]# virsh qemu-monitor-command CentOS-7.2-x86_64 --hmp --cmd info balloon

提示: 由此可见内存修改可以是动态的,但是有一个缺点是不能高于我们创建虚拟机的内存

3、硬盘设置

提示: 虚拟机磁盘支持扩容,但是生产不要使用。

Raw :全镜像模式,无法制作快照

Qcow2:稀疏模式,qcow2镜像格式是QEMU模拟器支持的一种磁盘镜像。它也是可以用一个文件形式来表示一块固定大小的块设备磁盘。

与普通raw格式的镜像相比,有以下特征:

1.更小的空间占用,即使用文件系统不支持空洞(hosts)

2.支持写时拷贝(COW,copy-on-write),镜像文件只能反映底层磁盘的变化

3.支持快照(snapshot),镜像文件能够包含多个快照的历史

4.可选择基于zlib的压缩方式

5.可以选择AES加密

Raw和Qcow2区别:

1.Raw 性能会比Qcow2快,因为没有那么多的功能

2.Raw磁盘无法扩展,分配多大就占用多大

3.Qcow2就是动态的,你用多大就占多大

4.通过Raw可以转换其他格式

我们可以使用qemu-img info来查看镜像格式

[root@linux-node1 ~]# qemu-img info /opt/CentOS-7.2-x86_64.rawimage: /opt/CentOS-7.2-x86_64.rawfile format: rawvirtual size: 10G (10737418240 bytes)disk size: 1.0G

转换格式

[root@linux-node1 ~]# qemu-img convert -f raw -O qcow2 /opt/CentOS-7.2-x86_64.raw test.qcow2

提示: 生产环境还是不要使用,可能会造成数据丢失

-rw-r--r-- 1 qemu qemu 4.1G Oct 26 16:33 CentOS-7.2.iso-rw-r--r-- 1 qemu qemu 10G Oct 27 15:08 CentOS-7.2-x86_64.raw-rw-r--r-- 1 root root 1.1G Oct 27 15:12 test.qcow2

按照用多少占多少进行分配的

[root@linux-node1 opt]# qemu-img info test.qcow2image: test.qcow2file format: qcow2virtual size: 10G (10737418240 bytes)disk size: 2.0Gcluster_size: 65536Format specific information:compat: 1.1lazy refcounts: false

4、KVM网络设置

默认虚拟机网络模式是NAT,我们可以看一下iptables

[root@linux-node1 ~]# iptables -L -nChain INPUT (policy ACCEPT)target prot opt source destinationACCEPT udp -- 0.0.0.0/0 0.0.0.0/0 udp dpt:53ACCEPT tcp -- 0.0.0.0/0 0.0.0.0/0 tcp dpt:53ACCEPT udp -- 0.0.0.0/0 0.0.0.0/0 udp dpt:67ACCEPT tcp -- 0.0.0.0/0 0.0.0.0/0 tcp dpt:67Chain FORWARD (policy ACCEPT)target prot opt source destinationACCEPT all -- 0.0.0.0/0 192.168.122.0/24 ctstate RELATED,ESTABLISHEDACCEPT all -- 192.168.122.0/24 0.0.0.0/0ACCEPT all -- 0.0.0.0/0 0.0.0.0/0REJECT all -- 0.0.0.0/0 0.0.0.0/0 reject-with icmp-port-unreachableREJECT all -- 0.0.0.0/0 0.0.0.0/0 reject-with icmp-port-unreachableChain OUTPUT (policy ACCEPT)target prot opt source destinationACCEPT udp -- 0.0.0.0/0 0.0.0.0/0 udp dpt:68

查看桥接网卡

[root@linux-node1 ~]# brctl showbridge name bridge id STP enabled interfacesvirbr0 8000.52540012d483 yes virbr0-nicvnet0

添加桥接网卡,因为DHCP会使我们无法使用xshell进行管理,所以我们将网卡变更为桥接网卡。.

[root@linux-node1 ~]# brctl addif br0 eth0添加br0并桥接到eth0上

现在已经可以连接上,无法出外网。缺少路由

[root@linux-node1 ~]# ip ro li192.168.56.0/24 dev br0 proto kernel scope link src 192.168.56.11192.168.122.0/24 dev virbr0 proto kernel scope link src 192.168.122.1

添加路由,ping百度进行测试

[root@linux-node1 ~]# route add default gw 192.168.56.2[root@linux-node1 ~]# ping www.baidu.comPING www.a.shifen.com (61.135.169.125) 56(84) bytes of data.64 bytes from 61.135.169.125: icmp_seq=1 ttl=128 time=9.52 ms^C--- www.a.shifen.com ping statistics ---1 packets transmitted, 1 received, 0% packet loss, time 0msrtt min/avg/max/mdev = 9.529/9.529/9.529/0.000 ms

提示:kvm 桥接网卡和eth0只能一个有IP地址,这样才算是正常的结果

[root@linux-node1 ~]# ifconfigbr0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet 192.168.56.11 netmask 255.255.255.0 broadcast 192.168.56.255inet6 fe80::20c:29ff:fef4:affe prefixlen 64 scopeid 0x20<link>ether 00:0c:29:f4:af:fe txqueuelen 0 (Ethernet)RX packets 251 bytes 18832 (18.3 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 157 bytes 19763 (19.2 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0eth0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet6 fe80::20c:29ff:fef4:affe prefixlen 64 scopeid 0x20<link>ether 00:0c:29:f4:af:fe txqueuelen 1000 (Ethernet)RX packets 15047 bytes 1796201 (1.7 MiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 23525 bytes 1763895 (1.6 MiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536inet 127.0.0.1 netmask 255.0.0.0inet6 ::1 prefixlen 128 scopeid 0x10<host>loop txqueuelen 0 (Local Loopback)RX packets 108 bytes 8966 (8.7 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 108 bytes 8966 (8.7 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0virbr0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet 192.168.122.1 netmask 255.255.255.0 broadcast 192.168.122.255ether 52:54:00:12:d4:83 txqueuelen 0 (Ethernet)RX packets 28 bytes 3842 (3.7 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 20 bytes 3615 (3.5 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0vnet0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet6 fe80::fc54:ff:fee2:1482 prefixlen 64 scopeid 0x20<link>ether fe:54:00:e2:14:82 txqueuelen 500 (Ethernet)RX packets 28 bytes 4234 (4.1 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 6677 bytes 350011 (341.8 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

现在里面的虚拟机还无法上网,我们需要编辑虚拟机 [root@linux-node1 ~]# virsh edit CentOS-7.2-x86_64

修改前

...<interface type='network'><mac address='52:54:00:e2:14:82'/><source network='default'/><model type='virtio'/><address type='pci' domain='0x0000' bus='0x00' slot='0x03' function='0x0'/>interface>...

修改后

...<interface type='bridge'><mac address='52:54:00:e2:14:82'/><source bridge='br0'/><model type='virtio'/><address type='pci' domain='0x0000' bus='0x00' slot='0x03' function='0x0'/>interface>...#br0是桥接网卡的名字

现在我们就需要重启虚拟机

[root@linux-node1 ~]# virsh list --allId Name State----------------------------------------------------2 CentOS-7.2-x86_64 running[root@linux-node1 ~]# virsh shutdown CentOS-7.2-x86_64[root@linux-node1 ~]# virsh start CentOS-7.2-x86_64

重启之后我们需要修改虚拟机的网卡配置文件

修改完并重启,然后ping 网关,ping百度查看是否可以ping通

提示:修改的是重启的虚拟机的网卡文件

现在我们就可以使用xshell进行连接了

十二、KVM优化

KVM优化分为三个方面 CPU、内存、IO(磁盘)

CPU优化:

Kvm是一个进程,是受cpu的调度,对于一个多口的cpu,进程会被调度到任何一个cpu上去。例如CPU缓存现在在1上面,进程被分配到2上面,那么就无法使用1的缓存就会遭成无法命中。

我们可以使用taskset来进行操作

[root@linux-node1 ~]# taskset -cp 0 8337pid 8337's current affinity list: 0-3#表示当前8337会在0-3CPU上调度pid 8337's new affinity list: 0#表示当前8337会在cpu0上进行调度8377 是进程号,通过ps -ef|grep kvm 来获取到-p pid 指定进程-c 指定cpu(可以写多个)

提示:可以减少开机miss,性能可以提高10%

内存优化

内存需要优化的很少,但是需要开起Memory EPT。这个技术是在bios里面开通的。还需要设置内存的寻址,简单的来说就是使用大页内存。

默认内存是分页的,一页是4096K.

[root@linux-node1 ~]# cat /proc/meminfoHugePages_Total: 0HugePages_Free: 0HugePages_Rsvd: 0HugePages_Surp: 0Hugepagesize: 2048 kB

内存合并技术

我们操作系统有一个内核级的进程会定期的去扫描内存,把连续的内存合并成一个2兆的大页内存,减少内存碎片。默认已经开启了

[root@linux-node1 ~]# cat /sys/kernel/mm/transparent_hugepage/enabled[always] madvise never

提示: 内存我们要做的不多,基本上系统已经我们优化好了。

IO优化

IO优化基本上我们要做的没有,因为默认kvm就使用virtio。Virtio是一种半虚拟化技术,让磁盘知道你是运行在虚拟机里面。这是一种半虚拟化技术,有兴趣可以了解一下

IO调度算法介绍

IO调度算法有三种(cenots6有四种)

Noop: 不进行任何调度算法(SSD一定要把这个设置为Noop,因为这个队列是针对磁盘的)

相关资料:

http://www.cnblogs.com/zhenjing/archive/2012/06/20/linux_writeback.html

http://jackyrong.iteye.com/blog/898938

查看当前调度算法

[root@linux-node1 ~]# cat /sys/block/sda/queue/schedulernoop [deadline] cfq

更改调度算法如下:

echo “noop” > /syc/block/sda/queue/scheduler

完!