用selenium爬取淘宝信息

需要的模块和组件

因为淘宝的Ajax比较复杂,所以这里使用Selenium来模拟浏览器的操作,抓取淘宝商品的信息,并将结果保存到MongoDB中。(我也不清楚为什么复杂,但是可以学一些新东西也可以把。)

Selenium是一个自动化测试工具,利用它可以驱动浏览器执行特定的动作,如点击、下拉等操作,同时还可以获取浏览器当前呈现的页面的源代码,做到可见即可爬。

要用到Chrome就需要用到ChromeDriver,这是一个浏览器驱动程序,用来启动Chrome等浏览器。

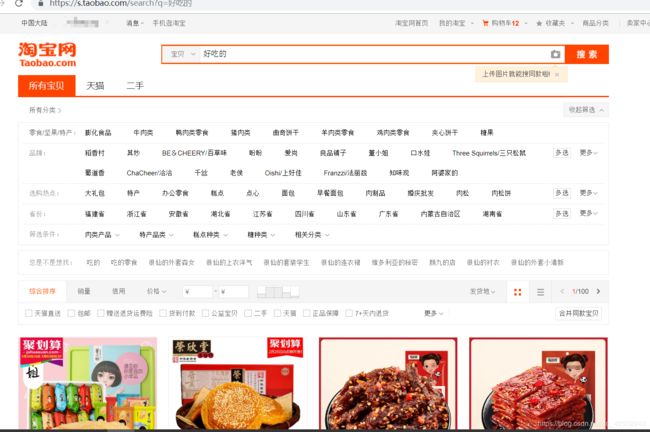

分析网站

可以看到我们输入链接https://s.taobao.com/search?q=好吃的,就可以进入指定的搜索地址。你直接搜东西在复制淘宝会隐藏,不会直观的显示出来,所以这样更美观一些。

然后就可以用Selenium进行抓取了,下面就是Selenium的一些用法。

from selenium import webdriver #导入浏览器驱动

from selenium.webdriver.common.by import By #这是一些方法,下面会细说

from selenium.webdriver.common.keys import Keys

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

browser = webdriver.Chrome() #使用 Chrome浏览器爬取

try:

browser.get('https://www.baidu.com') #给浏览器传入url

input = browser.find_element_by_id('kw') #找到百度的输入框

input.send_keys('Python') #传入keys值为python

input.send_keys(Keys.ENTER) #找到确认键

wait = WebDriverWait(browser, 10) #设置等待的时间

wait.until(EC.presence_of_element_located((By.ID, 'content_left'))) #等待确认已经进入了要进入的页面

print(browser.current_url) #输出输入python后的url

print('_______________________')

print(browser.get_cookies()) #输出cookies

print('_______________________')

print(browser.page_source) #输出整个原文html代码

finally:

browser.close() #最后关闭browser

上面测试了一下可用Selenium模拟搜索关键字并进行搜索。

做个笔记:

![]()

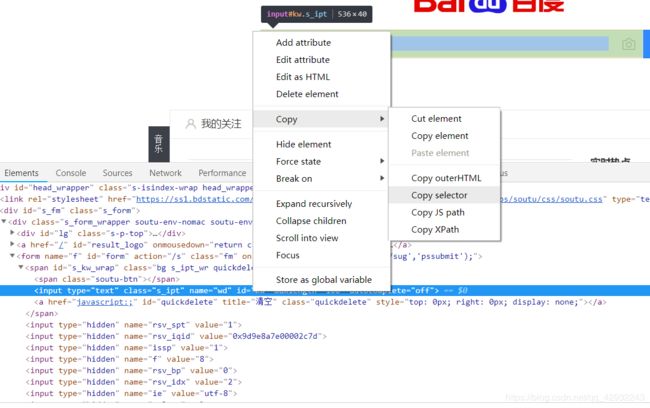

这句代码的意思是选择选择器。

检查,找到输入框,右键选择复制Copy selector,就将’kw’这个选择器选择出来,然后进行赋值,再选择确认键。下面的淘宝输入框也是一样的。

正式开始爬取

import pymongo

from selenium import webdriver

from selenium.common.exceptions import TimeoutException

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

from pyquery import PyQuery as pq

from config import *

from urllib.parse import quote

browser = webdriver.Chrome() #指定浏览器

wait = WebDriverWait(browser, 10) #等待时间

KEYWORD = '***' #指定想要搜索的关键字

def index_page(page): #爬取索引页的方法

"""

抓取索引页

:param page: 页码

"""

print('正在爬取第', page, '页')

try:

url = 'https://s.taobao.com/search?q=' + quote(KEYWORD) #url

browser.get(url) #浏览器获取url

if page > 1:

input = wait.until(

EC.presence_of_element_located((By.CSS_SELECTOR, '#mainsrp-pager > div > div > div > div.form > input'))) #获取输入页码的框

submit = wait.until(

EC.element_to_be_clickable((By.CSS_SELECTOR, '#J_SearchForm > button'))) #获取确认按键

input.clear() #清楚之前输入的数据

input.send_keys(page) #传入页码

submit.click() #确认

wait.until(

EC.text_to_be_present_in_element((By.CSS_SELECTOR, '#mainsrp-pager li.item.active > span'), str(page)))

wait.until(EC.presence_of_element_located((By.CSS_SELECTOR, '.m-itemlist .items .item')))

get_products() #跳转到解析商品信息函数

except TimeoutException: #如果错误重新加载

index_page(page)

因为这个页码非常多,为了防止爬取过程中出现异常退出,比如到50页退出了,此时点击“下一页”时,就无法快速切换到对应的后续页面了。此外,在爬取过程中,也需要记录当前的页码数,而且一旦点击“下一页”之后页面加载失败,还需要做异常检测,检测当前页面是加载到了第几页。整个流程相对比较复杂,所以这里我们直接用跳转的方式来爬取页面。

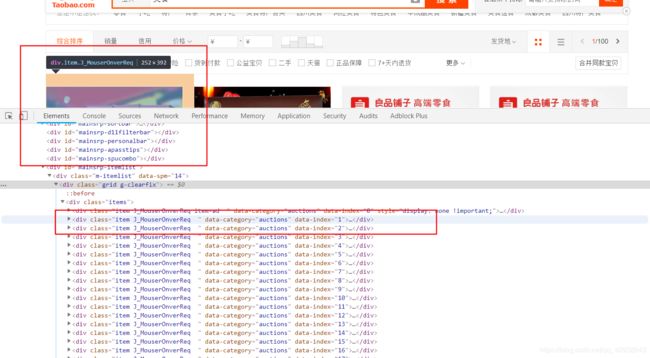

首先获取小的红框里面的输入页码框,再获取确认框。

解析函数

get_products():

"""

提取商品数据

"""

html = browser.page_source #获取源码

doc = pq(html) #使用pyquery对源码进行解析

items = doc('#mainsrp-itemlist .items .item').items() #获取class为items的所有内容

for item in items:

product = {

'image': item.find('.pic .img').attr('data-src'), #获取图片

'price': item.find('.price').text(), #获取金额

'deal': item.find('.deal-cnt').text(), #多少人付款

'title': item.find('.title').text(), #标题

'shop': item.find('.shop').text(), #店铺名

'location': item.find('.location').text() #所在地

}

print(product) #输出结果

save_to_mongo(product) #将结果传入mongo函数

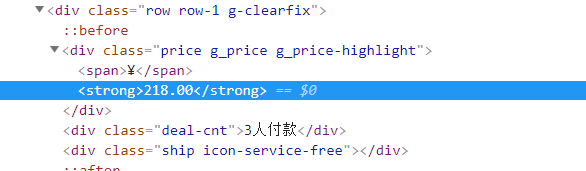

由上图可知,一份商品包裹再一个class的div中,所有商品包含在一个class为items的div中。

items = doc('#mainsrp-itemlist .items .item').items()

就是获取到了所有的商品源码。

上面两个图分别是图片和价格的位置,使用“.”搜索class就可以找到。

存储到MongoDB

MONGO_URL = 'localhost'

MONGO_DB = 'taobao'

MONGO_COLLECTION = 'products'

client = pymongo.MongoClient(MONGO_URL)

db = client[MONGO_DB]

def save_to_mongo(result):

"""

保存至MongoDB

:param result: 结果

"""

try:

if db[MONGO_COLLECTION].insert(result):

print('存储到MongoDB成功')

except Exception:

print('存储到MongoDB失败')

MongoDB是由C++语言编写的非关系型数据库,是一个基于分布式文件存储的开源数据库系统,其内容存储形式类似JSON对象,它的字段值可以包含其他文档、数组及文档数组,非常灵活。

详细的安装和操作可以去崔庆才博客查看。

多页查询

MAX_PAGE = 10 #定义爬取最大页数

def main():

"""

遍历每一页

"""

for i in range(1, MAX_PAGE + 1): #range包前不包后

index_page(i)

browser.close() #结束后关闭任务

if __name__ == '__main__': #启动

main()

完整代码

import pymongo

from selenium import webdriver

from selenium.common.exceptions import TimeoutException

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

from pyquery import PyQuery as pq

from config import *

from urllib.parse import quote

# browser = webdriver.Chrome()

# browser = webdriver.PhantomJS(service_args=SERVICE_ARGS) #浏览器设置为在后台运行的状态,全程不显示浏览器界面

chrome_options = webdriver.ChromeOptions()

chrome_options.add_argument('--headless')

# browser = webdriver.Chrome(chrome_options=chrome_options)

browser = webdriver.Chrome() # 设置Chrome为爬取的浏览器

wait = WebDriverWait(browser, 100) # 设定等待时间,100秒

MONGO_URL = 'localhost' # MONGO的url为本地主机

MONGO_DB = 'taobao' # 数据库名为taobao

MONGO_COLLECTION = 'products' # 数据库表名为products

client = pymongo.MongoClient(MONGO_URL) # 客户机的url为localhost

db = client[MONGO_DB] # 储存为名字为MONGO_DB的数据库

KEYWORD = '美食'

SERVICE_ARGS = ['--load-images=false', '--disk-cache=true']

def index_page(page):

"""

抓取索引页

:param page: 页码

"""

print('正在爬取第', page, '页')

try:

url = 'https://s.taobao.com/search?q=' + quote(KEYWORD) # url

browser.get(url) # 浏览器获取url

if page > 1:

input = wait.until(

EC.presence_of_element_located((By.CSS_SELECTOR, '#mainsrp-pager div.form > input'))) # 获取输入页码框

submit = wait.until(

EC.element_to_be_clickable((By.CSS_SELECTOR, '#mainsrp-pager div.form > span.btn.J_Submit'))) # 获取确认按键

input.clear()

input.send_keys(page)

submit.click()

wait.until(

EC.text_to_be_present_in_element((By.CSS_SELECTOR, '#mainsrp-pager li.item.active > span'), str(page)))

wait.until(EC.presence_of_element_located((By.CSS_SELECTOR, '.m-itemlist .items .item')))

get_products()

except TimeoutException:

index_page(page)

def get_products():

"""

提取商品数据

"""

html = browser.page_source

doc = pq(html)

items = doc('#mainsrp-itemlist .items .item').items()

for item in items:

product = {

'image': item.find('.pic .img').attr('data-src'),

'price': item.find('.price').text(),

'deal': item.find('.deal-cnt').text(),

'title': item.find('.title').text(),

'shop': item.find('.shop').text(),

'location': item.find('.location').text()

}

print(product)

save_to_mongo(product)

def save_to_mongo(result):

"""

保存至MongoDB

:param result: 结果

"""

try:

if db[MONGO_COLLECTION].insert(result):

print('存储到MongoDB成功')

except Exception:

print('存储到MongoDB失败')

MAX_PAGE = 10

def main():

"""

遍历每一页

"""

for i in range(1, MAX_PAGE + 1):

index_page(i)

browser.close()

if __name__ == '__main__':

main()

总结

以上就是爬取淘宝获取信息的所有步骤,经过这个项目,我学到了selenium再项目中的应用,也了解了MongoDB数据库的基础操作。