如何下载JetPack所使用的TensorRT

调试TensorRT,小伙伴坑人,在TX2上刷了JetPack,但是却没有安装TensorRT,所以我只能自己再下载一个,操作流程:

1)到JetPack官网下载最新的JetPack版本,网址:https://developer.nvidia.com/embedded/jetpack

2)下载下来是一个后缀为.run的文件, 在终端运行(可能需要修改权限,使用命名:chmod 777 JetPack-L4T-3.3-linux-x64_b39.run):

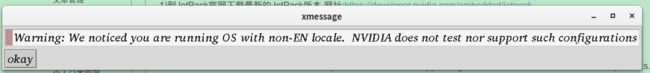

./JetPack-L4T-3.3-linux-x64_b39.run跳出这样一个对话框:

点击"okey";出现以下界面:

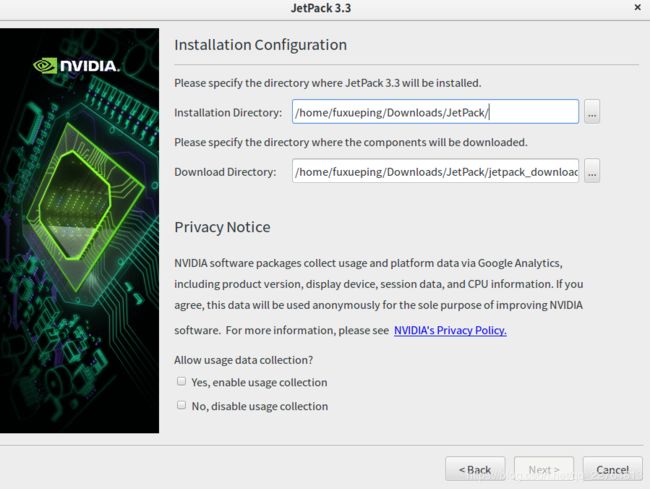

点击"next"; 出现以下界面:

选择下载路径(Download Directory): 同时点选:Yes,enable usage collection;然后点击next,出现以下界面:

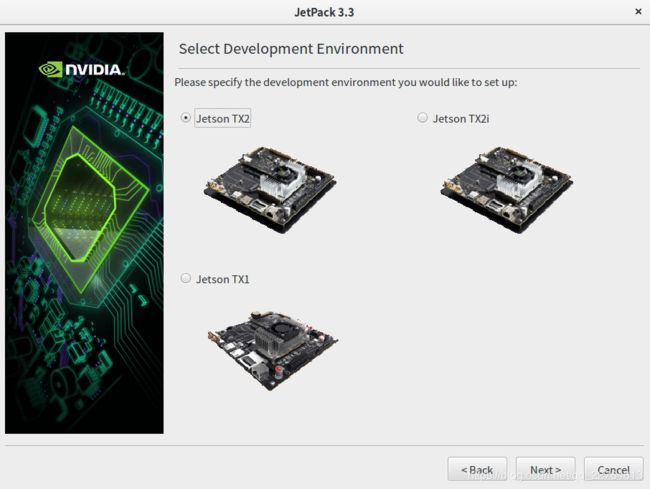

然后选择Jetson TX2,并点击next.则出现如下界面:

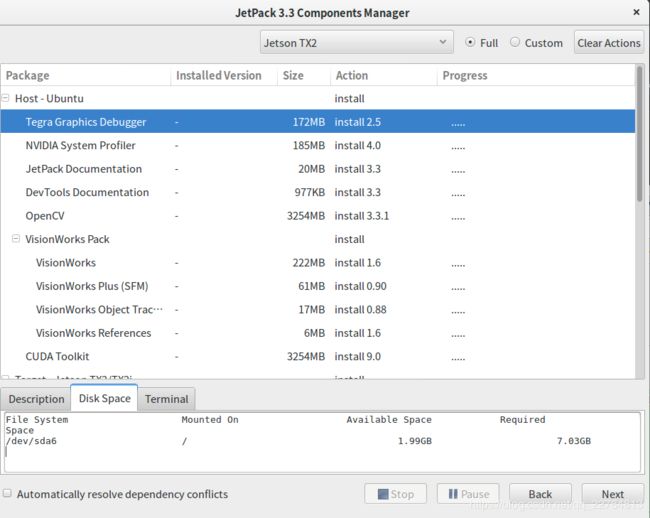

将右上角点选为"Custom",同时点击"Clear Actions",同时找到TensorRT,并对它进行点击:出现"no action"和"install 4.0",选择"install 4.0",出现如下界面:

选择"Keep & Apply",然后就继续点选next,由于TensorRT和cuda和cudnn是有关系的,所以同时会下载cuda和cudnn.

3)查看下载的内容,同时查看Tx2上的cuda版本和cudnn版本是否和下载的内容对应的上,如果没问题,下载出来的内容中找到如下文件夹:

libnvinfer4_4.1.3-1+cuda9.0_arm64.deb和libnvinfer-dev_4.1.3-1+cuda9.0_arm64.deb,对这两个压缩包进行解压,找到头文件和动态库文件就可以使用了:(注意将所有的so文件拷贝到同一个文件夹中,放到Tx2机器上,本人是在电脑上下载的文件);

到此结束;