Docker 搭建elasticsearch 7.6.x集群

Docker 搭建elasticsearch 7.6.x集群

文章目录

- 拉取镜像

- 设置Elasticsearch挂载目录

- 编写elasticsearch.yml配置文件

- node-1

- node-2

- node-3

- 创建镜像

- 验证是否搭建成功

- 问题

- max virtual memory areas vm.max_map_count [65530] is too low, increase to at least

- 参考

拉取镜像

docker pull elasticsearch:7.6.0

设置Elasticsearch挂载目录

#存放配置文件的文件夹

mkdir -p /home/elasticsearch/node-1/config

mkdir -p /home/elasticsearch/node-2/config

mkdir -p /home/elasticsearch/node-3/config

#存放数据的文件夹

mkdir -p /home/elasticsearch/node-1/data

mkdir -p /home/elasticsearch/node-2/data

mkdir -p /home/elasticsearch/node-3/data

#存放运行日志的文件夹

mkdir -p /home/elasticsearch/node-1/log

mkdir -p /home/elasticsearch/node-2/log

mkdir -p /home/elasticsearch/node-3/log

#存放IK分词插件的文件夹

mkdir -p /home/elasticsearch/node-1/plugins

mkdir -p /home/elasticsearch/node-2/plugins

mkdir -p /home/elasticsearch/node-3/plugins

chmod 777 /home/elasticsearch/node-1/data

chmod 777 /home/elasticsearch/node-2/data

chmod 777 /home/elasticsearch/node-3/data

chmod 777 /home/elasticsearch/node-1/plugins

chmod 777 /home/elasticsearch/node-2/plugins

chmod 777 /home/elasticsearch/node-3/plugins

chmod 777 /home/elasticsearch/node-1/log

chmod 777 /home/elasticsearch/node-2/log

chmod 777 /home/elasticsearch/node-3/log

chmod 777 /home/elasticsearch/node-1/config

chmod 777 /home/elasticsearch/node-3/config

chmod 777 /home/elasticsearch/node-2/config

生成目录结构

.

├── node-1

│ ├── config

│ │ └── elasticsearch.yml

│ ├── data

│ │ └── nodes

│ │ └── 0

│ │ ├── node.lock

│ │ └── _state

│ │ ├── manifest-3.st

│ │ ├── node-3.st

│ │ ├── _o.cfe

│ │ ├── _o.cfs

│ │ ├── _o.si

│ │ ├── segments_11

│ │ └── write.lock

│ ├── log

│ └── plugins

├── node-2

│ ├── config

│ │ └── elasticsearch.yml

│ ├── data

│ │ └── nodes

│ │ └── 0

│ │ ├── node.lock

│ │ └── _state

│ │ ├── manifest-4.st

│ │ ├── node-4.st

│ │ ├── _r.cfe

│ │ ├── _r.cfs

│ │ ├── _r.si

│ │ ├── segments_11

│ │ └── write.lock

│ ├── log

│ └── plugins

└── node-3

├── config

│ └── elasticsearch.yml

├── data

│ └── nodes

│ └── 0

│ ├── node.lock

│ └── _state

│ ├── manifest-1.st

│ ├── _n.cfe

│ ├── _n.cfs

│ ├── node-1.st

│ ├── _n.si

│ ├── segments_11

│ └── write.lock

├── log

└── plugins

编写elasticsearch.yml配置文件

node-1

#集群名称

cluster.name: my-es

#当前该节点的名称

node.name: node-1

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置其它结点和该结点交互的ip地址,如果不设置它会自动判断,值必须是个真实的ip地址,设置当前物理机地址,

#如果是docker安装节点的IP将会是配置的IP而不是docker网管ip

network.publish_host: 192.168.52.128

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["192.168.52.128:9300","192.168.52.128:9301","192.168.52.128:9302"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

node-2

#集群名称

cluster.name: my-es

#当前该节点的名称

node.name: node-2

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置其它结点和该结点交互的ip地址,如果不设置它会自动判断,值必须是个真实的ip地址,设置当前物理机地址,

#如果是docker安装节点的IP将会是配置的IP而不是docker网管ip

network.publish_host: 192.168.52.128

#设置映射端口

http.port: 9201

#内部节点之间沟通端口

transport.tcp.port: 9301

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["192.168.52.128:9300","192.168.52.128:9301","192.168.52.128:9302"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

node-3

#集群名称

cluster.name: my-es

#当前该节点的名称

node.name: node-3

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置其它结点和该结点交互的ip地址,如果不设置它会自动判断,值必须是个真实的ip地址,设置当前物理机地址,

#如果是docker安装节点的IP将会是配置的IP而不是docker网管ip

network.publish_host: 192.168.52.128

#设置映射端口

http.port: 9202

#内部节点之间沟通端口

transport.tcp.port: 9302

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["192.168.52.128:9300","192.168.52.128:9301","192.168.52.128:9302"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

创建镜像

docker run -e ES_JAVA_OPTS="-Xms512m -Xmx512m" -d -p 9200:9200 -p 9300:9300 -v /home/elasticsearch/node-1/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /home/elasticsearch/node-1/plugins:/usr/share/elasticsearch/plugins -v /home/elasticsearch/node-1/data:/usr/share/elasticsearch/data -v /home/elasticsearch/node-1/log:/usr/share/elasticsearch/log --name es-node-1 elasticsearch:7.6.0

docker run -e ES_JAVA_OPTS="-Xms512m -Xmx512m" -d -p 9201:9201 -p 9301:9301 -v /home/elasticsearch/node-2/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /home/elasticsearch/node-2/plugins:/usr/share/elasticsearch/plugins -v /home/elasticsearch/node-2/data:/usr/share/elasticsearch/data -v /home/elasticsearch/node-2/log:/usr/share/elasticsearch/log --name es-node-2 elasticsearch:7.6.0

docker run -e ES_JAVA_OPTS="-Xms512m -Xmx512m" -d -p 9202:9202 -p 9302:9302 -v /home/elasticsearch/node-3/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /home/elasticsearch/node-3/plugins:/usr/share/elasticsearch/plugins -v /home/elasticsearch/node-3/data:/usr/share/elasticsearch/data/ -v /home/elasticsearch/node-3/log:/usr/share/elasticsearch/log --name es-node-3 elasticsearch:7.6.0

验证是否搭建成功

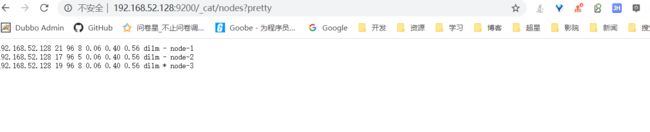

http://192.168.52.128:9200/_cat/nodes?pretty

问题

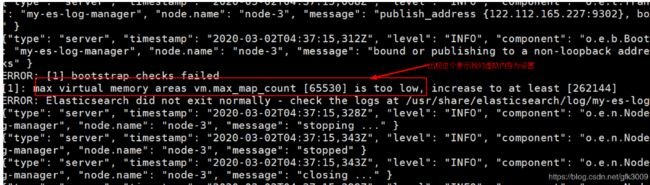

max virtual memory areas vm.max_map_count [65530] is too low, increase to at least

vim /etc/sysctl.conf

vm.max_map_count=655360

#保存退出,并刷新系统配置

sysctl -p /etc/sysctl.conf/

参考

elasticsearch搭建