Flink的时间类型和窗口概述,助你进阶Flink,畅游大数据时代

前言

Apache Flink是由Apache软件基金会开发的开源流处理框架,其核心是用Java和Scala编写的分布式流数据流引擎。Flink以数据并行和流水线方式执行任意流数据程序,Flink的流水线运行时系统可以执行批处理和流处理程序。而Flink中的时间类型和窗口是非常重要概念,也是学习Flink必须要掌握的两个知识点。今天我们就来探讨一下这两个知识点。

Flink中的时间类型

时间类型介绍

Flink流式处理中支持不同类型的时间。分为以下几种:

- 处理时间

- Flink程序执行对应操作的系统时间。所有基于时间的操作(例如:时间窗口)都将使用运行相应operator的系统时间。例如:每个小时的处理时间窗口包括在系统时间范围内所有operator接收到的记录。例如:如果应用程序在09:15开始运行,则第一个滚动时间窗口将包括:09:15 – 10:00 之间的处理事件,下一个窗口包括上午10:00 – 11:00之间的处理事件

- 这种处理时间方式实时性是最好的,但数据未必准确

- 事件时间

- 每个事件发生的时间。这个时间一般是在进入到Flink之前就包含在事件中

- 针对Eventtime,事件被处理的时间以来与事件本身

- Eventtime必须要指定如何生成Eventtime Watermark(水印)

- 理想情况,不管事件何时到达或者顺序如何,事件时间处理能够得到完整一致地结果。

- 事件处理在等待乱序事件时,会产生一些延迟。这样会对Eventtime的应用性能有一定的影响

- 摄入时间

- 摄入时间是事件进入Flink的时间

- 在source operator中,每个记录以时间戳的形式获取源的当前时间

- 它在概念是处于事件时间和处理时间中间

- 摄入时间不能处理乱序问题或者延迟数据,摄入时间可以由流式系统自动生成水印

Flink代码中设置时间类型

通常,我们在Flink初始化流式运行环境时,就会设置流处理时间特性。这个设置很重要,它决定了数据流的行为方式。(例如:是否需要给事件分配时间戳),以及窗口操作应该使用什么样的时间类型。例如:KeyedStream.timeWindow(Time.seconds(30))。

我们接下来通过实现一个每5秒中进行一次单词计数的案例,来说明Flink中如何指定时间类型。

public class WordCountWindow {

public static void main(String[] args) throws Exception {

// 1. 初始化流式运行环境

Configuration conf = new Configuration();

StreamExecutionEnvironment env = StreamExecutionEnvironment.createLocalEnvironmentWithWebUI(conf);

// 2. 设置时间处理类型,这里设置的方式处理时间

env.setStreamTimeCharacteristic(TimeCharacteristic.ProcessingTime);

// 3. 定义数据源,每秒发送一个hadoop单词

DataStreamSource wordDS = env.addSource(new RichSourceFunction() {

private boolean isCanaled = false;

@Override

public void run(SourceContext ctx) throws Exception {

while (!isCanaled) {

ctx.collect("hadooop");

Thread.sleep(1000);

}

}

@Override

public void cancel() {

isCanaled = true;

}

});

// 4. 每5秒进行一次,分组统计

// 4.1 转换为元组

wordDS.map(word -> Tuple2.of(word, 1))

// 指定返回类型

.returns(Types.TUPLE(Types.STRING, Types.INT))

// 按照单词进行分组

.keyBy(t -> t.f0)

// 滚动窗口,3秒计算一次

.timeWindow(Time.seconds(3))

.reduce(new ReduceFunction>() {

@Override

public Tuple2 reduce(Tuple2 value1, Tuple2 value2) throws Exception {

return Tuple2.of(value1.f0, value1.f1 + value2.f1);

}

}, new RichWindowFunction, Tuple2, String, TimeWindow>() {

@Override

public void apply(String word, TimeWindow window, Iterable> input, Collector> out) throws Exception {

// 打印窗口开始、结束时间

SimpleDateFormat sdf = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

System.out.println("窗口开始时间:" + sdf.format(window.getStart())

+ " 窗口结束时间:" + sdf.format(window.getEnd())

+ " 窗口计算时间:" + sdf.format(System.currentTimeMillis()));

int sum = 0;

Iterator> iterator = input.iterator();

while(iterator.hasNext()) {

Integer count = iterator.next().f1;

sum += count;

}

out.collect(Tuple2.of(word, sum));

}

}).print();

env.execute("app");

}

} 窗口开始时间:2020-02-05 00:22:21 窗口结束时间:2020-02-05 00:22:24 窗口计算时间:2020-02-05 00:22:24

4> (hadooop,2)

窗口开始时间:2020-02-05 00:22:24 窗口结束时间:2020-02-05 00:22:27 窗口计算时间:2020-02-05 00:22:27

4> (hadooop,3)

窗口开始时间:2020-02-05 00:22:27 窗口结束时间:2020-02-05 00:22:30 窗口计算时间:2020-02-05 00:22:30

4> (hadooop,3)

窗口开始时间:2020-02-05 00:22:30 窗口结束时间:2020-02-05 00:22:33 窗口计算时间:2020-02-05 00:22:33

4> (hadooop,3)

窗口开始时间:2020-02-05 00:22:33 窗口结束时间:2020-02-05 00:22:36 窗口计算时间:2020-02-05 00:22:36

4> (hadooop,3)

窗口开始时间:2020-02-05 00:22:36 窗口结束时间:2020-02-05 00:22:39 窗口计算时间:2020-02-05 00:22:39

我们可以看到,这个滚动窗口,每3秒计算一次,是按照系统时间来计算的。

我们再把时间窗口设置为1分钟,再试试。

窗口开始时间:2020-02-05 00:27:00 窗口结束时间:2020-02-05 00:28:00 窗口计算时间:2020-02-05 00:28:00

4> (hadooop,32)窗口开始时间:2020-02-05 00:28:00 窗口结束时间:2020-02-05 00:29:00 窗口计算时间:2020-02-05 00:29:00

4> (hadooop,60)

Flink窗口介绍及应用

Windows是Flink流计算的核心,本文将概括的介绍几种窗口的概念,重点只放在窗口的应用上。

一、窗口(window)的类型

对于窗口的操作主要分为两种,分别对于Keyedstream和Datastream。他们的主要区别也仅仅在于建立窗口的时候一个为.window(...),一个为.windowAll(...)。对于Keyedstream的窗口来说,他可以使得多任务并行计算,每一个logical key stream将会被独立的进行处理。

stream

.keyBy(...) <- keyed versus non-keyed windows

.window(...)/.windowAll(...) <- required: "assigner"

[.trigger(...)] <- optional: "trigger" (else default trigger)

[.evictor(...)] <- optional: "evictor" (else no evictor)

[.allowedLateness(...)] <- optional: "lateness" (else zero)

[.sideOutputLateData(...)] <- optional: "output tag" (else no side output for late data)

.reduce/aggregate/fold/apply() <- required: "function"

[.getSideOutput(...)] <- optional: "output tag"

按照窗口的Assigner来分,窗口可以分为

Tumbling window, sliding window,session window,global window,custom window

每种窗口又可分别基于processing time和event time,这样的话,窗口的类型严格来说就有很多。

还有一种window叫做count window,依据元素到达的数量进行分配,之后也会提到。

窗口的生命周期开始在第一个属于这个窗口的元素到达的时候,结束于第一个不属于这个窗口的元素到达的时候。

二、窗口的操作

2.1 Tumbling window

固定相同间隔分配窗口,每个窗口之间没有重叠看图一眼明白。

下面的例子定义了每隔3毫秒一个窗口的流:

WindowedStream Rates = rates

.keyBy(MovieRate::getUserId)

.window(TumblingEventTimeWindows.of(Time.milliseconds(3)));

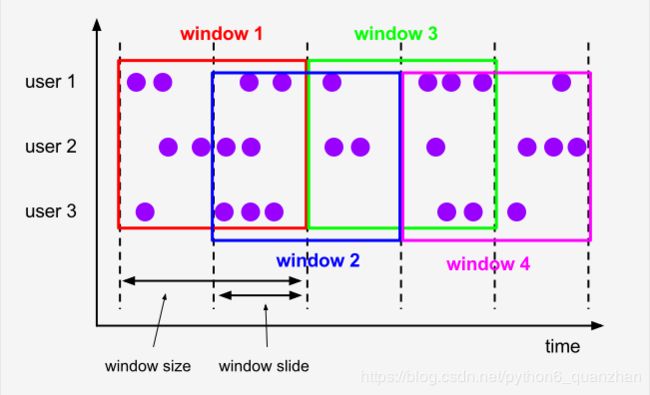

2.2 Sliding Windows

跟上面一样,固定相同间隔分配窗口,只不过每个窗口之间有重叠。窗口重叠的部分如果比窗口小,窗口将会有多个重叠,即一个元素可能被分配到多个窗口里去。

下面的例子给出窗口大小为10毫秒,重叠为5毫秒的流:

WindowedStream Rates = rates

.keyBy(MovieRate::getUserId)

.window(SlidingEventTimeWindows.of(Time.milliseconds(10), Time.milliseconds(5)));

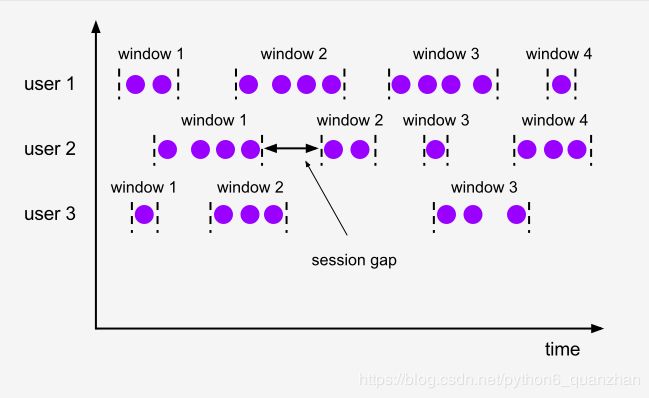

2.3 Session window

这种窗口主要是根据活动的事件进行窗口化,他们通常不重叠,也没有一个固定的开始和结束时间。一个session window关闭通常是由于一段时间没有收到元素。在这种用户交互事件流中,我们首先想到的是将事件聚合到会话窗口中(一段用户持续活跃的周期),由非活跃的间隙分隔开。

// 静态间隔时间

WindowedStream Rates = rates

.keyBy(MovieRate::getUserId)

.window(EventTimeSessionWindows.withGap(Time.milliseconds(10)));

// 动态时间

WindowedStream Rates = rates

.keyBy(MovieRate::getUserId)

.window(EventTimeSessionWindows.withDynamicGap(()));

2.4 Global window

将所有相同keyed的元素分配到一个窗口里。好吧,就这样:

WindowedStream Rates = rates

.keyBy(MovieRate::getUserId)

.window(GlobalWindows.create());

三、窗口函数

窗口函数就是这四个:ReduceFunction,AggregateFunction,FoldFunction,ProcessWindowFunction。前两个执行得更有效,因为Flink可以增量地聚合每个到达窗口的元素。

Flink必须在调用函数之前在内部缓冲窗口中的所有元素,所以使用ProcessWindowFunction进行操作效率不高。不过ProcessWindowFunction可以跟其他的窗口函数结合使用,其他函数接受增量信息,ProcessWindowFunction接受窗口的元数据。

举一个AggregateFunction的例子吧,下面代码为MovieRate按user分组,且分配5毫秒的Tumbling窗口,返回每个user在窗口内评分的所有分数的平均值。

DataStream> Rates = rates

.keyBy(MovieRate::getUserId)

.window(TumblingEventTimeWindows.of(Time.milliseconds(5)))

.aggregate(new AggregateFunction>() {

@Override

public AverageAccumulator createAccumulator() {

return new AverageAccumulator();

}

@Override

public AverageAccumulator add(MovieRate movieRate, AverageAccumulator acc) {

acc.userId = movieRate.userId;

acc.sum += movieRate.rate;

acc.count++;

return acc;

}

@Override

public Tuple2 getResult(AverageAccumulator acc) {

return Tuple2.of(acc.userId, acc.sum/(double)acc.count);

}

@Override

public AverageAccumulator merge(AverageAccumulator acc0, AverageAccumulator acc1) {

acc0.count += acc1.count;

acc0.sum += acc1.sum;

return acc0;

}

});

public static class AverageAccumulator{

int userId;

int count;

double sum;

}

以下是部分输出:

...

1> (44,3.0)

4> (96,0.5)

2> (51,0.5)

3> (90,2.75)

...

看上面的代码,会发现add()函数特别生硬,因为我们想返回Tuple2

DataStream> Rates = rates

.keyBy(MovieRate::getUserId)

.window(TumblingEventTimeWindows.of(Time.milliseconds(5)))

.aggregate(new MyAggregateFunction(), new MyProcessWindowFunction());

public static class MyAggregateFunction implements AggregateFunction {

@Override

public AverageAccumulator createAccumulator() {

return new AverageAccumulator();

}

@Override

public AverageAccumulator add(MovieRate movieRate, AverageAccumulator acc) {

acc.sum += movieRate.rate;

acc.count++;

return acc;

}

@Override

public Double getResult(AverageAccumulator acc) {

return acc.sum/(double)acc.count;

}

@Override

public AverageAccumulator merge(AverageAccumulator acc0, AverageAccumulator acc1) {

acc0.count += acc1.count;

acc0.sum += acc1.sum;

return acc0;

}

}

public static class MyProcessWindowFunction extends

ProcessWindowFunction, Integer, TimeWindow> {

@Override

public void process(Integer key,

Context context,

Iterable results,

Collector> out) throws Exception {

Double result = results.iterator().next();

out.collect(new Tuple2<>(key, result));

}

}

public static class AverageAccumulator{

int count;

double sum;

}

可以得到,结果与上面一样,但代码好看了很多。

四、其他操作

4.1 Triggers(触发器)

触发器定义了窗口何时准备好被窗口处理。每个窗口分配器默认都有一个触发器,如果默认的触发器不符合你的要求,就可以使用trigger(...)自定义触发器。

通常来说,默认的触发器适用于多种场景。例如,多有的event-time窗口分配器都有一个EventTimeTrigger作为默认触发器。该触发器在watermark通过窗口末尾时出发。

PS:GlobalWindow默认的触发器时NeverTrigger,该触发器从不出发,所以在使用GlobalWindow时必须自定义触发器。

4.2 Evictors(驱逐器)

Evictors可以在触发器触发之后以及窗口函数被应用之前和/或之后可选择的移除元素。使用Evictor可以防止预聚合,因为窗口的所有元素都必须在应用计算逻辑之前先传给Evictor进行处理

4.3 Allowed Lateness

当使用event-time窗口时,元素可能会晚到,例如Flink用于跟踪event-time进度的watermark已经超过了窗口的结束时间戳。

默认来说,当watermark超过窗口的末尾时,晚到的元素会被丢弃。但是flink也允许为窗口operator指定最大的allowed lateness,以至于可以容忍在彻底删除元素之前依然接收晚到的元素,其默认值是0。

为了支持该功能,Flink会保持窗口的状态,知道allowed lateness到期。一旦到期,flink会删除窗口并删除其状态。

把晚到的元素当作side output。

SingleOutputStreamOperator result = input

.keyBy()

.window()

.allowedLateness(