Python 爬取诗词分析古人最喜欢用的诗词

"知之为知之,不知为不知,是知也~",最近突然迷恋古诗词,体验下文人雅士,迁客骚人的生活,并跟随杜牧,李白感受下千百年前社会(给自己点赞~),不过突然我在想,这么多古诗,这么多作者,他们在写古诗的时候最喜欢的词语是啥子?来来来,让我们安排下~嘎嘎嘎~

1. 5分钟快速了解爬虫

爬虫(spider:网络蜘蛛):是一个用脚本代替浏览器请求服务器获取服务器资源的程序(简单不?)

当然,各位看官,肯定知道咱们的python爬虫能做什么吧,我就在这里简单的总结下子.

数据收集(数据分析、人工智能)

模拟操作(测试、数据采集)

接口操作(自动化)

爬虫的原理:说到底,我们的爬虫是模拟web请求,不论学习什么框架我们都需要对http协议的请求和响应有所了解,看下图:

用户去发送请求,给服务器,服务器这个碧池一看有用户请求我,我就回应,把自己的响应的数据发送给用户,并不要脸的把响应体发送给了用户,这里咱们做python爬虫的主要是想要拿到响应体,去蹂躏~嘎嘎嘎~

2. beautifulsoup 匹配原则

什么是beautiful Soup?

简单来说:Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据。

官方解释:Beautiful Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。

这里我不得不提醒下大家,我们爬虫常用的匹配有 re,xpath,bs。bs ,相比着前两种来说有点慢,嘿嘿~它的优点也有很多了,文档自动纠错啦,等等,大家不用怕,看工作需求~

2.1 bs的安装

环境介绍: pycharm 2018.2.3 + python 3.7.2 +windows

bs的安装 : pip install bs4

首先必须要导入 bs4 库, 创建BeautifulSoup对象

from bs4 import BeautifulSoup as BS

text = '''

Test

Hello World

风一般的男人

'''

soup = BS(text,"lxml")#前面是要解析的内容,后面是指定的解析器

print(soup.prettify())#转换字符串

print(type(soup.prettify()))

print(type(soup))2.2 搜索文档树

说到bs了,咱们在这里就不得不提搜索文档树了,我们做爬虫主要做什么?无非就是提取数据啦,所以我们的bs肯定的有相对应的方法快速搜索咱们的响应体滴,从上往下,从头到脚,一个地方都不放过~(也可以具体选择某个地方),列德森and乡亲们来来,请出咱们的主角,find()和find_all()(自带bgm,啾~啾~啾~啾~~)

find() 和 find_all()

find_all() : 搜索当前tag的所有tag子节点,并判断是否符合过滤器的条件。

find() 和 find_all() 的区别: find直接返回元素的一个结果,find_all返回元素列表

find_all( name , attrs , recursive , text , **kwargs )

简单介绍参数:

name 参数可以查找所有名字为name的tag,字符串对象会被自动忽略掉;

name参数可以传入字符串、正则表达式、列表、True、自定义的方法等,但是各自代表的含义不一样。

字符串,在搜索方法中传入一个字符串参数,Beautiful Soup会查找与字符串完整匹配的内容。

光说不练假把式,咱们废话不BB看下下面的具体代码段

1. 通过tag标签名:

print(soup.find('body'))

print(soup.find_all('body')

如果匹配成功将会匹配所有的tag

2. 通过具体的属性名

如果一个指定名字的参数不是搜索内置的一些参数名,搜索时会把该参数当作指定名字tag的属性来搜索;

例如:id=1

如果包含一个名字为 id 的参数,Beautiful Soup会搜索每个tag的”id”属性;

如果传入 href 参数,Beautiful Soup会搜索每个tag的”href”属性;

使用多个指定名字的参数可以同时过滤tag的多个属性;

但是对于class ,可以使用class_来搜索

#返回这个class_=‘p’的标签内容。

print(soup.find_all('p',class_='p'))

对于某些tag属性不能通过搜索得到值,可以使用attrs参数得到

#返回class为e的标签

print(soup.find_all(attrs={'class':'e'}))

ps: bs 知识点我们略微的尝尝,当前所学的就够咱们今天用到滴,如果大家想深入美丽汤,可以去官方网站上呦~

博主到这个地方,冥思苦想,要想把湿人的词语,展示给小伙伴,到底用什么方法呢?matplotlib?echart? nonono~,我灵光一闪就它-wordcloud了,来来来,各位看官请移步到wordcloud简单讲解

3. wordcloud 使用详情

wordcloud 简单利用英语来看就是词云,它是以词语为基本单位,更加直观的展示出我们的内容。

ps:既然是以词语为单位,肯定先事先准备些小词,还好博主平时看书比较多,肉铺,蜜桃……(杠杠滴)

wordcloud 的安装:pip install wordcloud

大家顺便安装下:pip install jieba

1、基本格式

#导入词云

from wordcloud import WordCloud

#打开文件并且读取完全

f = open('1.txt','r').read()

#创建wc设个实例对象,里面可传递相应的参数

#generate根据文本生成词云

wc = WordCloud(

background_color='white',

width=500,

height=366,

margin=2

).generate(f)

#to_file 输出到文件

wc.to_file('./image/0.jpg')

运行结果展示:

以上代码还有个小小的坑,看看大家能不能排除下,抖个小小的机灵~嘻嘻~

好了,上边说了这么多,下面终于进入主题了,我要放大给大家看看实战:爬取中国唐诗宋词,体验文人雅士最常用的词语,小小的实战送给各位亲~

首先,咳咳~允许我把大致的流程来列出来,我要一步步往上爬,在最高点……

第一步 : 下载中国的唐诗宋词

第二步:把数据保存到本地

第三步:结巴分词

第四步:生成词云简单分析

下载唐诗宋词保存本地

import re

import requests

from bs4 import BeautifulSoup

from concurrent.futures import ThreadPoolExecutor, wait, ALL_COMPLETED

#这是url地址

urls = ['https://so.gushiwen.org/gushi/tangshi.aspx',

'https://so.gushiwen.org/gushi/sanbai.aspx',

'https://so.gushiwen.org/gushi/songsan.aspx',

'https://so.gushiwen.org/gushi/songci.aspx'

]

#处理获取每个诗词的url地址

poem_links = []

for url in urls:

# 请求头部

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.80 Safari/537.36'}

req = requests.get(url, headers=headers)

#把爬取到的文本格式改成bs4可改变的格式

soup = BeautifulSoup(req.text, "lxml")

#定位到第一个class = sone的内容

content = soup.find_all('div', class_="sons")[0]

#获取该content 下所有a标签

links = content.find_all('a')

print(links)

#进行比遍历,url地址拼接

for link in links:

poem_links.append('https://so.gushiwen.org'+link['href'])

poem_list = []

def get_poem(url):

# 请求头部

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.87 Safari/537.36'}

req = requests.get(url, headers=headers)

soup = BeautifulSoup(req.text, "lxml")

poem = soup.find('div', class_='contson').text.strip()

poem = poem.replace(' ', '')

poem = re.sub(re.compile(r"\([\s\S]*?\)"), '', poem)

poem = re.sub(re.compile(r"([\s\S]*?)"), '', poem)

poem = re.sub(re.compile(r"。\([\s\S]*?)"), '', poem)

poem = poem.replace('!', '!').replace('?', '?')

poem_list.append(poem)

# 利用并发爬取

executor = ThreadPoolExecutor(max_workers=10) # 可以自己调整max_workers,即线程的个数

# submit()的参数: 第一个为函数, 之后为该函数的传入参数,允许有多个

future_tasks = [executor.submit(get_poem, url) for url in poem_links]

# 等待所有的线程完成,才进入后续的执行

wait(future_tasks, return_when=ALL_COMPLETED)

# 将爬取的诗句写入txt文件

poems = list(set(poem_list))

poems = sorted(poems, key=lambda x:len(x))

print(poems)

for poem in poems:

poem = poem.replace('《','').replace('》','').replace(':', '').replace('“', '')

print(poem)

with open('poem.txt', 'a') as f:

f.write(poem)

f.write('\n')生成词云进行分析:

import jieba

from wordcloud import WordCloud,STOPWORDS

wc = WordCloud(background_color='white', # 背景颜色

max_words=1000, # 最大词数

# mask=back_color, # 以该参数值作图绘制词云,这个参数不为空时,width和height会被忽略

max_font_size=100, # 显示字体的最大值

stopwords=STOPWORDS.add('国'), # 使用内置的屏蔽词,再添加'苟利国'

# font_path="C:/Windows/Fonts/STFANGSO.ttf", # 解决显示口字型乱码问题,可进入C:/Windows/Fonts/目录更换字体

font_path='C:\Windows\Fonts\simfang.ttf',

random_state=42, # 为每个词返回一个PIL颜色

# width=1000, # 图片的宽

# height=860 #图片的长

)

text = open('poem.txt').read()

# 该函数的作用就是把屏蔽词去掉,使用这个函数就不用在WordCloud参数中添加stopwords参数了

# 把你需要屏蔽的词全部放入一个stopwords文本文件里即可

def stop_words(texts):

words_list = []

word_generator = jieba.cut(texts, cut_all=False) # 返回的是一个迭代器

for word in word_generator:

words_list.append(word)

print(words_list)

return ' '.join(words_list) # 注意是空格

text = stop_words(text)

wc.generate(text)

# 显示图片

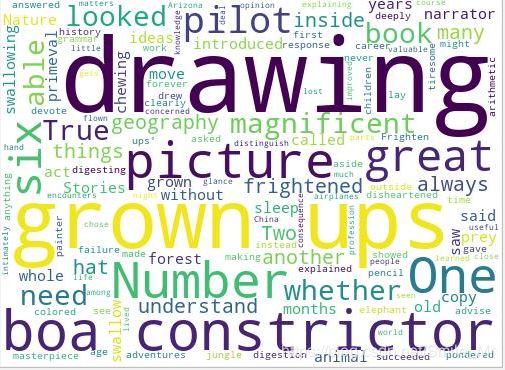

wc.to_file('maikou.png')最终结果如下:

啧啧啧~这样看来,古人喜欢用 的无非就几个:何处,君王,清晨,古寺,人心,

是不是我也可以来一首诗,展示下我的渊博的学识,嘎嘎嘎~

人心不知何处去,君王真想不早朝。

清晨起床一脸懵,真想古寺得禅道。

完美,溜了溜了~