语义分割论文:Group-wise Deep Object Co-Segmentation with Co-AttentionRecurrent Neural Network(ICCV2019)

协同分割论文阅读:Group-wise Deep Object Co-Segmentation with Co-AttentionRecurrent Neural Network(ICCV2019)

http://openaccess.thecvf.com/content_ICCV_2019/html/Li_Group-Wise_Deep_Object_Co-Segmentation_With_Co-Attention_Recurrent_Neural_Network_ICCV_2019_paper.ht

目录

1.贡献点

2.总体框架

3.实现细节

4.Loss函数

5.训练细节

1.贡献点

提出一种利用协同注意力和循环网络结构实现协同分割的方法。

(1)引入递归网络结构进行协同分割,实现一组(而非一对)图像的协同分割。

(2)提出协同注意力递归单元(CARU),处理图像中协同注意对象在外观和位置上的变化。

(3)提出了一个group-wise训练目标,利用协同对象相似性和图形-背景差异作为额外的监督。

2.总体框架

(1)我们的网络首先提取所有图像的语义特征;

(2)然后由两个分支处理特征。单个图像表示分支对每个图像分别进行处理,以学习其独特的属性。同时使用一个设计好的协同注意力循环单元(CARU))对所有图像利用图像间的协同注意来生成这组图片的group feature。

(3)同时,group-wise表示分支可以通过引入递归结构,逐步学习组内的所有图像,从而学习一种鲁棒的group-wis表示。

(4)将group-wise特征广播到每一张单独的图像上,并与其特征融合,使得网络能够充分利用组和单个表示之间的互补性和相互作用,从而促进最终的协同分割。

图中,SIR:the single image representation branch单一图像表示分支

CARU:the Co-Attention Recurrent Unit 协同注意递归单元

MFF:Multi-scale Features Fusion module 多尺度特征融合模块

输入任意大小的一组图片,CNN模块提取所有图片信息,之后SIR分支提取每张图像的独有特征,CARU模块递归探索协同信息,两分支经MFF模块融合用以获取最终的协同分割掩码。

3.实现细节

SIR,单一图像表示分支

使用预训练的CNN(VGG19)提取池化特征作为其语义特征![]() ,然后用3个conv提取特征得到

,然后用3个conv提取特征得到![]() ,公式如下:

,公式如下:

- CARU,协同注意递归单元,结构图

![]() 指group representation,总体表示:

指group representation,总体表示:

分析其具体实现

输入Xn和上一步得到的![]() (

(![]() 为

为![]() ),D用于消除当前图片噪声(多张图背景相关或非公共物体),Z决定对

),D用于消除当前图片噪声(多张图背景相关或非公共物体),Z决定对![]() 的更新

的更新

![]()

去噪后得到特征图:

![]() 输入

输入![]() 以识别

以识别![]() 和

和![]() 的差异并对

的差异并对![]() 进行更新

进行更新

![]()

下图为更新门![]() 具体结构:

具体结构:

channel注意力模块,全局空间平均池化获取每个channel的整体响应,后接全连接层,生成通道注意力特征图![]()

![]() 为

为![]() 全局空间平均池化后得到。

全局空间平均池化后得到。

spatial注意力模块,全局空间平均池化获取每个空间位置的整体响应,后接2全连接层以生成空间注意力特征图![]()

![]()

![]() 为

为![]() 全局通道平均池化后得到。

全局通道平均池化后得到。

最后更新![]()

![]()

![]()

Z 中每个值代表对应位置![]() 被保留和

被保留和![]() 被更新的概率。

被更新的概率。

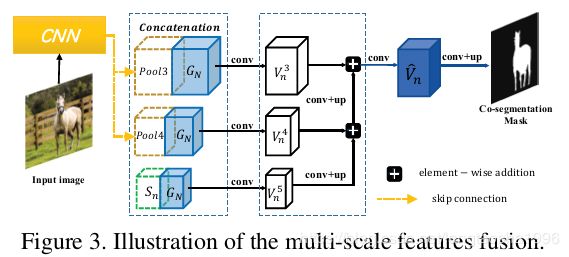

多尺度特征融合

将group-wise特征广播到每一张单独的图像上,并与其特征融合。利用骨干网中的低层特征(Pool3、Pool4)作为补充,融合多层视觉特征,为物体的协同分割提供全面表现。

4.Loss函数

交叉熵loss进行监督

考虑到共现物体间再不同图片的高相似度以及共现目标与图片中其他区域的差异度,作者提出一种group-wise训练方法,以进一步探讨训练组中整幅图像的交互关系,提高分割精度,使用triplet loss作为分组训练的loss约束。

对于单张图片,可得到三种掩码:

![]()

其中![]() ,

,![]() 是

是![]() 当前检测到的协同分割objects,

当前检测到的协同分割objects,![]() 和

和![]() 是实际协同分割objects和非公共分割区域,之后对3种掩码图用检测器

是实际协同分割objects和非公共分割区域,之后对3种掩码图用检测器![]() 作用

作用

![]()

triplet loss监督,E为欧几里得距离,利用Hinge Loss (折页损失函数、铰链损失函数)思想:

也可以用softplus函数的平滑近似代替铰链函数。

最后loss为:

5.训练细节

在group-wise约束中,使用VGG中的Relu3_1,Relu4_1,Relu5_1作为特征向量计算欧几里得距离。

为避免陷入局部最优,前100代训练只用交叉熵loss,之后的训练激活triplet loss进行训练。

考虑到训练数据较少,利用COCO数据集作为训练数据。

评价指标:Precision(P)和Jaccard index(J)。