CS231-

CS231-SVM

- Pretraining

- Loss Function

- 多分类SVM Loss

- 正则化

Pretraining

1.mean-substraction:将所有特征值减去特征均值,使所有像素值处于[-127,127]之间

2.标准化:使所有像素值处于[-1,1]之间

Loss Function

多分类SVM Loss

SVM希望每幅图片的correct class得分通过一个margin的修饰都比incorrect class得分高

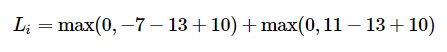

例:对第i个实例,设其image图片为Xi,label为yi。score function 用所有像素计算向量f(xi,W),然后得到得分s,而第j类的得分sj=f(xi,W)j 而计算多分类SVM中第i个实例的loss是:

比如,s=[13,-7,11],correct class yi=0,delt=10,则

前一项有max(0,-),也就是说correct分类得分明显过于incorrect分类得分。而第二项有max(0,8),即使correct class得分为13,incorrect class得分为11,对于间隔为10来说,这样的结果并不好。loss有8.

对linear score function:

![]()

则loss function:

形象解释:

正则化

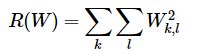

避免某些参数因权重大而产生的过大影响。因此在loss中加一项regularization penalty R(W)。最常见的是L2范式:

所以最后的Loss函数由两部分组成:

展开为: