在本文中,基于Daphne Koller完成课程。

PDM(ProbabilisticGraphiccal Models)

称为概率图模型。

以下分别说明3个词相应的意义。

概率

-给出了不确定性的明白量度。

-给出了依据不确定性进行判断的有力工具。

-利用数据结构,建立了进行学习的方法,解决十分大规模的问题。

图

这里主要用到2种概率图,用于表示依赖关系。如图1所看到的。

![]()

图1

1.Bayesiannetworks

贝叶斯网络是一个有向无环图(Directed Acyclic Graph,DAG)。

由代表变量节点及连接这些节点有向边构成。

节点代表随机变量。节点间的有向边代表了节点间的互相关系(由父节点指向其子节点),用条件概率进行表达关系强度,没有父节点的用先验概率进行信息表达。

2.Markovnetworks

马尔可夫网络是一个无向图。

一方面它能够表示贝叶斯网络无法表示的一些依赖关系,如循环依赖;

还有一方面。它不能表示贝叶斯网络可以表示的某些关系,如推导关系。

图形表示的长处

1.直观而紧凑的数据结构。

2.利用图形结构,提供了一套使用通用算法进行高效判断的方式。

3.能够用非常少的參数表示高维的概率分布。

參数的选择能够用手工也能够从数据中学习。

模型

模型是客观世界的陈述性描写叙述。

举2个简单应用样例

1.医疗诊断(如图2所看到的)

医生面对病人时脑子里有大量的信息,这些信息都是关于怎样诊断病人的指标(如发病诱因、症状、体检结果等等),医生如今须要决定究竟应当怎样施治。

图2就是一个真实的诊断网络。

图2

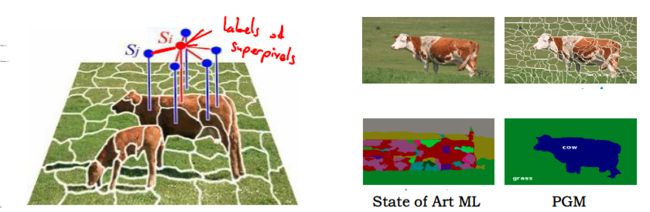

2.图像切割(如图3所看到的)

一副图片有成千上万个像素点或者超像素(大块的那种),须要弄清每一个像素相应的内容(这些点相应的是草、天空、牛还是?)。

图中的点是随机变量,代表了像素(或者超像素)的标签,而边则代表了标签与邻近标签之间的概率关系。能够看出State of Art 的机器学习算法识别得一团糟,可是运用了PGM之后好太多了。

图3

这两个问题有什么共同点呢?

1.都包括了大量须要被判断的变量。

2.基本上。不论算法多么智能。是否能得到正确答案,都是很不确定的。

PGM的提出就是为了解决上述问题的框架。

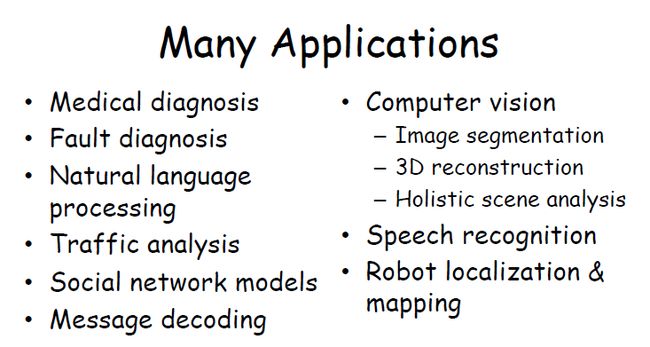

有很广泛的应用如图4。

图4

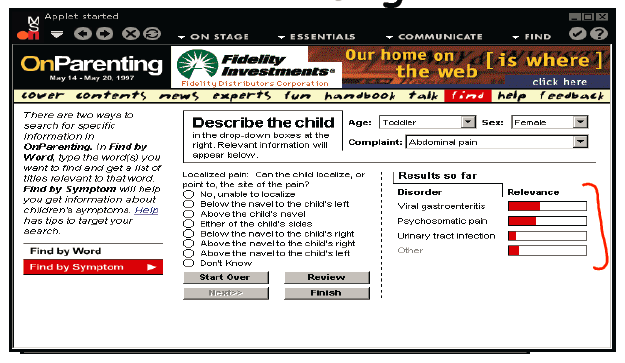

家用的诊断系统

孩子生了病,家长在站点上描写叙述病状,系统对家长提出问题。家长在回答了系统的问题之后,系统会给出孩子最有可能得的疾病。如图5所看到的。

图5

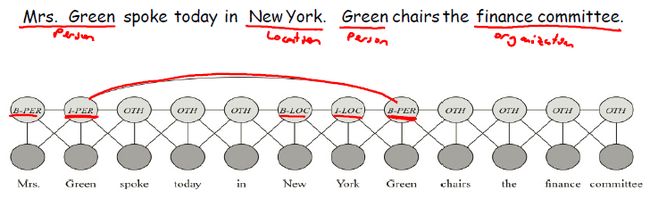

文本信息提取

将非结构型结构转成为文本中各种关键点(如人、地点、组织)之间的可能关系的表示。

如图6所看到的。

Mrs. Green这是两个词。可是要求一起识别;Green是一个词可是要识别出来它代表的是一个人,以及地点、组织等的都要通过相互之间的概率关系识别出来。如图6所看到的。

图6

总结

PGM是要做3件基本的事情:

1.表达

使用无向图和有向图进行表达。

使用动态和静态模型进行表达。

2.判断

精确判断和模糊判断(寻求计算效率和计算精度的妥协)

在不确定性状态下进行决策。

3.学习

自己主动学习參数和结构

有全然数据情形和非全然数据情形。

欢迎參与讨论并关注本博客和微博以及知乎个人主页,兴许内容继续更新哦~

转载请您尊重作者的劳动,完整保留上述文字以及本文链接,感谢您的支持。

版权声明:本文博主原创文章,博客,未经同意不得转载。