Scrapy 是用Python实现一个为爬取网站数据、提取结构性数据而编写的应用框架。

一、Scrapy框架简介

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。 可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中。

其最初是为了 页面抓取 (更确切来说, 网络抓取 )所设计的, 也可以应用在获取API所返回的数据(例如 Amazon Associates Web Services ) 或者通用的网络爬虫。

二、架构流程图

接下来的图表展现了Scrapy的架构,包括组件及在系统中发生的数据流的概览(绿色箭头所示)。 下面对每个组件都做了简单介绍,并给出了详细内容的链接。数据流如下所描述。

1、组件

Scrapy Engine

引擎负责控制数据流在系统中所有组件中流动,并在相应动作发生时触发事件。 详细内容查看下面的数据流(Data Flow)部分。

调度器(Scheduler)

调度器从引擎接受request并将他们入队,以便之后引擎请求他们时提供给引擎。

下载器(Downloader)

下载器负责获取页面数据并提供给引擎,而后提供给spider。

Spiders

Spider是Scrapy用户编写用于分析response并提取item(即获取到的item)或额外跟进的URL的类。 每个spider负责处理一个特定(或一些)网站。 更多内容请看 Spiders 。

Item Pipeline

Item Pipeline负责处理被spider提取出来的item。典型的处理有清理、 验证及持久化(例如存取到数据库中)。 更多内容查看 Item Pipeline 。

下载器中间件(Downloader middlewares)

下载器中间件是在引擎及下载器之间的特定钩子(specific hook),处理Downloader传递给引擎的response。 其提供了一个简便的机制,通过插入自定义代码来扩展Scrapy功能。更多内容请看 下载器中间件(Downloader Middleware) 。

Spider中间件(Spider middlewares)

Spider中间件是在引擎及Spider之间的特定钩子(specific hook),处理spider的输入(response)和输出(items及requests)。 其提供了一个简便的机制,通过插入自定义代码来扩展Scrapy功能。更多内容请看 Spider中间件(Middleware) 。

2、数据流(Data flow)

Scrapy中的数据流由执行引擎控制,其过程如下:

- 引擎打开一个网站(open a domain),找到处理该网站的Spider并向该spider请求第一个要爬取的URL(s)。

- 引擎从Spider中获取到第一个要爬取的URL并在调度器(Scheduler)以Request调度。

- 引擎向调度器请求下一个要爬取的URL。

- 调度器返回下一个要爬取的URL给引擎,引擎将URL通过下载中间件(请求(request)方向)转发给下载器(Downloader)。

- 一旦页面下载完毕,下载器生成一个该页面的Response,并将其通过下载中间件(返回(response)方向)发送给引擎。

- 引擎从下载器中接收到Response并通过Spider中间件(输入方向)发送给Spider处理。

- Spider处理Response并返回爬取到的Item及(跟进的)新的Request给引擎。

- 引擎将(Spider返回的)爬取到的Item给Item Pipeline,将(Spider返回的)Request给调度器。

- (从第二步)重复直到调度器中没有更多地request,引擎关闭该网站。

3、事件驱动网络(Event-driven networking)

Scrapy基于事件驱动网络框架 Twisted 编写。因此,Scrapy基于并发性考虑由非阻塞(即异步)的实现。

关于异步编程及Twisted更多的内容请查看下列链接:

三、4步制作爬虫

- 新建项目(scrapy startproject xxx):新建一个新的爬虫项目

- 明确目标(编写items.py):明确你想要抓取的目标

- 制作爬虫(spiders/xxsp der.py):制作爬虫开始爬取网页

- 存储内容(pipelines.py):设计管道存储爬取内容

四、安装框架

这里我们使用 conda 来进行安装:

conda install scrapy或者使用 pip 进行安装:

pip install scrapy查看安装:

➜ spider scrapy -h

Scrapy 1.4.0 - no active project

Usage:

scrapy [options] [args]

Available commands:

bench Run quick benchmark test

fetch Fetch a URL using the Scrapy downloader

genspider Generate new spider using pre-defined templates

runspider Run a self-contained spider (without creating a project)

settings Get settings values

shell Interactive scraping console

startproject Create new project

version Print Scrapy version

view Open URL in browser, as seen by Scrapy

[ more ] More commands available when run from project directory

Use "scrapy -h" to see more info about a command 1.创建项目

➜ spider scrapy startproject SF

New Scrapy project 'SF', using template directory '/Users/kaiyiwang/anaconda2/lib/python2.7/site-packages/scrapy/templates/project', created in:

/Users/kaiyiwang/Code/python/spider/SF

You can start your first spider with:

cd SF

scrapy genspider example example.com

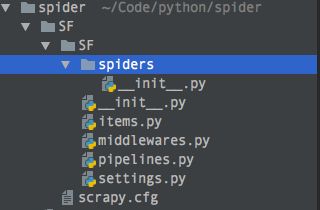

➜ spider使用 tree 命令可以查看项目结构:

➜ SF tree

.

├── SF

│ ├── __init__.py

│ ├── items.py

│ ├── middlewares.py

│ ├── pipelines.py

│ ├── settings.py

│ └── spiders

│ └── __init__.py

└── scrapy.cfg2.在spiders 目录下创建模板

➜ spiders scrapy genspider sf "https://segmentfault.com"

Created spider 'sf' using template 'basic' in module:

SF.spiders.sf

➜ spiders这样,就生成了一个项目文件 sf.py

# -*- coding: utf-8 -*-

import scrapy

from SF.items import SfItem

class SfSpider(scrapy.Spider):

name = 'sf'

allowed_domains = ['https://segmentfault.com']

start_urls = ['https://segmentfault.com/']

def parse(self, response):

# print response.body

# pass

node_list = response.xpath("//h2[@class='title']")

# 用来存储所有的item字段的

# items = []

for node in node_list:

# 创建item字段对象,用来存储信息

item = SfItem()

# .extract() 将xpath对象转换为 Unicode字符串

title = node.xpath("./a/text()").extract()

item['title'] = title[0]

# 返回抓取到的item数据,给管道文件处理,同时还回来继续执行后边的代码

yield.item

#return item

#return scrapy.Request(url)

#items.append(item)

命令:

# 测试爬虫是否正常, sf为爬虫的名称

➜ scrapy check sf

# 运行爬虫

➜ scrapy crawl sf3.item pipeline

当 item 在Spider中被收集之后,它将会被传递到 item Pipeline, 这些 item Pipeline 组件按定义的顺序处理 item.

每个 Item Pipeline 都是实现了简单方法的Python 类,比如决定此Item是丢弃或存储,以下是 item pipeline 的一些典型应用:

- 验证爬取得数据(检查item包含某些字段,比如说name字段)

- 查重(并丢弃)

- 将爬取结果保存到文件或者数据库总(数据持久化)

编写 item pipeline

编写 item pipeline 很简单,item pipeline 组件是一个独立的Python类,其中 process_item()方法必须实现。

from scrapy.exceptions import DropItem

class PricePipeline(object):

vat_factor = 1.15

def process_item(self, item, spider):

if item['price']:

if item['price_excludes_vat']:

item['price'] = item['price'] * self.vat_factor

return item

else:

raise DropItem("Missing price in %s" % item)4.选择器(Selectors)

当抓取网页时,你做的最常见的任务是从HTML源码中提取数据。

Selector 有四个基本的方法,最常用的还是Xpath

-

xpath():传入xpath表达式,返回该表达式所对应的所有节点的selector list 列表。 -

extract(): 序列化该节点为Unicode字符串并返回list -

css():传入CSS表达式,返回该表达式所对应的所有节点的selector list 列表,语法同 BeautifulSoup4 -

re():根据传入的正则表达式对数据进行提取,返回Unicode 字符串list 列表

Scrapy提取数据有自己的一套机制。它们被称作选择器(seletors),因为他们通过特定的 XPath 或者 CSS 表达式来“选择” HTML文件中的某个部分。

XPath 是一门用来在XML文件中选择节点的语言,也可以用在HTML上。 CSS 是一门将HTML文档样式化的语言。选择器由它定义,并与特定的HTML元素的样式相关连。

Scrapy选择器构建于 lxml 库之上,这意味着它们在速度和解析准确性上非常相似。

XPath表达式的例子:

/html/head/title: 选择文档中标签内的元素

/html/head/title/text(): 选择上面提到的<title>元素的问题

//td: 选择所有的<td> 元素

//div[@class="mine"]:选择所有具有 class="mine" 属性的 div 元素</code></pre>

<p>更多XPath 语法总结请看这里。</p>

<h2>五、爬取招聘信息</h2>

<h3>1.爬取腾讯招聘信息</h3>

<p>爬取的地址:http://hr.tencent.com/positio...</p>

<h4>1.1 创建项目</h4>

<pre><code>> scrapy startproject Tencent

You can start your first spider with:

cd Tencent

scrapy genspider example example.com</code></pre>

<p><span class="img-wrap"><a href="http://img.e-com-net.com/image/info8/483efb38515e48e7b32be8f78fc36914.jpg" target="_blank"><img src="http://img.e-com-net.com/image/info8/483efb38515e48e7b32be8f78fc36914.jpg" alt="Python Scrapy爬虫框架学习_第3张图片" title="clipboard.png" width="452" height="200" style="border:1px solid black;"></a></span></p>

<p>需要抓取网页的元素:</p>

<p><span class="img-wrap"><a href="http://img.e-com-net.com/image/info8/8cb8c954a22b482e87a5f277de2c5fb7.jpg" target="_blank"><img src="http://img.e-com-net.com/image/info8/8cb8c954a22b482e87a5f277de2c5fb7.jpg" alt="Python Scrapy爬虫框架学习_第4张图片" title="clipboard.png" width="650" height="440" style="border:1px solid black;"></a></span></p>

<p>我们需要爬取以下信息:<br>职位名:positionName<br>职位链接:positionLink<br>职位类型:positionType<br>职位人数:positionNumber<br>工作地点:workLocation<br>发布时点:publishTime</p>

<p>在 <code>items.py</code> 文件中定义爬取的字段:</p>

<pre><code># -*- coding: utf-8 -*-

# Define here the models for your scraped items

#

# See documentation in:

# http://doc.scrapy.org/en/latest/topics/items.html

import scrapy

# 定义字段

class TencentItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

# 职位名

positionName = scrapy.Field()

# 职位链接

positionLink = scrapy.Field()

# 职位类型

positionType = scrapy.Field()

# 职位人数

positionNumber = scrapy.Field()

# 工作地点

workLocation = scrapy.Field()

# 发布时点

publishTime = scrapy.Field()

pass

</code></pre>

<h4>1.2 写spider爬虫</h4>

<p>使用命令创建</p>

<pre><code>➜ Tencent scrapy genspider tencent "tencent.com"

Created spider 'tencent' using template 'basic' in module:

Tencent.spiders.tencent</code></pre>

<p>生成的 spider 在当前目录下的 <code>spiders/tencent.py</code></p>

<pre><code>➜ Tencent tree

.

├── __init__.py

├── __init__.pyc

├── items.py

├── middlewares.py

├── pipelines.py

├── settings.py

├── settings.pyc

└── spiders

├── __init__.py

├── __init__.pyc

└── tencent.py</code></pre>

<p>我们可以看下生成的这个初始化文件 <code>tencent.py</code></p>

<pre><code># -*- coding: utf-8 -*-

import scrapy

class TencentSpider(scrapy.Spider):

name = 'tencent'

allowed_domains = ['tencent.com']

start_urls = ['http://tencent.com/']

def parse(self, response):

pass

</code></pre>

<p>对初识文件<code>tencent.py</code>进行修改:</p>

<pre><code># -*- coding: utf-8 -*-

import scrapy

from Tencent.items import TencentItem

class TencentSpider(scrapy.Spider):

name = 'tencent'

allowed_domains = ['tencent.com']

baseURL = "http://hr.tencent.com/position.php?&start="

offset = 0 # 偏移量

start_urls = [baseURL + str(offset)]

def parse(self, response):

# 请求响应

# node_list = response.xpath("//tr[@class='even'] or //tr[@class='odd']")

node_list = response.xpath("//tr[@class='even'] | //tr[@class='odd']")

for node in node_list:

item = TencentItem() # 引入字段类

# 文本内容, 取列表的第一个元素[0], 并且将提取出来的Unicode编码 转为 utf-8

item['positionName'] = node.xpath("./td[1]/a/text()").extract()[0].encode("utf-8")

item['positionLink'] = node.xpath("./td[1]/a/@href").extract()[0].encode("utf-8") # 链接属性

item['positionType'] = node.xpath("./td[2]/text()").extract()[0].encode("utf-8")

item['positionNumber'] = node.xpath("./td[3]/text()").extract()[0].encode("utf-8")

item['workLocation'] = node.xpath("./td[4]/text()").extract()[0].encode("utf-8")

item['publishTime'] = node.xpath("./td[5]/text()").extract()[0].encode("utf-8")

# 返回给管道处理

yield item

# 先爬 2000 页数据

if self.offset < 2000:

self.offset += 10

url = self.baseURL + self.offset

yield scrapy.Request(url, callback = self.parse)

#pass

</code></pre>

<p>写管道文件 <code>pipelines.py</code>:</p>

<pre><code># -*- coding: utf-8 -*-

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: http://doc.scrapy.org/en/latest/topics/item-pipeline.html

import json

class TencentPipeline(object):

def __init__(self):

self.f = open("tencent.json", "w")

# 所有的item使用共同的管道

def process_item(self, item, spider):

content = json.dumps(dict(item), ensure_ascii = False) + ",\n"

self.f.write(content)

return item

def close_spider(self, spider):

self.f.close()

</code></pre>

<p>管道写好之后,在 <code>settings.py</code> 中启用管道</p>

<pre><code># Configure item pipelines

# See http://scrapy.readthedocs.org/en/latest/topics/item-pipeline.html

ITEM_PIPELINES = {

'Tencent.pipelines.TencentPipeline': 300,

}</code></pre>

<p>运行:</p>

<pre><code>> scrapy crawl tencent

File "/Users/kaiyiwang/Code/python/spider/Tencent/Tencent/spiders/tencent.py", line 21, in parse

item['positionName'] = node.xpath("./td[1]/a/text()").extract()[0].encode("utf-8")

IndexError: list index out of range</code></pre>

<p>请求响应这里写的有问题,Xpath或应该为这种写法:</p>

<pre><code> # 请求响应

# node_list = response.xpath("//tr[@class='even'] or //tr[@class='odd']")

node_list = response.xpath("//tr[@class='even'] | //tr[@class='odd']")

</code></pre>

<p>然后再执行命令:</p>

<pre><code>> scrapy crawl tencent</code></pre>

<p>执行结果文件 <code>tencent.json</code> :</p>

<pre><code>{"positionName": "23673-财经运营中心热点运营组编辑", "publishTime": "2017-12-02", "positionLink": "position_detail.php?id=32718&keywords=&tid=0&lid=0", "positionType": "内容编辑类", "workLocation": "北京", "positionNumber": "1"},

{"positionName": "MIG03-腾讯地图高级算法评测工程师(北京)", "publishTime": "2017-12-02", "positionLink": "position_detail.php?id=30276&keywords=&tid=0&lid=0", "positionType": "技术类", "workLocation": "北京", "positionNumber": "1"},

{"positionName": "MIG10-微回收渠道产品运营经理(深圳)", "publishTime": "2017-12-02", "positionLink": "position_detail.php?id=32720&keywords=&tid=0&lid=0", "positionType": "产品/项目类", "workLocation": "深圳", "positionNumber": "1"},

{"positionName": "MIG03-iOS测试开发工程师(北京)", "publishTime": "2017-12-02", "positionLink": "position_detail.php?id=32715&keywords=&tid=0&lid=0", "positionType": "技术类", "workLocation": "北京", "positionNumber": "1"},

{"positionName": "19332-高级PHP开发工程师(上海)", "publishTime": "2017-12-02", "positionLink": "position_detail.php?id=31967&keywords=&tid=0&lid=0", "positionType": "技术类", "workLocation": "上海", "positionNumber": "2"}</code></pre>

<h4>1.3 通过下一页爬取</h4>

<p>我们上边是通过总的页数来抓取每页数据的,但是没有考虑到每天的数据是变化的,所以,需要爬取的总页数不能写死,那该怎么判断是否爬完了数据呢?其实很简单,我们可以根据<code>下一页</code>来爬取,只要下一页没有数据了,就说明数据已经爬完了。</p>

<p><span class="img-wrap"><a href="http://img.e-com-net.com/image/info8/47f0e42030aa455dbc589e5118e22867.jpg" target="_blank"><img src="http://img.e-com-net.com/image/info8/47f0e42030aa455dbc589e5118e22867.jpg" alt="Python Scrapy爬虫框架学习_第5张图片" title="clipboard.png" width="650" height="201" style="border:1px solid black;"></a></span></p>

<p>我们通过 <code>下一页</code> 看下最后一页的特征:</p>

<p><span class="img-wrap"><a href="http://img.e-com-net.com/image/info8/3eaa9861e277480ab305cfe84d7d3251.jpg" target="_blank"><img src="http://img.e-com-net.com/image/info8/3eaa9861e277480ab305cfe84d7d3251.jpg" alt="Python Scrapy爬虫框架学习_第6张图片" title="clipboard.png" width="650" height="233" style="border:1px solid black;"></a></span></p>

<p>下一页的按钮为灰色,并且链接为 <code>class='noactive'</code>属性了,我们可以根据此特性来判断是否到最后一页了。</p>

<pre><code> # 写死总页数,先爬 100 页数据

"""

if self.offset < 100:

self.offset += 10

url = self.baseURL + str(self.offset)

yield scrapy.Request(url, callback = self.parse)

"""

# 使用下一页爬取数据

if len(response.xpath("//a[@class='noactive' and @id='next']")) == 0:

url = response.xpath("//a[@id='next']/@href").extract()[0]

yield scrapy.Request("http://hr.tencent.com/" + url, callback = self.parse)</code></pre>

<p>修改后的<code>tencent.py</code>文件:</p>

<pre><code># -*- coding: utf-8 -*-

import scrapy

from Tencent.items import TencentItem

class TencentSpider(scrapy.Spider):

# 爬虫名

name = 'tencent'

# 爬虫爬取数据的域范围

allowed_domains = ['tencent.com']

# 1.需要拼接的URL

baseURL = "http://hr.tencent.com/position.php?&start="

# 需要拼接的URL地址的偏移量

offset = 0 # 偏移量

# 爬虫启动时,读取的URL地址列表

start_urls = [baseURL + str(offset)]

# 用来处理response

def parse(self, response):

# 提取每个response的数据

node_list = response.xpath("//tr[@class='even'] | //tr[@class='odd']")

for node in node_list:

# 构建item对象,用来保存数据

item = TencentItem()

# 文本内容, 取列表的第一个元素[0], 并且将提取出来的Unicode编码 转为 utf-8

print node.xpath("./td[1]/a/text()").extract()

item['positionName'] = node.xpath("./td[1]/a/text()").extract()[0].encode("utf-8")

item['positionLink'] = node.xpath("./td[1]/a/@href").extract()[0].encode("utf-8") # 链接属性

# 进行是否为空判断

if len(node.xpath("./td[2]/text()")):

item['positionType'] = node.xpath("./td[2]/text()").extract()[0].encode("utf-8")

else:

item['positionType'] = ""

item['positionNumber'] = node.xpath("./td[3]/text()").extract()[0].encode("utf-8")

item['workLocation'] = node.xpath("./td[4]/text()").extract()[0].encode("utf-8")

item['publishTime'] = node.xpath("./td[5]/text()").extract()[0].encode("utf-8")

# yield的重要性,是返回数据后还能回来接着执行代码,返回给管道处理,如果为return 整个函数都退出了

yield item

# 第一种写法:拼接URL,适用场景:页面没有可以点击的请求链接,必须通过拼接URL才能获取响应

"""

if self.offset < 100:

self.offset += 10

url = self.baseURL + str(self.offset)

yield scrapy.Request(url, callback = self.parse)

"""

# 第二种写法:直接从response获取需要爬取的连接,并发送请求处理,直到连接全部提取完(使用下一页爬取数据)

if len(response.xpath("//a[@class='noactive' and @id='next']")) == 0:

url = response.xpath("//a[@id='next']/@href").extract()[0]

yield scrapy.Request("http://hr.tencent.com/" + url, callback = self.parse)

#pass

</code></pre>

<p>OK,通过 根据下一页我们成功爬完招聘信息的所有数据。</p>

<h4>1.4 小结</h4>

<p>爬虫步骤:</p>

<ul>

<li>1.创建项目 scrapy project XXX</li>

<li>2.scarpy genspider xxx "http://www.xxx.com"</li>

<li>3.编写 items.py, 明确需要提取的数据</li>

<li>4.编写 <code>spiders/xxx.py</code>, 编写爬虫文件,处理请求和响应,<strong>以及提取数据(yield item)</strong> </li>

<li>5.编写 <code>pipelines.py</code>, 编写管道文件,处理spider返回item数据,比如本地数据持久化,写文件或存到表中。</li>

<li>6.编写 <code>settings.py</code>,启动管道组件<code>ITEM_PIPELINES</code>,以及其他相关设置</li>

<li>7.执行爬虫 <code>scrapy crawl xxx</code> </li>

</ul>

<p>有时候被爬取的网站可能做了很多限制,所以,我们请求时可以添加请求报头,scrapy 给我们提供了一个很方便的报头配置的地方,<code>settings.py</code> 中,我们可以开启:</p>

<pre><code>

# Crawl responsibly by identifying yourself (and your website) on the user-agent

USER_AGENT = 'Tencent (+http://www.yourdomain.com)'

User-AGENT = "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6)

AppleWebKit/537.36 (KHTML, like Gecko)

Chrome/62.0.3202.94 Safari/537.36"

# Override the default request headers:

DEFAULT_REQUEST_HEADERS = {

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Language': 'en',

}</code></pre>

<p>scrapy 最大的适用场景是爬取静态页面,性能非常强悍,但如果要爬取动态的json数据,那就没必要了。</p>

<hr>

<p>相关文章:</p>

<p>Scrapy入门教程</p>

</div>

</div>

</div>

</div>

</div>

</div>

<!--PC和WAP自适应版-->

<div id="SOHUCS" sid="1292925265965555712"></div>

<script type="text/javascript" src="/views/front/js/chanyan.js"></script>

<!-- 文章页-底部 动态广告位 -->

<div class="youdao-fixed-ad" id="detail_ad_bottom"></div>

</div>

<div class="col-md-3">

<div class="row" id="ad">

<!-- 文章页-右侧1 动态广告位 -->

<div id="right-1" class="col-lg-12 col-md-12 col-sm-4 col-xs-4 ad">

<div class="youdao-fixed-ad" id="detail_ad_1"> </div>

</div>

<!-- 文章页-右侧2 动态广告位 -->

<div id="right-2" class="col-lg-12 col-md-12 col-sm-4 col-xs-4 ad">

<div class="youdao-fixed-ad" id="detail_ad_2"></div>

</div>

<!-- 文章页-右侧3 动态广告位 -->

<div id="right-3" class="col-lg-12 col-md-12 col-sm-4 col-xs-4 ad">

<div class="youdao-fixed-ad" id="detail_ad_3"></div>

</div>

</div>

</div>

</div>

</div>

</div>

<div class="container">

<h4 class="pt20 mb15 mt0 border-top">你可能感兴趣的:(Python Scrapy爬虫框架学习)</h4>

<div id="paradigm-article-related">

<div class="recommend-post mb30">

<ul class="widget-links">

<li><a href="/article/1943993659967991808.htm"

title="系统学习Python——并发模型和异步编程:进程、线程和GIL" target="_blank">系统学习Python——并发模型和异步编程:进程、线程和GIL</a>

<span class="text-muted"></span>

<div>分类目录:《系统学习Python》总目录在文章《并发模型和异步编程:基础知识》我们简单介绍了Python中的进程、线程和协程。本文就着重介绍Python中的进程、线程和GIL的关系。Python解释器的每个实例都是一个进程。使用multiprocessing或concurrent.futures库可以启动额外的Python进程。Python的subprocess库用于启动运行外部程序(不管使用何种</div>

</li>

<li><a href="/article/1943992776169418752.htm"

title="Flask框架入门:快速搭建轻量级Python网页应用" target="_blank">Flask框架入门:快速搭建轻量级Python网页应用</a>

<span class="text-muted">「已注销」</span>

<a class="tag" taget="_blank" href="/search/python-AI/1.htm">python-AI</a><a class="tag" taget="_blank" href="/search/python%E5%9F%BA%E7%A1%80/1.htm">python基础</a><a class="tag" taget="_blank" href="/search/%E7%BD%91%E7%AB%99%E7%BD%91%E7%BB%9C/1.htm">网站网络</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/flask/1.htm">flask</a><a class="tag" taget="_blank" href="/search/%E5%90%8E%E7%AB%AF/1.htm">后端</a>

<div>转载:Flask框架入门:快速搭建轻量级Python网页应用1.Flask基础Flask是一个使用Python编写的轻量级Web应用框架。它的设计目标是让Web开发变得快速简单,同时保持应用的灵活性。Flask依赖于两个外部库:Werkzeug和Jinja2,Werkzeug作为WSGI工具包处理Web服务的底层细节,Jinja2作为模板引擎渲染模板。安装Flask非常简单,可以使用pip安装命令</div>

</li>

<li><a href="/article/1943991891796226048.htm"

title="Python Flask 框架入门:快速搭建 Web 应用的秘诀" target="_blank">Python Flask 框架入门:快速搭建 Web 应用的秘诀</a>

<span class="text-muted">Python编程之道</span>

<a class="tag" taget="_blank" href="/search/Python%E4%BA%BA%E5%B7%A5%E6%99%BA%E8%83%BD%E4%B8%8E%E5%A4%A7%E6%95%B0%E6%8D%AE/1.htm">Python人工智能与大数据</a><a class="tag" taget="_blank" href="/search/Python%E7%BC%96%E7%A8%8B%E4%B9%8B%E9%81%93/1.htm">Python编程之道</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/flask/1.htm">flask</a><a class="tag" taget="_blank" href="/search/%E5%89%8D%E7%AB%AF/1.htm">前端</a><a class="tag" taget="_blank" href="/search/ai/1.htm">ai</a>

<div>PythonFlask框架入门:快速搭建Web应用的秘诀关键词Flask、微框架、路由系统、Jinja2模板、请求处理、WSGI、Web开发摘要想快速用Python搭建一个灵活的Web应用?Flask作为“微框架”代表,凭借轻量、可扩展的特性,成为初学者和小型项目的首选。本文将从Flask的核心概念出发,结合生活化比喻、代码示例和实战案例,带你一步步掌握:如何用Flask搭建第一个Web应用?路由</div>

</li>

<li><a href="/article/1943988487875260416.htm"

title="python_虚拟环境" target="_blank">python_虚拟环境</a>

<span class="text-muted">阿_焦</span>

<a class="tag" taget="_blank" href="/search/python/1.htm">python</a>

<div>第一、配置虚拟环境:virtualenv(1)pipvirtualenv>安装虚拟环境包(2)pipinstallvirtualenvwrapper-win>安装虚拟环境依赖包(3)c盘创建虚拟目录>C:\virtualenv>配置环境变量【了解一下】:(1)如何使用virtualenv创建虚拟环境a、cd到C:\virtualenv目录下:b、mkvirtualenvname>创建虚拟环境nam</div>

</li>

<li><a href="/article/1943985208218939392.htm"

title="Python爱心光波" target="_blank">Python爱心光波</a>

<span class="text-muted"></span>

<div>系列文章序号直达链接Tkinter1Python李峋同款可写字版跳动的爱心2Python跳动的双爱心3Python蓝色跳动的爱心4Python动漫烟花5Python粒子烟花Turtle1Python满屏飘字2Python蓝色流星雨3Python金色流星雨4Python漂浮爱心5Python爱心光波①6Python爱心光波②7Python满天繁星8Python五彩气球9Python白色飘雪10Pyt</div>

</li>

<li><a href="/article/1943985208697090048.htm"

title="Python流星雨" target="_blank">Python流星雨</a>

<span class="text-muted">Want595</span>

<a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a>

<div>文章目录系列文章写在前面技术需求完整代码代码分析1.模块导入2.画布设置3.画笔设置4.颜色列表5.流星类(Star)6.流星对象创建7.主循环8.流星运动逻辑9.视觉效果10.总结写在后面系列文章序号直达链接表白系列1Python制作一个无法拒绝的表白界面2Python满屏飘字表白代码3Python无限弹窗满屏表白代码4Python李峋同款可写字版跳动的爱心5Python流星雨代码6Python</div>

</li>

<li><a href="/article/1943983065500020736.htm"

title="Python之七彩花朵代码实现" target="_blank">Python之七彩花朵代码实现</a>

<span class="text-muted">PlutoZuo</span>

<a class="tag" taget="_blank" href="/search/Python/1.htm">Python</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a>

<div>Python之七彩花朵代码实现文章目录Python之七彩花朵代码实现下面是一个简单的使用Python的七彩花朵。这个示例只是一个简单的版本,没有很多高级功能,但它可以作为一个起点,你可以在此基础上添加更多功能。importturtleastuimportrandomasraimportmathtu.setup(1.0,1.0)t=tu.Pen()t.ht()colors=['red','skybl</div>

</li>

<li><a href="/article/1943982902379343872.htm"

title="Python 脚本最佳实践2025版" target="_blank">Python 脚本最佳实践2025版</a>

<span class="text-muted"></span>

<div>前文可以直接把这篇文章喂给AI,可以放到AI角色设定里,也可以直接作为提示词.这样,你只管提需求,写脚本就让AI来.概述追求简洁和清晰:脚本应简单明了。使用函数(functions)、常量(constants)和适当的导入(import)实践来有逻辑地组织你的Python脚本。使用枚举(enumerations)和数据类(dataclasses)等数据结构高效管理脚本状态。通过命令行参数增强交互性</div>

</li>

<li><a href="/article/1943982558085705728.htm"

title="(Python基础篇)了解和使用分支结构" target="_blank">(Python基础篇)了解和使用分支结构</a>

<span class="text-muted">EternityArt</span>

<a class="tag" taget="_blank" href="/search/%E5%9F%BA%E7%A1%80%E7%AF%87/1.htm">基础篇</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a>

<div>目录一、引言二、Python分支结构的类型与语法(一)if语句(单分支)(二)if-else语句(双分支)(三)if-elif-else语句(多分支)三、分支结构的应用场景(一)提示用户输入用户名,然后再提示输入密码,如果用户名是“admin”并且密码是“88888”则提示正确,否则,如果用户名不是admin还提示用户用户名不存在,(二)提示用户输入用户名,然后再提示输入密码,如果用户名是“adm</div>

</li>

<li><a href="/article/1943982558555467776.htm"

title="(Python基础篇)循环结构" target="_blank">(Python基础篇)循环结构</a>

<span class="text-muted">EternityArt</span>

<a class="tag" taget="_blank" href="/search/%E5%9F%BA%E7%A1%80%E7%AF%87/1.htm">基础篇</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a>

<div>一、什么是Python循环结构?循环结构是编程中重复执行代码块的机制。在Python中,循环允许你:1.迭代处理数据:遍历列表、字典、文件内容等。2.自动化重复任务:如批量处理数据、生成序列等。3.控制执行流程:根据条件决定是否继续或终止循环。二、为什么需要循环结构?假设你需要打印1到100的所有偶数:没有循环:需手动编写100行print()语句。print(0)print(2)print(4)</div>

</li>

<li><a href="/article/1943982559000064000.htm"

title="(Python基础篇)字典的操作" target="_blank">(Python基础篇)字典的操作</a>

<span class="text-muted">EternityArt</span>

<a class="tag" taget="_blank" href="/search/%E5%9F%BA%E7%A1%80%E7%AF%87/1.htm">基础篇</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a>

<div>一、引言在Python编程中,字典(Dictionary)是一种极具灵活性的数据结构,它通过“键-值对”(key-valuepair)的形式存储数据,如同现实生活中的字典——通过“词语(键)”快速查找“释义(值)”。相较于列表和元组的有序索引访问,字典的优势在于基于键的快速查找,这使得它在处理需要频繁通过唯一标识获取数据的场景中极为高效。掌握字典的操作,能让我们更高效地组织和管理复杂数据,是Pyt</div>

</li>

<li><a href="/article/1943981927514042368.htm"

title="Python七彩花朵" target="_blank">Python七彩花朵</a>

<span class="text-muted">Want595</span>

<a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a>

<div>系列文章序号直达链接Tkinter1Python李峋同款可写字版跳动的爱心2Python跳动的双爱心3Python蓝色跳动的爱心4Python动漫烟花5Python粒子烟花Turtle1Python满屏飘字2Python蓝色流星雨3Python金色流星雨4Python漂浮爱心5Python爱心光波①6Python爱心光波②7Python满天繁星8Python五彩气球9Python白色飘雪10Pyt</div>

</li>

<li><a href="/article/1943975627472302080.htm"

title="用OpenCV标定相机内参应用示例(C++和Python)" target="_blank">用OpenCV标定相机内参应用示例(C++和Python)</a>

<span class="text-muted"></span>

<div>下面是一个完整的使用OpenCV进行相机内参标定(CameraCalibration)的示例,包括C++和Python两个版本,基于棋盘格图案标定。一、目标:相机标定通过拍摄多张带有棋盘格图案的图像,估计相机的内参:相机矩阵(内参)K畸变系数distCoeffs可选外参(R,T)标定精度指标(如重投影误差)二、棋盘格参数设置(根据自己的棋盘格设置):棋盘格角点数:9x6(内角点,9列×6行);每个</div>

</li>

<li><a href="/article/1943974492640440320.htm"

title="Anaconda 详细下载与安装教程" target="_blank">Anaconda 详细下载与安装教程</a>

<span class="text-muted"></span>

<div>Anaconda详细下载与安装教程1.简介Anaconda是一个用于科学计算的开源发行版,包含了Python和R的众多常用库。它还包括了conda包管理器,可以方便地安装、更新和管理各种软件包。2.下载Anaconda2.1访问官方网站首先,打开浏览器,访问Anaconda官方网站。2.2选择适合的版本在页面中,你会看到两个主要的下载选项:AnacondaIndividualEdition:适用于</div>

</li>

<li><a href="/article/1943972473032732672.htm"

title="python中 @注解 及内置注解 的使用方法总结以及完整示例" target="_blank">python中 @注解 及内置注解 的使用方法总结以及完整示例</a>

<span class="text-muted">慧一居士</span>

<a class="tag" taget="_blank" href="/search/Python/1.htm">Python</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a>

<div>在Python中,装饰器(Decorator)使用@符号实现,是一种修改函数/类行为的语法糖。它本质上是一个高阶函数,接受目标函数作为参数并返回包装后的函数。Python也提供了多个内置装饰器,如@property、@staticmethod、@classmethod等。一、核心概念装饰器本质:@decorator等价于func=decorator(func)执行时机:在函数/类定义时立即执行装饰</div>

</li>

<li><a href="/article/1943971717185597440.htm"

title="Python中的静态方法和类方法详解" target="_blank">Python中的静态方法和类方法详解</a>

<span class="text-muted"></span>

<div>在Python中,`@staticmethod`和`@classmethod`是两种装饰器,它们用于定义类中的方法,但是它们的行为和用途有所不同。###@staticmethod`@staticmethod`装饰器用于定义一个静态方法。静态方法不接收类或实例的引用作为第一个参数,因此它不能访问类的状态或实例的状态。静态方法可以看作是与类关联的普通函数,但它们可以通过类名直接调用。classMath</div>

</li>

<li><a href="/article/1943969448046161920.htm"

title="Python中类静态方法:@classmethod/@staticmethod详解和实战示例" target="_blank">Python中类静态方法:@classmethod/@staticmethod详解和实战示例</a>

<span class="text-muted"></span>

<div>在Python中,类方法(@classmethod)和静态方法(@staticmethod)是类作用域下的两种特殊方法。它们使用装饰器定义,并且与实例方法(deffunc(self))的行为有所不同。1.三种方法的对比概览方法类型是否访问实例(self)是否访问类(cls)典型用途实例方法✅是❌否访问对象属性类方法@classmethod❌否✅是创建类的替代构造器,访问类变量等静态方法@stati</div>

</li>

<li><a href="/article/1943968314044772352.htm"

title="Python多版本管理与pip升级全攻略:解决冲突与高效实践" target="_blank">Python多版本管理与pip升级全攻略:解决冲突与高效实践</a>

<span class="text-muted">码界奇点</span>

<a class="tag" taget="_blank" href="/search/Python/1.htm">Python</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/pip/1.htm">pip</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a><a class="tag" taget="_blank" href="/search/python3.11/1.htm">python3.11</a><a class="tag" taget="_blank" href="/search/%E6%BA%90%E4%BB%A3%E7%A0%81%E7%AE%A1%E7%90%86/1.htm">源代码管理</a><a class="tag" taget="_blank" href="/search/%E8%99%9A%E6%8B%9F%E7%8E%B0%E5%AE%9E/1.htm">虚拟现实</a><a class="tag" taget="_blank" href="/search/%E4%BE%9D%E8%B5%96%E5%80%92%E7%BD%AE%E5%8E%9F%E5%88%99/1.htm">依赖倒置原则</a>

<div>引言Python作为最流行的编程语言之一,其版本迭代速度与生态碎片化给开发者带来了巨大挑战。据统计,超过60%的Python开发者需要同时维护基于Python3.6+和Python2.7的项目。本文将系统解决以下核心痛点:如何安全地在同一台机器上管理多个Python版本pip依赖冲突的根治方案符合PEP标准的生产环境最佳实践第一部分:Python多版本管理核心方案1.1系统级多版本共存方案Wind</div>

</li>

<li><a href="/article/1943967555555225600.htm"

title="基于Python的健身数据分析工具的搭建流程day1" target="_blank">基于Python的健身数据分析工具的搭建流程day1</a>

<span class="text-muted">weixin_45677320</span>

<a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a><a class="tag" taget="_blank" href="/search/%E6%95%B0%E6%8D%AE%E6%8C%96%E6%8E%98/1.htm">数据挖掘</a><a class="tag" taget="_blank" href="/search/%E7%88%AC%E8%99%AB/1.htm">爬虫</a>

<div>基于Python的健身数据分析工具的搭建流程分数据挖掘、数据存储和数据分析三个步骤。本文主要介绍利用Python实现健身数据分析工具的数据挖掘部分。第一步:加载库加载本文需要的库,如下代码所示。若库未安装,请按照python如何安装各种库(保姆级教程)_python安装库-CSDN博客https://blog.csdn.net/aobulaien001/article/details/133298</div>

</li>

<li><a href="/article/1943952054795956224.htm"

title="seaborn又一个扩展heatmapz" target="_blank">seaborn又一个扩展heatmapz</a>

<span class="text-muted">qq_21478261</span>

<a class="tag" taget="_blank" href="/search/%23/1.htm">#</a><a class="tag" taget="_blank" href="/search/Python%E5%8F%AF%E8%A7%86%E5%8C%96/1.htm">Python可视化</a><a class="tag" taget="_blank" href="/search/matplotlib/1.htm">matplotlib</a>

<div>推荐阅读:Pythonmatplotlib保姆级教程嫌Matplotlib繁琐?试试Seaborn!</div>

</li>

<li><a href="/article/1943951549751422976.htm"

title="NGS测序基础梳理01-文库构建(Library Preparation)" target="_blank">NGS测序基础梳理01-文库构建(Library Preparation)</a>

<span class="text-muted">qq_21478261</span>

<a class="tag" taget="_blank" href="/search/%23/1.htm">#</a><a class="tag" taget="_blank" href="/search/%E7%94%9F%E7%89%A9%E4%BF%A1%E6%81%AF/1.htm">生物信息</a><a class="tag" taget="_blank" href="/search/%E7%94%9F%E7%89%A9%E5%AD%A6/1.htm">生物学</a>

<div>本文介绍Illumina测序平台文库构建(LibraryPreparation)步骤,文库结构。写作时间:2020.05。推荐阅读:10W字《Python可视化教程1.0》来了!一份由公众号「pythonic生物人」精心制作的PythonMatplotlib可视化系统教程,105页PDFhttps://mp.weixin.qq.com/s/QaSmucuVsS_DR-klfpE3-Q10W字《Rg</div>

</li>

<li><a href="/article/1943943735205228544.htm"

title="Python 常用内置函数详解(七):dir()函数——获取当前本地作用域中的名称列表或对象的有效属性列表" target="_blank">Python 常用内置函数详解(七):dir()函数——获取当前本地作用域中的名称列表或对象的有效属性列表</a>

<span class="text-muted"></span>

<div>目录一、功能二、语法和示例一、功能dir()函数获取当前本地作用域中的名称列表或对象的有效属性列表。二、语法和示例dir()函数有两种形式,如果没有实参,则返回当前本地作用域中的名称列表。如果有实参,它会尝试返回该对象的有效属性列表。如果对象有一个名为__dir__()的方法,那么该方法将被调用,并且必须返回一个属性列表。dir()函数的语法格式如下:C:\Users\amoxiang>ipyth</div>

</li>

<li><a href="/article/1943941718281875456.htm"

title="pythonjson中list操作_Python json.dumps 特殊数据类型的自定义序列化操作" target="_blank">pythonjson中list操作_Python json.dumps 特殊数据类型的自定义序列化操作</a>

<span class="text-muted"></span>

<div>场景描述:Python标准库中的json模块,集成了将数据序列化处理的功能;在使用json.dumps()方法序列化数据时候,如果目标数据中存在datetime数据类型,执行操作时,会抛出异常:TypeError:datetime.datetime(2016,12,10,11,04,21)isnotJSONserializable那么遇到json.dumps序列化不支持的数据类型,该怎么办!首先,</div>

</li>

<li><a href="/article/1943940206172368896.htm"

title="Python 日期格式转json.dumps的解决方法" target="_blank">Python 日期格式转json.dumps的解决方法</a>

<span class="text-muted">douyaoxin</span>

<a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/json/1.htm">json</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a>

<div>classDateEncoder(json.JSONEncoder):defdefault(self,obj):ifisinstance(obj,datetime.datetime):returnobj.strftime('%Y-%m-%d%H:%M:%S')elifisinstance(obj,datetime.date):returnobj.strftime("%Y-%m-%d")json.d</div>

</li>

<li><a href="/article/1943934034132398080.htm"

title="Python 爬虫实战:视频平台播放量实时监控(含反爬对抗与数据趋势预测)" target="_blank">Python 爬虫实战:视频平台播放量实时监控(含反爬对抗与数据趋势预测)</a>

<span class="text-muted">西攻城狮北</span>

<a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/%E7%88%AC%E8%99%AB/1.htm">爬虫</a><a class="tag" taget="_blank" href="/search/%E9%9F%B3%E8%A7%86%E9%A2%91/1.htm">音视频</a>

<div>一、引言在数字内容蓬勃发展的当下,视频平台的播放量数据已成为内容创作者、营销人员以及行业分析师手中极为关键的情报资源。它不仅能够实时反映内容的受欢迎程度,更能在竞争分析、营销策略制定以及内容优化等方面发挥不可估量的作用。然而,视频平台为了保护自身数据和用户隐私,往往会设置一系列反爬虫机制,对数据爬取行为进行限制。这就向我们发起了挑战:如何巧妙地突破这些限制,同时精准地捕捉并预测播放量的动态变化趋势</div>

</li>

<li><a href="/article/1943933655697125376.htm"

title="Python技能手册 - 模块module" target="_blank">Python技能手册 - 模块module</a>

<span class="text-muted">金色牛神</span>

<a class="tag" taget="_blank" href="/search/Python/1.htm">Python</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/windows/1.htm">windows</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a>

<div>系列Python常用技能手册-基础语法Python常用技能手册-模块modulePython常用技能手册-包package目录module模块指什么typing数据类型int整数float浮点数str字符串bool布尔值TypeVar类型变量functools高阶函数工具functools.partial()函数偏置functools.lru_cache()函数缓存sorted排序列表排序元组排序</div>

</li>

<li><a href="/article/1943930629099941888.htm"

title="Ubuntu基础(Python虚拟环境和Vue)" target="_blank">Ubuntu基础(Python虚拟环境和Vue)</a>

<span class="text-muted">aaiier</span>

<a class="tag" taget="_blank" href="/search/ubuntu/1.htm">ubuntu</a><a class="tag" taget="_blank" href="/search/python/1.htm">python</a><a class="tag" taget="_blank" href="/search/linux/1.htm">linux</a>

<div>Python虚拟环境sudoaptinstallpython3python3-venv进入项目目录cdXXX创建虚拟环境python3-mvenvvenv激活虚拟环境sourcevenv/bin/activate退出虚拟环境deactivateVue安装Node.js和npm#安装Node.js和npm(Ubuntu默认仓库可能版本较旧,适合入门)sudoaptinstallnodejsnpm#验</div>

</li>

<li><a href="/article/1943930421968433152.htm"

title="苦练Python第9天:if-else分支九剑" target="_blank">苦练Python第9天:if-else分支九剑</a>

<span class="text-muted"></span>

<a class="tag" taget="_blank" href="/search/python%E5%90%8E%E7%AB%AF%E5%89%8D%E7%AB%AF%E4%BA%BA%E5%B7%A5%E6%99%BA%E8%83%BD/1.htm">python后端前端人工智能</a>

<div>苦练Python第9天:if-else分支九剑前言大家好,我是倔强青铜三。是一名热情的软件工程师,我热衷于分享和传播IT技术,致力于通过我的知识和技能推动技术交流与创新,欢迎关注我,微信公众号:倔强青铜三。欢迎点赞、收藏、关注,一键三连!!!欢迎来到100天Python挑战第9天!今天我们不练循环,改磨“分支剑法”——ifelse三式:单分支、双分支、多分支,以及嵌套和三元运算符,全部实战演练,让</div>

</li>

<li><a href="/article/1943930420689170432.htm"

title="苦练Python第8天:while 循环之妙用" target="_blank">苦练Python第8天:while 循环之妙用</a>

<span class="text-muted"></span>

<a class="tag" taget="_blank" href="/search/python%E5%90%8E%E7%AB%AF%E5%89%8D%E7%AB%AF%E4%BA%BA%E5%B7%A5%E6%99%BA%E8%83%BD/1.htm">python后端前端人工智能</a>

<div>苦练Python第8天:while循环之妙用原文链接:https://dev.to/therahul_gupta/day-9100-while-loops-with-real-world-examples-528f作者:RahulGupta译者:倔强青铜三前言大家好,我是倔强青铜三。是一名热情的软件工程师,我热衷于分享和传播IT技术,致力于通过我的知识和技能推动技术交流与创新,欢迎关注我,微信公众</div>

</li>

<li><a href="/article/1943930167651004416.htm"

title="苦练Python第5天:字符串从入门到格式化" target="_blank">苦练Python第5天:字符串从入门到格式化</a>

<span class="text-muted"></span>

<a class="tag" taget="_blank" href="/search/python%E5%90%8E%E7%AB%AF%E4%BA%BA%E5%B7%A5%E6%99%BA%E8%83%BD%E5%89%8D%E7%AB%AF/1.htm">python后端人工智能前端</a>

<div>苦练Python第5天:字符串从入门到格式化原文链接:https://dev.to/therahul_gupta/day-5100-working-with-strings-basics-to-formatting-2kkn作者:RahulGupta译者:倔强青铜三前言大家好,我是倔强青铜三。是一名热情的软件工程师,我热衷于分享和传播IT技术,致力于通过我的知识和技能推动技术交流与创新,欢迎关注我</div>

</li>

<li><a href="/article/20.htm"

title="矩阵求逆(JAVA)初等行变换" target="_blank">矩阵求逆(JAVA)初等行变换</a>

<span class="text-muted">qiuwanchi</span>

<a class="tag" taget="_blank" href="/search/%E7%9F%A9%E9%98%B5%E6%B1%82%E9%80%86%EF%BC%88JAVA%EF%BC%89/1.htm">矩阵求逆(JAVA)</a>

<div>package gaodai.matrix;

import gaodai.determinant.DeterminantCalculation;

import java.util.ArrayList;

import java.util.List;

import java.util.Scanner;

/**

* 矩阵求逆(初等行变换)

* @author 邱万迟

*</div>

</li>

<li><a href="/article/147.htm"

title="JDK timer" target="_blank">JDK timer</a>

<span class="text-muted">antlove</span>

<a class="tag" taget="_blank" href="/search/java/1.htm">java</a><a class="tag" taget="_blank" href="/search/jdk/1.htm">jdk</a><a class="tag" taget="_blank" href="/search/schedule/1.htm">schedule</a><a class="tag" taget="_blank" href="/search/code/1.htm">code</a><a class="tag" taget="_blank" href="/search/timer/1.htm">timer</a>

<div>1.java.util.Timer.schedule(TimerTask task, long delay):多长时间(毫秒)后执行任务

2.java.util.Timer.schedule(TimerTask task, Date time):设定某个时间执行任务

3.java.util.Timer.schedule(TimerTask task, long delay,longperiod</div>

</li>

<li><a href="/article/274.htm"

title="JVM调优总结 -Xms -Xmx -Xmn -Xss" target="_blank">JVM调优总结 -Xms -Xmx -Xmn -Xss</a>

<span class="text-muted">coder_xpf</span>

<a class="tag" taget="_blank" href="/search/jvm/1.htm">jvm</a><a class="tag" taget="_blank" href="/search/%E5%BA%94%E7%94%A8%E6%9C%8D%E5%8A%A1%E5%99%A8/1.htm">应用服务器</a>

<div>堆大小设置JVM 中最大堆大小有三方面限制:相关操作系统的数据模型(32-bt还是64-bit)限制;系统的可用虚拟内存限制;系统的可用物理内存限制。32位系统下,一般限制在1.5G~2G;64为操作系统对内存无限制。我在Windows Server 2003 系统,3.5G物理内存,JDK5.0下测试,最大可设置为1478m。

典型设置:

java -Xmx</div>

</li>

<li><a href="/article/401.htm"

title="JDBC连接数据库" target="_blank">JDBC连接数据库</a>

<span class="text-muted">Array_06</span>

<a class="tag" taget="_blank" href="/search/jdbc/1.htm">jdbc</a>

<div>package Util;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.ResultSet;

import java.sql.SQLException;

import java.sql.Statement;

public class JDBCUtil {

//完</div>

</li>

<li><a href="/article/528.htm"

title="Unsupported major.minor version 51.0(jdk版本错误)" target="_blank">Unsupported major.minor version 51.0(jdk版本错误)</a>

<span class="text-muted">oloz</span>

<a class="tag" taget="_blank" href="/search/java/1.htm">java</a>

<div>java.lang.UnsupportedClassVersionError: cn/support/cache/CacheType : Unsupported major.minor version 51.0 (unable to load class cn.support.cache.CacheType)

at org.apache.catalina.loader.WebappClassL</div>

</li>

<li><a href="/article/655.htm"

title="用多个线程处理1个List集合" target="_blank">用多个线程处理1个List集合</a>

<span class="text-muted">362217990</span>

<a class="tag" taget="_blank" href="/search/%E5%A4%9A%E7%BA%BF%E7%A8%8B/1.htm">多线程</a><a class="tag" taget="_blank" href="/search/thread/1.htm">thread</a><a class="tag" taget="_blank" href="/search/list/1.htm">list</a><a class="tag" taget="_blank" href="/search/%E9%9B%86%E5%90%88/1.htm">集合</a>

<div> 昨天发了一个提问,启动5个线程将一个List中的内容,然后将5个线程的内容拼接起来,由于时间比较急迫,自己就写了一个Demo,希望对菜鸟有参考意义。。

import java.util.ArrayList;

import java.util.List;

import java.util.concurrent.CountDownLatch;

public c</div>

</li>

<li><a href="/article/782.htm"

title="JSP简单访问数据库" target="_blank">JSP简单访问数据库</a>

<span class="text-muted">香水浓</span>

<a class="tag" taget="_blank" href="/search/sql/1.htm">sql</a><a class="tag" taget="_blank" href="/search/mysql/1.htm">mysql</a><a class="tag" taget="_blank" href="/search/jsp/1.htm">jsp</a>

<div>学习使用javaBean,代码很烂,仅为留个脚印

public class DBHelper {

private String driverName;

private String url;

private String user;

private String password;

private Connection connection;

privat</div>

</li>

<li><a href="/article/909.htm"

title="Flex4中使用组件添加柱状图、饼状图等图表" target="_blank">Flex4中使用组件添加柱状图、饼状图等图表</a>

<span class="text-muted">AdyZhang</span>

<a class="tag" taget="_blank" href="/search/Flex/1.htm">Flex</a>

<div>1.添加一个最简单的柱状图

? 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28

<?xml version=

"1.0"&n</div>

</li>

<li><a href="/article/1036.htm"

title="Android 5.0 - ProgressBar 进度条无法展示到按钮的前面" target="_blank">Android 5.0 - ProgressBar 进度条无法展示到按钮的前面</a>

<span class="text-muted">aijuans</span>

<a class="tag" taget="_blank" href="/search/android/1.htm">android</a>

<div>在低于SDK < 21 的版本中,ProgressBar 可以展示到按钮前面,并且为之在按钮的中间,但是切换到android 5.0后进度条ProgressBar 展示顺序变化了,按钮再前面,ProgressBar 在后面了我的xml配置文件如下:

[html]

view plain

copy

<RelativeLa</div>

</li>

<li><a href="/article/1163.htm"

title="查询汇总的sql" target="_blank">查询汇总的sql</a>

<span class="text-muted">baalwolf</span>

<a class="tag" taget="_blank" href="/search/sql/1.htm">sql</a>

<div>select list.listname, list.createtime,listcount from dream_list as list , (select listid,count(listid) as listcount from dream_list_user group by listid order by count(</div>

</li>

<li><a href="/article/1290.htm"

title="Linux du命令和df命令区别" target="_blank">Linux du命令和df命令区别</a>

<span class="text-muted">BigBird2012</span>

<a class="tag" taget="_blank" href="/search/linux/1.htm">linux</a>

<div> 1,两者区别

du,disk usage,是通过搜索文件来计算每个文件的大小然后累加,du能看到的文件只是一些当前存在的,没有被删除的。他计算的大小就是当前他认为存在的所有文件大小的累加和。

</div>

</li>

<li><a href="/article/1417.htm"

title="AngularJS中的$apply,用还是不用?" target="_blank">AngularJS中的$apply,用还是不用?</a>

<span class="text-muted">bijian1013</span>

<a class="tag" taget="_blank" href="/search/JavaScript/1.htm">JavaScript</a><a class="tag" taget="_blank" href="/search/AngularJS/1.htm">AngularJS</a><a class="tag" taget="_blank" href="/search/%24apply/1.htm">$apply</a>

<div> 在AngularJS开发中,何时应该调用$scope.$apply(),何时不应该调用。下面我们透彻地解释这个问题。

但是首先,让我们把$apply转换成一种简化的形式。

scope.$apply就像一个懒惰的工人。它需要按照命</div>

</li>

<li><a href="/article/1544.htm"

title="[Zookeeper学习笔记十]Zookeeper源代码分析之ClientCnxn数据序列化和反序列化" target="_blank">[Zookeeper学习笔记十]Zookeeper源代码分析之ClientCnxn数据序列化和反序列化</a>

<span class="text-muted">bit1129</span>

<a class="tag" taget="_blank" href="/search/zookeeper/1.htm">zookeeper</a>

<div>ClientCnxn是Zookeeper客户端和Zookeeper服务器端进行通信和事件通知处理的主要类,它内部包含两个类,1. SendThread 2. EventThread, SendThread负责客户端和服务器端的数据通信,也包括事件信息的传输,EventThread主要在客户端回调注册的Watchers进行通知处理

ClientCnxn构造方法

&</div>

</li>

<li><a href="/article/1671.htm"

title="【Java命令一】jmap" target="_blank">【Java命令一】jmap</a>

<span class="text-muted">bit1129</span>

<a class="tag" taget="_blank" href="/search/Java%E5%91%BD%E4%BB%A4/1.htm">Java命令</a>

<div>jmap命令的用法:

[hadoop@hadoop sbin]$ jmap

Usage:

jmap [option] <pid>

(to connect to running process)

jmap [option] <executable <core>

(to connect to a </div>

</li>

<li><a href="/article/1798.htm"

title="Apache 服务器安全防护及实战" target="_blank">Apache 服务器安全防护及实战</a>

<span class="text-muted">ronin47</span>

<div>此文转自IBM.

Apache 服务简介

Web 服务器也称为 WWW 服务器或 HTTP 服务器 (HTTP Server),它是 Internet 上最常见也是使用最频繁的服务器之一,Web 服务器能够为用户提供网页浏览、论坛访问等等服务。

由于用户在通过 Web 浏览器访问信息资源的过程中,无须再关心一些技术性的细节,而且界面非常友好,因而 Web 在 Internet 上一推出就得到</div>

</li>

<li><a href="/article/1925.htm"

title="unity 3d实例化位置出现布置?" target="_blank">unity 3d实例化位置出现布置?</a>

<span class="text-muted">brotherlamp</span>

<a class="tag" taget="_blank" href="/search/unity%E6%95%99%E7%A8%8B/1.htm">unity教程</a><a class="tag" taget="_blank" href="/search/unity/1.htm">unity</a><a class="tag" taget="_blank" href="/search/unity%E8%B5%84%E6%96%99/1.htm">unity资料</a><a class="tag" taget="_blank" href="/search/unity%E8%A7%86%E9%A2%91/1.htm">unity视频</a><a class="tag" taget="_blank" href="/search/unity%E8%87%AA%E5%AD%A6/1.htm">unity自学</a>

<div>问:unity 3d实例化位置出现布置?

答:实例化的同时就可以指定被实例化的物体的位置,即 position

Instantiate (original : Object, position : Vector3, rotation : Quaternion) : Object

这样你不需要再用Transform.Position了,

如果你省略了第二个参数(</div>

</li>

<li><a href="/article/2052.htm"

title="《重构,改善现有代码的设计》第八章 Duplicate Observed Data" target="_blank">《重构,改善现有代码的设计》第八章 Duplicate Observed Data</a>

<span class="text-muted">bylijinnan</span>

<a class="tag" taget="_blank" href="/search/java/1.htm">java</a><a class="tag" taget="_blank" href="/search/%E9%87%8D%E6%9E%84/1.htm">重构</a>

<div>

import java.awt.Color;

import java.awt.Container;

import java.awt.FlowLayout;

import java.awt.Label;

import java.awt.TextField;

import java.awt.event.FocusAdapter;

import java.awt.event.FocusE</div>

</li>

<li><a href="/article/2179.htm"

title="struts2更改struts.xml配置目录" target="_blank">struts2更改struts.xml配置目录</a>

<span class="text-muted">chiangfai</span>

<a class="tag" taget="_blank" href="/search/struts.xml/1.htm">struts.xml</a>

<div>struts2默认是读取classes目录下的配置文件,要更改配置文件目录,比如放在WEB-INF下,路径应该写成../struts.xml(非/WEB-INF/struts.xml)

web.xml文件修改如下:

<filter>

<filter-name>struts2</filter-name>

<filter-class&g</div>

</li>

<li><a href="/article/2306.htm"

title="redis做缓存时的一点优化" target="_blank">redis做缓存时的一点优化</a>

<span class="text-muted">chenchao051</span>

<a class="tag" taget="_blank" href="/search/redis/1.htm">redis</a><a class="tag" taget="_blank" href="/search/hadoop/1.htm">hadoop</a><a class="tag" taget="_blank" href="/search/pipeline/1.htm">pipeline</a>

<div>

最近集群上有个job,其中需要短时间内频繁访问缓存,大概7亿多次。我这边的缓存是使用redis来做的,问题就来了。

首先,redis中存的是普通kv,没有考虑使用hash等解结构,那么以为着这个job需要访问7亿多次redis,导致效率低,且出现很多redi</div>

</li>

<li><a href="/article/2433.htm"

title="mysql导出数据不输出标题行" target="_blank">mysql导出数据不输出标题行</a>

<span class="text-muted">daizj</span>

<a class="tag" taget="_blank" href="/search/mysql/1.htm">mysql</a><a class="tag" taget="_blank" href="/search/%E6%95%B0%E6%8D%AE%E5%AF%BC%E5%87%BA/1.htm">数据导出</a><a class="tag" taget="_blank" href="/search/%E5%8E%BB%E6%8E%89%E7%AC%AC%E4%B8%80%E8%A1%8C/1.htm">去掉第一行</a><a class="tag" taget="_blank" href="/search/%E5%8E%BB%E6%8E%89%E6%A0%87%E9%A2%98/1.htm">去掉标题</a>

<div>当想使用数据库中的某些数据,想将其导入到文件中,而想去掉第一行的标题是可以加上-N参数

如通过下面命令导出数据:

mysql -uuserName -ppasswd -hhost -Pport -Ddatabase -e " select * from tableName" > exportResult.txt

结果为:

studentid</div>

</li>

<li><a href="/article/2560.htm"

title="phpexcel导出excel表简单入门示例" target="_blank">phpexcel导出excel表简单入门示例</a>

<span class="text-muted">dcj3sjt126com</span>

<a class="tag" taget="_blank" href="/search/PHP/1.htm">PHP</a><a class="tag" taget="_blank" href="/search/Excel/1.htm">Excel</a><a class="tag" taget="_blank" href="/search/phpexcel/1.htm">phpexcel</a>

<div>先下载PHPEXCEL类文件,放在class目录下面,然后新建一个index.php文件,内容如下

<?php

error_reporting(E_ALL);

ini_set('display_errors', TRUE);

ini_set('display_startup_errors', TRUE);

if (PHP_SAPI == 'cli')

die('</div>

</li>

<li><a href="/article/2687.htm"

title="爱情格言" target="_blank">爱情格言</a>

<span class="text-muted">dcj3sjt126com</span>

<a class="tag" taget="_blank" href="/search/%E6%A0%BC%E8%A8%80/1.htm">格言</a>

<div> 1) I love you not because of who you are, but because of who I am when I am with you. 我爱你,不是因为你是一个怎样的人,而是因为我喜欢与你在一起时的感觉。 2) No man or woman is worth your tears, and the one who is, won‘t</div>

</li>

<li><a href="/article/2814.htm"

title="转 Activity 详解——Activity文档翻译" target="_blank">转 Activity 详解——Activity文档翻译</a>

<span class="text-muted">e200702084</span>

<a class="tag" taget="_blank" href="/search/android/1.htm">android</a><a class="tag" taget="_blank" href="/search/UI/1.htm">UI</a><a class="tag" taget="_blank" href="/search/sqlite/1.htm">sqlite</a><a class="tag" taget="_blank" href="/search/%E9%85%8D%E7%BD%AE%E7%AE%A1%E7%90%86/1.htm">配置管理</a><a class="tag" taget="_blank" href="/search/%E7%BD%91%E7%BB%9C%E5%BA%94%E7%94%A8/1.htm">网络应用</a>

<div>activity 展现在用户面前的经常是全屏窗口,你也可以将 activity 作为浮动窗口来使用(使用设置了 windowIsFloating 的主题),或者嵌入到其他的 activity (使用 ActivityGroup )中。 当用户离开 activity 时你可以在 onPause() 进行相应的操作 。更重要的是,用户做的任何改变都应该在该点上提交 ( 经常提交到 ContentPro</div>

</li>

<li><a href="/article/2941.htm"

title="win7安装MongoDB服务" target="_blank">win7安装MongoDB服务</a>

<span class="text-muted">geeksun</span>

<a class="tag" taget="_blank" href="/search/mongodb/1.htm">mongodb</a>

<div>1. 下载MongoDB的windows版本:mongodb-win32-x86_64-2008plus-ssl-3.0.4.zip,Linux版本也在这里下载,下载地址: http://www.mongodb.org/downloads

2. 解压MongoDB在D:\server\mongodb, 在D:\server\mongodb下创建d</div>

</li>

<li><a href="/article/3068.htm"

title="Javascript魔法方法:__defineGetter__,__defineSetter__" target="_blank">Javascript魔法方法:__defineGetter__,__defineSetter__</a>

<span class="text-muted">hongtoushizi</span>

<a class="tag" taget="_blank" href="/search/js/1.htm">js</a>

<div>转载自: http://www.blackglory.me/javascript-magic-method-definegetter-definesetter/

在javascript的类中,可以用defineGetter和defineSetter_控制成员变量的Get和Set行为

例如,在一个图书类中,我们自动为Book加上书名符号:

function Book(name){ </div>

</li>

<li><a href="/article/3195.htm"

title="错误的日期格式可能导致走nginx proxy cache时不能进行304响应" target="_blank">错误的日期格式可能导致走nginx proxy cache时不能进行304响应</a>

<span class="text-muted">jinnianshilongnian</span>

<a class="tag" taget="_blank" href="/search/cache/1.htm">cache</a>

<div>昨天在整合某些系统的nginx配置时,出现了当使用nginx cache时无法返回304响应的情况,出问题的响应头: Content-Type:text/html; charset=gb2312 Date:Mon, 05 Jan 2015 01:58:05 GMT Expires:Mon , 05 Jan 15 02:03:00 GMT Last-Modified:Mon, 05</div>

</li>

<li><a href="/article/3322.htm"

title="数据源架构模式之行数据入口" target="_blank">数据源架构模式之行数据入口</a>

<span class="text-muted">home198979</span>

<a class="tag" taget="_blank" href="/search/PHP/1.htm">PHP</a><a class="tag" taget="_blank" href="/search/%E6%9E%B6%E6%9E%84/1.htm">架构</a><a class="tag" taget="_blank" href="/search/%E8%A1%8C%E6%95%B0%E6%8D%AE%E5%85%A5%E5%8F%A3/1.htm">行数据入口</a>

<div>注:看不懂的请勿踩,此文章非针对java,java爱好者可直接略过。

一、概念

行数据入口(Row Data Gateway):充当数据源中单条记录入口的对象,每行一个实例。

二、简单实现行数据入口

为了方便理解,还是先简单实现:

<?php

/**

* 行数据入口类

*/

class OrderGateway {

/*定义元数</div>

</li>

<li><a href="/article/3449.htm"

title="Linux各个目录的作用及内容" target="_blank">Linux各个目录的作用及内容</a>

<span class="text-muted">pda158</span>

<a class="tag" taget="_blank" href="/search/linux/1.htm">linux</a><a class="tag" taget="_blank" href="/search/%E8%84%9A%E6%9C%AC/1.htm">脚本</a>

<div>1)根目录“/” 根目录位于目录结构的最顶层,用斜线(/)表示,类似于

Windows

操作系统的“C:\“,包含Fedora操作系统中所有的目录和文件。 2)/bin /bin 目录又称为二进制目录,包含了那些供系统管理员和普通用户使用的重要

linux命令的二进制映像。该目录存放的内容包括各种可执行文件,还有某些可执行文件的符号连接。常用的命令有:cp、d</div>

</li>

<li><a href="/article/3576.htm"

title="ubuntu12.04上编译openjdk7" target="_blank">ubuntu12.04上编译openjdk7</a>

<span class="text-muted">ol_beta</span>

<a class="tag" taget="_blank" href="/search/HotSpot/1.htm">HotSpot</a><a class="tag" taget="_blank" href="/search/jvm/1.htm">jvm</a><a class="tag" taget="_blank" href="/search/jdk/1.htm">jdk</a><a class="tag" taget="_blank" href="/search/OpenJDK/1.htm">OpenJDK</a>

<div>获取源码

从openjdk代码仓库获取(比较慢)

安装mercurial Mercurial是一个版本管理工具。 sudo apt-get install mercurial

将以下内容添加到$HOME/.hgrc文件中,如果没有则自己创建一个: [extensions] forest=/home/lichengwu/hgforest-crew/forest.py fe</div>

</li>

<li><a href="/article/3703.htm"

title="将数据库字段转换成设计文档所需的字段" target="_blank">将数据库字段转换成设计文档所需的字段</a>

<span class="text-muted">vipbooks</span>

<a class="tag" taget="_blank" href="/search/%E8%AE%BE%E8%AE%A1%E6%A8%A1%E5%BC%8F/1.htm">设计模式</a><a class="tag" taget="_blank" href="/search/%E5%B7%A5%E4%BD%9C/1.htm">工作</a><a class="tag" taget="_blank" href="/search/%E6%AD%A3%E5%88%99%E8%A1%A8%E8%BE%BE%E5%BC%8F/1.htm">正则表达式</a>

<div> 哈哈,出差这么久终于回来了,回家的感觉真好!

PowerDesigner的物理数据库一出来,设计文档中要改的字段就多得不计其数,如果要把PowerDesigner中的字段一个个Copy到设计文档中,那将会是一件非常痛苦的事情。</div>

</li>

</ul>

</div>

</div>

</div>

<div>

<div class="container">

<div class="indexes">

<strong>按字母分类:</strong>

<a href="/tags/A/1.htm" target="_blank">A</a><a href="/tags/B/1.htm" target="_blank">B</a><a href="/tags/C/1.htm" target="_blank">C</a><a

href="/tags/D/1.htm" target="_blank">D</a><a href="/tags/E/1.htm" target="_blank">E</a><a href="/tags/F/1.htm" target="_blank">F</a><a

href="/tags/G/1.htm" target="_blank">G</a><a href="/tags/H/1.htm" target="_blank">H</a><a href="/tags/I/1.htm" target="_blank">I</a><a

href="/tags/J/1.htm" target="_blank">J</a><a href="/tags/K/1.htm" target="_blank">K</a><a href="/tags/L/1.htm" target="_blank">L</a><a

href="/tags/M/1.htm" target="_blank">M</a><a href="/tags/N/1.htm" target="_blank">N</a><a href="/tags/O/1.htm" target="_blank">O</a><a

href="/tags/P/1.htm" target="_blank">P</a><a href="/tags/Q/1.htm" target="_blank">Q</a><a href="/tags/R/1.htm" target="_blank">R</a><a

href="/tags/S/1.htm" target="_blank">S</a><a href="/tags/T/1.htm" target="_blank">T</a><a href="/tags/U/1.htm" target="_blank">U</a><a

href="/tags/V/1.htm" target="_blank">V</a><a href="/tags/W/1.htm" target="_blank">W</a><a href="/tags/X/1.htm" target="_blank">X</a><a

href="/tags/Y/1.htm" target="_blank">Y</a><a href="/tags/Z/1.htm" target="_blank">Z</a><a href="/tags/0/1.htm" target="_blank">其他</a>

</div>

</div>

</div>

<footer id="footer" class="mb30 mt30">

<div class="container">

<div class="footBglm">

<a target="_blank" href="/">首页</a> -

<a target="_blank" href="/custom/about.htm">关于我们</a> -

<a target="_blank" href="/search/Java/1.htm">站内搜索</a> -

<a target="_blank" href="/sitemap.txt">Sitemap</a> -

<a target="_blank" href="/custom/delete.htm">侵权投诉</a>

</div>

<div class="copyright">版权所有 IT知识库 CopyRight © 2000-2050 E-COM-NET.COM , All Rights Reserved.

<!-- <a href="https://beian.miit.gov.cn/" rel="nofollow" target="_blank">京ICP备09083238号</a><br>-->

</div>

</div>

</footer>

<!-- 代码高亮 -->

<script type="text/javascript" src="/static/syntaxhighlighter/scripts/shCore.js"></script>

<script type="text/javascript" src="/static/syntaxhighlighter/scripts/shLegacy.js"></script>

<script type="text/javascript" src="/static/syntaxhighlighter/scripts/shAutoloader.js"></script>

<link type="text/css" rel="stylesheet" href="/static/syntaxhighlighter/styles/shCoreDefault.css"/>

<script type="text/javascript" src="/static/syntaxhighlighter/src/my_start_1.js"></script>

</body>

</html>