Hadoop完全分布式配置步骤

1.克隆三台虚拟机

例:

hadoop101 NN DN NM

hadoop102 RM DN NM

hadoop103 2NN DN NM

分析:

hadoop101里配置namenode

hadoop102里配置resourcemanager

hadoop103里配置SecondaryNameNode

DN(datanode) NM(namemanager) 混搭,其余的都分布在不同的服务器上,有多少个DN就有多少个NM,所以每个服务器上都有一个DN和一个NM

1.关闭防火墙

chkconfig iptables off

2.修改静态ip

/etc/sysconfig/network-scripts/ifcfg-eth0

修改内容如下

DEVICE=eth0

TYPE=Ethernet

ONBOOT=yes

NM_CONTROLLED=yes

BOOTPROTO=static

#IP地址

IPADDR=192.168.1.102

#网关

GATEWAY=192.168.1.2

#域名解析器

DNS1=192.168.1.2

NAME=eth0

3.修改主机名称

/etc/sysconfig/network

4.创建集群 vim /etc/hosts

内容如下例:

| ip地址 | 主机名 |

|---|---|

| 192.168.1.100 | hadoop100 |

| 192.168.1.101 | hadoop101 |

| 192.168.1.102 | hadoop102 |

| 192.168.1.103 | hadoop103 |

| 192.168.1.104 | hadoop104 |

| 192.168.1.105 | hadoop105 |

5.修改网关

vim /etc/udev/ rules. d/70- persistent-net. rules

# This file was automatically generated by the /lib/udev/write_net_rules

# program, run by the persistent-net-generator.rules rules file.

#

# You can modify it, as long as you keep each rule on a single

# line, and change only the value of the NAME= key.

# PCI device 0x8086:0x100f (e1000)

#SUBSYSTEM=="net", ACTION=="add", DRIVERS=="?*",

#这一行删除或注释

ATTR{address}=="00:0c:29:ad:ce:a7", ATTR{type}=="1", KERNEL=="eth*", NAME="eth0"

# PCI device 0x8086:0x100f (e1000)

#这一行把**"eth1"**修改为**"eth0"**

SUBSYSTEM=="net", ACTION=="add", DRIVERS=="?*", ATTR{address}=="00:0c:29:c7:05:81", ATTR{type}=="1", KERNEL=="eth*", NAME="eth1"

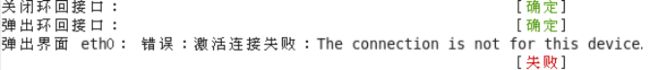

6.重启network

service network restart

如果报错,reboot,重启虚拟机

2.上传hadoop,jdk. jar包并解压

1.创建一个SFTP类型的远程连接

/opt/ 文件夹下 software/ 文件夹 存放 jar 包

/opt/ 文件夹下 module/ 文件夹 存放解压的 jar 包

2.进入software文件夹下 cd /opt/software/

3.把hadoop jar包,jdk jar包拖进来

4.在创建的不是SFTP类型的远程连接上把jar包解压到module包下

tar -zxvf hadoop… -C /opt/module/

tar -zxvf jdk… -C /opt/module/

修改文件夹权限

chown -R 用户名:用户密码 文件夹名

3.配置

1.配置环境变量 /etc/profile(根目录下的)

配置内容如下

#JAVA_HOME:

export JAVA_HOME=/opt/module/jdk1.8.0_144

export PATH=$PATH:$JAVA_HOME/bin

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-2.7.2

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

--------------------------------------------------------- 以下是

[jinghang@hadoop101 hadoop-2.7.2] etc/hadoop/ 目录下的配置

2.配置:hadoop-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144

3.配置 yarn-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144

4.配置mapred-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144

5.配置core-site.xml

fs.defaultFS

hdfs://hadoop101:9000

hadoop.tmp.dir

/opt/module/hadoop-2.7.2/data/tmp

6.配置 yarn-site.xml

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.hostname

hadoop102

7.配置hdfs-site.xml

dfs.replication

3

dfs.namenode.secondary.http-address

hadoop103:50090

7.配置mapred-site.xml

mapreduce.framework.name

yarn

8.配置history – mapred-site.xml

mapreduce.jobhistory.address

hadoop101:10020

mapreduce.jobhistory.webapp.address

hadoop101:19888

9.配置日志 – yarn-site.xml

yarn.log-aggregation-enable

true

yarn.log-aggregation.retain-seconds

604800

3.无密登录

1.生成公钥,私钥

[jinghang@hadoop101 .ssh]$ ssh-keygen -t rsa

然后敲(三个回车),就会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥)

2.将公钥拷贝到要免密登录的目标机器上

[jinghang@hadoop101 .ssh]$ ssh-copy-id hadoop102

[jinghang@hadoop101 .ssh]$ ssh-copy-id hadoop103

[jinghang@hadoop101 .ssh]$ ssh-copy-id hadoop104

注意:

还需要在hadoop101上采用root账号,配置一下无密登录到hadoop102、hadoop102、hadoop103;

还需要在hadoop102上采用jinghang账号配置一下无密登录到hadoop102、hadoop102、hadoop1服务器上

3. .ssh文件夹下(~/.ssh)的文件功能解释

| known_hosts | 记录ssh访问过计算机的公钥(public key) |

| id_rsa | 生成的私钥 |

| id_rsa.pub | 生成的公钥 |

| authorized_keys | 存放授权过得无密登录服务器公钥 |

6.测试无密登录

[jinghang@hadoop101 .ssh]$ ssh hadoop102

5.设置群起节点

vim /opt/module/hadoop-2.7.2/etc/hadoop/slaves

内容(主机名)

hadoop101

hadoop102

hadoop103

5.scp — rsync

1. scp(secure copy)安全拷贝

scp -r $pdir/$fname $user@hadoop$host:$pdir/$fname

命令 递归 要拷贝的文件路径/名称 目的用户@主机:目的路径/名称

案例实操

(a)将hadoop101中/etc/profile文件拷贝到hadoop102的/etc/profile上。

[jinghang@hadoop101 ~]$ sudo scp /etc/profile root@hadoop102:/etc/profile

(b)在hadoop101上操作将hadoop101中/opt/module目录下的软件拷贝到hadoop102上。

[jinghang@hadoop101 opt]$ scp -r /opt/module jinghang@hadoop102:/opt/module

(c)在hadoop101上,将hadoop101服务器上的/home/jnghang/.ssh目录下的软件拷贝到hadoop103上。

[jinghang@hadoop101 opt]$sudo scp -r /home/jinghang/.ssh/ jinghang@hadoop103:/home/jinghang/.ssh

2. rsync 远程同步工具

rsync -av $pdir/$fname $user@hadoop$host:$pdir/$fname

命令 选项参数 要拷贝的文件路径/名称 目的用户@主机:目的路径/名称

选项参数说明

| 选项 | 功能 |

|---|---|

| -a | 归档拷贝 |

| -v | 显示复制过程 |

案例实操

(a)把hadoop101机器上的/opt/software目录同步到hadoop102服务器的root用户下的/opt/目录

[jinghang@hadoop101 opt]$ rsync -av /opt/software/ hadoop102:/opt/software

== rsync和scp区别:用rsync做文件的复制要比scp的速度快,rsync只对差异文件做更新。scp是把所有文件都复制过去。==

6.格式化

[jinghang@hadoop102 hadoop-2.7.2]$ hdfs namenode -format

复制到其余的节点后 jps查询不到节点,使用

source /etc/profile

启动

7.开启节点

1.HDFS

群起:start-dfs.sh

群关:stop-dfs.sh

2.YARN

群起:start-yarn.sh

群关:stop-yarn.sh

3.历史服务器

开启 :mr-jobhistory-daemon.sh start historyserver

关闭 :mr-jobhistory-daemon.sh stop historyserver

8.启动web

HDFS:192.168.1.101:50070

YARN : 192.168.1.102:8088

9.测试

1.将测试文件内容上传到文件系统上

[jinghang@hadoop101 hadoop-2.7.2]$bin/hdfs dfs -put wcinput/wc.input

/user/jinghang/input/

2.运行MapReduce程序

[jinghang@hadoop101 hadoop-2.7.2]$ bin/hadoop jar

share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount /user/jinghang/input/ /user/jinghang/output