爬虫项目实战三:爬取抖音短视频

爬取抖音网页版短视频

- 目标

- 项目准备

- 网站分析

- 反爬分析

- 每一页的链接分析

- 代码实现

- 效果显示

目标

爬取抖音短视频,批量下载到本地。

项目准备

软件:Pycharm

第三方库:requests,fake_useragent,re

网站地址:http://douyin.bm8.com.cn/d_1.html

网站分析

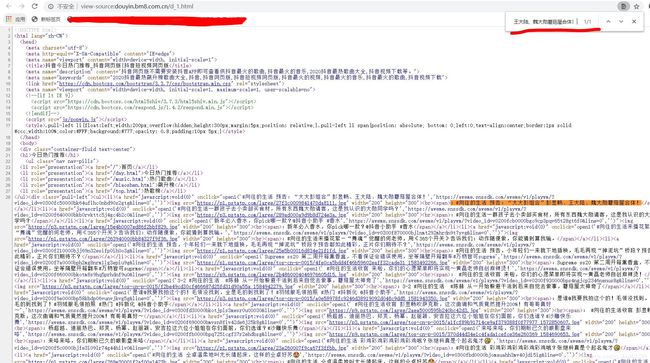

首先判断是静态加载或者动态加载。

鼠标向下拉动,发现滑到底部出现页码之类的,初步判定为静态加载。

Ctrl+U查看源代码,Ctrl+F调出搜索框,输入一些网页上出现的文字。

可以找到,最终判定为静态加载类型。

反爬分析

同一个ip地址去多次访问会面临被封掉的风险,这里采用fake_useragent,产生随机的User-Agent请求头进行访问。

每一页的链接分析

第一页链接:http://douyin.bm8.com.cn/d_1.html

第二页链接:http://douyin.bm8.com.cn/d_2.html

第三页链接:http://douyin.bm8.com.cn/d_3.html

可以发现规律,就是每页的数字在变化。

代码实现

1.导入相对应的第三方库,定义一个class类继承object,定义init方法继承self,主函数main继承self。

import requests

from fake_useragent import UserAgent

from lxml import etree

class douyin(object):

def __init__(self):

self.url = 'http://douyin.bm8.com.cn/d_{}.html'

ua = UserAgent(verify_ssl=False)

#随机产生user-agent

for i in range(1, 100):

self.headers = {

'User-Agent': ua.random

}

def mian(self):

pass

if __name__ == '__main__':

spider = douyin()

spider.main()

2.发送请求,获取网页。

def get_html(self,url):

response=requests.get(url,headers=self.headers)

html=response.content.decode('utf-8')

return html

3.解析网页,获取视频链接,下载到本地。

def parse_html(self,html):

links=re.compile('open1\(\'(.*?)\',\'(.*?)\',\'\'\)').findall(html)

for link in links:

print('正在下载:'+link[0])

host=link[1]

r=requests.get(host,headers=self.headers)

filename=link[0]

with open('F:/pycharm文件/document/'+filename+'.mp4','wb')as f:

f.write(r.content)

说明一下。

open1(’#向往的生活 预告:“大大彭组合”彭昱畅、王大陆、魏大勋蘑菇屋合体!’,‘https://aweme.snssdk.com/aweme/v1/playwm/?video_id=v0300fc50000bk64uflhc0nbd90s2gtg&line=0’,’’)

正则表达式提取

links=re.compile('open1\(\'(.*?)\',\'(.*?)\',\'\'\)').findall(html)

4.获取多页

def main(self):

start = int(input('输入开始:'))

end = int(input('输入结束页:'))

for page in range(start, end + 1):

print('第%s页' % page)

url = self.url.format(page)

html = self.get_html(url)

self.parse_html(html)

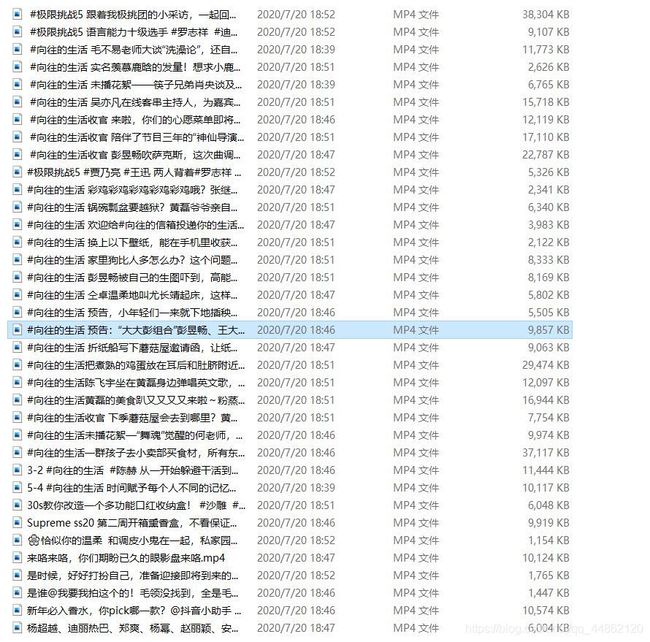

效果显示

完整代码如下:

import requests

from fake_useragent import UserAgent

import re

class douyin(object):

def __init__(self):

self.url='http://douyin.bm8.com.cn/d_{}.html'

ua = UserAgent(verify_ssl=False)

for i in range(1, 100):

self.headers = {

'User-Agent': ua.random

}

def get_html(self,url):

response=requests.get(url,headers=self.headers)

html=response.content.decode('utf-8')

return html

def parse_html(self,html):

links=re.compile('open1\(\'(.*?)\',\'(.*?)\',\'\'\)').findall(html)

for link in links:

print('正在下载:'+link[0])

host=link[1]

r=requests.get(host,headers=self.headers)

filename=link[0]

with open('F:/pycharm文件/document/'+filename+'.mp4','wb')as f:

f.write(r.content)

def main(self):

start = int(input('输入开始:'))

end = int(input('输入结束页:'))

for page in range(start, end + 1):

print('第%s页' % page)

url = self.url.format(page)

html = self.get_html(url)

self.parse_html(html)

if __name__ == '__main__':

spider = douyin()

spider.main()

声明:仅作为自己学习参考使用。