Django --haystack实现全文搜索

搜索

搜索可以使用最原始的like的方式进行搜索。当然这种搜索方式对于些小的数据是非常合适的。但是随着数据越来越大。这时候我们就需要使用搜索引擎了。搜索引擎会将所有要搜索的数据使用算法做个素引,以后搜索的时候就只需要根据这个索引脚找到相应的数据。搜索引擎做索引的过程会比较慢,但是一旦索引建立完成,那么以后再搜索的时候就会很快了。

django-haystack插件:

这个插件是专门始django 提供搜索功能的。django-haystack 提供了一个搜索的接口,底层可以根据自己的需求更换搜索引擎。他

其实有点类似于Django 中的ORM插件,提供了一个操作数据库的接口,但是底层具体使用哪个数据库是可以自己设置的。安装方式非常简单,通过pip install djange-haystack即可安装。

搜索引擎:

django-haystack支持的搜索引擎有Solar、Elasticsearch 、Whoosh 、Xapian 等。Whoosh 是基于纯Python 的搜索引擎,检索速度快,集成方便。这里我们就选择Whoosh来作为haystack 的搜索引擎。安装方式同样也是通过pip安装的: pip install whoosh

集成步骤:

(1)在项目中安装 djando-haystack

添加进INSTALLED_APPS = {

'haystack',

}

(2)设置搜索引擎

在settings.py中添加以下配置

HAYSTACK_CONNECTIONS = {

'default':{

# 设置haystack的搜索引擎

'ENGINE': 'haystack.backends.whoosh_backend.WhooshEngine',

# 设置索引文件的位置

'PATH': os.path.join(BASE_DIR, 'whoosh_index')

}

}

(3)创建索引类

在模型所属的app下创建一个search_indexes.py文件,然后创建索引类。比如要给News类创建索引:

from haystack import indexes

from .models import News

class NewsIndex(indexes.SearchIndex, indexes.Indexable):

text = indexes.CharField(document=True, use_template=True)

def get_model(self):

return News

def index_queryset(self, using=None):

return self.get_model().objects.all()

(4)添加url映射

在主urls.py中

urlpatterns = [

path('search/', include('haystack.urls')),

]

(5)添加模板

在templates文件夹下创建一下目录:

templates->search->indexes->news(app名称)->news(模型名称)_text.txt

然后再news_text.txt中添加需要被索引的字段:

{{ object.title }}

{{ object.content }}

接着再templates文件夹下创建search.html模板文件,haystack会自动在templates文件夹下寻找这个模板文件进行渲染,并且会给这个模板文件传入 page, paginator, query等参数。其中page和paginator分别是django内置的Page类和Paginator类的对象,query是查询的关键字,我们可以通过page.object_list获取到result对象,再通过result.object 获取到QuerySet对象

{% for result in page_object_list %}

{% with result.object as news %}

{% endfor %}

(6)创建索引

执行python manage.py rebuild_index

使用中文查询(以上操作除过设置搜索引擎以外,全部相同)

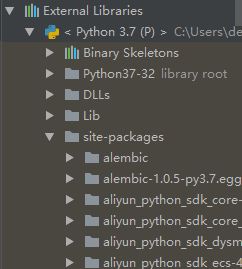

在site-packages文件夹下 找到whoosh_backend.py文件, 将该文件内容全部复制

在news 的app文件中创建一个whoosh_cn_backend.py的文件,将刚才复制的内容粘贴到该文件中,并将以下代码粘贴到该文件中:

import jieba

from whoosh.analysis import Tokenizer, Token

class ChineseTokenizer(Tokenizer):

def __call__(self, value, positions=True, chars=True, keeporiginal=False, removestops=True, start_pos=0, start_char=0, mode='', **kwargs):

t = Token(positions, chars, removestops=removestops, mode=mode, **kwargs)

seglist = jieba.cut(value, cut_all=True)

for w in seglist:

t.original = t.text = w

t.boost = 1.0

if positions:

t.pos = start_pos + value.find(w)

if chars:

t.startchar = start_char + value.find(w)

t.endchar = start_char + value.find(w) + len(w)

yield t

def ChineseAnalyzer():

return ChineseTokenizer()再将第186行的:schema_fields[field_class.index_fieldname] = TEXT(stored=True, analyzer=StemmingAnalyzer(), field_boost=field_class.boost, sortable=True)

修改为:schema_fields[field_class.index_fieldname] = TEXT(stored=True, analyzer=ChineseAnalyzer(), field_boost=field_class.boost, sortable=True)

settings.py文件中添加:

HAYSTACK_CONNECTIONS = {

'default':{

# 设置haystack的搜索引擎

'ENGINE': 'apps.news.whoosh_cn_backend.WhooshEngine',

# 设置索引文件的位置

'PATH': os.path.join(BASE_DIR, 'whoosh_index')

}

}

#增删改查操作后自动更新索引

HAYSTACK_SIGNAL_PROCESSOR = 'haystack.signals.RealtimeSignalProcessor'