- Python学习笔记-Day05

snape00

Python学习笔记Day_05-构造程序逻辑作者的话学完前面的几个章节后,我觉得有必要在这里带大家做一些练习来巩固之前所学的知识,虽然迄今为止我们学习的内容只是Python的冰山一角,但是这些内容已经足够我们来构建程序中的逻辑。对于编程语言的初学者来说,在学习了Python的核心语言元素(变量、类型、运算符、表达式、分支结构、循环结构等)之后,必须做的一件事情就是尝试用所学知识去解决现实中的问题

- python学习笔记第5节-类和函数

梁鋐俐

我们在前面的学习中学会了一个叫type()的函数,用它来判断变量的类型,变量和它当下存储的数据绑定在一起。例如a=[4,5,6,7]print(type(a))输出a=range(10,20,2)print(type(a))输出a=Trueprint(type(a))输出a={‘a54’:56}print(type(a))输出a={‘a54’,56}print(type(a))输出a=‘tyuio

- Python学习笔记--列表、字典、集合、元组

小黄酥

Pythonpython学习笔记

Python学习笔记43-列表#列表主要是用来存储多个数据.列表是有序的集合list_1=[]#创建一个空的列表list_2=[12,34,56,True,'abc']#创建一个列表#列表的访问,通过下标访问列表中的元素,下标默认从0开始,0表示第一个元素,-1表示最后一个元素list_3=[1,2,3,False,True,'abc']print(list_3[0])#1print(list_3

- python学习笔记08_赋值运算、逻辑运算、表达式、短路原则

flamingocc

python笔记081.赋值运算符num+=1等价于num=num+1num-=1等价于num=num-1num*=1等价于num=num*1num/=1等价于num=num/1num//2等价于num=num//2num%=2等价于num/2的余数num**2等价于num=num*num2.逻辑运算符逻辑运算符包含:not、and、or2.1and的用法:(且、并且)写法:条件1and条件2eg

- Python学习笔记(三):列表的定义、访问及修改

RANDY_Sw

Python入门python

今天学习了有关列表的定义、访问及修改的方法,在此整理一下。列表的定义与访问name_list=['zhangsan','lisi','wangwu']#创建一个列表name_list[0]='xiaobai'#修改列表中的单个元素print(name_list)#遍历的方式打印列表1foriteminname_list:print(item)#遍历的方式打印列表2i=0foriinrange(le

- Python学习笔记36:进阶篇(二十五)pygame的使用之事件监听控制切歌和暂停,继续播放

明月望秋思

学习pythonpygamepython学习

前言基础模块的知识通过这么长时间的学习已经有所了解,更加深入的话需要通过完成各种项目,在这个过程中逐渐学习,成长。我们的下一步目标是完成pythoncrashcourse中的外星人入侵项目,这是一个2D游戏项目。在这之前,我们先简单学习一下pygame模块。私信我发送消息python资料,领取pythoncrashcourse中文版PDF。pygamePygame是一个开源的Python多媒体开发

- python工资条教程_python学习笔记--工资条发放软件

weixin_39873191

python工资条教程

1#!/usr/bin/envpython2#-*-coding:UTF-8-*-3importsmtplib4fromemail.mime.textimportMIMEText5mailto_list=['

[email protected]']#收件人(列表)6mail_host="smtp.163.com"#使用的邮箱的smtp服务器地址,这里是163的smtp地址7mail_user="

[email protected]

- Python学习笔记二(布尔值及类型检查)

StaticKing

Python入门Python

字符串赋值与布尔值及类型检查布尔值(bool)假:False真:Truea1='a'a2='a'print(a1==a2)print(a1!=a2)TrueFalse布尔值也属于整型,True相当于1False相当于0print(True+

- Python学习笔记_第八章:异常

雨住多一横

什么是异常Python用异常对象来表示异常情况,遇到错误后会引发异常。如果异常对象未被处理或捕捉,程序就会用所谓的回溯终止执行按自己的方式出错raise语句使用一个类(Exception及其子类)或者类实例调用raise语句可以引发异常。Python内建异常可以在exceptions模块中找到,可以使用dir列出模块内容>>>dir(exceptions)['ArithmeticError','A

- Python学习笔记之:本地文件的读取

你怎么这么奇怪

Python学习笔记

读取文件#桌面上的第一个txtf=open(r"C:\Users\Administrator\Desktop\test.txt")print(f.read())以test.txt文件为例,该文件存储路径为桌面打印读取文件内容f.read()print(f.readline())读

- python学习笔记五(面向对象实战版)

小满胜 万全

Python学习学习笔记

传送门:python及pycharm安装配置_pycharm和python配置-CSDN博客Python学习笔记(一)-CSDN博客Python学习笔记(二)-CSDN博客Python学习笔记三(面向对象)-CSDN博客Python学习笔记四(面向对象)-CSDN博客前言:在前面两章,我们学习了python的基本概念和一些重要的知识点,由于这个部分非常重要,而代码学习之道最重要的就是自己要动手写代

- Python学习笔记一(基础知识)

小满胜 万全

Python学习学习python

PS:这篇文章是以一个学习者的角度来汇总知识点以及教程,对于想学习Python的入门者也会比较友好,想学习python可以先收藏,我会慢慢持续更新。学艺不精,如有纰漏,敬请指正。需要安装配置python和Pycharm软件可以移步这篇文章,有详细的教程。传送门:python及pycharm安装配置-CSDN博客Python学习笔记(二)-CSDN博客Python学习笔记三(面向对象)-CSDN博客

- Python学习笔记07

正文01

python学习笔记

第十三章,面向对象初识对象生活中数据的组织学校开学,要求学生填写自己的基础信息,一人发一张白纸,让学生自己填我叫林军杰,今年31岁.来自山东省,我是男的,中国人内容混乱改为登记表,打印出来让学生自行填写:姓名林军杰姓别男国籍中国籍贯山东省年龄31整洁明了程序中数据的组织在程序中简单使用变量来记录学生信息student_1={"姓名":"周杰轮","性别":"男","国籍":"中国","籍贯":"台

- Python学习笔记03

正文01

python学习笔记

第五章、Python函数函数介绍函数函数:是组织好的,可重复使用的,用来实现特定功能的代码段name="itheima"length=len(name)print(length)输出结果:7为什么随时都可以使用len()统计长度?因为,len()是Python内置的函数:是提前写好的可以重复使用实现统计长度这一特定功能的代码段我们使用过的:input()、print()、str()、int()等都

- Python学习笔记 —— 文件处理模块

miles-zh

pythonpython

Excel文件openpyxl读/写Excel文件,https://pypi.org/project/openpyxlxlwt创建Excel文件,设置单元格样式,https://pypi.org/project/xlwtxlrd读取Excel文件,https://pypi.org/project/xlrdxlutils修改Excel文件,https://pypi.org/project/xluti

- 【Python学习笔记】Python logging模块的学习

Augenstern K

Pythonpython学习笔记

Pythonlogging模块基础介绍作用与功能基本用法引入模块创建并配置记录器的基本步骤代码演示日志级别日志消息格式用法介绍代码示例日志的输出位置代码示例日志记录的高级功能对日志记录进行过滤和处理在多个模块中使用同一个日志记录器总结当谈到日志记录时,logging库是Python中最常用的工具之一。它提供了许多功能和选项,使开发人员能够灵活地记录和管理应用程序的日志信息。引入logging作为P

- Python学习笔记(1)——环境安装与变量

ThinkerChenYi

python学习笔记Python学习笔记

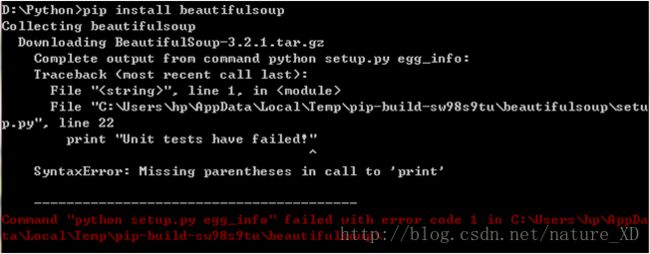

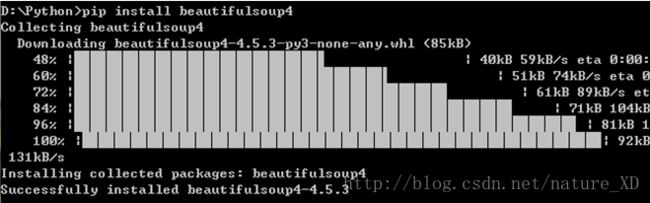

python环境安装-python2还是python3python2只支持到2020年,并且python2和3有不少用法差异。要是刚学完python2不久就发现过时了这就很尴尬了,所以推荐使用python3-安装环境推荐:Anaconda+pychamAnaconda是一个python的科学计算包,python环境,常用模块以及工具都包含在里面,省心省力官网:https://www.anacond

- 2.25python笔记 高阶编程

13351

@[TOC](2.25学堂在线python学习笔记高阶编程)#高阶编程1.利用二分法查找一个字符是否在某个字符串当中基线条件:当s=''时,返回False当len(s)=1且s==char时返回True当len(s)>1且s[mid]>char时,返回isIn(char,s[:mid])否则当s[mid]1:ifs[mid]>char:print(s)returnisIn(char,s[:mid]

- Python学习笔记——逻辑运算符not,and,or

phoebe’

python

运算优先级:not>and>or三个都从左往右解析,区别如下not:返回布尔型(TrueorFalse)>>>not7False>>>not0Trueand:有0(False)则返回0(False),否则返回后一个变量(常数)>>>3and0and10>>>1and2and33>>>Falseand1Falseor:返回第一个不为0(False)的变量(常数)>>>FalseorTrueTrue>

- python学习笔记——三目运算符与逻辑运算符

phily123

python学习笔记python

一、三目运算符python中用ifelse来替代其他编程语言的?:三目运算符,并且用法不同。ifa>b:c=aelse:c=bpython中:c=aifa>belsebc语言中:c=a>b?a:b二、逻辑运算符python中逻辑运算符用andornot:20and10#结果是1020or10#结果是200or10#结果是10not10#结果是Falsenot0#结果是Truec语言中逻辑运算符用&

- Python课后习题第十章

水中小船

'''10-1Python学习笔记:在文本编辑器中新建一个文件,写几句话来总结一下你至此学到的Python知识,其中每一行都以“InPythonyoucan”打头。将这个文件命名为learning_python.txt,并将其存储到为完成本章练习而编写的程序所在的目录中。编写一个程序,它读取这个文件,并将你所写的内容打印三次:第一次打印时读取整个文件;第二次打印时遍历文件对象;第三次打印时将各行存

- python表示乘方的运算符_Python学习笔记Day3 - Python运算符

weixin_39684454

python表示乘方的运算符

1.Python类型转换常用数据类型转换2.Python算术运算符Python算术运算符2.1加法(+)运算符m=10n=97sum1=m+nx=7.2y=15.3sum2=x+yprint("sum1=%d,sum2=%.2f"%(sum1,sum2))运行结果:sum1=107,sum2=22.50拼接字符串当+用于数字时表示加法,但是当+用于字符串时,它还有拼接字符串(将两个字符串连接为一个

- Python学习笔记之os.path.join()

爱叫啥叫啥去

路径拼接os.path.join()函数os.path.join()函数用于路径拼接文件路径os.path.join()函数中可以传入多个路径:a、会从第一个以"/"开头的参数开始拼接,之前的参数全部丢弃b、在上一种情况确保情况下,若出现"./"开头的参数,会从"./"开头的参数的上一个参数开始拼接join()函数语法:‘sep’.join(seq)参数说明:sep:分隔符。可以为空seq:要连接

- python学习笔记--ifelse分支和循环结构用法,实现python猜数字游戏和冒泡排序

大佬Sam

前言分支(if-else)和循环是每种编程语言必定存在的用法,这里记录下python中的分支结构和结构。结合之前学习的变量,类型,运算符,表达式,和分支,循环结构,练习写个猜数字游戏和冒泡排序。正文分支结构if语句的使用分支结构可以使用if、elif和else关键字。所谓关键字就是有特殊含义的单词,像if和else就是专门用于构造分支结构的关键字,很显然你不能够使用它作为变量名(事实上,用作其他的

- 【python学习笔记】:亚马逊的反爬虫机制

姜子牙大侠

pythonpython爬虫开发语言

今天,来学习越过亚马逊的反爬虫机制,爬取想要的商品、评论等等有用信息。反爬虫机制但是,我们想用爬虫来爬取相关的数据信息时像亚马逊、TBao、JD这些大型的购物商城他们为了保护自己的数据信息,都是有一套完善的反爬虫机制的先试试亚马逊的反爬机制我们用不同的几个python爬虫模块,来一步步试探最终,成功越过反爬机制。一、urllib模块代码如下:#-*-coding:utf-8-*-importurl

- python学习笔记之---三种引号的使用

没有用户的名字

python学习笔记python学习笔记

三种引号,单引号’‘,双引号"",三引号’‘’‘’'(三个单引号组合)或者"“”“”"(三个双引号组合)一、一般情况下,三种引号等价print('这个单引号测试')print("这是双引号测试")print("""这是三引号测试""")二、特殊情况1、单引号:字符串中含有单引号时不能使用,需要转义2、双引号:字符串含有双引号的情况不能使用,需要转义错误写法:print("这是"双引号"测试")`正

- python小结

张叁疯_

本周整理了python学习笔记复习旧的,顺便整理新的,笔记分享在了有道云链接如下阿龙的python笔记都是基础知识,希望在今后能成体系,根据案例学python

- python学习笔记------函数

烟雨织轻愁

学习笔记

函数介绍是组织好的,可重复使用的,用来实现特定功能的代码段函数定义def函数名(传入参数):函数体return返回值参数不需要可省略,返回值不需要也可以省略先定义后调用函数的传入参数例如:defadd(x,y):result=x+yprint(f"{x}+{y}的结果是:{result}")在函数定义中,x、y为形参,表示函数声明将要使用两个参数,参数之间使用逗号进行分隔函数调用时,提供的数属于实

- python学习笔记

烟雨织轻愁

学习笔记

字面量整数、浮点数和·现实中写法一致字符串加上双引号即可,例如:"python代码"变量定义方式:变量名=变量的值(无需分号)数据类型print(type("python代码"))即可输出类型名string_type=type("python代码")接收类型名数据类型转换:int(x)、float(x)、str(x)标识符标识符:变量名字、方法的名字、类的名字等等标识符命名只允许数字、英文、中文、

- Python学习笔记 -一到五

赵唯一

Python编程秘籍python开发语言

第一阶段第一章python入门小技巧:上注释使用(ctrl+/)print("")输出的时候是,输出的就是“”内的内容如果是使用变量的话,不加””双引号,才可以输出变量的内容。eg:num=111而使用print("num")所输出的也就是num,调用变量不要加“”而且print是没有结果输出的,只是打印的功能;print("我","是")print可以多个输出内容中间用逗号隔开!!!(需要全部是

- [星球大战]阿纳金的背叛

comsci

本来杰迪圣殿的长老是不同意让阿纳金接受训练的.........

但是由于政治原因,长老会妥协了...这给邪恶的力量带来了机会

所以......现代的地球联邦接受了这个教训...绝对不让某些年轻人进入学院

- 看懂它,你就可以任性的玩耍了!

aijuans

JavaScript

javascript作为前端开发的标配技能,如果不掌握好它的三大特点:1.原型 2.作用域 3. 闭包 ,又怎么可以说你学好了这门语言呢?如果标配的技能都没有撑握好,怎么可以任性的玩耍呢?怎么验证自己学好了以上三个基本点呢,我找到一段不错的代码,稍加改动,如果能够读懂它,那么你就可以任性了。

function jClass(b

- Java常用工具包 Jodd

Kai_Ge

javajodd

Jodd 是一个开源的 Java 工具集, 包含一些实用的工具类和小型框架。简单,却很强大! 写道 Jodd = Tools + IoC + MVC + DB + AOP + TX + JSON + HTML < 1.5 Mb

Jodd 被分成众多模块,按需选择,其中

工具类模块有:

jodd-core &nb

- SpringMvc下载

120153216

springMVC

@RequestMapping(value = WebUrlConstant.DOWNLOAD)

public void download(HttpServletRequest request,HttpServletResponse response,String fileName) {

OutputStream os = null;

InputStream is = null;

- Python 标准异常总结

2002wmj

python

Python标准异常总结

AssertionError 断言语句(assert)失败 AttributeError 尝试访问未知的对象属性 EOFError 用户输入文件末尾标志EOF(Ctrl+d) FloatingPointError 浮点计算错误 GeneratorExit generator.close()方法被调用的时候 ImportError 导入模块失

- SQL函数返回临时表结构的数据用于查询

357029540

SQL Server

这两天在做一个查询的SQL,这个SQL的一个条件是通过游标实现另外两张表查询出一个多条数据,这些数据都是INT类型,然后用IN条件进行查询,并且查询这两张表需要通过外部传入参数才能查询出所需数据,于是想到了用SQL函数返回值,并且也这样做了,由于是返回多条数据,所以把查询出来的INT类型值都拼接为了字符串,这时就遇到问题了,在查询SQL中因为条件是INT值,SQL函数的CAST和CONVERST都

- java 时间格式化 | 比较大小| 时区 个人笔记

7454103

javaeclipsetomcatcMyEclipse

个人总结! 不当之处多多包含!

引用 1.0 如何设置 tomcat 的时区:

位置:(catalina.bat---JAVA_OPTS 下面加上)

set JAVA_OPT

- 时间获取Clander的用法

adminjun

Clander时间

/**

* 得到几天前的时间

* @param d

* @param day

* @return

*/

public static Date getDateBefore(Date d,int day){

Calend

- JVM初探与设置

aijuans

java

JVM是Java Virtual Machine(Java虚拟机)的缩写,JVM是一种用于计算设备的规范,它是一个虚构出来的计算机,是通过在实际的计算机上仿真模拟各种计算机功能来实现的。Java虚拟机包括一套字节码指令集、一组寄存器、一个栈、一个垃圾回收堆和一个存储方法域。 JVM屏蔽了与具体操作系统平台相关的信息,使Java程序只需生成在Java虚拟机上运行的目标代码(字节码),就可以在多种平台

- SQL中ON和WHERE的区别

avords

SQL中ON和WHERE的区别

数据库在通过连接两张或多张表来返回记录时,都会生成一张中间的临时表,然后再将这张临时表返回给用户。 www.2cto.com 在使用left jion时,on和where条件的区别如下: 1、 on条件是在生成临时表时使用的条件,它不管on中的条件是否为真,都会返回左边表中的记录。

- 说说自信

houxinyou

工作生活

自信的来源分为两种,一种是源于实力,一种源于头脑.实力是一个综合的评定,有自身的能力,能利用的资源等.比如我想去月亮上,要身体素质过硬,还要有飞船等等一系列的东西.这些都属于实力的一部分.而头脑不同,只要你头脑够简单就可以了!同样要上月亮上,你想,我一跳,1米,我多跳几下,跳个几年,应该就到了!什么?你说我会往下掉?你笨呀你!找个东西踩一下不就行了吗?

无论工作还

- WEBLOGIC事务超时设置

bijian1013

weblogicjta事务超时

系统中统计数据,由于调用统计过程,执行时间超过了weblogic设置的时间,提示如下错误:

统计数据出错!

原因:The transaction is no longer active - status: 'Rolling Back. [Reason=weblogic.transaction.internal

- 两年已过去,再看该如何快速融入新团队

bingyingao

java互联网融入架构新团队

偶得的空闲,翻到了两年前的帖子

该如何快速融入一个新团队,有所感触,就记下来,为下一个两年后的今天做参考。

时隔两年半之后的今天,再来看当初的这个博客,别有一番滋味。而我已经于今年三月份离开了当初所在的团队,加入另外的一个项目组,2011年的这篇博客之后的时光,我很好的融入了那个团队,而直到现在和同事们关系都特别好。大家在短短一年半的时间离一起经历了一

- 【Spark七十七】Spark分析Nginx和Apache的access.log

bit1129

apache

Spark分析Nginx和Apache的access.log,第一个问题是要对Nginx和Apache的access.log文件进行按行解析,按行解析就的方法是正则表达式:

Nginx的access.log解析正则表达式

val PATTERN = """([^ ]*) ([^ ]*) ([^ ]*) (\\[.*\\]) (\&q

- Erlang patch

bookjovi

erlang

Totally five patchs committed to erlang otp, just small patchs.

IMO, erlang really is a interesting programming language, I really like its concurrency feature.

but the functional programming style

- log4j日志路径中加入日期

bro_feng

javalog4j

要用log4j使用记录日志,日志路径有每日的日期,文件大小5M新增文件。

实现方式

log4j:

<appender name="serviceLog"

class="org.apache.log4j.RollingFileAppender">

<param name="Encoding" v

- 读《研磨设计模式》-代码笔记-桥接模式

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

/**

* 个人觉得关于桥接模式的例子,蜡笔和毛笔这个例子是最贴切的:http://www.cnblogs.com/zhenyulu/articles/67016.html

* 笔和颜色是可分离的,蜡笔把两者耦合在一起了:一支蜡笔只有一种

- windows7下SVN和Eclipse插件安装

chenyu19891124

eclipse插件

今天花了一天时间弄SVN和Eclipse插件的安装,今天弄好了。svn插件和Eclipse整合有两种方式,一种是直接下载插件包,二种是通过Eclipse在线更新。由于之前Eclipse版本和svn插件版本有差别,始终是没装上。最后在网上找到了适合的版本。所用的环境系统:windows7JDK:1.7svn插件包版本:1.8.16Eclipse:3.7.2工具下载地址:Eclipse下在地址:htt

- [转帖]工作流引擎设计思路

comsci

设计模式工作应用服务器workflow企业应用

作为国内的同行,我非常希望在流程设计方面和大家交流,刚发现篇好文(那么好的文章,现在才发现,可惜),关于流程设计的一些原理,个人觉得本文站得高,看得远,比俺的文章有深度,转载如下

=================================================================================

自开博以来不断有朋友来探讨工作流引擎该如何

- Linux 查看内存,CPU及硬盘大小的方法

daizj

linuxcpu内存硬盘大小

一、查看CPU信息的命令

[root@R4 ~]# cat /proc/cpuinfo |grep "model name" && cat /proc/cpuinfo |grep "physical id"

model name : Intel(R) Xeon(R) CPU X5450 @ 3.00GHz

model name :

- linux 踢出在线用户

dongwei_6688

linux

两个步骤:

1.用w命令找到要踢出的用户,比如下面:

[root@localhost ~]# w

18:16:55 up 39 days, 8:27, 3 users, load average: 0.03, 0.03, 0.00

USER TTY FROM LOGIN@ IDLE JCPU PCPU WHAT

- 放手吧,就像不曾拥有过一样

dcj3sjt126com

内容提要:

静悠悠编著的《放手吧就像不曾拥有过一样》集结“全球华语世界最舒缓心灵”的精华故事,触碰生命最深层次的感动,献给全世界亿万读者。《放手吧就像不曾拥有过一样》的作者衷心地祝愿每一位读者都给自己一个重新出发的理由,将那些令你痛苦的、扛起的、背负的,一并都放下吧!把憔悴的面容换做一种清淡的微笑,把沉重的步伐调节成春天五线谱上的音符,让自己踏着轻快的节奏,在人生的海面上悠然漂荡,享受宁静与

- php二进制安全的含义

dcj3sjt126com

PHP

PHP里,有string的概念。

string里,每个字符的大小为byte(与PHP相比,Java的每个字符为Character,是UTF8字符,C语言的每个字符可以在编译时选择)。

byte里,有ASCII代码的字符,例如ABC,123,abc,也有一些特殊字符,例如回车,退格之类的。

特殊字符很多是不能显示的。或者说,他们的显示方式没有标准,例如编码65到哪儿都是字母A,编码97到哪儿都是字符

- Linux下禁用T440s,X240的一体化触摸板(touchpad)

gashero

linuxThinkPad触摸板

自打1月买了Thinkpad T440s就一直很火大,其中最让人恼火的莫过于触摸板。

Thinkpad的经典就包括用了小红点(TrackPoint)。但是小红点只能定位,还是需要鼠标的左右键的。但是自打T440s等开始启用了一体化触摸板,不再有实体的按键了。问题是要是好用也行。

实际使用中,触摸板一堆问题,比如定位有抖动,以及按键时会有飘逸。这就导致了单击经常就

- graph_dfs

hcx2013

Graph

package edu.xidian.graph;

class MyStack {

private final int SIZE = 20;

private int[] st;

private int top;

public MyStack() {

st = new int[SIZE];

top = -1;

}

public void push(i

- Spring4.1新特性——Spring核心部分及其他

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- 配置HiveServer2的安全策略之自定义用户名密码验证

liyonghui160com

具体从网上看

http://doc.mapr.com/display/MapR/Using+HiveServer2#UsingHiveServer2-ConfiguringCustomAuthentication

LDAP Authentication using OpenLDAP

Setting

- 一位30多的程序员生涯经验总结

pda158

编程工作生活咨询

1.客户在接触到产品之后,才会真正明白自己的需求。

这是我在我的第一份工作上面学来的。只有当我们给客户展示产品的时候,他们才会意识到哪些是必须的。给出一个功能性原型设计远远比一张长长的文字表格要好。 2.只要有充足的时间,所有安全防御系统都将失败。

安全防御现如今是全世界都在关注的大课题、大挑战。我们必须时时刻刻积极完善它,因为黑客只要有一次成功,就可以彻底打败你。 3.

- 分布式web服务架构的演变

自由的奴隶

linuxWeb应用服务器互联网

最开始,由于某些想法,于是在互联网上搭建了一个网站,这个时候甚至有可能主机都是租借的,但由于这篇文章我们只关注架构的演变历程,因此就假设这个时候已经是托管了一台主机,并且有一定的带宽了,这个时候由于网站具备了一定的特色,吸引了部分人访问,逐渐你发现系统的压力越来越高,响应速度越来越慢,而这个时候比较明显的是数据库和应用互相影响,应用出问题了,数据库也很容易出现问题,而数据库出问题的时候,应用也容易

- 初探Druid连接池之二——慢SQL日志记录

xingsan_zhang

日志连接池druid慢SQL

由于工作原因,这里先不说连接数据库部分的配置,后面会补上,直接进入慢SQL日志记录。

1.applicationContext.xml中增加如下配置:

<bean abstract="true" id="mysql_database" class="com.alibaba.druid.pool.DruidDataSourc

![]()

![]()

def func(m):

if not m.group(3).startswith("http"):

rtn = "".join([m.group(1), self.domain, m.group(2), m.group(3)])

return rtn

else:

return "".join([m.group(1), m.group(2), m.group(3)])

html = re.compile(pattern).sub(func, html)

html = html_template.format(content=html)

html = html.encode("utf-8")

return html

except Exception as e:

logging.error("解析错误", exc_info=True)

if __name__ == '__main__':

start_url = "http://www.liaoxuefeng.com/wiki/0014316089557264a6b348958f449949df42a6d3a2e542c000"

crawler = LiaoXueFengPythonCrawler("廖雪峰blogs", start_url)

crawler.run()