虚拟机Ubuntu下Hadoop2.6.1的安装和配置(伪分布式)

安装前提:因本人是在虚拟机中安装的Hadoop,故在此主要讲解的是虚拟机中的安装,本文默认已安装好VM和Ubuntu。我使用的是VMware-workstation-full-11.0.0-2305329和ubuntukylin-14.04.2-desktop-i386,其中配置如下图

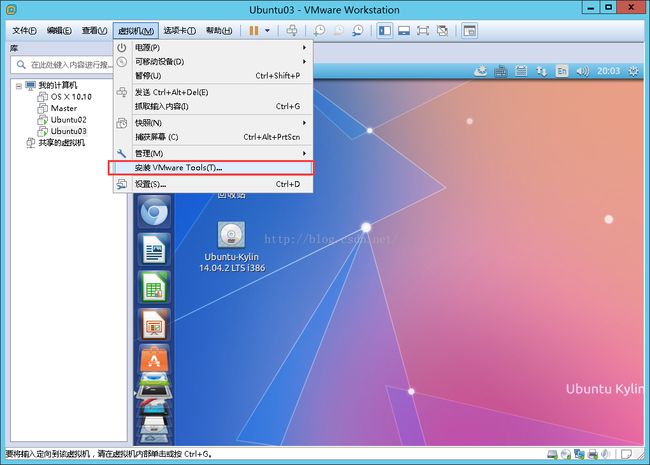

一、安装VMwareTools

安装了VMware Tools后,可以在宿主机和虚拟机之间直接拷贝文件。

先运行命令 sudo apt-get install build-essential然后选择“安装VMware Tools”

就会弹出VMWareTools所在的文件夹,然后右键VMWare Tools.tar.gz,copy to到Home目录下。

输入解压命令:tar -xzvf VMwareTools-9.9.0-2304977.tar.gz

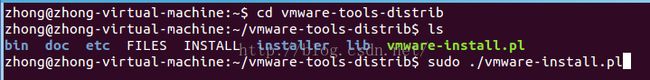

解压完成之后,进入解压目录,进行安装:

cd vmware-tools-distrib

sudo ./vmware-install.pl

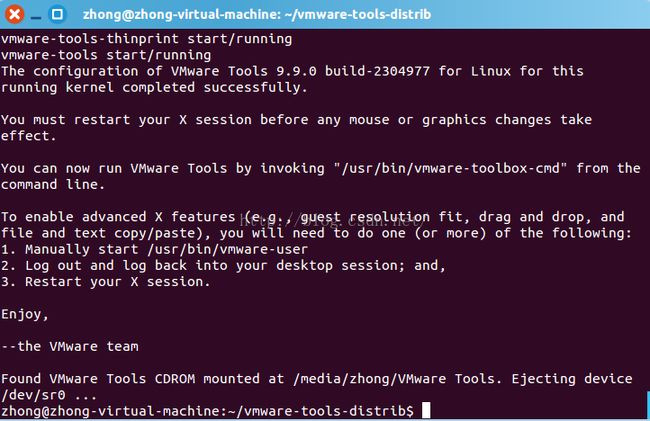

安装过程中根据提示不断回车即可。当出现如下界面时,表示安装成功:

然后再重启客户机。VMwareTools即安装完成。

二、安装JDK

本文使用jdk-6u45-linux-i586.bin(现在用的是>=1.7的版本,这里还没有修改)

先将jdk拖到Ubuntu桌面,再在/usr/lib目录下建立文件夹java,然后拷贝jdk到java目录下,先赋予可执行权限,再直接解压进行安装:

等待安装完之后配置环境变量,输入命令:sudo gedit /etc/profile

把下面代码加入到文件末尾(注意路径里面的JAVA_HOME根据个人安装路径而定):

export JAVA_HOME=/usr/lib/java/jdk1.6.0_45

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH

export CLASSPATH=$CLASSPATH:.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib

保存退出之后输入:source/etc/profile 使更改生效,需要再将安装的jdk设置为系统默认的jdk,依次输入以下命令:

sudo update-alternatives --install "/usr/bin/java" "java" "/usr/lib/java/jdk1.6.0_45/bin/java" 300

sudo update-alternatives --install "/usr/bin/javac" "javac" "/usr/lib/java/jdk1.6.0_45/bin//javac" 300

sudo update-alternatives --config java

sudo update-alternatives --config javac

其中前2条命令的数字300前面的那个路径根据个人jdk安装路径而定。

最后输入java-version,若出现版本信息则安装成功。

三、安装Hadoop并配置

hadoop-2.6.1.tar.gz

先将Hadoop安装文件拖到Ubuntu桌面,再在/usr目录下建立Hadoop文件夹,将hadoop-2.6.1.tar.gz文件直接解压到/usr/hadoop文件夹下。

sudo mkdir/usr/hadoop //新建文件夹

cd /home/zhong/Desktop

sudo tar -zxvf hadoop-2.6.1.tar.gz -C /usr/hadoop //解压

解压之后需要配置环境变量,运行命令: sudo gedit /etc/profile

添加如下内容(注意HADOOPHOME是自己的hadoop-2.6.1.tar.gz文件解压所在路径):

export HADOOPHOME=/usr/hadoop/hadoop-2.6.1

export PATH=$HADOOPHOME/bin:$PATH

然后需要更改hadoop文件夹的所属者,将所属者赋予当前用户,输入下面这个条命令(若不操作,集群运行时会提示权限不够):

sudo chown -hR zhong /usr/hadoop

其中zhong表示当前的用户名,/usr/hadoop/表示要修改的文件夹

接下来需要配置/usr/hadoop/hadoop-2.6.1/etc/hadoop/hadoop-env.sh文件:

在该文件中添加内容:

export JAVA_HOME=/usr/lib/java/jdk1.6.0_45

再接下来需要修改/usr/hadoop/hadoop-2.6.1/etc/hadoop/目录下四个文件

- core-site.xml文件

fs.defaultFS

hdfs://localhost:9000

- hdfs-site.xml文件

dfs.replication

1

- 将mapred-site.xml.template复制一份后改为mapred-site.xml,并修改

mapreduce.framework.name

yarn

- yarn-site.xml文件

四、开启ssh并配置无密码验证登录(连网配置)

依次输入命令

sudo apt-get install ssh

sudo apt-get install rsync

为ssh设置免密码登录和设置权限,依次输入下面几条命令:

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys chmod 700 ~/.ssh chmod 644 ~/.ssh/authorized_keys

完成之后再输入ssh localhost命令,若不需要输入密码的话怎配置ssh免密码登录成功。

若出现以下问题选择“yes”回车即可。再输入ssh localhost验证。

查看ssh服务是否启动命令:sudo ps -e | grep ssh

若结果中有sshd则说明已启动,若没有可输入命令 :sudo service ssh start五、Hadoop开启与测试

现在就可以启动hadoop集群了:

进入Hadoop安装目录/usr/hadop/hadoop-2.6.1命令下,

先输入格式化命令:bin/hdfs namenode -format (中间如有选择,则选“y”并继续)

启动集群命令:sbin/start-yarn.sh

出现如下页面即为成功

可用jps命令查看结果

可用命令:sbin/stop-yarn.sh 关闭集群

验证:浏览器中输入地址http://localhost:8088/可得