论文阅读High-Resolution Image Synthesis and Semantic Manipulation with Conditional GANs

Abstract

我们提出了一种利用条件生成对抗网络从语义标签映射中合成高分辨率真实感图像的新方法。条件GANs已经启用了多种应用程序,但结果往往局限于低分辨率,离现实还很远。在这项工作中,我们生成了2048 1024视觉上吸引人的结果与一个新的对抗损失,以及新的多尺度发生器和鉴别器架构。此外,我们还将框架扩展到具有两个传统特性的交互式视觉操作。首先,我们合并对象实例分割信息,它支持对象操作,例如删除/添加对象和更改对象类别。其次,我们提出了一种方法,在相同的输入条件下生成不同的结果,允许用户交互式地编辑对象外观。人类观点研究表明,我们的方法明显优于现有的方法,提高了深度图像合成和编辑的质量和效果。

1. Introduction

由于必须明确地模拟几何图形、材料和光传输,因此涉及到使用标准图形技术的真实感图像绘制。尽管现有的图形算法擅长这项任务,但构建和编辑虚拟环境是昂贵和耗时的。这是因为我们必须明确地对世界的各个方面进行建模。如果我们能够使用从数据中学习的模型来渲染真实感图像,我们就可以把图形渲染的过程变成一个模型学习和推理的问题。然后,我们可以通过在新数据集上训练模型来简化创建新虚拟世界的过程。我们甚至可以通过允许用户简单地指定整体语义结构,而不是建模几何、材料或照明,来简化定制环境的工作。

在本文中,我们讨论了一种从语义标签地图生成高分辨率图像的新方法。该方法具有广泛的应用前景。例如,我们可以使用它来创建用于训练视觉识别算法的合成训练数据,因为为期望的场景创建语义标签要比生成训练图像容易得多。使用语义分割方法,可以将图像转换为语义标签域,编辑标签域内的对象,再将其转换回图像域。这种方法也为我们提供了新的高级图像编辑工具,例如,向图像中添加对象或更改现有对象的外观。

要从语义标签合成图像,可以使用pix2pix方法,这是一个图像到图像的翻译框架[21],它在条件设置中利用了生成式对抗网络(GANs)[16]。最近,Chen和Koltun[5]提出,对抗性训练可能不稳定,而且在高分辨率图像生成任务中容易失败。相反,他们采用一种改进的感知损失[11,13,22]来合成图像,这些图像分辨率很高,但通常缺乏精细的细节和真实的纹理。

在这里,我们解决了上述方法的两个主要问题:(1)使用GANs[21]生成高分辨率图像的困难和(2)在以前的高分辨率结果[5]中缺乏细节和真实纹理。我们证明,通过一个新的、健壮的对抗学习目标,以及新的多尺度生成器和鉴别器架构,我们可以合成2048 1024分辨率的真实感图像,这比以前的方法计算出的图像更具有视觉吸引力[5,21]。我们首先通过对抗性训练获得结果,不依赖任何手工制作的损失[43]或用于感知损失的预训练网络(如VGGNet[47])[11,22](图7c, 9b)。然后我们证明,在某些情况下,如果有一个训练前的网络可用,添加来自训练前网络[47]的感知损失可以稍微改善结果(图7d, 9c)。在图像质量方面,这两个结果都大大优于以前的工作。

此外,为了支持交互式语义操作,我们从两个方向扩展了我们的方法。首先,我们使用实例级的对象分割信息,它可以在同一类别中分离不同的对象实例。这支持灵活的对象操作,例如添加/删除对象和更改对象类型。其次,我们提出了一种方法,在给定相同的输入标签映射的情况下生成不同的结果,允许用户交互式地编辑相同对象的外观。

我们比较了最先进的视觉合成系统[5,21],结果表明我们的方法在定量评估和人类感知研究方面都优于这些方法。我们还进行了一个消融的研究,关于训练目标和实例级分割信息的重要性。除了语义操作之外,我们还在edge2photo应用程序上测试了我们的方法(图2),这表明我们的方法是通用的

2. Related Work

生成对抗网络: 生成对抗网络(GANs)[16]的目标是通过使生成的样本与自然图像难以区分来对自然图像的分布进行建模。GANs支持多种应用,如图像生成[1,41,60]、表示学习[44]、图像处理[62]、对象检测[32]和视频应用[37,50,52]。已经有人提出了各种由粗到精的[4]方案[9,19,26,55]来无条件地合成更大的图像(如256 256)。从他们的成功中得到启发,我们提出了一种新的从粗到精的生成器和多尺度鉴别器结构,适用于更高分辨率的条件图像生成。

Image-to-image翻译: 许多研究人员利用对抗性学习进行图像到图像的翻译[21],其目标是将输入图像从一个域转换到另一个域,给定输入-输出图像对作为训练数据。相对于L1丢失,这往往会导致图像模糊[21,22],对抗丢失[16]已经成为许多图像到图像任务的普遍选择[10,24,25,31,40,455,53,58,64]。其原因是识别器可以学习一个可训练的损失函数,并自动适应目标域中生成的图像与真实图像之间的差异。例如,最近的pix2pix框架[21]为不同的应用程序使用了图像条件GANs[38],例如将谷歌地图转换为卫星视图,以及从用户草图生成猫。在缺乏训练对的情况下,人们还提出了各种学习图像-图像翻译的方法[2,33,34,46,49,51,54,63]。

最近,Chen和Koltun[5]提出,由于训练不稳定和优化问题,有条件的GANs很难生成高分辨率图像。为了避免这一困难,他们使用了基于知觉损失的直接回归目标[11,13,22],并产生了第一个可以合成2048* 1024张图像的模型。生成的结果是高分辨率的,但往往缺乏精细的细节和现实的纹理。我们的方法是由他们的成功所激励的。我们证明,使用新的目标函数以及新的多尺度生成器和鉴别器,我们不仅在很大程度上稳定了高分辨率图像上条件GANs的训练,而且与Chen和Koltun[5]相比,取得了更好的效果。并排比较清楚地显示了我们的优势(图1、7、8、9)。

深度视觉处理:近年来,深度神经网络在风格转换[13]、inpainting[40]、着色[56]、恢复[14]等各种图像处理任务中取得了良好的效果。然而,这些作品大多缺乏用户界面来调整当前结果或探索输出空间。为了解决这个问题,Zhu等人[62]基于GANs学习的先验知识,开发了一种编辑对象外观的优化方法。最近的作品[21,45,57]也提供了用户界面,用于从颜色和草图等低层次线索创建新的图像。之前的所有工作都报告了低分辨率图像的结果。我们的系统与过去的工作具有相同的精神,但我们专注于对象级的语义编辑,允许用户与整个场景交互并操作图像中的单个对象。因此,用户可以用最少的努力快速创建一个新的场景。我们的界面灵感来自于以前的数据驱动的图形系统[6,23,28]。但是我们的系统允许更灵活的操作,并实时生成高分辨率的结果。

3. Instance-Level Image Synthesis(实例级图像合成)

我们提出了一个条件对抗框架,用于从语义标签地图生成高分辨率真实感照片。我们首先回顾我们的基线模型pix2pix(第3.1节)。然后,我们描述如何使用改进的目标函数和网络设计来提高结果的照相真实感和分辨率(第3.2节)。接下来,我们使用额外的实例级对象语义信息来进一步提高图像质量(第3.3节)。最后,我们介绍了一个实例级的特征嵌入方案,以更好地处理图像合成的多模态性质,使交互式对象编辑成为可能

3.1. The pix2pix Baseline (pix2pix 基准)

pix2pix方法[21]是一个有条件的GAN框架,用于图像到图像的翻译。它由生成器G和鉴别器D组成。对于我们的任务,生成器G的目标是将语义标签映射转化为现实的图像,而鉴别器D的目标是将真实图像与翻译后的图像区分开来。该框架在有监督的环境中运行。即训练数据集为一组对应的图像{(si, xi)},其中si为语义标签映射,xi为对应的自然照片。条件GANs的目标是通过如下的极小极大博弈:minG maxD LGAN(G,D),其中目标函数LGAN(G,D) 1为

![]()

pix2pix方法采用U-Net[42]作为生成器,采用基于patch的全卷积网络[35]作为鉴别器。鉴别器的输入是语义标签映射和对应图像的按通道级联。生成的图像分辨率高达256*256。我们直接测试了使用pix2pix框架生成高分辨率图像,但是我们发现训练不稳定,生成的图像质量不理想。因此,我们将在下一小节中描述如何改进pix2pix框架。

3.2. Improving Photorealism and Resolution(提高真实感和分辨率)

我们使用粗到细的生成器、多尺度鉴别器结构和健壮的对抗学习目标函数来改进pix2pix框架

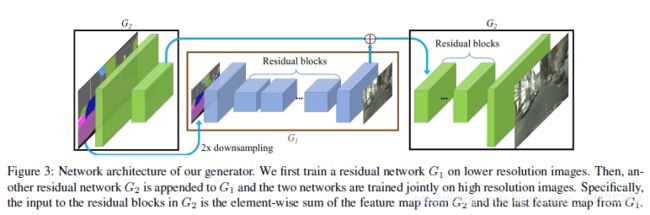

我们将生成器分解为两个子网络:G1和G2。我们称G1为全局生成器网络,称G2为局部增强器网络。然后用图3所示的元组G = {G1,G2}表示生成器。全局生成器操作的分辨率为1024*512,而本地增强器网络输出的图像的分辨率为前一个图像的输出大小的4倍(每个图像维为2)。为了更高的分辨率合成图像,可以利用额外的局部增强器网络。例如,G = {G1,G2}的输出图像分辨率为2048 * 1024,G = {G1,G2,G3}的输出图像分辨率为4096 * 2048。

图3:我们的生成器的网络结构。我们首先在低分辨率图像上训练残差网络G1。然后,将另一个残差网络G2附加到G1中,并对这两个网络进行高分辨率图像的联合训练。具体来说,G2中残差块的输入是G2的特征图和G1的最后一个特征图的元素之和。

我们的全局生成器是建立在Johnson等人提出的[22]架构上的,该架构已被证明在512 * 512图像的神经风格传输方面是成功的。它由三个部分组成:卷积前端G1(F) , 一系列的残差块G1® ,以及一个移位的卷积后端G1(B) ,一个1024×512分辨率的语义标签依次通过3个组件,输出分辨率为1024×512的图像

局部增强器器网络也由3个部分组成:卷积前端G 2(F),一组残块G2® ,以及调换位置的卷积后端G2(B) 。输入标签映射到G2的分辨率是2048 * 1024。与全局生成器网络不同,剩余块G® 2的输入是两个feature map的元素和:G2(F) 的输出feature map和全局生成器网络G 1(B)后端的最后一个feature map。这有助于将全球信息从G1整合到G2。

在训练中,我们首先训练全局生成器,然后按照它们的分辨率顺序训练局部增强器。然后我们一起对所有的网络进行微调。我们使用这个生成器设计来有效地为图像合成任务聚合全局和局部信息。我们注意到在计算机视觉[4]中,这种多分辨率管道是一种非常稳定的实践,双标度[3]通常就足够了。类似的想法,但不同的架构可以在最近的无条件GANs[9,19]和条件图像生成中找到

to do …