目标跟踪数据集整理(一)---TrackingNet

文章目录

- Introduction

- Related Work

- TrackingNet

- Evaluation(三个标准)

- Tracking Benchmark

TrackingNet(A Large-Scale Dataset and benchmark for Object Tracking in the Wild) 2018 ECCV

Download the dataset using the toolkit https://github.com/SilvioGiancola/TrackingNet-devkit.

这个数据集采用一种方法将现有的大规模的目标检测的数据集利用到目标跟踪上(YouTubeBB稀疏标注)。也就是说,是视频目标检测YT-BB的子集,大约1.1T,30000左右个视频,我最开始接触的是imageNet vid2015(密集标注),大约100G,有5000左右个视频,那时候就觉得好大,现在比较起来真的是。。。

Introduction

We provide more than 30K videos with more than 14 milliondense bounding box annotations.

In addition, we introduce a new benchmark composed of 500 novel videos, modeled with a distribution similar to our training dataset.(evaluating more than 20 trackers)

(i)尽管目标跟踪取得了相当大的成功,但它仍然是一个挑战。当前的跟踪器在已经建立的数据集,如OTB、VOT基准上表现的很好,然而,这些数据集大部分是相对小的,并且不能完全代表在野外跟踪目标所遇到的挑战。

(ii)目前基于深度的跟踪器经常受限,一般使用目标分类的预训练模型或者使用目标检测的数据集训练,如ImageNet Videos,或者使用小型的数据集来训练,这些都是一些限制因素。

(iii)因为经典的跟踪器依赖手工特征并且因为存在的跟踪数据集小,当前用于训练和测试的数据之间并没有明确的区分。

基于这些,本文提出了TrackingNet数据集,它有以下优势:

(1)大规模的训练集使得专门针对跟踪的深度设计的发展成为可能

(2)目标跟踪数据集的特殊性使得新的结构更关注连续帧之间的时间上下文信息。当前大规模的目标检测数据集没有及时提供密集标注的数据,也就是并不是每一帧都做标注

(3)TrackingNet通过在YouTube视频上采样来表示真实世界的场景

因此,TrackingNet视频包含了丰富的目标类别的分布,并且我们强制在训练和测试之间共享这些类别。最后我们在一个具有目标类别和运动的相似分布的隔离的测试集上进行评估跟踪器的性能。

贡献:

TrackingNet是针对目标跟踪的第一个大规模的数据集。我们分析了其特征、属性、和独特性,当和其他数据集比起来时。另外我们还提供不同的技术从粗糙的标注生成密集的标注。

Related Work

multi-object tracking: object detection algorithms

single-object tracking: tracking-by-detection(model representation+object seach)

Correlation Filter Trackers

The main reason behind the impressive performance of CF trackers lies in the approximate dense sampling achieved by circulantly shifting the target patch samples.Also, the remarkable runtime performance is achieved by efficiently solving the underlying ridge regression problem in the Fourier domain.

Deep Trackers

讲了三个代表性的方法,MDNet,SIamfc,另一个没有读过,尴尬(Visual tracking with fully convolutional

networks.)提出了siamfc的准确性很高的依赖于训练数据集所捕获的外观特征,所以本文提出的数据集对这些方法是有用的。对于其有用性,论文做了相关实验,只用了1/12的视频来fine-tune就有一定的提升,将SiameFC算法在该数据集上进行训练,在OTB100上得到的测试结果相对于之前提升了1.6个百分点

Object Tracking Datasets

VIVID: an early attempt to build a tracking dataset for surveillance purposes

NfS: provides a set of 100 videos with high framerate, in an attempt to focus on fast motion.

UAV123/UAV20L: gather another application-specific collection of 123 videos and 20 long videos captured from a UAV or generated from a flight simulator.

NUS PRO: gathers an application-specific collection of 365 videos for people and rigid object tracking

目标检测的数据集,像ImageNet Video or YoutubeBoundingBoxes,这些数据集提供目标检测的bbox,相对稀疏或者低的帧率,因此缺乏目标动态的运动信息

TrackingNet

收集了30643个视频片段,平均时长为16.6s, 1443,1266帧,分为测试集和训练集两部分,

从Youtube-BoundingBoxes(是一个针对目标检测的大规模数据集,大约有38000个视频段,以每秒标注,这些视频是从Y YouTube直接收集的)仔细挑选了30132个训练视频,分为12个训练子集,每一个包含2511个视频,每个视频大约400多帧(short-term tracking)。21种目标类别。为了跟踪的需要,我们移除了缺乏运动的目标类,尤其是盆栽和厕所,并把人分为详细的7个类别。为了确保跟踪的高质量。我们基于属性条件从视频中挑选出90%视频。首先,我们避免了小视频片段,短于15s;第二,我们仅仅考虑了覆盖不到50%帧的边框;最后,我们保存了在bbox间至少包含合理运动的片段。那如何标注呢?

Coarse annotations are provided by YT-BB at 1 fps. In order to increase the annotation density, we rely on a mixture of state-of-the-art trackers to fill in missing annotations. We claim that any tracker is reliable on a small time lapse of 1 second.

As a result, we densely annotated the 30,132 videos using a weighted average between a forward and a backward pass using the DCF tracker(300fps)

对于选定哪个跟踪器去执行密集的标注呢,本文进行了实验,详细的可以看论文。开始我很疑惑,1fps不就相当于每个图片都标注了吗,可论文的实验给出30fps,所以这样差别就来了。以前就是1s只标注一帧,现在标注30帧,这样感觉有了更详细的运动特征。

并且建立了一个与训练集具有相同分布511个测试视频。测试视频的标注是使用Mechanical Turk workers(Turkers)+VATIC tool(一个利用光流法的视频标注工具)标注的。测试集提供了15个属性,前五个属性(Scale Variation,Aspect Ratio Change,Fast Motion,Low Resolution,Out-of-View)后十个是手动检查的(Illumination Variation,Camera Motion,Motion Blur,Blackground Clutter,Similar Object,Deformation,In-Plane Rotation,Out-of-Plane Rotation,Partial Occlusion,Full Occlusion)

结构如下:

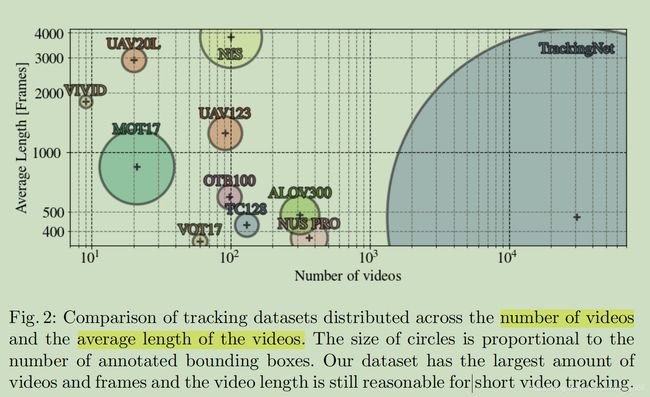

下图是和其他数据集的一个比较,TrackingNet视频数量多,每个视频的平均长度也合理,标注较详细。

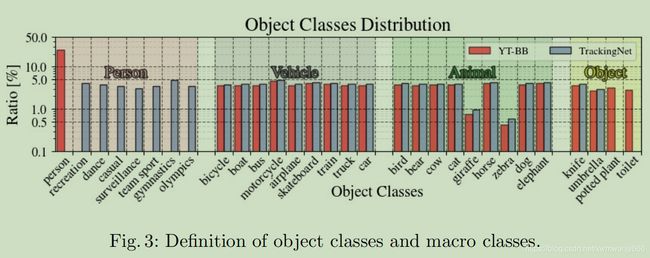

以下是数据集的目标类别分布:可以看到移除了最后两类,并把人分为详细的7个类别

Evaluation(三个标准)

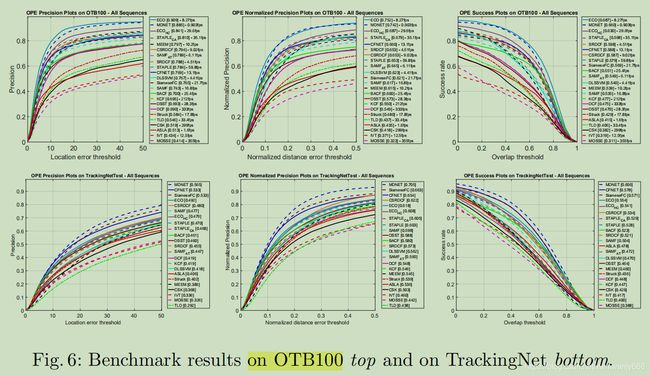

We evaluate the trackers through an online server.In a similar OTB100 fashion, we perform a One Pass Evaluation (OPE) and measure the success and precision of the trackers over the 511 videos.

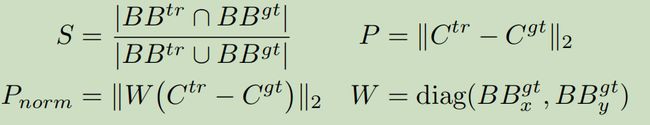

success S: IOU between the ground truth bounding boxes and the ones generated by trackers.The trackers are ranked using the AUC(Area Under the Curve) 0~1

precision P :measured as the distance in pixels between the centers Cgt and Ctr.The trackers are ranked using this metric with a conventional threshold of 20 pixels.

因为那个precision对图像的分辨率和bbox的大小很敏感,我们提出了第三个度量标准:

Pnorm: we normalize the precision over the size of the ground truth bounding box,we rank tracking algorithms using the Area Under the Curve(AUC) 0~0.5

Tracking Benchmark

**我们发现具有低分辨、全遮挡、平面内选择等挑战的视频一直是最困难的。**然后还有了自己的benchmark,在各种属性挑战上,发现mdnet效果更佳。最后,作者提出把测试集从500扩充到1000。

以上,总结起来一句话,就是跟踪领域的一个很大的数据集,希望机器争点气可以学到点有用的信息,完成任务!!!