CVPR2019深度学习|亮点:图网络去噪自编码;神经再生;深度度量学习(论文及代码)...

[1] Generating Classification Weights with GNN Denoising Autoencoders for Few-Shot Learning

Spyros Gidaris, Nikos Komodakis

University Paris-Est, valeo.ai

http://openaccess.thecvf.com/content_CVPR_2019/papers/Gidaris_Generating_Classification_Weights_With_GNN_Denoising_Autoencoders_for_Few-Shot_Learning_CVPR_2019_paper.pdf

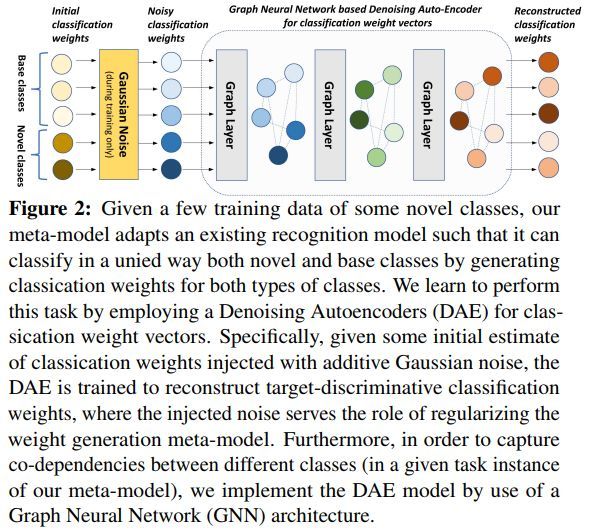

给定一组基类上训练好的初始识别模型,本文的目标是开发一种用于少样本学习的元模型。

在元模型中,输入中包含了一些新类,并且每个类只有很少的训练样例,元模型必须将现有的识别模型适当地调整为一个新的模型,该模型能够以统一的方式对这些新类别和基类进行正确的分类。为了实现这一目标,必须学会为这两种类型(新类别和基类)输出适当的分类权重向量。

为构建元模型,本文工作有两个主要的创新:

使用去噪自编码网络(DAE)(在训练期间)将一组用高斯噪声污染的分类权重作为输入,并学习重建目标,即判别分类器的权重。在这种情况下,分类权重上的注入噪声能够对生成元模型的权重进行正则化。

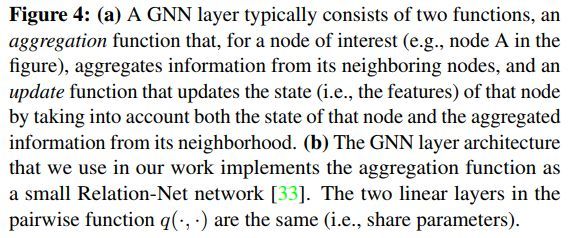

在元模型的目标任务实例中,为了得到不同类别之间的共同依赖,作者们将DAE当做图神经网络(GNN)来实现。

为了验证该方法的有效性,本文在基于ImageNet的少样本学习任务中进行了大量实验,并且给出了最优结果。

几个比较相似的类图示如下

模型结构图示如下

元模型图示如下

GNN结构图示如下

几种方法在ImageNet-FS上的效果对比如下

其中41对应的论文为

Low-shot learning from imaginary data, cvpr 2018

13对应的论文为

Low-shot visual recognition by shrinking and hallucinating features

代码地址

https://github.com/facebookresearch/low-shot-shrink-hallucinate

9对应的论文为

Dynamic few-shot visual learning without forgetting, cvpr 2018

代码地址

https://github.com/gidariss/FewShotWithoutForgetting

几种方法在MiniImageNet上的效果对比如下

其中7对应的论文为

Model-agnostic metalearning for fast adaptation of deep networks, icml 2017

代码地址

https://github.com/cbfinn/maml

36对应的论文为

Prototypical networks for few-shot learning,NIPS 2017

代码地址

https://github.com/jakesnell/prototypical-networks

42对应的论文为

Learning to compare: Relation network for few-shot learning, cvpr 2018

代码地址

https://github.com/floodsung/LearningToCompare_FSL

8对应的论文为

Few-shot learning with graph neural networks, 2017

代码地址

https://github.com/vgsatorras/few-shot-gnn

3对应的论文为

Meta-learning with differentiable closed-form solvers, iclr 2019

代码地址

https://github.com/bertinetto/r2d2

24对应的论文为

Tadam: Task dependent adaptive metric for improved few-shot learning, nips 2018

代码地址

https://github.com/ElementAI/TADAM

23对应的论文为

Meta networks, 2017

33对应的论文为

A simple neural network module for relational reasoning, nips 2017

代码地址

https://github.com/mesnico/RelationNetworks-CLEVR

26对应的论文为

Few-shot image recognition by predicting parameters from activations, cvpr 2018

代码地址

https://github.com/joe-siyuan-qiao/FewShot-CVPR

31对应的论文为

Meta-learning with latent embedding optimization, iclr 2019

代码地址

https://github.com/deepmind/leo

其中21对应的论文为

Transductive propagation network for few-shot learning, iclr 2019

代码地址

https://github.com/csyanbin/TPN

代码地址

https://github.com/gidariss/wDAE_GNN_FewShot

![]() 我是分割线

我是分割线![]()

[2] Neural Rejuvenation: Improving Deep Network Training by Enhancing Computational Resource Utilization

Siyuan Qiao, Zhe Lin, Jianming Zhang, Alan Yuille

Johns Hopkins University, Adobe Research

http://openaccess.thecvf.com/content_CVPR_2019/papers/Qiao_Neural_Rejuvenation_Improving_Deep_Network_Training_by_Enhancing_Computational_Resource_CVPR_2019_paper.pdf

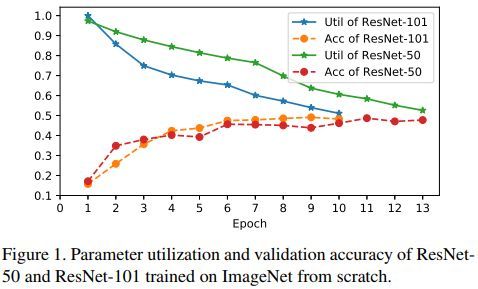

本文主要研究如何提高神经网络计算资源的利用率。深度神经网络通常针对不同的任务需要过度参数化以便获得良好的性能,因此可能没有充分利用计算资源。这种现象引起了许多研究课题,例如:网络剪枝,结构搜索等。

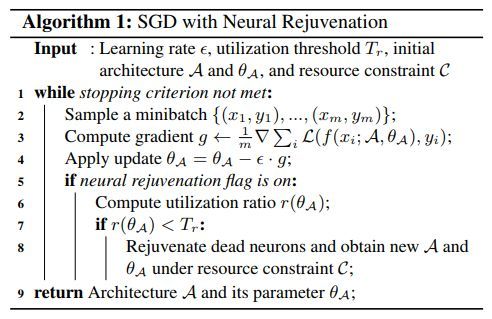

由于计算成本较高(例如,更多的参数或更多的计算量)的模型通常性能更好,本文着重研究如何提高神经网络的资源利用率。为此,作者们提出了一种称为神经再生的新型优化方法。顾名思义,该方法检测死神经元并实时计算资源利用率,通过资源重新分配和重新初始化恢复死神经元,并用新的训练方案训练它们。

利用简单的用神经再生替换标准优化算法,这种做法能够在保持资源利用率的同时,以非常大的幅度提高神经网络的性能。

随机梯度下降神经再生算法伪代码如下

准确率和参数利用率的对比图示如下

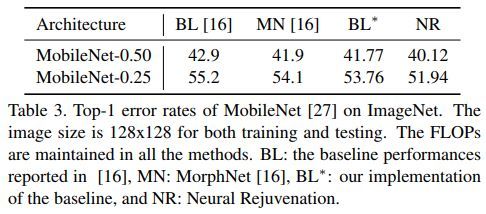

几种情况下的错误率对比如下

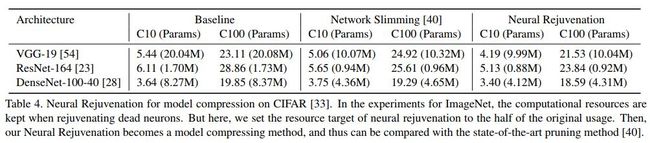

神经再生对几种网络结构的影响示例如下

其中28对应的论文为

Densely connected convolutional networks, cvpr 2017

代码地址

https://github.com/liuzhuang13/DenseNet

54对应的论文为

Very deep convolutional networks for large-scale image recognition, 2014

23对应的论文为

Deep residual learning for image recognition, cvpr 2016

代码地址

https://github.com/KaimingHe/deep-residual-networks

不同结构的mobilenet在ImageNet上的效果如下

16对应的论文为

Morphnet: Fast & simple resourceconstrained structure learning of deep networks,CVPR 2018

代码地址

https://github.com/google-research/morph-net

40对应的论文为

Learning efficient convolutional networks through network slimming, iccv 2017

代码地址

https://github.com/liuzhuang13/slimming

神经再生在模型压缩中的效果示例如下

不同的再生对应的效果示例如下

代码地址

https://github.com/joe-siyuan-qiao/NeuralRejuvenation-CVPR19

![]() 我是分割线

我是分割线![]()

[3] Hardness-Aware Deep Metric Learning

Wenzhao Zheng, Zhaodong Chen, Jiwen Lu, Jie Zhou

Tsinghua University, State Key Lab of Intelligent Technologies and Systems, Beijing National Research Center for Information Science and Technology

http://openaccess.thecvf.com/content_CVPR_2019/papers/Zheng_Hardness-Aware_Deep_Metric_Learning_CVPR_2019_paper.pdf

本文介绍了一种硬度感知深度量度学习(HDML)框架。

大多数之前的深度量度学习方法采用硬负采样挖掘策略来缓解缺乏训练样本的问题。但是,该挖掘策略仅利用训练数据的子集,这可能不足以全面地表征嵌入空间的全局几何特性。

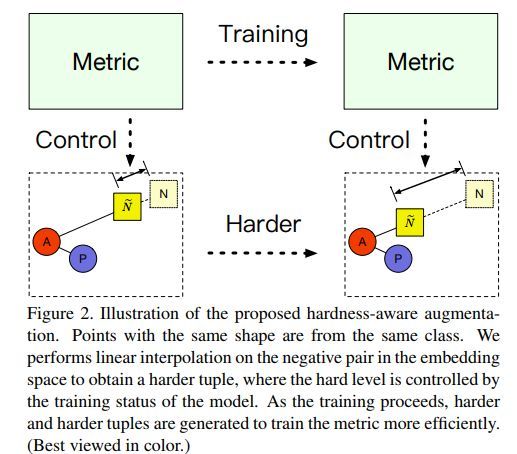

为了解决这个问题,作者们对嵌入进行线性插值,进而可以自适应地操纵它们的硬水平,并为再循环训练生成相应的合成样本,同时保留相应的标签。这样就可以充分利用所有样本中隐藏的信息,并且通常可以在适当的难度下得到相应的度量。

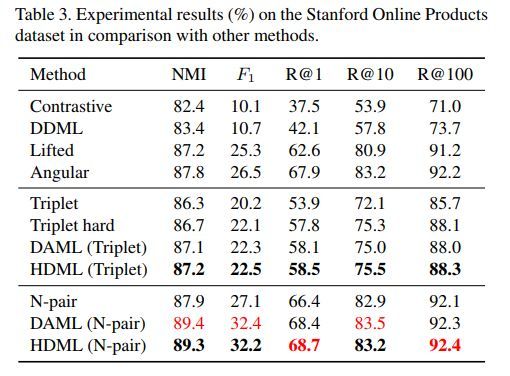

本文所提方法在多个数据集上取得了非常好的效果,比如广泛使用的 CUB-200-2011, Cars196数据集,以及Stanford Online Products datasets。

特征合成图示如下

增广图示如下

整体流程图示如下

不同情形在聚类中的对比如下

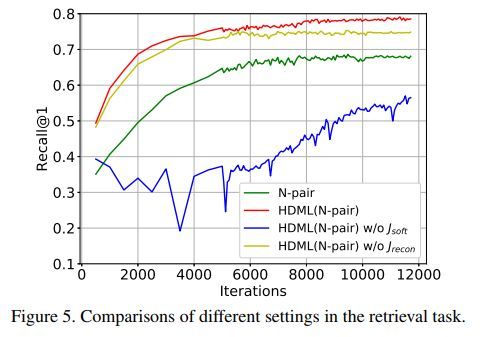

不同情形在检索中的对比如下

不同方法在数据集CUB-200-2011上的效果对比如下

不同方法在数据集Cars196上的效果对比如下

不同方法在数据集Stanford Online Products上的效果对比如下

可视化如下

代码地址

https://github.com/wzzheng/HDML

![]() 我是分割线

我是分割线![]()

您可能感兴趣