郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布!

1 DeepMind, London, UK

2 University College London, London, UK

3 Princeton University, Princeton, NJ, USA

*Correspondence: [email protected] (M. Botvinick).

Trends in Cognitive Sciences, May 2019, Vol. 23, No. 5 https://doi.org/10.1016/j.tics.2019.02.006

© 2019 The Authors. Published by Elsevier Ltd. This is an open access article under the CC BY license (http://creativecommons.org/licenses/by/4.0/).

近年来,深度强化学习(RL)方法在AI方面取得了令人瞩目的进步,在从Atari到Go到无限制扑克等领域都超过了人类的性能。这一进展引起了对了解人类学习感兴趣的认知科学家的关注。但是,人们一直担心,深度RL的样本效率可能太低——也就是说,它可能太慢——无法为人类学习提供一个合理的模型。在本综述中,我们通过描述最近开发的技术来反驳这种批评,这些技术使深度RL能够更灵活地运行,比以前的方法更快地解决问题。尽管这些技术是在AI环境中开发的,但我们提出它们可能会对心理学和神经科学产生深远的影响。这些AI方法产生的关键见解涉及快速RL和较慢的更多增量学习形式之间的基本联系。

Highlights

最近的AI研究已经产生了用于深度强化学习的强大技术。在将表征学习与奖励驱动行为结合起来时,深度强化学习似乎对心理学和神经科学具有内在的兴趣。

一种保留意见是,深度强化学习程序需要大量的训练数据,这表明这些算法可能从根本上与基于人类学习的算法不同。

尽管这种担忧适用于深度RL技术的最初浪潮,但随后的AI工作已经建立了使深度RL系统能够更快且更高效地学习的方法。两种特别有趣且有前途的技术分别集中在情景记忆和元学习上。

除了作为AI技术的兴趣外,利用情景记忆和元学习的深度RL方法对心理学和神经科学具有直接而有趣的意义。这些技术引起关注的一个微妙但至关重要的见解是快速和慢速学习形式之间的基本联系。

Glossary

- 深度神经网络:具有一个或(通常)多个隐含层的神经网络。

- 嵌入:位于神经网络层中学到的表示。

- 隐含层:输入和输出层之间的神经网络层。

- 神经网络:一组可学习的权重和偏差,它们以分层的形式排列,这些层处理输入以产生输出。要了解更多信息,请参阅McClelland and Rumelhart[105]的开创性入门材料。

- 非参数:在非参数模型中,参数的数量不是固定的,并且可以随着向模型提供的数据增加而增加。

- 循环神经网络:在序列的每个时间步骤中运行的神经网络,将其隐含层激活从每个步骤传递到下一个步骤。

Box 1. Deep Reinforcement Learning

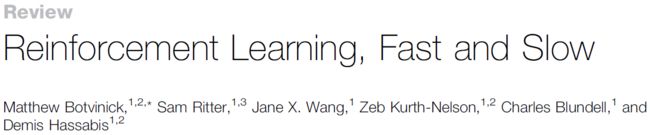

RL集中于学习行为策略,从状态或情况到动作的映射问题,这可以最大化累积长期奖励[12]。在简单的设置中,该策略可以表示为查找表,列出针对任何状态的适当动作。但是,在更丰富的环境中,这种简单的列表是不可行的,因此必须将策略隐式编码为参数化函数。1990年代的开拓性工作表明,可以使用多层(或深度)神经网络来逼近此函数([78],L.J. Lin,博士学位论文,卡内基梅隆大学,1993),允许梯度下降学习发现丰富的从感知输入到动作的非线性映射(请参阅面板A及以下)。但是,直到2015年,技术挑战才阻止将深度神经网络与RL集成,当时突破性的工作证明了可以使RL在诸如Atari视频游戏等复杂领域工作的程度[13](请参见图IB及以下)。从那时起,在改进和扩展深度RL[79]方面取得了迅速的进展,使其可以应用于复杂的任务域,例如Go[16]和Capture the Flag[80]。在许多情况下,后来的发展涉及将深度RL与结构和算法补全相集成,例如树搜索[16]或slot-based类似情景记忆[52](请参见图IC及其下面)。其他进展集中在学习速度的目标上,使深度学习RL仅根据一些观察就可以取得进展,如正文中所述。

该图说明了深度RL方法的演变,从图A开始,是Tesauro突破性的backgammon-playing系统“ TD-gammon”[78]。这是以神经网络为中心的,该神经网络以棋盘的表示形式作为输入,并学会输出“状态价值”的估计,状态价值定义为期望累积未来奖励,这仅等于从当前位置最终赢得比赛的估计概率。面板B显示了Mnih及其同事[13]报告的Atari-playing DQN网络。在这里,卷积神经网络(见[3])将屏幕像素作为输入并学习输出操纵杆动作。面板C显示了Wayne及其同事[51]报道的最先进的深度RL系统。此RL智能体的详细“接线”的完整描述不在本文讨论范围内(但可以在[51]中找到)。但是,如图所示,该结构包含多个模块,包括一个神经网络,该神经网络利用类似情景记忆来预测即将发生的事件,它与强化学习模块“对话”,该模块根据预测器模块的当前状态选择动作。该系统除其他任务外,还将学习在迷宫般的环境中执行目标导向的导航,如图I所示。

Box 2. Episodic Deep RL

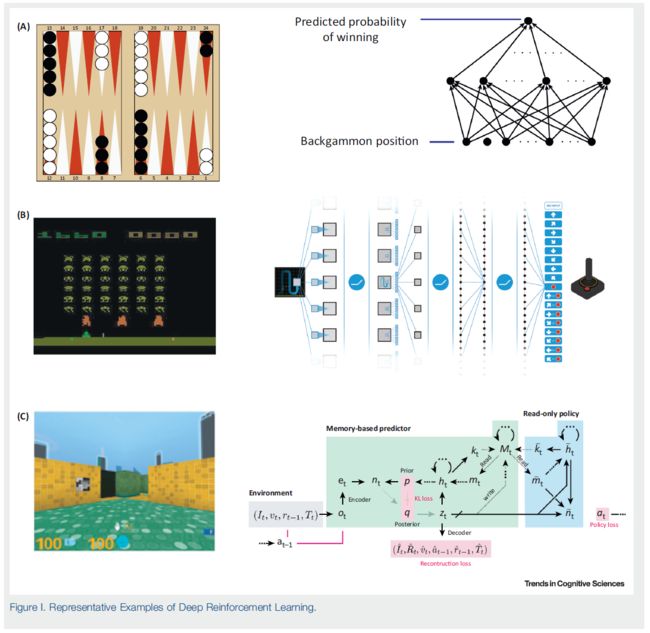

情景式RL算法使用情景记忆来估计动作和状态的价值[30,43,44]。例如,考虑图1所示的情景式评估算法,其中,智能体存储每个遇到的状态以及在接下来的n个时间步骤中获得的折扣奖励总和。这两个存储的项包括对所遇状态和后续奖励的情景记忆。为了估计新状态的价值,智能体计算存储的折扣奖励总和,并按存储的状态与新状态之间的相似性(模拟)加权。通过将所采取的动作连同状态和奖励总和一起记录在内存存储中,然后查询存储以查找仅采取了要评估的动作的内存,可以将该算法扩展为估计动作价值。实际上,[81]使用了这种情景式RL算法来在Atari游戏中实现强大的性能。

情景式RL的成功取决于用于计算状态相似性的状态表示。在[81]的后续研究中,Pritzel et al.[29]表明,通过使用梯度下降学习逐渐塑造这些状态表示,可以提高性能。这些结果证明了Atari学习环境中57款游戏的出色性能和最新数据效率[29],展示了将慢速(表示)学习和快速(价值)学习相结合的优势。

Box 3. Meta-Reinforcement Learning

当一个学习系统逐步调整第二个学习系统的运行时,就会发生元学习,从而使后者以更快的速度和效率运行[82-86]。通常用两个学习“环”来描述这种情况,一个“外环”利用其在许多任务上下文中的经验逐步调整控制“内环”操作的参数,以便内环可以快速调整以执行新任务(参见图1)。元RL是指内环和外环都实施RL算法,从奖励结果中学习并朝产生最大奖励的行为进行优化的情况。

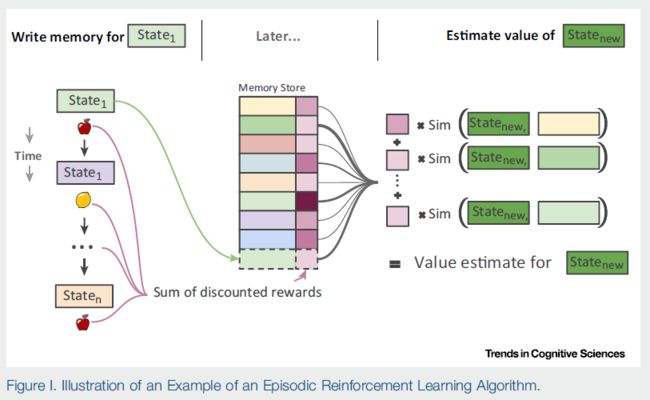

正如正文中所讨论的那样,该想法的一种实现采用了机器学习中常用的循环神经网络形式:长短期记忆单元[82,87]。在这种设置中,学习“外环”涉及通过标准的深度RL算法来调整网络的连接权重。在完成许多任务的过程中,这慢慢产生了“内环”学习算法,该算法在循环网络的活动动态中实现[37,38,50,82,87]。一个简单的例子涉及在“两臂赌博机”任务上训练循环神经网络。在每次试验中,智能体必须在两个动作之间进行选择(拉动左臂或右臂),并根据控制每个动作的收益概率的潜在参数获得奖励。在训练过程中,出现了一系列赌博机问题,每个问题都有一对随机抽样的回报参数。智能体与一个赌博机问题交互固定的步骤数,然后继续进行下一个问题。在每个新的赌博机问题中,智能体所面临的挑战是,在探索这两种方案与利用迄今获得的信息之间取得平衡,以寻求最大化的累积奖励。元RL学会解决这个问题,还学会探索一个更困难的赌博机问题,其臂奖励概率更匹配[(40%, 60%) vs (25%, 75%);比较图1A的下面板和上面板]。在对许多问题进行了训练之后,即使固定了连接权重,网络也可以探索一个新的赌博机问题,并使用与手工制作的机器学习算法相媲美的策略(图IB)收敛到奖励更高的臂上。

至关重要的是,网络活动动态中出现的学习算法不仅独立于训练网络权重的“外环” RL算法,而且它也可以比外环算法更好地工作,因为它可以学习与训练系统任务相一致的归纳偏差。在图1B中提供了图示(来自Wang et al.[49])。绿线表示训练一组赌博机任务后的性能(累积后悔;越低越好),在该组赌博机任务中,臂奖励概率是独立采样的(“独立赌博机”),而蓝线表示对某个臂的分布进行训练,其中概率是相互关联的(“相关赌博机”;特别是,它们之和总为1)。如图所示,对相关赌博机的训练会使算法更快地磨练奖励更高的臂。这反映了在网络的周期性动态中实现的自适应归纳偏差。图1C展示了元RL的更丰富的应用。正如正文中所述,Harlow[34]引入了“学会学习”的想法,该任务使用了猴子在成对的陌生物体之间进行选择的任务,最终基于任务的一致结构展示了one-shot学习。具体而言,对于每对物体,无论位置如何,一个物体始终与奖励相关联。猴子最终学会了在试验1中随机选择一个物体,然后使用奖励结果在试验2–6中表现完美(图IC,中间面板)。在最近的计算建模工作中,Wang及其同事[49]表明,采用循环神经网络的元RL产生了相同的one-shot学习模式(图IC,右面板)。

Box 4. Meta-RL and Rapid Learning in the Brain

Wang和同事[49]提出,如Box 3所述,元RL可以模拟生物大脑中的学习。他们认为,以前额叶皮层(PFC)为中心的循环网络实现了学习内环,而这种内环算法是由多巴胺驱动的突触可塑性的外环缓慢地塑造而成的。

我们首先关注内环。PFC是快速学习的核心[46,88],PFC中的神经元编码了支持这种学习的变量。例如,Tsutsui et al.[89]在环境变量不断变化的觅食任务中从灵长类动物背外侧PFC(dlPFC)记录。他们发现,单个神经元不仅为当前选择的价值编码,还为先前采取的动作,收到的先前奖励以及先前动作与先前奖励的交互进行编码(图I)。这些是在此任务中实施有效学习策略的关键变量。

Wang et al.[49]在同一任务上训练了元RL(Box 3)。他们发现,在训练过程中,人工循环网络开始实施模仿动物行为的快速学习策略。此外,这个训练有素的网络中的各个单元具有与灵长类dlPFC神经元非常相似的编码特性(图I)。Wang et al.[49]提出,在动物一生的整个过程中进行元学习将使PFC中的循环网络成形,使其具有可用于自然学习任务的调整属性。

现在我们转到外环。传统上,中脑多巴胺神经元被认为携带时序差分学习的奖励预测误差(RPE)信号[90-92]。在这种标准理论中,多巴胺可推动皮质-纹状体突触的增量调节,而这些调节会使动物易于重复强化动作。这种无模型学习系统通常被视为对存在大多数不同大脑区域的有模型系统的补充[93-95]。

但是,由于多巴胺携带有模型信息,这一标准理论变得复杂了[96-98]。例如,在旨在隔离有模型和无模型信号的任务中,Daw et al.[96]提出了令人惊讶的发现,腹侧纹状体中的信号(被认为是多巴胺能预测误差最强的fMRI相关性)包含有模型的可靠信息(图I)。

Wang et al.[49]在此任务的变体上训练了元RL[99]。在行为方面,他们发现经过训练的循环网络在其活动动态中实例化了有模型的鲁棒学习过程,尽管事实是元RL的训练过程是无模型的。当他们检查元RL的RPE时,他们发现RPE包含重要的有模型信息(图I)。人们已经做了很多工作来了解大脑如何学习和使用模型[46,100–102]。元RL提供了一个简洁的解释:依赖多巴胺的无模型学习会自动塑造循环网络,使其成为有模型学习算法。

总之,元RL可能是大脑组织的重要原理。在这个模型中,缓慢的增量学习过程将循环的大脑回路形成算法,这些算法利用环境中一致的结构来有效学习(有关工作,请参见[86,103,104])。

Powerful but Slow: The First Wave of Deep RL

在过去的几年中,AI研究取得了革命性的进步,其中神经网络或“深度学习”方法[1,2]的复兴推动了图像理解[3,4],自然语言处理[5,6]等许多其他领域的突破。这些发展吸引了心理学家,心理语言学家和神经科学家的兴趣,他们对AI的发展是否会提出有关人类认知和脑功能的新假设感到好奇[7-11]。

从这个角度来看,AI研究的一个特别吸引人的领域是深度RL(Box 1)。深度RL将神经网络建模(请参阅Glossary)与强化学习相结合,强化学习是一种从奖励和惩罚而不是从更明确的指导中学习的方法[12]。数十年来,深度RL作为一种有前途而非实际的想法,在过去的5年中已发展成为AI研究最密集的领域之一,在从视频游戏[13]到扑克[14],多人游戏比赛[15]和复杂的棋盘游戏,包括围棋和象棋[16-19]的任务中产生了超出人类的性能。

除了作为AI主题固有的兴趣之外,深度RL似乎对心理学和神经科学也具有特殊的兴趣。深度RL中驱动学习的机制最初是受到动物条件研究的启发[20],并且被认为与以多巴胺为中心的基于奖励的学习的神经机制密切相关[21]。同时,深度RL利用神经网络来学习强大的表示,这些表示支持泛化和迁移以及生物大脑的关键能力。有了这些联系,深度RL似乎可以为对人类和动物学习感兴趣的研究人员在行为和神经科学层面提供丰富的想法和假设来源。实际上,研究人员已经开始注意到[7,8]。

同时,对第一波深度RL研究的评论也听起来有些谨慎。乍一看,深度RL系统的学习方式与人类完全不同。有人争辩说,这种差异的特点在于人类学习与深度RL的样本效率。样本效率是指学习系统达到任何选定的目标性能水平所需的数据量。通过这种措施,深度学习RL系统的最初浪潮确实与人类学习者明显不同。为了在Atari电子游戏或国际象棋等任务上达到人类专家水平的性能,深度RL系统比人类专家本身需要更多数量级的训练数据[22]。简而言之,深度RL,至少在其最初的版本中,似乎太慢了,无法为人类学习提供合理的模型。所以过去已经有很多争论[23,24]。

这种批评确实适用于第一波深度RL方法,该方法于2013年左右开始报道(例如[25])。但是,即使在此之后的很短时间内,深度RL研究仍发生了重要的创新,这表明如何可以大大提高深度RL的样本效率。这些方法减轻了深度RL对大量训练数据的原始需求,有效地提高了深度RL的速度。这些计算技术的出现使深度RL成为人类学习的候选模型以及心理学和神经科学洞察力的源泉。

在本文中,我们考虑了缓解样本效率问题的两种关键的深度RL方法:情景式深度RL和元RL。我们研究了这些技术如何实现快速深度RL,并考虑了它们对心理学和神经科学的潜在影响。

Sources of Slowness in Deep RL

考虑快速RL技术的关键出发点是研究为什么深度RL的初始方法实际上如此缓慢。在这里,我们描述了样本效率低下的两个主要来源。在本文的结尾,我们将回头研究这两个概念所描述的问题之间的联系。

深度RL缓慢的第一个原因是对增量参数进行调整的要求。最初的深度RL方法(在AI研究中仍然非常广泛地使用)采用梯度下降来塑造从感知输入到动作输出的深度神经网络映射的连通性(Box 1)。正如在AI和心理学[26]中已经广泛讨论的那样,在这种学习形式期间所做的调整必须很小,以便最大化泛化[27]并避免覆盖早期学习的效果(有时将这种效果被称为“灾难性干扰”)。对学习中小步长的需求是最初为深度RL提出的方法缓慢的一个原因。

第二个来源是弱归纳偏差。学习理论的基础经验是,任何学习过程都必然面临偏差-方差的折衷:学习过程对要学习的模式做出的初始假设越强(即学习过程的初始归纳偏差越强)。学习完成所需的数据就更少了(假设初始归纳偏差与数据中的相匹配!)。归纳偏差较弱的学习程序将能够掌握更大范围的模式(更大的方差),但通常采样效率较低[28]。实际上,强归纳偏差是允许快速学习的原因。一个学习系统在解释传入数据时仅考虑狭窄范围的假设,比起归纳性偏弱的系统(同样,假设正确假设处于该狭窄的初始范围之内),它会更快地磨合正确的假设。重要的是,通用神经网络是极低偏差的学习系统。它们具有许多参数(连接权重),并且能够使用这些参数来适应各种数据。正如偏差-方差折衷所表明的那样,这意味着神经网络(在第一个深度RL模型(Box 1)中采用的通用形式)往往样本效率低下,需要学习大量数据。

这两个因素(增量参数调整和弱归纳偏差)共同解释了第一代深度RL模型的缓慢性。但是,随后的研究表明,可以同时缓解这两个因素,从而使深度RL能够以更加高效的采样方式进行。 接下来,我们考虑两种特定的技术,一种面对增量参数调整问题,另一种面对弱归纳偏差问题。除了它们在AI领域中的含义外,这两种AI技术都与心理学和神经科学具有暗示性联系,我们将对此进行详细介绍。

Episodic Deep RL: Fast Learning through Episodic Memory

如果增量参数调整是深度RL中缓慢的一种来源,那么学习速度更快的一种方法可能是避免这种增量更新。幼稚地增加控制梯度下降优化的学习速率会导致灾难性干扰问题。但是,最近的研究表明,还有另一种方法可以实现相同的目标,即保留过去事件的明确记录,并将该记录直接用作制定新决策的参考点。这个想法被称为情景式RL[29,30,42],与机器学习中的“非参数”方法[28]相似,类似于心理学中的“实例”或“基于示例”的学习理论[31,32]。当遇到新的情况并且必须对要采取的动作做出决定时,该过程是将当前情况的内部表示与过去情况的存储表示进行比较。然后,根据与当前情况最相似的过去情况的结果,所选择的动作就是与最高价值相关的动作。当内部状态表示由多层神经网络计算时,我们将所得算法称为“情景式深度RL”。Box 2中提供了对情景式深度RL机制的更详细解释。

在情景式深度RL中,与标准增量方法不同,通过每个经历的事件获得的信息可以立即用于指导行为。但是,虽然情景式深度RL能够“快速”发展,而较早的深度RL方法却“缓慢”,但这个故事有一个转折:情景式深度RL的快速学习关键取决于缓慢的增量学习。这是对连接权重的逐步学习,允许系统形成每个新观察值的有用内部表示或嵌入。这些表示形式本身是通过经验学习的,使用的是形成标准深度RL骨干结构的增量参数更新。最终,通过这种较慢的学习形式,可以保证情景式深度RL的速度。即,通过缓慢学习来实现快速学习。

快速学习对慢速学习的这种依赖绝不是巧合。正如我们将在下面讨论的那样,这是一个基本原理,至少适用于AI,也适用于心理学和神经科学。但是,在考虑这个一般点之前,我们先检查一下它在第二种新近开发的用于快速深度RL的AI技术中的作用:元RL。

Meta-RL: Speeding up Deep RL by Learning to Learn

如前所述,除了增量更新,标准深度RL速度缓慢的第二个关键根源是弱归纳偏置。在偏差-方差折衷的想法中,快速学习要求学习者学习一套合理大小的假设,这些假设涉及其将要面临的模式结构。假设集越窄,学习越快。但是,正如之前所预言的那样,存在一个陷阱:狭窄的假设集只有包含正确的假设,才能够加快学习速度。虽然强归纳偏差可以加速学习,但只有当学习者采用的特定偏差恰好适合要学习的材料时,它们才会这样做。作为结果,出现了一个新的学习问题:学习者如何知道采用什么归纳偏差?

这个问题的自然答案是借鉴过去的经验。当然,这不言而喻地一直发生在日常生活中。例如,考虑学习使用新智能手机的任务。在这种情况下,过去使用智能手机和其他相关设备的经验将为人们关于新手机应如何工作的假设提供依据,并指导对手机操作的探索。这些最初的假设对应于偏差-方差折衷中的“偏差”,并且它们负责快速学习如何使用新手机。没有这些偏差(即“方差”较高)的学习者会考虑更多有关电话操作的假设,但会牺牲学习速度。

利用过去的经验来加快新学习的速度在机器学习中被称为元学习[33]。然而,毫不奇怪,这个想法起源于心理学,被称为“学会学习”。在使用该术语的第一篇论文中,Harlow[34]提出了一个实验,它巧妙地抓住了原理。在这里,向猴子展示了两个陌生的物体,并允许它们抓住其中一个。在下面放置食物奖励或空。然后将物体再次放在动物面前,可能左右颠倒,然后重复该过程共六轮。然后替换了两个新的不熟悉的物体,随后又进行了六个试验。然后是另一对物体,依此类推。在许多物体对中,这些动物能够弄清楚始终存在一个简单的规则:一个物体产生食物,而另一个物体则不产生食物,而无论其左右位置如何。当给Harlow的猴子们放上一对新物体时,他们可以one-shot学习到哪个物体是首选物体,这是学习的简单而生动的例子(Box 3)。

现在回到AI,最近的工作表明如何利用学习来加速深度RL中的学习。这个总体想法已经以多种方式实现[35,36]。然而,Wang[37]和Duan[38]及其同事同时提出了一种与神经科学和心理学特别相关的方法。在这里,循环神经网络针对一系列相互关联的RL任务进行训练。网络中的权重调整非常缓慢,因此它们可以吸收跨任务的常见问题,但不能快速变化以支持任何单个任务的解决方案。在这种情况下,会发生一些非常明显的事情。循环网络的活动动态实现了他们自己单独的RL算法,该算法“负责”以根据过去任务中积累的知识快速解决每个新任务(图1)。一种RL算法有效地催生了另一种RL算法,因此也称为“元RL”。

与情景式深度RL一样,元RL又涉及快速学习与缓慢学习之间的紧密联系。循环网络中的连接会在各个任务之间缓慢更新,从而允许将跨任务的一般原理“构建”到循环网络的动态中。由此产生的网络动态实现了一种新的学习算法,该算法可以快速解决新问题,因为底层的缓慢学习过程赋予了它们有用的归纳偏差(Box 3)。再次,快速学习源于缓慢学习,并且受其影响。

Episodic Meta-RL

重要的是,我们上面讨论的两种技术不是互相排斥的。确实,最近的工作已经探索了一种利用元学习和情景控制相辅相成的优势来整合这两种方法[39,40]。如前文和Box 3所述,在情景式元RL中,元学习发生在循环神经网络内。但是,在此之上叠加的是一个情景记忆系统,其作用是恢复循环网络中的活动模式。与情景式深度RL中一样,情景记忆对一系列过去事件进行分类,可以根据当前上下文对其进行查询。但是,情景式元RL不会将上下文与价值估算链接在一起,而是将它们与来自循环网络内部或隐含单元的存储活动模式联系起来。这些模式之所以重要,是因为它们通过元RL总结了智能体从与各个任务的交互中学到的知识(有关详细信息,请参见Box 3)。在情景式元RL中,当智能体遇到的情况看起来与过去遇到的情况类似时,它将恢复先前遇到的隐含激活,从而使先前获悉的信息可以立即影响当前策略。实际上,情景存储使系统能够识别先前遇到的任务,从而检索存储的解决方案。

通过模拟工作进行赌博机和导航任务,Ritter et al.[39]表明,情景式元RL与“朴素”元RL一样,具有强归纳偏差,可以使其迅速解决新任务。更重要的是,当遇到以前遇到的任务时,情景式元RL会立即检索并恢复以前发现的解决方案,以免需要重新探索。第一次遇到新任务时,系统受益于元RL的快速性;在第二次和以后的相遇中,它受益于情景控制所赋予的one-shot学习能力。

Implications for Neuroscience and Psychology

正如我们在一开始所讨论的那样,样本效率低下的问题已成为质疑深度RL与人类和其他动物学习的相关性的原因[23,24]。从心理学和神经科学的角度来看,情景式深度RL和元RL的一个重要含义是它们通过表明深度RL实际上不必太慢而破坏了这一论点。该演示在捍卫深度RL作为人类和动物学习的潜在模型方面有一定距离。但是,除了这个一般性观点之外,情景式深度RL和元RL的细节也指出了心理学和神经科学中有趣的新假设。

首先,从情景式深度RL开始,我们已经注意到了这种记忆与经典的基于实例的人类记忆模型之间的有趣联系,其中认知作用于存储的有关先前特定观察的信息[31,32]。情景式RL为基于实例的处理如何满足奖励驱动的学习提供了可能的解释。有趣的是,最近在动物和人类中有关RL的工作越来越强调了情景记忆的潜在贡献,有证据表明状态和动作价值的估计是基于对特定过去行动结果观察的记忆[41-44]。情景式深度RL提供了一个讨论会,用于探索这一通用原理如何扩展到丰富的高维顺序学习问题。也许从根本上讲,它强调了基于情景记忆的表示学习和度量学习在RL中可能发挥的重要作用。因此,情景式深度RL建议:研究“快速的情景式RL在人和动物中可能与较慢的学习过程相互作用,并依赖较慢的学习过程”可能是富有成果的。虽然快慢学习之间的这种联系已经涉及到内存本身的工作,包括在多个内存系统上的工作[26,45-47],但尚未深入探讨其在基于奖励的学习中的作用(尽管参见[48])。

转向元RL,此框架也对心理学和神经科学具有有趣的潜在影响。确实,Wang及其同事[49]提出了从元RL元素到神经结构和函数的非常直接的映射。具体来说,他们提出,多巴胺驱动的缓慢突触变化可以用来调节前额叶回路的活动动态,以使前额叶回路实现一套独立的学习程序(Box 4)。通过一系列计算机模拟,Wang及其同事[49]证明了以这种方式解释的元RL如何解释行为和神经生理学文献中各种不同的经验发现(Box 4)。

同样直接的链接将情景式元RL与心理学和神经科学联系起来。确实,情景式元RL涉及的恢复机制直接受到神经科学数据的启发,这些数据表明,情景记忆电路可用于恢复大脑皮层的激活模式,包括支持工作记忆的区域(见[40])。Ritter及其同事[39](S. Ritter,博士学位论文,普林斯顿大学,2019)展示了如何通过RL本身配置这样的函数,从而形成了一个可以从战略上恢复有关先前遇到的任务信息的系统(另请参见[50–52])。除了它从神经科学中获得的最初灵感外,这项工作还通过提供对最近报道的人类学习中情景式与有模型控制之间的交互的简要解释,回到生物学上([53],S.Ritter,博士学位论文,普林斯顿大学,2019)。在更广泛的层面上,Ritter及其同事[39]报告的工作提供了元学习如何在多个存储系统上运行的说明[26],它们缓慢地调整了它们的交互,从而共同支持快速学习。

Fast and Slow RL: Broader Implications

在讨论情景式RL和元RL时,我们强调了“缓慢”学习在实现快速且样本高效的学习中的作用。如我们所见,在元RL中,基于权重的缓慢学习的作用是建立归纳偏差,该偏差可以指导推断,从而支持快速适应新任务。缓慢的增量学习在情景式RL中的作用可以用相关术语来理解。情景式RL本质上取决于对情况或状态之间相似性的判断。慢速学习塑造了内部表示状态的方式,因此就一系列与哪些状态最相关的归纳偏差进行了归纳。

仔细研究情景式RL,您可能还会说,学习结构内置了归纳偏差。特别是,情景式RL固有地采用一种平滑性原理:相似的状态通常会要求相似的动作。该归纳偏差不是被学习的,而是被连接到定义情景性RL的学习系统的结构中。在当前的AI术语中,这是“结构”或“算法偏差”的一种情况,与“学习偏差”的区别(如在元RL中所见)。

当前的大量AI研究都集中于寻找有用的归纳偏差来加快学习速度,无论这是通过学习还是通过对结构或算法偏差的直接手工设计来实现的。确实,后一种策略本身在很大程度上负责了AI中神经网络的兴起。卷积神经网络为这种复兴提供了原始动力,它建立在一个非常具体的架构偏见上,与图像识别中的平移不变性有关。但是,在过去的几年中,越来越多的AI研究已经明确或隐含地集中在归纳偏差问题上(例如[54-56])。

在较高的水平上,这些发展当然与心理学中一些长期存在的问题平行。正如我们已经指出的,归纳偏差实际上可以通过学习获得的想法最初源自心理学[34],并且一直是心理学研究的一个间歇性话题(例如,[23])。但是,神经网络中的元学习可能会提供一个新的上下文来探索这种学习过程的机制和动态,尤其是在RL环境中。

心理学,尤其是发展心理学,也长期以来一直在考虑某些归纳偏差是“内在的”,即天生就有的[57]。但是,关于结构偏差和内置于神经网络学习算法中的偏差的更为机械化的想法尚未得到广泛考虑(尽管请参见[58-60])。同样,当前的深度学习和深度RL方法提供了一个工具包,可能有助于进一步的探索,例如,考虑到有关大脑连接性的信息不断增长的含义[61-63]。

值得注意的是,尽管AI工作在通过学习获得的归纳偏差与手工“连接”的偏差之间有着明显的区别,但在生物学背景下,可以使用一种更普遍且更统一的观点。具体而言,人们可以将架构和算法偏差视为由进化驱动的不同学习过程所引起。在这里,进化是“缓慢”学习过程,逐渐塑造出架构和算法偏差,从而可以更快地进行终身学习。因此,元学习不仅可以在一个生命周期内进行,而且可以在进化时间内进行。有趣的是,这种观点暗示进化并不是选择真正的“通用”学习算法,而是选择一种利用大脑进化的特定环境中的规律性算法。在这种情况下,AI的最新发展可能再次证明了对神经科学和心理学的启示。在自然选择的启发下,最近的AI工作已通过进化算法深入研究了构建智能体架构的方法以及奖励函数[15,64-67]。

无论是专注于人工工程还是进化,AI在架构和算法偏差方面的工作都为我们提供了一个新的实验室,用于研究进化如何塑造神经系统以支持高效学习。AI研究建议的可能性包括对网络连接的初始模式的限制[36]。塑造突触学习规则[35,68,69];各种因素促使出现纠缠的或组合的表示[54,70,71]和内部预测模型[51]。

从心理学,神经科学以及进化与发展研究的角度来看,这样的工作产生了一张图片,其中学习一次在许多时间尺度上运行(从几千年到几毫秒不等),而较慢的时间尺度产生了偏差。可以在上述级别上更快地学习,并且所有这些过程都在受到环境结构强烈影响的轨迹之后,在进化,发育和昼夜时间尺度上发挥作用(参见[72])。从这个角度来看,进化塑造了架构和算法,它们嵌入了归纳偏差。然后,这些将影响一生的学习,而学习本身会根据经验发展出进一步的归纳偏差。在这张图片中,进化表现为“级联”中“最慢”的学习过程,每一层通过将归纳偏差提供给下一个级别来支持下一个“更快”级别。

正如许多读者会认识到的那样,这种基于元学习的观点对于认知科学并不是完全陌生的。如前所述,学习的思想在心理学中已经占据了数十年的位置[34,73],而分级贝叶斯学习模型长期以来一直强调紧密相关的思想,先验概率为归纳偏差提供了媒介[23,74–77]。关于生物进化的研究也涉及到相关的观点[66]。尽管有这些先例,最近AI研究的兴起,研究了慢速学习和快速学习在神经网络和RL中的作用,提供了全新的观点和新的机遇。

Concluding Remarks and Future Directions

深度RL的快速发展领域对心理学和神经科学产生了浓厚的兴趣,因为它集中于表示学习和目标导向的行为。在本综述中,我们描述了最近出现的深度RL形式,这些形式克服了样本效率低下的明显问题,使深度RL可以“快速”发挥作用。这些技术不仅增强了深度RL与心理学和神经科学之间的潜在相关性,反击了最近的怀疑评估;通过建立与情景记忆和学会学习等主题的联系,他们丰富了潜在的联系。此外,深入的RL研究产生的想法越来越多地为心理学和神经科学的新研究提出了具体的方向。

正如我们已经强调的那样,最近有关样本高效的深度RL的工作的一个关键含义是,在发生快速学习的地方,它必然依赖于慢速学习,后者建立了能够进行快速学习的表示形式和归纳偏差。这种计算辩证法为研究大脑中的多个记忆系统及其进化起源提供了理论框架。但是,人类学习可能会涉及多个相互作用的过程,而不是本评论中讨论的过程,并且我们认为,任何深度RL模型都需要整合所有这些模型才能进行类似于人类的学习(请参阅悬而未决的问题)。在更广泛的层面上,了解RL快慢之间的关系为心理学和神经科学提出了引人入胜的组织挑战。确实,这可能是AI,神经科学和心理学可以协同交互的关键领域,这一直以来都是认知科学的理想选择。