Redis的基础命令、事物、集群模式、持久化机制

文章目录

- 配置文件详解

- 常用命令

- 1.公共命令

- 2.string

- 3.hash

- 4.list

- 5.set

- 6.zset

- 特性

- 1.发布订阅

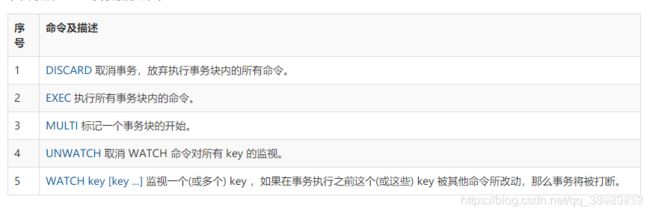

- 2.事物

- 主从同步/复制

- **主从复制原理:**

- **优点:**

- **缺点:**

- 哨兵模式

- **哨兵模式的作用:**

- **故障切换的过程:**

- **哨兵模式的配置:**

- **哨兵模式的工作方式:**

- **优点:**

- **缺点:**

- Cluster 集群

- **集群的配置**

- **集群的特点**

- **集群的工作方式**

- 持久化机制

- RDB持久化机制的优点

- RDB持久化机制的缺点

- AOF持久化机制的优点

- AOF持久化机制的缺点

- AOF的持久化配置

- AOF破损文件的修复

配置文件详解

daemonize : 默认为no,修改为yes启用守护线程

port :设定端口号,默认为6379

bind :绑定IP地址

databases :数据库数量,默认16

save :指定多少时间、有多少次更新操作,就将数据同步到数据文件

#redis默认配置有三个条件,满足一个即进行持久化

save 900 1 #900s有1个更改

save 300 10 #300s有10个更改

save 60 10000 #60s有10000更改

dbfilename :指定本地数据库的文件名,默认为dump.rdb

dir :指定本地数据库的存放目录,默认为./当前文件夹

auto-aof-rewrite-percentage 100: 就是当前AOF大小膨胀到超过上次100%,上次的两倍

auto-aof-rewrite-min-size 64mb: 根据你的数据量来定,16mb,32mb

requirepass :设置密码,默认关闭

redis -cli -h host -p port -a password

常用命令

1.公共命令

DEL key

DUMP key:序列化给定key,返回被序列化的值

EXISTS key:检查key是否存在

EXPIRE key second:为key设定过期时间

TTL key:返回key剩余时间

PERSIST key:移除key的过期时间,key将持久保存

KEY pattern:查询所有符号给定模式的key

RANDOM key:随机返回一个key

RANAME key newkey:修改key的名称

MOVE key db:移动key至指定数据库中

TYPE key:返回key所储存的值的类型

2.string

string类型是二进制安全的,redis的string可以包含任何数据,如图像、序列化对象。一个键最多能存储512MB。==二进制安全是指,在传输数据的时候,能保证二进制数据的信息安全,也就是不会被篡改、破译;如果被攻击,能够及时检测出来 ==

setkey_name value:命令不区分大小写,但是key_name区分大小写

SETNX key value:当key不存在时设置key的值。(SET if Not eXists)

get key_name

GETRANGE key start end:获取key中字符串的子字符串,从start开始,end结束

MGET key1 [key2 …]:获取多个key

GETSET KEY_NAME VALUE:设定key的值,并返回key的旧值。当key不存在,返回nil

STRLEN key:返回key所存储的字符串的长度

INCR KEY_NAME :INCR命令key中存储的值+1,如果不存在key,则key中的值话先被初始化为0再加1

INCRBY KEY_NAME 增量

DECR KEY_NAME:key中的值自减一

DECRBY KEY_NAME decrement: 将 key 所储存的值减去减量 decrement

append key_name value:字符串拼接,追加至末尾,如果不存在,为其赋值

3.hash

Redis hash是一个string类型的field和value的映射表,hash特别适用于存储对象。每个hash可以存储232-1键值对。可以看成KEY和VALUE的MAP容器。相比于JSON,hash占用很少的内存空间。

HSET key_name field value:为指定的key设定field和value

hmset key field value[field1,value1]

hget key field

hmget key field[field1]

hgetall key:返回hash表中所有字段和值

hkeys key:获取hash表所有字段

hlen key:获取hash表中的字段数量

hdel key field [field1]:删除一个或多个hash表的字段

4.list

类似于Java中的LinkedList。

lpush key value1 [value2]

rpush key value1 [value2]

lpushx key value:从左侧插入值,如果list不存在,则不操作

rpushx key value:从右侧插入值,如果list不存在,则不操作

llen key:获取列表长度

lindex key index:获取指定索引的元素

lrange key start stop:获取列表指定范围的元素

lpop key :从左侧移除第一个元素

prop key:移除列表最后一个元素

blpop key [key1] timeout:移除并获取列表第一个元素,如果列表没有元素会阻塞列表到等待超时或发现可弹出元素为止

brpop key [key1] timeout:移除并获取列表最后一个元素,如果列表没有元素会阻塞列表到等待超时或发现可弹出元素为止

ltrim key start stop :对列表进行修改,让列表只保留指定区间的元素,不在指定区间的元素就会被删除

lset key index value :指定索引的值

linsert key before|after world value:在列表元素前或则后插入元素

5.set

唯一、无序

sadd key value1[value2]:向集合添加成员

scard key:返回集合成员数

smembers key:返回集合中所有成员

sismember key member:判断memeber元素是否是集合key成员的成员

srandmember key [count]:返回集合中一个或多个随机数

srem key member1 [member2]:移除集合中一个或多个成员

spop key:移除并返回集合中的一个随机元素

smove source destination member:将member元素从source集合移动到destination集合

sdiff key1 [key2]:返回所有集合的差集

sdiffstore destination key1[key2]:返回给定所有集合的差集并存储在destination中

6.zset

有序且不重复。每个元素都会关联一个double类型的分数,Redis通过分数进行从小到大的排序。分数可以重复

ZADD key score1 memeber1

ZCARD key :获取集合中的元素数量

ZCOUNT key min max 计算在有序集合中指定区间分数的成员数

ZCOUNT key min max 计算在有序集合中指定区间分数的成员数

ZRANK key member:返回有序集合指定成员的索引

ZREVRANGE key start stop :返回有序集中指定区间内的成员,通过索引,分数从高到底

ZREM key member [member …] 移除有序集合中的一个或多个成员

ZREMRANGEBYRANK key start stop 移除有序集合中给定的排名区间的所有成员(第一名是0)(低到高排序)

ZREMRANGEBYSCORE key min max 移除有序集合中给定的分数区间的所有成员

特性

1.发布订阅

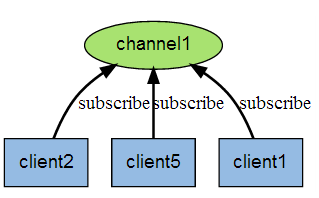

Redis 发布订阅(pub/sub)是一种消息通信模式:发送者(pub)发送消息,订阅者(sub)接收消息。

Redis 客户端可以订阅任意数量的频道。

下图展示了频道 channel1 , 以及订阅这个频道的三个客户端 —— client2 、 client5 和 client1 之间的关系:

当有新消息通过 PUBLISH 命令发送给频道 channel1 时, 这个消息就会被发送给订阅它的三个客户端:

subscribe channel [channel…]:订阅一个或多个频道的信息

psubscribe pattern [pattern…]:订阅一个或多个符合规定模式的频道

publish channel message :将信息发送到指定频道

unsubscribe [channel[channel…]]:退订频道

punsubscribe [pattern[pattern…]]:退订所有给定模式的频道

2.事物

Redis事务可以一次执行多个命令,(按顺序地串行化执行,执行过程中不允许其他命令插入执行序列中)。

1、Redis会将一个事务中的所有命令序列化,然后按顺序执行

2、执行中不会被其他命令插入,不允许加塞行为

主从同步/复制

通过持久化功能,Redis保证了即使在服务器重启的情况下也不会丢失(或少量丢失)数据,因为持久化会把内存中数据保存到硬盘上,重启会从硬盘上加载数据。 但是由于数据是存储在一台服务器上的,如果这台服务器出现硬盘故障等问题,也会导致数据丢失。

为了避免单点故障,通常的做法是将数据库复制多个副本以部署在不同的服务器上,这样即使有一台服务器出现故障,其他服务器依然可以继续提供服务。为此, Redis 提供了复制(replication)功能,可以实现当一台数据库中的数据更新后,自动将更新的数据同步到其他数据库上。

在复制的概念中,数据库分为两类,一类是主数据库(master),另一类是从数据库(slave)。主数据库可以进行读写操作,当写操作导致数据变化时会自动将数据同步给从数据库。而从数据库一般是只读的,并接受主数据库同步过来的数据。一个主数据库可以拥有多个从数据库,而一个从数据库只能拥有一个主数据库。

主从数据库的配置:

主数据库不用配置,从数据库的配置文件(redis.conf)中可以加载主数据库的信息,也可以在启动时,使用 redis-server --port 6380 --slaveof 127.0.0.1 6379 命令指明主数据库的 IP 和端口。从数据库一般是只读,可以改为可写,但写入的数据很容易被主同步没,所以还是只读就可以。也可以在运行时使用 slaveof ip port 命令,停止原来的主,切换成刚刚设置的主 slaveof no one会把自己变成主。

主从复制原理:

- 从数据库连接主数据库,发送SYNC命令;

- 主数据库接收到SYNC命令后,开始执行BGSAVE命令生成RDB文件并使用缓冲区记录此后执行的所有写命令;

- 主数据库BGSAVE执行完后,向所有从数据库发送快照文件,并在发送期间继续记录被执行的写命令;

- 从数据库收到快照文件后丢弃所有旧数据,载入收到的快照;

- 主数据库快照发送完毕后开始向从数据库发送缓冲区中的写命令;

- 从数据库完成对快照的载入,开始接收命令请求,并执行来自主数据库缓冲区的写命令;(从数据库初始化完成)

- 主数据库每执行一个写命令就会向从数据库发送相同的写命令,从数据库接收并执行收到的写命令(从数据库初始化完成后的操作)

- 出现断开重连后,2.8之后的版本会将断线期间的命令传给重数据库,增量复制。

- 主从刚刚连接的时候,进行全量同步;全同步结束后,进行增量同步。当然,如果有需要,slave 在任何时候都可以发起全量同步。Redis 的策略是,无论如何,首先会尝试进行增量同步,如不成功,要求从机进行全量同步。

优点:

- 支持主从复制,主机会自动将数据同步到从机,可以进行读写分离;

- 为了分载Master的读操作压力,Slave服务器可以为客户端提供只读操作的服务,写服务仍然必须由Master来完成;

- Slave同样可以接受其它Slaves的连接和同步请求,这样可以有效的分载Master的同步压力;

- Master Server是以非阻塞的方式为Slaves提供服务。所以在Master-Slave同步期间,客户端仍然可以提交查询或修改请求;

- Slave Server同样是以非阻塞的方式完成数据同步。在同步期间,如果有客户端提交查询请求,Redis则返回同步之前的数据;

缺点:

- Redis不具备自动容错和恢复功能,主机从机的宕机都会导致前端部分读写请求失败,需要等待机器重启或者手动切换前端的IP才能恢复;

- 主机宕机,宕机前有部分数据未能及时同步到从机,切换IP后还会引入数据不一致的问题,降低了系统的可用性;

- 如果多个Slave断线了,需要重启的时候,尽量不要在同一时间段进行重启。因为只要Slave启动,就会发送sync请求和主机全量同步,当多个 Slave 重启的时候,可能会导致 Master IO剧增从而宕机。

- Redis较难支持在线扩容,在集群容量达到上限时在线扩容会变得很复杂;

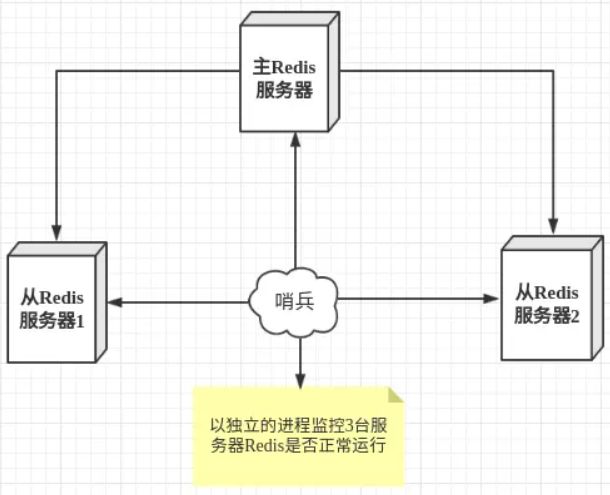

哨兵模式

第一种主从同步/复制的模式,当主服务器宕机后,需要手动把一台从服务器切换为主服务器,这就需要人工干预,费事费力,还会造成一段时间内服务不可用。这不是一种推荐的方式,更多时候,我们优先考虑哨兵模式。

哨兵模式是一种特殊的模式,首先Redis提供了哨兵的命令,哨兵是一个独立的进程,作为进程,它会独立运行。其原理是哨兵通过发送命令,等待Redis服务器响应,从而监控运行的多个Redis实例。

哨兵模式的作用:

- 通过发送命令,让Redis服务器返回监控其运行状态,包括主服务器和从服务器;

- 当哨兵监测到master宕机,会自动将slave切换成master,然后通过发布订阅模式通知其他的从服务器,修改配置文件,让它们切换主机;

然而一个哨兵进程对Redis服务器进行监控,也可能会出现问题,为此,我们可以使用多个哨兵进行监控。各个哨兵之间还会进行监控,这样就形成了多哨兵模式。

故障切换的过程:

假设主服务器宕机,哨兵1先检测到这个结果,系统并不会马上进行 failover 过程,仅仅是哨兵1主观的认为主服务器不可用,这个现象成为主观下线。当后面的哨兵也检测到主服务器不可用,并且数量达到一定值时,那么哨兵之间就会进行一次投票,投票的结果由一个哨兵发起,进行 failover 操作。切换成功后,就会通过发布订阅模式,让各个哨兵把自己监控的从服务器实现切换主机,这个过程称为客观下线。这样对于客户端而言,一切都是透明的。

哨兵模式的配置:

配置一主二从和三个哨兵的 Redis 服务器来演示这个过程

主从服务器配置

# 使得Redis服务器可以跨网络访问

bind 0.0.0.0

# 设置密码

requirepass "123456"

# 以下有关slaveof的配置只是配置从服务器,主服务器不需要配置

# 指定主服务器

slaveof 192.168.11.128 6379

# 主服务器密码

masterauth 123456

哨兵配置

# 禁止保护模式

protected-mode no

# 配置监听的主服务器,这里sentinel monitor代表监控,mymaster代表服务器的名称,可以自定义,192.168.11.128代表监控的主服务器,6379代表端口,2代表只有两个或两个以上的哨兵认为主服务器不可用的时候,才会进行failover操作。

sentinel monitor mymaster 192.168.11.128 6379 2

# sentinel author-pass定义服务的密码,mymaster是服务名称,123456是Redis服务器密码

# sentinel auth-pass

sentinel auth-pass mymaster 123456

配置3个哨兵,每个哨兵的配置都是一样的。在Redis安装目录下有一个sentinel.conf文件,copy一份进行修改

启动

注意启动的顺序。首先是主机(192.168.11.128)的 Redis 服务进程,然后启动从机的 Redis 服务进程,最后启动3个哨兵的服务进程。

哨兵模式的工作方式:

- 每个Sentinel(哨兵)进程以每秒钟一次的频率向整个集群中的Master主服务器,Slave从服务器以及其他Sentinel(哨兵)进程发送一个 PING 命令。

- 如果一个实例(instance)距离最后一次有效回复 PING 命令的时间超过 down-after-milliseconds 选项所指定的值, 则这个实例会被 Sentinel(哨兵)进程标记为主观下线(SDOWN)

- 如果一个Master主服务器被标记为主观下线(SDOWN),则正在监视这个Master主服务器的所有 Sentinel(哨兵)进程要以每秒一次的频率确认Master主服务器的确进入了主观下线状态

- 当有足够数量的 Sentinel(哨兵)进程(大于等于配置文件指定的值)在指定的时间范围内确认Master主服务器进入了主观下线状态(SDOWN), 则Master主服务器会被标记为客观下线(ODOWN)

- 在一般情况下, 每个 Sentinel(哨兵)进程会以每 10 秒一次的频率向集群中的所有Master主服务器、Slave从服务器发送 INFO 命令。

- 当Master主服务器被 Sentinel(哨兵)进程标记为客观下线(ODOWN)时,Sentinel(哨兵)进程向下线的 Master主服务器的所有 Slave从服务器发送 INFO 命令的频率会从 10 秒一次改为每秒一次。

- 若没有足够数量的 Sentinel(哨兵)进程同意 Master主服务器下线, Master主服务器的客观下线状态就会被移除。若 Master主服务器重新向 Sentinel(哨兵)进程发送 PING 命令返回有效回复,Master主服务器的主观下线状态就会被移除。

优点:

- 哨兵模式是基于主从模式的,所有主从的优点,哨兵模式都具有。

- 主从可以自动切换,系统更健壮,可用性更高。

缺点:

- Redis较难支持在线扩容,在集群容量达到上限时在线扩容会变得很复杂。

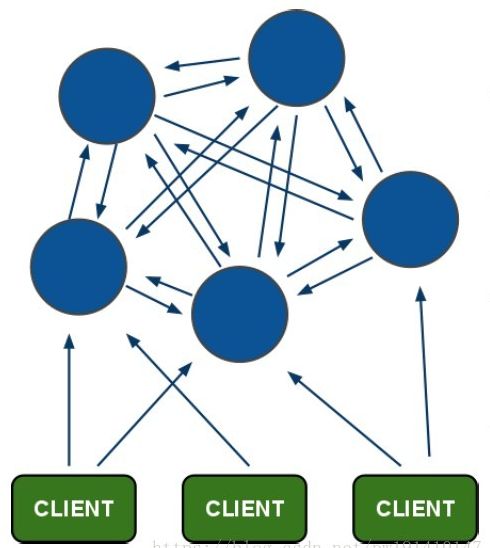

Cluster 集群

Redis 的哨兵模式基本已经可以实现高可用,读写分离 ,但是在这种模式下每台 Redis 服务器都存储相同的数据,很浪费内存,所以在redis3.0上加入了 Cluster 集群模式,实现了 Redis 的分布式存储,也就是说每台 Redis 节点上存储不同的内容。

集群的配置

根据官方推荐,集群部署至少要 3 台以上的master节点,最好使用 3 主 3 从六个节点的模式。在测试环境中,只能在一台机器上面开启6个服务实例来模拟。

1、修改配置文件

将 redis.conf 的配置文件复制6份(文件名最好加上端口后缀),然后开始修改配置文件中的参数

#开启redis的集群模式

cluster-enabled yes

#配置集群模式下的配置文件

cluster-config-file nodes-6379.conf

#集群内节点之间支持最长响应时间

cluster-node-timeout 15000

2、修改完毕之后启动 6 个 Redis 服务

3、快速部署集群

6个 Redis 服务启动成功之后,借助 redis-tri.rb 工具可以快速的部署集群,如果本机没有该命令行需要自行安装,只需要执行/redis-trib.rb create --replicas 1 127.0.0.1:6380 127.0.0.1:6381 127.0.0.1:6382 127.0.0.1:6383 127.0.0.1:6384 127.0.0.1:6385 就可以成功创建集群。

创建集群可能会出现的错误

#这是由于创建集群中的某一个服务中曾经插入过数据,并且已经产生了持久化文件,此时需要flushall命令清空所有数据

[ERR] Node 127.0.0.1:6380 is not empty. Either the node already knows other nodes (check with CLUSTER NODES) or contains some key in database 0

#这是由于之前创建集群遗留的配置文件导致的问题,使用命令cluster reset即可

redis-4.1.0/lib/redis/client.rb:124:in `call': ERR Slot 935 is already busy

集群的部署会在后续的文章中进行详细的说明和测试,这里就不详细说明了

集群的特点

- 所有的redis节点彼此互联(PING-PONG机制),内部使用二进制协议优化传输速度和带宽。

- 节点的fail是通过集群中超过半数的节点检测失效时才生效。

- 客户端与 Redis 节点直连,不需要中间代理层.客户端不需要连接集群所有节点,连接集群中任何一个可用节点即可。

集群的工作方式

在 Redis 的每一个节点上,都有这么两个东西,一个是插槽(slot),它的的取值范围是:0-16383。还有一个就是cluster,可以理解为是一个集群管理的插件。当我们的存取的 Key到达的时候,Redis 会根据 crc16的算法得出一个结果,然后把结果对 16384 求余数,这样每个 key 都会对应一个编号在 0-16383 之间的哈希槽,通过这个值,去找到对应的插槽所对应的节点,然后直接自动跳转到这个对应的节点上进行存取操作。

为了保证高可用,redis-cluster集群引入了主从模式,一个主节点对应一个或者多个从节点,当主节点宕机的时候,就会启用从节点。当其它主节点ping一个主节点A时,如果半数以上的主节点与A通信超时,那么认为主节点A宕机了。如果主节点A和它的从节点A1都宕机了,那么该集群就无法再提供服务了。

持久化机制

RDB持久化机制的优点

(1)RDB会生成多个数据文件,每个数据文件都代表了某一个时刻中redis的数据,这种多个数据文件的方式,非常适合做冷备

RDB也可以做冷备,生成多个文件,每个文件都代表了某一个时刻的完整的数据快照

AOF也可以做冷备,只有一个文件,但是你可以,每隔一定时间,去copy一份这个文件出来

RDB做冷备,优势在哪儿呢?由redis去控制固定时长生成快照文件的事情,比较方便; AOF,还需要自己写一些脚本去做这个事情,各种定时RDB数据做冷备,在最坏的情况下,提供数据恢复的时候,速度比AOF快

(2)RDB对redis对外提供的读写服务,影响非常小,可以让redis保持高性能,因为redis主进程只需要fork一个子进程,让子进程执行磁盘IO操作来进行RDB持久化即可

RDB,每次写,都是直接写redis内存,只是在一定的时候,才会将数据写入磁盘中

AOF,每次都是要写文件的,虽然可以快速写入os cache中,但是还是有一定的时间开销的,速度肯定比RDB略慢一些

(3)相对于AOF持久化机制来说,直接基于RDB数据文件来重启和恢复redis进程,更加快速AOF,存放的指令日志,做数据恢复的时候,其实是要回放和执行所有的指令日志,来恢复出来内存中的所有数据的RDB,就是一份数据文件,恢复的时候,直接加载到内存中即可

结合上述优点,RDB特别适合做冷备份,冷备

RDB持久化机制的缺点

(1)如果想要在redis故障时,尽可能少的丢失数据,那么RDB没有AOF好。一般来说,RDB数据快照文件,都是每隔5分钟,或者更长时间生成一次,这个时候就得接受一旦redis进程宕机,那么会丢失最近5分钟的数据

这个问题,也是rdb最大的缺点,就是不适合做第一优先的恢复方案,如果你依赖RDB做第一优先恢复方案,会导致数据丢失的比较多

(2)RDB每次在fork子进程来执行RDB快照数据文件生成的时候,如果数据文件特别大,可能会导致对客户端提供的服务暂停数毫秒,或者甚至数秒

一般不要让RDB的间隔太长,否则每次生成的RDB文件太大了,对redis本身的性能可能会有影响的

AOF持久化机制的优点

(1)AOF可以更好的保护数据不丢失,一般AOF会每隔1秒,通过一个后台线程执行一次fsync操作,最多丢失1秒钟的数据每隔1秒,就执行一次fsync操作,保证os cache中的数据写入磁盘中redis进程挂了,最多丢掉1秒钟的数据

(2)AOF日志文件以append-only模式写入,所以没有任何磁盘寻址的开销,写入性能非常高,而且文件不容易破损,即使文件尾部破损,也很容易修复

(3)AOF日志文件即使过大的时候,出现后台重写操作,也不会影响客户端的读写。因为在rewrite log的时候,会对其中的指导进行压缩,创建出一份需要恢复数据的最小日志出来。再创建新日志文件的时候,老的日志文件还是照常写入。当新的merge后的日志文件ready的时候,再交换新老日志文件即可。

(4)AOF日志文件的命令通过非常可读的方式进行记录,这个特性非常适合做灾难性的误删除的紧急恢复。比如某人不小心用flushall命令清空了所有数据,只要这个时候后台rewrite还没有发生,那么就可以立即拷贝AOF文件,将最后一条flushall命令给删了,然后再将该AOF文件放回去,就可以通过恢复机制,自动恢复所有数据

AOF持久化机制的缺点

(1)对于同一份数据来说,AOF日志文件通常比RDB数据快照文件更大

(2)AOF开启后,支持的写QPS会比RDB支持的写QPS低,因为AOF一般会配置成每秒fsync一次日志文件,当然,每秒一次fsync,性能也还是很高的如果你要保证一条数据都不丢,也是可以的,AOF的fsync设置成没写入一条数据,fsync一次,那就完蛋了,redis的QPS大降

(3)以前AOF发生过bug,就是通过AOF记录的日志,进行数据恢复的时候,没有恢复一模一样的数据出来。所以说,类似AOF这种较为复杂的基于命令日志/merge/回放的方式,比基于RDB每次持久化一份完整的数据快照文件的方式,更加脆弱一些,容易有bug。不过AOF就是为了避免rewrite过程导致的bug,因此每次rewrite并不是基于旧的指令日志进行merge的,而是基于当时内存中的数据进行指令的重新构建,这样健壮性会好很多。

(4)唯一的比较大的缺点,其实就是做数据恢复的时候,会比较慢,还有做冷备,定期的备份,不太方便,可能要自己手写复杂的脚本去做,做冷备不太合适

AOF的持久化配置

appendonly yes,可以打开AOF持久化机制,在生产环境里面,一般来说AOF都是要打开的,除非你说随便丢个几分钟的数据也无所谓

always: 每次写入一条数据,立即将这个数据对应的写日志fsync到磁盘上去,性能非常非常差,吞吐量很低; 确保说redis里的数据一条都不丢,那就只能这样了

everysec: 每秒将os cache中的数据fsync到磁盘,这个最常用的,生产环境一般都这么配置,性能很高,QPS还是可以上万的

no: 仅仅redis负责将数据写入os cache就撒手不管了,然后后面os自己会时不时有自己的策略将数据刷入磁盘,不可控了

AOF破损文件的修复

如果redis在append数据到AOF文件时,机器宕机了,可能会导致AOF文件破损

用redis-check-aof --fix命令来修复破损的AOF文件