集成算法 — 随机森林(Python3.6实现)

RandomForest 随机森林

在上一篇博文 “集成算法— 简介 + 决策树”中,简要介绍了集成算法的3种分类:Boosting、Bagging、Stacking以及它们经常使用的弱分类器—决策树(分类树和回归树)。集成算法可分为序列集成法和并行集成法:(1)序列集成法,是指参与训练的基础学习器按照顺序生成(如 AdaBoost),利用基础学习器之间的依赖关系,通过对之前训练中错误标记的样本赋值较高的权重,提高整体的预测效果;(2)并行集成法,是指其中参与训练的基础学习器并行生成(如 Random Forest),利用基础学习器之间的独立性,通过平均降低错误。

算法原理

1)每轮从数据集中抽取n个训练样本(在训练集中,有些样本可能被多次抽取到,而有些样本可能一次都没有被抽中),样本是有放回的抽取;

2)共进行k轮抽取,得到k个训练集(k个训练集之间是相互独立的);

3)对分类问题:对于将得到的k个模型采用投票的方式得到分类结果,各模型权重相等;对回归问题,计算k个模型的均值作为结果。

对于随机森林“随机”的理解

1)取样是随机的,并且是有放回的取样:

如果不是有放回的取样,那么每棵树都是没有交集的,是“有偏的”,尤其是对于样本量小或者是数据特征差别比较大的数据集,每棵树训练出来的预测结果差异会很大,而随机森林最后分类取决于多棵树的投票表决,因此若每棵树预测结果差异很大,那其对最终分类结果没有帮助。

2)随机选择特征,比如7个特征随机选5个:

在不知道哪些特征起作用,哪些特征不起作用的情况下,能防止过拟合,使结果更可靠

调用模型

from sklearn import datasets

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

iris = datasets.load_iris()

iris_x = iris.data

iris_y = iris.target

x_train, x_test, y_train, y_test = train_test_split(iris_x, iris_y, test_size = 0.3)

rf = RandomForestClassifier(criterion = 'entropy', max_depth = 3, n_estimators = 5, random_state = 300)

rf = rf.fit(x_train, y_train)

rf_result = rf.predict(x_test)

print(rf.result[:5])

[2 2 2 1 0]

rf_pro = rf.predict_proba(x_test)

print(rf_pro[:5])

[[0. 0. 1. ]

[0. 0.25428571 0.74571429]

[0. 0. 1. ]

[0. 0.98133874 0.01866126]

[1. 0. 0. ]]

rf.score(x_test, y_test)

0.9777777777777777

feature_names = ['petallength', 'petalwidth', 'petaldeep', 'petalshape']

[*zip(feature_names, rf.feature_importances_)]

#各特征在模型中的贡献度

[('petallength', 0.09437720216915173),

('petalwidth', 0.021342040735077016),

('petaldeep', 0.3588292628452025),

('petalshape', 0.5254514942505688)]

重要参数

RandomForest的重要参数和之前讲的决策树的重要参数有很多重复的。

RandomForestClassifier (n_estimators= 10, criterion=gini, max_depth=None, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features= auto, max_leaf_nodes=None, min_impurity_decrease=0.0, min_impurity_split=None, random_state=None, class_weight=None, bootstrp = True)

n_estimators:建几棵树,一般所建树数量越多,预测效果越好。

criterion:决策树算法有entropy(信息增益), gini(CART)两种,默认gini。

剪枝参数:

max_depth:决策树最大深度,默认值是‘None’,常用的可以取值10-100之间。

min_samples_split:内部节点再划分所需最小样本数,默认值为2。

min_samples_leaf:叶子节点最少样本数,默认值为1。

max_features:在划分数据集时考虑的最多的特征值数量。

精修参数:

max_leaf_nodes:最大叶子节点数,默认为None。min_impurity_decrease:节点划分最小不纯度。默认值为0。

min_impurity_split:信息增益的阀值,决策树在创建分支时,信息增益必须大于这个阀值,否则不分裂。

min_weight_fraction_leaf:叶子节点最小的样本权重和,默认为0,所有样本的权重相同。

min_impurity_decrease:节点划分最小不纯度,默认值为‘0’,如果某节点的不纯度(基尼系数,信息增益,均方差,绝对差)小与这个阈值,则该节点不再生成子节点。

其他参数:

class_weight:指定样本各类别的权重,balanced,算法自己计算权重,不适用于回归树。

random_state:默认是None,可填任意数值。

bootstrp:是否对样本集进行有放回抽样,默认值True。画学习曲线调参

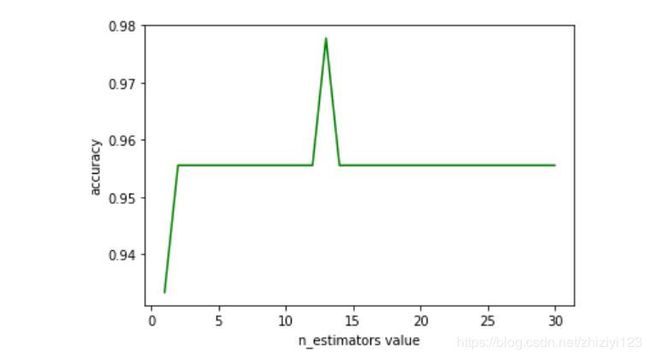

随机森林分类模型中最重要的参数是n_estimators,下面改变这个参数的数值画出学习曲线,确定最佳预测模型。

from sklearn import datasets

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

import matplotlib.pyplot as plt

iris = datasets.load_iris()

iris_x = iris.data

iris_y = iris.target

x_train, x_test, y_train, y_test = train_test_split(iris_x, iris_y, test_size = 0.3)

rf_scores = []

for i in range(30):

rf = RandomForestClassifier(criterion = 'entropy', max_depth = 3, n_estimators = i+1, random_state = 300)

rf = rf.fit(x_train, y_train)

scores = rf.score(x_test, y_test)

rf_scores.append(scores)

plt.plot(range(1, 31), rf_scores, color = 'green')

plt.xlabel('n_estimators value')

plt.ylabel('accuracy')

从图中可以看出n_estimator的数值在12~14范围内时,模型预测准确率最高。