深度补全(Single-Image Depth Perception in the Wild)

Single-Image Depth Perception in the Wild

arXiv:1604.03901v2 [cs.CV] 6 Jan 2017

Abstract

本文研究了户外的深度感知,即从无约束设置下单个图像恢复深度。本文介绍了一种新的户外数据集深度,由户外的图像组成,这些图像在随机点对之间用相对深度标注。我们还提出了一种利用相对深度的标注来学习度量深度估计的新算法。与目前的技术水平相比,我们的算法更简单,性能更好。实验表明,我们的算法结合了现有的RGB-D数据和新的相对深度标注,显著提高了户外单幅图像的深度感知。

1. 介绍

从单个RGB图像获取深度是视觉的一个基本问题。近年来,由于数据驱动方法[1,2,3]的出现,特别是对大型RGB-D数据集进行深度神经网络训练[4,5,6,7,8,9,10]。但这些进展尚未对更高级别的任务产生广泛影响。原因之一是,许多高级任务必须对拍摄的户外图像进行操作,而对摄像机、位置、场景和对象没有任何限制,但是用于训练和评估图像到深度系统的RGB-D数据集以这样或那样的方式受到限制。

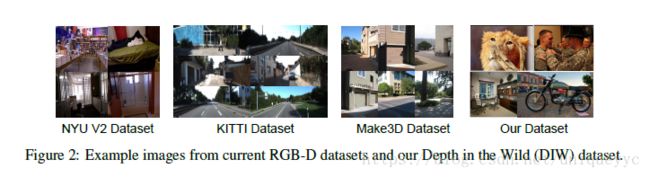

目前的RGB-D数据集是由深度传感器收集的[4,5],深度传感器的范围和分辨率有限,在镜面或透明物体[11]上常常出现故障。此外,由于RGB-D图像没有Flickr,研究人员不得不手动捕捉图像。因此,当前的RGB-D数据集在场景多样性方面受到限制。例如,NYU deep[4]主要由室内场景组成,没有人在场;KITTI[5]主要由汽车拍摄的公路场景组成;Make3D[3,12]主要由斯坦福校园的户外场景组成(图2)。虽然这些数据集在驱动研究中起着关键作用,但目前尚不清楚在这些数据集上训练的系统能否推广到野外图像。

是否有可能为户外图像收集地面真相深度?在无约束条件下使用深度传感器尚不可行。众包似乎是可行的,但人类并不擅长估算度量深度,或者一般[13]的3D度量结构。事实上,从单个图像得到的度量深度从根本上来说是模糊的:房子后面的树可以稍微大一点但离得更远,或者稍微小一点但离得更近一点,房子和树之间的绝对深度差异无法唯一确定。此外,即使在人们可以估计度量深度的情况下,也不清楚如何从它们中提取值。

但人类更善于判断相对深度****[13]:点A比点B更接近吗?对人类来说,这通常是一个容易得多的问题。Zoran等人最近的研究表明,仅使用相对深度的注释来估计度量深度是可能的。虽然这样的度量深度估计仅适用于单调变换,但对于高级任务,特别是对于遮挡推理,它们可能非常有用。Zoran等人的开创性成果指出了两方面有待进一步发展:(1)收集了大量户外图像的相对深度注释;(2)改进了从相对深度注释中学习的算法。

在本文中,我们在这两个方面都做了贡献。我们的第一个贡献是一个新的数据集叫做“Depth in theWild”(DIW)。它由495K不同的图像组成,每个图像都用随机采样点及其相对深度标注。我们对每幅图像的一对点进行抽样,以最小化注释的冗余。据我们所知,这是第一个由户外图像和相对深度注释组成的大型数据集。我们证明该数据集可以作为评估基准和训练数据。

我们的第二个贡献是一个新的算法,用来学习仅使用相对深度的注释来估计度量深度。我们的算法不仅明显优于Zoran等人的[14],而且更简单。Zoran等人的算法首先学习了一个分类器来预测图像中两个点之间的序数关系。给出一个新的图像,这个分类器被反复用于预测稀疏集点对之间的序数关系(主要在相邻的超像素中心之间)。然后,该算法通过求解一个约束二次优化问题,从预测的序数关系中重构深度,约束二次优化使附加的平滑约束和协调潜在的不一致的序数关系。最后,算法估计了所有像素的深度,假设每个超像素的深度不变。

相比之下,我们的算法由一个直接预测像素深度的单一深度网络组成(图1)。网络以整个图像作为输入,由现成的组件组成,完全可以通过相对深度的标注进行训练。我们的方法的新颖之处在于结合了两方面的因素:(1)多尺度深度网络,产生像素级的度量深度预测;(2)使用相对深度的损失函数。实验表明,我们的方法产生的像素级深度更加精确,不仅优于Zoran等人的方法[14],而且优于Eigen等人的最先进的图像深度系统[8],该系统使用地面真实度度量深度进行训练。此外,结合我们的新算法、新数据集和现有的RGB-D数据,可以显著改善户外的单图像深度估计。

2. 相关工作

RGB-D数据集:先前构建RGB-D数据集的工作依赖于Kinect[4,15,16,17]或LIDAR[3,5]。现有的基于kinect的数据集仅限于室内场景;现有的激光数据集偏向于人造结构的场景[3,5]。相反,我们的数据集涵盖了更广泛的场景:通过大规模的众包和数量有限的互联网图像,它可以很容易地扩展。

Intrinsic Images in the Wild:我们的工作从Intrinsic Images in the Wild中获得灵感,这是一部开创性的作品,它将相对反射率的注解众包在无约束的影像上。我们的工作在目标和几个设计决策上是不同的。首先,我们对随机点而不是超像素中心进行采样,因为与反射不同,在超像素内假设一个恒定的深度是不合理的。其次,我们对每幅图像只采样一对点,而不是多个点,以最大化人工注释的价值。

单一图像的深度:图像到深度是一个长期存在的问题,大量的文献[1,6,7,8,9,10,12,19,19,20,21,22,23,24,25,26]。最近深度神经网络和RGB-D数据集的融合[4,5]导致了重大进展[6,8,10,14,27,28]。但是,除了[14]之外,之前这些作品中的网络都是专门使用地面真实度度量深度进行训练的,而我们的方法使用的是相对深度。

我们的工作受到Zoran等人的启发,[14]提出利用深度网络来重复分类基于超像素分割的采样点对,并通过解决一个额外的优化问题来重建每个像素的度量深度。我们的方法不同:它由一个经过训练的端到端单一深网络组成,直接预测每像素的度量深度;顺序关系没有中间分类,因此不需要优化来解决不一致。

用序数关系学习:最近的几个成果[29,30]都使用了从户外数据集[18]的固有图像中得到的序数关系来估计表面反射。与Zoran等人[14]相似,Zhou等人[29]首先学习了一个深度网络来分类点对之间的序数关系,然后通过能量最小化使它们全局一致。

Narihira等人的[30]学习了一种利用图像块预测中心像素的度量反射率的明度势网络。但是这个网络只适用于稀疏的像素集。虽然理论上这种亮度势网络可以应用于每个像素,以产生像素级的反射,但这样做是相当昂贵的。完全卷积(正如作者在[30]中提到的那样)只解决了部分问题:只要lightness potential network具有向下采样层(在[30]中就是这样),最终的输出就会相应地向下采样。因此需要增加额外的分辨率(如移位和缝合方法[31])。相比之下,我们的方法完全避免了这些问题,并直接输出像素级估计。

除了固有图像外,序数关系在计算机视觉和机器学习中被广泛使用,包括对象识别[32]和学习排序[33,34]。

3. 数据集的重建

我们从Flickr上收集图片。我们使用从英语词典中抽取的随机查询关键字,排除人工图像,如绘图和剪辑艺术。为了收集相对深度的注释,我们向一个人群工作者展示了一幅图像和两个突出的点(图3),问哪个点更接近,1点,2点,还是难以分辨?工人按下一个键回应。

多少双?每个图像应该查询多少对点?我们只对每张图片进行抽样,因为这样可以最大化来自人类注释器的信息量。考虑另一种极端情况,即在同一幅图像中查询所有可能的点对。这是一种浪费,因为近距离的点对可能具有相同的相对深度。换句话说,从同一映像查询多一对可能比从新映像查询多一对可能增加更少的信息。因此,对每个映像只查询一对更划算。