Cloudera HUE大数据可视化分析

1.Hue 概述及版本下载

1)概述

Hue是一个开源的Apache Hadoop UI系统,最早是由Cloudera Desktop演化而来,由Cloudera贡献给开源社区,它是基于Python Web框架Django实现的。通过使用Hue我们可以在浏览器端的Web控制台上与Hadoop集群进行交互来分析处理数据,例如操作HDFS上的数据,运行MapReduce Job等等。

2)下载

(由于之前安装Hive的版本为0.13,所以我们选择安装hue-3.7.0-cdh5.3.6版本,因为3.9.0版本的hue所需的hive最低版本要求高于0.13)

CDH版本下载

官网下载

2.编译安装

1)上传解压(拟安装在第三台主机)

tar -zxf hue-3.7.0-cdh5.3.6.tar.gz -C /opt/modules/2)安装依赖包

sudo yum install ant asciidoc cyrus-sasl-devel cyrus-sasl-gssapi gcc gcc-c++ krb5-devel ibtidy libxml2-devel libxslt-devel openldap-devel python-devel sqlite-devel openssl-devel mysql-devel gmp-devel注:执行以下命令时需要连接外网,所以需要将网络配置为自动获取(DHCP)模式,下载安装完成后再将网络配置回来。

依赖包参考此连接。

3)编译

cd hue-3.7.0-cdh5.3.6

make apps

这样出现了build目录即表示make成功!

Hue的所有操作命令都在bin目录下。

3.Hue 基本配置与服务启动

1)修改配置文件

[kfk@bigdata-pro03 hue-3.7.0-cdh5.3.6]$ cd desktop/

[kfk@bigdata-pro03 desktop]$ ls

conf core desktop.db libs logs Makefile

[kfk@bigdata-pro03 desktop]$ cd conf/

[kfk@bigdata-pro03 conf]$ ll

total 52

-rw-r--r-- 1 kfk kfk 41350 Nov 10 2015 hue.ini

-rw-r--r-- 1 kfk kfk 1843 Nov 10 2015 log4j.properties

-rw-r--r-- 1 kfk kfk 1721 Nov 10 2015 log.conf做如下配置:

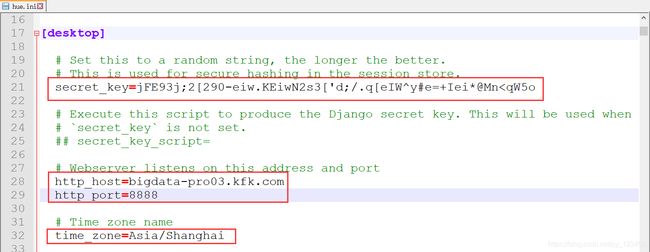

vi hue.ini

#秘钥

secret_key=jFE93j;2[290-eiw.KEiwN2s3['d;/.q[eIW^y#e=+Iei*@Mn2)修改desktop.db 文件权限

sudo chmod o+w desktop/desktop.db

sudo chown -R kfk:kfk desktop/desktop.db3)启动Hue服务

./build/env/bin/supervisor

4)查看Hue web界面

bigdata-pro03.kfk.com:8888

4.Hue与HDFS集成

1)修改hue.ini配置文件

fs_defaultfs=hdfs://ns

webhdfs_url=http://bigdata-pro01.kfk.com:50070/webhdfs/v1

hadoop_hdfs_home=/opt/modules/hadoop-2.6.0

hadoop_bin=/opt/modules/hadoop-2.6.0/bin

hadoop_conf_dir=/opt/modules/hadoop-2.6.0/etc/hadoop2)修改core-site.xml配置文件

添加如下内容

hadoop.proxyuser.hue.hosts

*

hadoop.proxyuser.hue.groups

*

3)将core-site.xml配置文件分发到其他节点

scp core-site.xml bigdata-pro02.kfk.com:/opt/modules/hadoop-2.6.0/etc/hadoop

scp core-site.xml bigdata-pro01.kfk.com:/opt/modules/hadoop-2.6.0/etc/hadoop4)重新启动hue

首先启动Hadoop集群

sbin/start-dfs.sh再启动hue

./build/env/bin/supervisor5.Hue与YARN集成

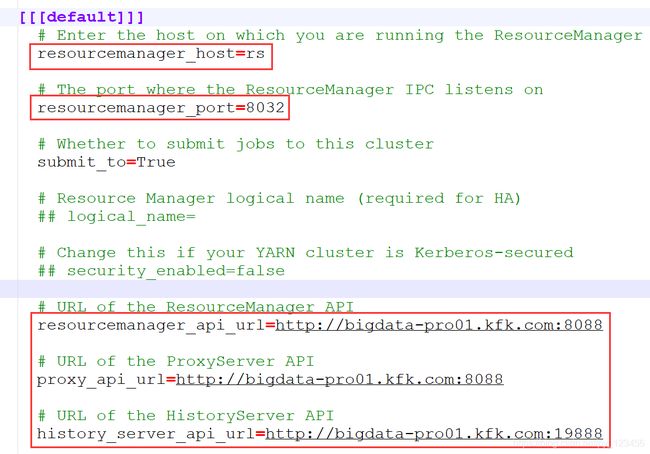

修改hue.ini配置文件

resourcemanager_host=rs

resourcemanager_port=8032

submit_to=true

resourcemanager_api_url=http://bigdata-pro01.kfk.com:8088

proxy_api_url=http://bigdata-pro01.kfk.com:8088

history_server_api_url=http://bigdata-pro01.kfk.com:198886.Hue与Hive集成

修改hue.ini配置文件

hive_server_host=bigdata-pro03.kfk.com

hive_server_port=10000

hive_conf_dir=/opt/modules/hive-0.13.1-cdh5.3.0/conf7.Hue与mysql集成

1)修改hue.ini配置文件

nice_name="My SQL DB"

name=metastore

engine=mysql

host=bigdata-pro01.kfk.com

port=3306

user=root

password=root2)重新启动hue

在这之前需要先启动数据库服务、hive服务和hiveserver2。

#启动数据库(节点1)

sudo service mysqld start

mysqld -uroot –proot

#启动Hive和hiveserver2(节点3)

bin/hive

bin/ hiveserver2

#启动hue

./build/env/bin/supervisor8.Hue与HBase集成

1)修改hue.ini配置文件

hbase_clusters=(Cluster|bigdata-pro01.kfk.com:9090)

hbase_conf_dir=/opt/modules/hbase-0.98.6-cdh5.3.0/conf2)HBase中启动thrift服务(节点1)

bin/start-hbase.sh

bin/hbase-daemon.sh start thrift3)重新启动hue

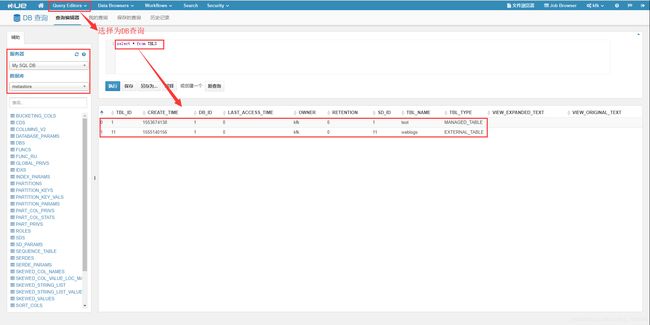

./build/env/bin/supervisor搜索浏览量前5的新闻:

select count(1) ssum,searchname from weblogs where 1=1 group by searchname order by ssum desc limit 5;提交之后的执行过程如下所示:

结果展示(由于当初导入数据时我没有全部导入,所以结果只是部分数据的统计结果):

结果展示(由于当初导入数据时我没有全部导入,所以结果只是部分数据的统计结果):

9.Hue使用注意事项

1)如果hive版本不是cdh版本的时候回存在无法打印日志到hue界面的问题,解决方法:hive启动使用后台启动方式:

nohup bin/hiveserver2 &2)hue使用稳定版本:hue-3.7.0-cdh5.3.6

以上就是博主为大家介绍的这一板块的主要内容,这都是博主自己的学习过程,希望能给大家带来一定的指导作用,有用的还望大家点个支持,如果对你没用也望包涵,有错误烦请指出。如有期待可关注博主以第一时间获取更新哦,谢谢!同时也欢迎转载,但必须在博文明显位置标注原文地址,解释权归博主所有!