【学习记录-街景字符识别】TASK3:字符识别模型

街景字符识别-字符识别模型

- 1.CNN基础和原理

- 1.1 CNN介绍

- 1.2 CNN 发展

- 2.Pytorch构建CNN模型

- 小结

本文的任务是构建一个定长字符识别模型。

1.CNN基础和原理

1.1 CNN介绍

- 全连接神经网络的缺点:

1.图像变大导致色彩数变多,不好解决;

2.不便处理高维度数据。

基于全连接神经网络的缺点,卷积神经网络应运而生。

- 卷积神经网络(简称CNN)是一类特殊的人工神经网络,是深度学习中重要的一个分支,在很多领域都表现优异,精度和速度比传统计算学习算法高很多,特别是在计算机视觉领域,是解决图像分类,图像检索,物体检测和语义分割的主流模型。

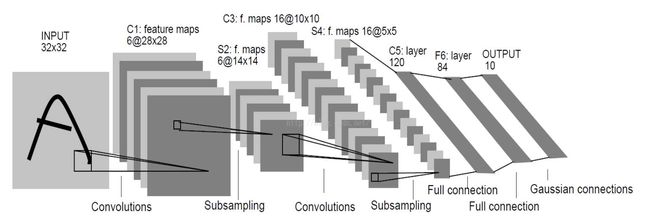

模型结构图:

模型包括输入层(Input layer)、卷积层(convolutional layer)、池化层(pooling layer)和输出层(全连接层+softmax layer)。与全连接神经网络的区别在于CNN总有至少一个卷积层,而且卷积层级之间的神经元是局部连接和权值共享,这样的设计大大减少了(w,b)的数量,加快了训练。

上图为LeNet网络结构,是非常经典的字符识别模型。两个卷积层,两个池化层,两个全连接层组成。卷积核都是5*5,stride=1,池化层使用最大池化。

通过多次卷积和池化,CNN的最后一层将输入的图像像素映射为具体的输出。如 在分类任务中会转换为不用类别的概率输出,然后计算真是标签与CNN模型预测结果的差异,并通过反向传播更新每层的参数,并在更新完成后再次前向传播,如此反复直到训练完成。

与传统的机器学习模型相比,CNN具有一种端到端的思路,在CNN训练的过程中是直接从图像像素到最终的输出,并不涉及到具体的特征提取和构建模型的过程,也不需要人工的参与。

1.2 CNN 发展

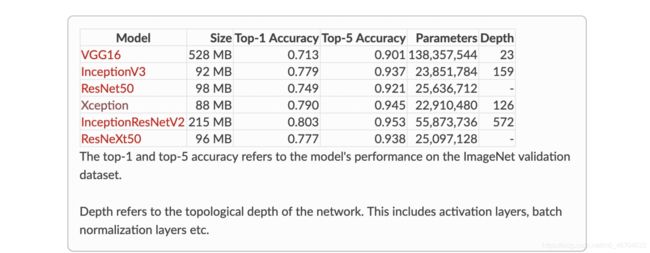

随着网络结构的发展,研究人员最初发现网络模型结构越深、网络参数越多模型的精度更优。比较典型的是AlexNet、VGG、InceptionV3和ResNet的发展脉络。

2.Pytorch构建CNN模型

此模型包括两个卷积层,最后并联6个全连接层进行分类。

import torch

torch.manual_seed(0)

torch.backends.cudnn.deterministic=False

torch.backends.cudnn.benchmark=True

import torchvision.models as models

import torchvision.transforms as transforms

import torchvision.datasets as datasets

import torch.nn as nn

import torch.nn.functional as F

import torch.optim as optim

from torch.autograd import Variable

from torch.utils.data.dataset import Dataset

#

#定义模型

class SVHN_Model1(nn.Module):

def _init_(self):

super(SVHN_Model1,self)._init_()

#CNN提取特征模块

self.cnn=nn.Sequential(

nn.Conv2d(3,16,kernel_size=(3,3),stride=(2,2)),

nn.ReLU(),

nn.MaxPool2d(2),

nn.Conv2d(16,32,kernel_size=(3,3),stride=(2,2)),

nn.ReLU(),

nn.MaxPool2d(2))

self.fc1=nn.Linear(32*3*7,11)

self.fc2=nn.Linear(32*3*7,11)

self.fc3=nn.Linear(32*3*7,11)

self.fc4=nn.Linear(32*3*7,11)

self.fc5=nn.Linear(32*3*7,11)

self.fc6=nn.Linear(32*3*7,11)

def forward(self,img):

feat=self.cnn(img)

feat=feat.view(feat.shape[0],-1)

c1=self.fc1(feat)

c2=self.fc1(feat)

c3=self.fc1(feat)

c4=self.fc1(feat)

c5=self.fc1(feat)

c6=self.fc1(feat)

return c1,c2,c3,c4,c5,c6

model=SVHN_Model1()

训练代码:

#

# 损失函数

criterion = nn.CrossEntropyLoss()

#

# 优化器器

optimizer = torch.optim.Adam(model.parameters(), 0.005)

loss_plot, c0_plot = [], []

#

# 迭代10个Epoch

for epoch in range(10):

for data in train_loader:

c0, c1, c2, c3, c4, c5 = model(data[0])

loss = criterion(c0, data[1][:, 0]) + \

criterion(c1, data[1][:, 1]) + \

criterion(c2, data[1][:, 2]) + \

criterion(c3, data[1][:, 3]) + \

criterion(c4, data[1][:, 4]) + \

criterion(c5, data[1][:, 5])

loss /= 6

optimizer.zero_grad()

loss.backward()

optimizer.step()

loss_plot.append(loss.item())

c0_plot.append((c0.argmax(1) == data[1][:, 0]).sum().item()*1.0 / c0.shape[0])

print(epoch)

为了追求精度,也可以使用在ImageNet数据集上的预训练模型:

class SVHN_Model2(nn.Module):

def __init__(self):

super(SVHN_Model2,self).__init__()

model_conv=models.resnet18(pretrained=True)#torch.load('resnet18-5c106cde.pth')这里可以更改为这个权重

model_conv.avgpool=nn.AdaptiveAvgPool2d(1)

model_conv=nn.Sequential(*list(model_conv.children())[:-1])

self.cnn=model_conv

self.fc1=nn.Linear(512,11)

self.fc2=nn.Linear(512,11)

self.fc3=nn.Linear(512,11)

self.fc4=nn.Linear(512,11)

self.fc5=nn.Linear(512,11)

def forward(self,img):

feat=self.cnn(img)

print(feat.shape)

feat=feat.view(feat.shape[0],-1)

c0=self.fc1(feat)

c1=self.fc1(feat)

c2=self.fc1(feat)

c3=self.fc1(feat)

c4=self.fc1(feat)

return c0,c1,c2,c3,c4

小结

本文介绍了CNN以及CNN的发展,并用Pytorch构建了一个简易的CNN模型来完成字符分类任务。