每天一篇论文 327/365 Instance-wise Depth and Motion Learning from Monocular Videos

每天一篇论文汇总list

Instance-wise Depth and Motion Learning from Monocular Videos

摘要

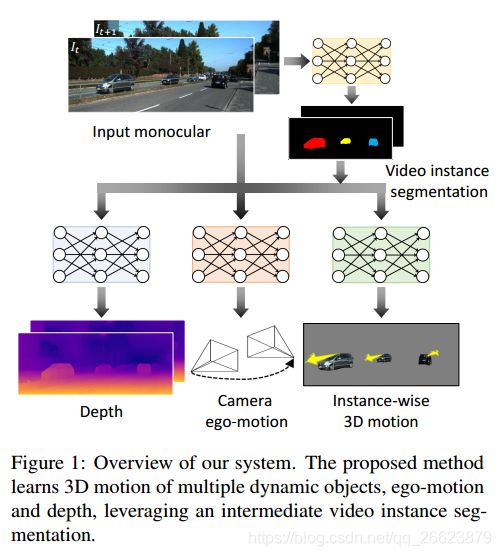

我们提出了一个端到端的联合训练框架,在没有监督的情况下,直接模拟了多个动态物体的6自由度运动、Ego-motion和深度。

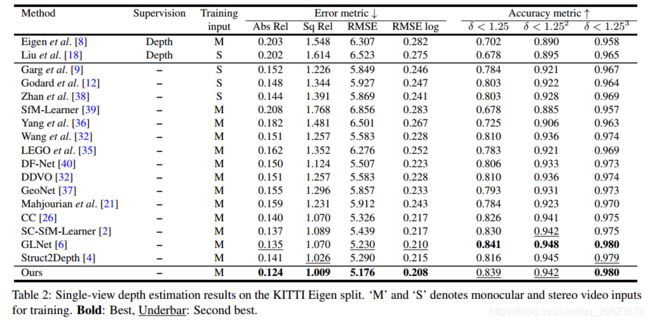

在我们的框架中使用的唯一注释是一个视频实例分割图,它可以由我们新的自动注释方案进行预测。我们的贡献主要三个方面。首先,我们提出了一个可微的前向刚性投影模块,它在我们的实例深度和运动学习中起着关键作用。其次,我们设计了一个实例级的光度和几何一致性损失,有效地分解背景和运动目标区域。最后,我们提出了一个不需要额外迭代训练的实例级小批量重组方案。这些元素在一个详细的渐变研究中得到了验证。通过在KITTI数据集上进行的大量实验,我们的框架被证明优于最新的深度和运动估计方法。

方法

本文的核心思想就是把实例分割的对象作为一个warp加入到深度估计中,为深度估计和object的位姿进行估计。

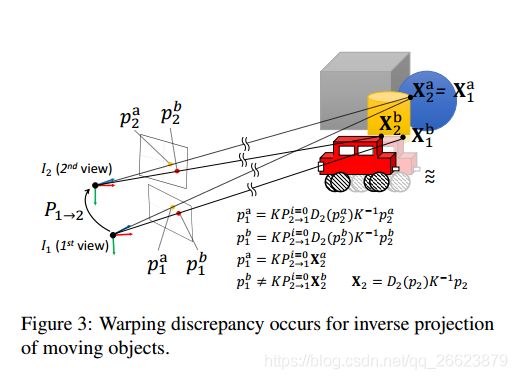

运动物体中当发生遮挡时

投影