hadoop伪分布式配置的全部流程!!!,记录下第一篇博客

准备工作

1,准备虚拟机,我准备的centOS 6.5 (可能有点老)!!

2,所需 软件 Oracle VM VirtualBox ,FZ ,Xshell

**3,环境,我搞得 jdk 1.7 /hadoop 2.6.5 **

配置ssh免密

修改vm 网络配置

查看linux IP地址

修改ip地址

1,命令 : sudo vi /etc/sysconfig/network-scripts/ifcfg-eth0 这是6.5的命令!!

生效ip 重启虚拟机

2,修改/etc/hosts 文件

root 权限执行 “ **vi/etc/hosts ** 在末尾加上 # 填写的ip地址与主机名

设置ssh免密登陆

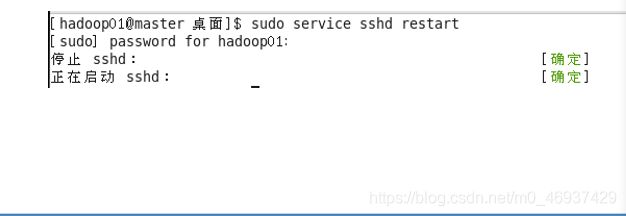

1,启动ssh服务

命令:service sshh start

检查ssh是否已经安装成功!!

出现以上信息表示ssh正常启动

** 生成ssh 公钥**

命令 :ssh-keygen -t rsa

![]()

拷贝密钥到本机的authorized_keys列表

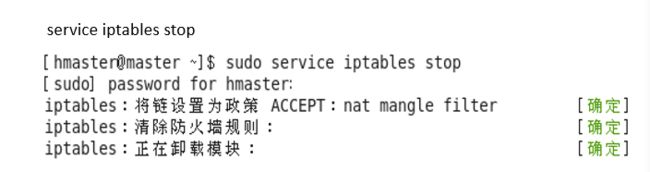

关闭防火墙

临时关闭

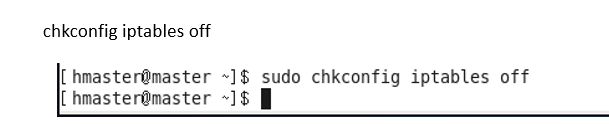

永久关闭

xshell连接测试

无需输入密码表示成功!!

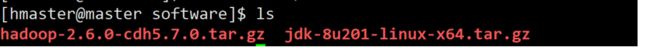

jdk + hadoop 环境安装

上传用的工具

~~

- 这两个都可以啊,软件不会用我也救不了了。

~~

设置linux目录结构

![]()

software目录 :放置软件安装包

app目录:所有的软件安装目录

data目录:存放数据

lib目录:存放任务的jar包

shell目录:存放任务的shell脚本

maven-resp目录:存放需要用到的依赖包

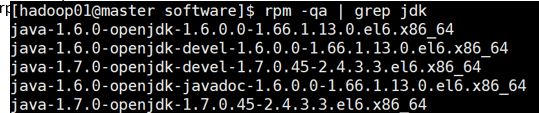

配置jdk

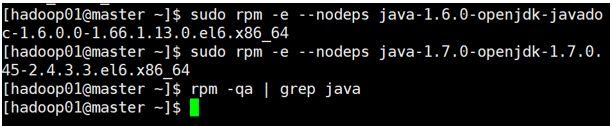

查看当前系统的jdk,如果出现openjdk则需要删除!!!

查看命令:rpm -qa | grep jdk

删除命令: rpm -e --nodeps …

把上传好的解压到app目录下

命令: tar -zxvf jdk-8u201-liunx-x64.tar.gz - C ~/app/

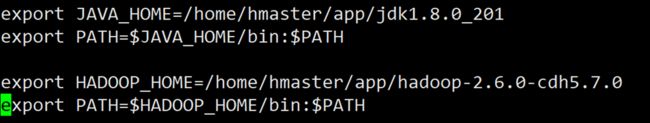

配置环境变量

sudo vi /etc/porfile

- 注:在最下面修改 按住大写G直接就到了最下面了!!!!

生效配置文件

命令:source /etc/profile

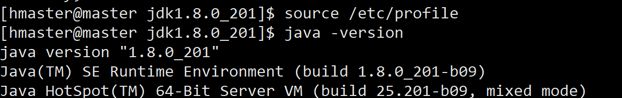

检查安装成功没!!

命令:java -version

配置Hadoop

解压

命令 :tar -zxvf hadoop-2.6.0-cdh5.7.0.tar.gz -C ~/app/

配置hadoop-env.sh

位置在 cd/etc/hadoop

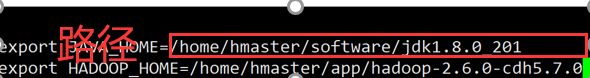

在末尾加环境变量,java跟hadoop的

*配置core-site.xml

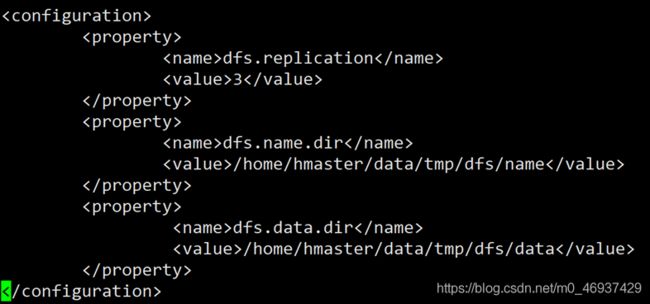

修改hdfs-site.xml

修改slaves文件

修改配置文件,把HADOOP_HOME追加上去

命令:sudo vi /etc/porfile

文件生效

source /etc/profile

格式化hadoop

1,进入bin目录在执行命令hadoop namenode-format

不可重复执行

出现这个为成功!!

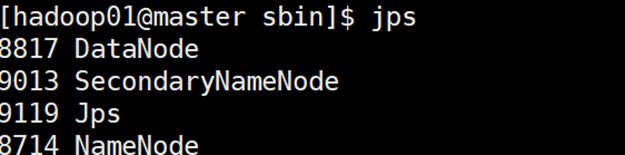

**启动hadoop **

进入sbin目录下执行命令 start-dfs.sh

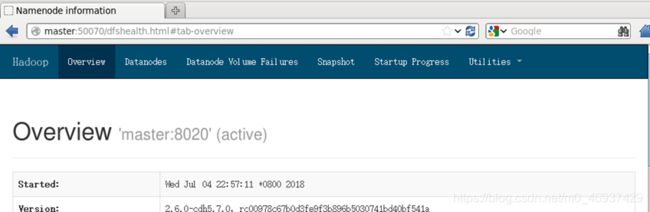

检查hadoop

如果出现以上四个进程表示成功!!!

可以通过在虚拟机浏览器中输入 http://master:50070

或者在windows系统输入 http:虚拟机的ip地址:50070

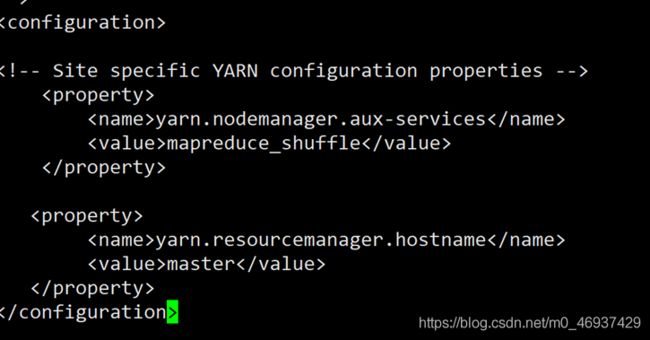

配置Yarn

修改yarn-site.xml

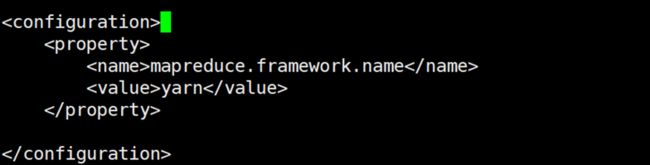

修改mapred-site.xml

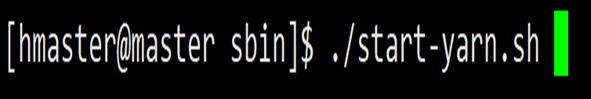

启动yarn查看进程

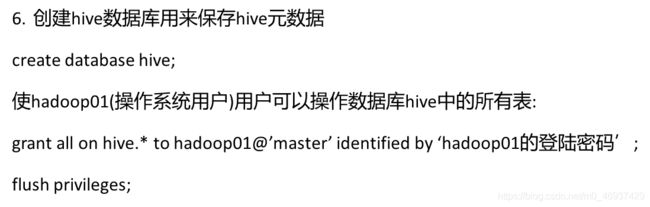

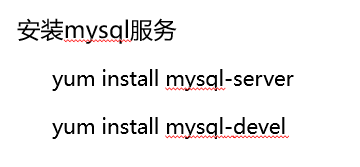

安装Mysql ,hive使用会用到mysql所以要安装哈!!

hive在使用的时候会用到mysql数据库的支持,所以在安装hive前必须先安装mysql数据库,由于在安装mysql数据库的时候会使用到yum,所以需要把网络打开,确保可连接互联网

- 1,安装mysql服务

**启动&&停止服务

**

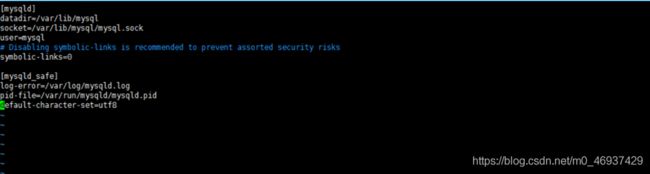

**1,在mysql配置文件/etc/my.cnf中加入default-character-set=utf8

vim /etc/my.cnf

**

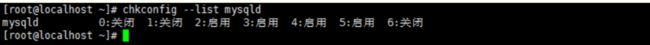

**2,设置开机自启动

chkconfig mysqld on

chkconfig --list mysqld

**

**3,启动mysql

service mysqld start

**

4,登陆mysql

root用户登陆

mysqladmin -u root password 123456

mysql -u root -p

5,忘记密码

sudo service mysqld stop

mysqld_safe --user=root --skip-grant-tables

mysql -u root

use mysql

update user set password=pasword(“new_pass”) where user=“root”;

flush privileges;

6,bug处理

ERROR 1045 (28000): Access denied for user ‘root’@‘localhost’ (using password: YES)

密码错误

密码正确还是无法登陆

停止mysql服务器

service mysqld stop

使用mysqld_safe命令在启动mysql,更新root账号的密码

mysqld_safe --user=mysql --skip-grant-tables --skip-networking &:

注:–skip-grant-tables:不启动grant-tables(授权表),跳过权限控制。

–skip-networking :跳过TCP/IP协议,只在本机访问(从网上有些资料看,这个选项不是必须的。可以不用)

执行上面命令后,此会话窗口会出现无反应的状态,需要使用CTRL+C中断会话

7,设置密码

mysql -u root mysql

mysql> update user set password=PASSWORD(‘12345’)

-> where user=‘root’ and host=‘root’ or host=‘localhost’;

flush privileges

启动mysql服务

命令:service mysqld start

注意:如果启动报错,请重启mysql的服务 sudo service mysqld restart

安装hive

在安装完mysql以后就可以进行hive的安装

下载hive的压缩包,官网有哈!!!!

解压hive的压缩文件

tar -zxvf ~/app/hive-1.10-cdh5.7.0.tar.gz

修改hive-site.xml文件

hive解压文件的conf目录中使用hadoop01用户创建文件hive-site.xml

cp hive-site.xml.tmplate hive-site.xml

加入下面的配置文件

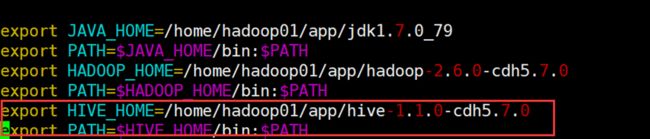

配置环境变量!!

在/etc/profile文件末尾最佳hive的环境变量

验证安装成功没!!!

启动Hadoop和MySQL,然后执行

hive

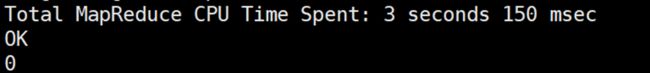

进入Hive命令行,执行命令,创建一个名为test的表,并查询该表的记录数

create table test(id int);

select count(*) from test;

观察结果,出现下面为成功!!!

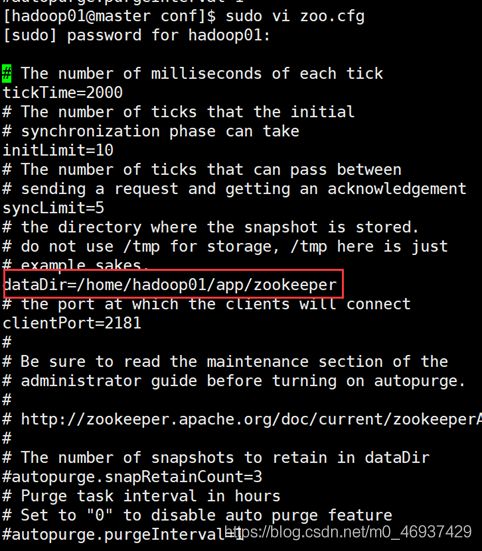

配置zookeeper

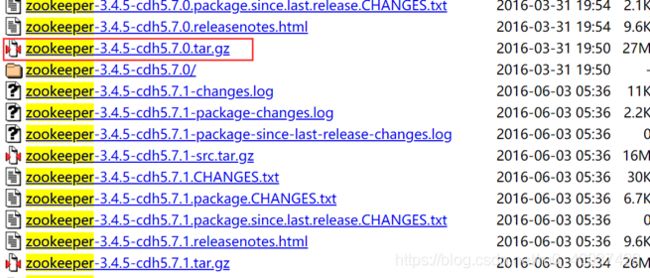

下载 http://archive-primary.cloudera.com/cdh5/cdh/5/

解压

tar -zxvf zookeeper-3.4.5-cdh5.7.0.tar.gz

复制Zookeeper的zoo_sample.cfg配置文件

进入 zookeeper 的 conf 目录下,找到 zoo_sample.cfg 文件。首先将 zoo_sample.cfg 文件备份,并重命名为 zoo.cfg

dataDir 默认是 /tmp/zookeeper,由于 /tmp 是 Ubuntu 的 临时目录,这个路径下的数据不能长久保存,因此需要指定到别的目录。

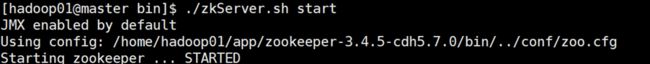

启动 Zookeeper

进入bin目录,执行sudo ./zkServer.sh start

使用 status 参数来查看 zookeeper 的状态

HBase在使用Zookeeper的时候可以有两种方式1、使用本身自带的Zookeeper进行管理2、使用外部的Zookeeper的集群进行管理,在生产环境中一般使用后一种,上面的配置的是只有一个节点的伪分布Zookeeper配置。

Hease安装

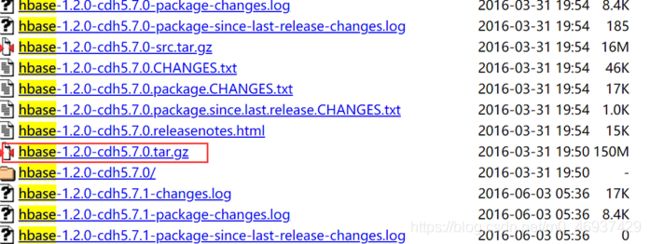

下载hbase

http://archive-primary.cloudera.com/cdh5/cdh/5/

上传解压

tar -zxvf hbase-1.2.0-cdh5.7.0.tar.gz

配置环境变量

sudo vi /etc/profile

使环境变量生效

source /etc/profile

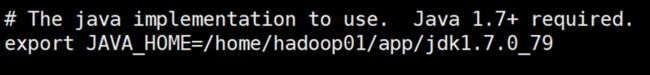

修改hbase-env.sh

sudo vi hbase-env.sh

修改hbase-env.sh文件,添加如下配置:

export JAVA_HOME=/home/hadoop01/app/jdk1.7.0_79

export HBASE_CLASSPATH=/home/hadoop01/app/hadoop-2.6.0-cdh5.7.0/etc/hadoop

export HBASE_MANAGES_ZK=false

- hbase-env.sh配置文档中的HBASE_MANAGES_ZK的默认值是true,它表示HBase使用自身自带的Zookeeper实例。如果你是使用hbase自带的zk就是true,如果使用外部的zk就是false

修改regionservers文件

如果是完全分布式模式,则regionservers为:

slave1

slave2

……

如果是伪分布模式,则regionservers为:

master

我们试伪分布式所以用下面的啊!!

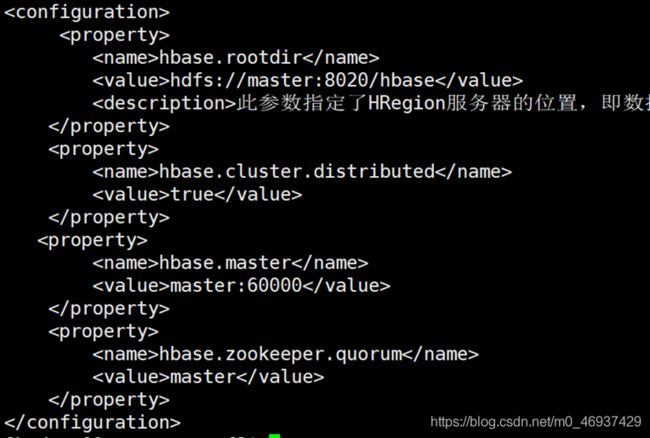

修改hbase-site.xml

sudo vi hbase-site.xml

hbase.rootdir

hdfs://master:8020/hbase

此参数指定了HRegion服务器的位置,即数据存放位置

hbase.cluster.distributed

true

hbase.master

master:60000

hbase.zookeeper.quorum

master

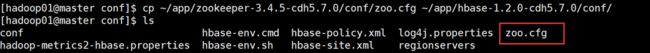

拷贝zookeeper conf/zoo.cfg到hbase的conf/下

赋予脚本执行权力

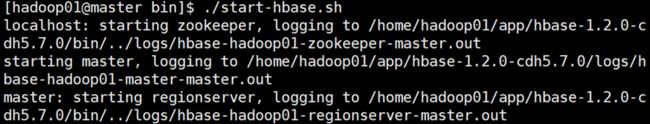

chmod +x ~/app/hbase-1.2.0-cdh5.7.0/bin/start-hbase.sh

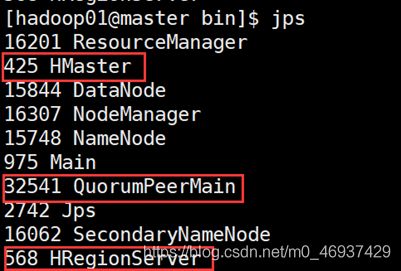

启动Hbase

在bin目录下执行 :./start-hbase.sh

执行

hbase(main):001:0>create ‘testtable’,’colfam1’

如果没有报错即安装成功

总结

- 1,环境和软件需求

- 2,ssh免密服务配置

- 3,jdk+hadoop 环境安装

- 4,mysql+hive 安装

- 5,zookeeper+hbase安装