分布式日志处理--Sleuth/Zipkin

使用Sleuth实现微服务跟踪:

1:在需要监听的项目中(provider/consumer)添加依赖,整合Sleuth

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-sleuthartifactId>

<version>1.2.5.RELEASEversion>

dependency>

2:修改application.yml文件,在其中设置日志级别为info

logging:

level: info

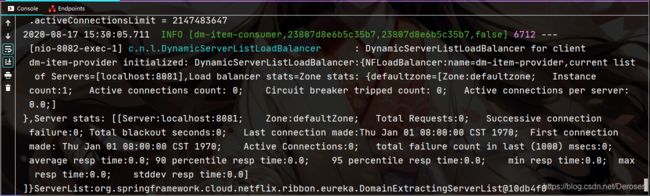

3:运行项目,此时调用服务可在控制台看到对应的日志文件,包括一些ip,serverName等

Spring Cloud Sleuth整合Zipkin:

Zipkin提供了图形化界面。除了使用Zipkin,还可以配合ELK实现

1:创建新项目:dm-sleuth-server,并导入springCloud依赖

2:添加zipkin依赖:

<dependency>

<groupId>io.zipkin.javagroupId>

<artifactId>zipkin-serverartifactId>

dependency>

<dependency>

<groupId>io.zipkin.javagroupId>

<artifactId>zipkin-autoconfigure-uiartifactId>

dependency>

3:启动类添加注解:@EnableZipkinServer

4:yml文件添加一个server:port :7700后运行项目,运行后即可通过7700访问zipkin页面

微服务整合Zipkin:

1:在需要监听的项目中(provider/consumer)添加依赖,整合Zipkin

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-sleuthartifactId>

<version>1.2.5.RELEASEversion>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-zipkinartifactId>

dependency>

2:分别修改所需项目中的application.yml,在其中指定Zipkin Server地址和采样率

spring:

zipkin:

base-url: http://localhost:7700

sleuth:

sampler:

percentage: 1.0

(在开发、测试中配置文件中的spring.sleuth.sampler.percentage属性设置为1.0,代表100%采样,否则可能会忽略掉大量span,可能看不到想要查看的请求)

3:重启项目后访问服务,在Zipkin页面中可以看到这其中产生的数据

使用消息中间件收集数据:RabbitMQ(需要创建RabbitMQ容器,端口为15672,5672)

收集跟踪数据是使用HTTP请求的方式,带来的问题

耦合性,都需要连接到Zipkin Server

不稳定性,网络出现问题就无法保证收集到跟踪数据

可以使用消息中间件解决

先将需要收集的数据发送到消息中间件中,然后Zipkin Server再从消息中间件取出数据分析

1:在sleuth-server项目中添加依赖

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-sleuth-zipkin-streamartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-stream-binder-rabbitartifactId>

<version>1.2.1.RELEASEversion>

dependency>

<dependency>

<groupId>io.zipkin.javagroupId>

<artifactId>zipkin-autoconfigure-uiartifactId>

dependency>

2:启动类将@EnableZipkinServer改为@EnableZipkinStreamServer

3:在yml中配置RabbitMQ的服务地址和账号

spring:

rabbitmq:

host: 192.168.9.151

port: 5672

username: guest

password: guest

4:所需项目配置以下依赖,删除之前配置的zipkin依赖

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-sleuthartifactId>

<version>1.2.5.RELEASEversion>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-sleuth-streamartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-stream-binder-rabbitartifactId> <version>1.2.1.RELEASEversion>

dependency>

5:所需项目中删除之前配置的zipkin配置,换为如下配置

spring

rabbitmq:

host: 192.168.9.151

port: 5672

username: guest

password: guest

6:重启项目,此时日志则是通过RabbitMQ来访问的,在RabbitMQ页面中可看到队列显示

使用MySQL存储跟踪数据:

数据丢失

前文示例中Zipkin Server都是将数据保存在内存中,重启Zipkin Server后就不能查看到之前的数据了

数据持久化存储

MySQL

Elasticsearch

…

1:为sleuth-server添加数据库依赖

<dependency>

<groupId>io.zipkin.javagroupId>

<artifactId>zipkin-storage-mysqlartifactId>

<version>1.16.2version>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-jdbcartifactId>

dependency>

<dependency>

<groupId>mysqlgroupId>

<artifactId>mysql-connector-javaartifactId>

dependency>

2:创建数据库

创建表

官方脚本

https://github.com/openzipkin/zipkin/blob/master/zipkin-storage/mysql-v1/src/main/resources/mysql.sql

3:在sleuth-server中添加关于数据库的配置

datasource:

url: jdbc:mysql://数据库地址:3306/表名?useUnicode=true&characterEncoding=gbk&zeroDateTimeBehavior=convertToNull&useSSL=true

username: root

password: root

driver-class-name: com.mysql.jdbc.Driver

zipkin:

storage:

type: mysql

4:重启项目,此时访问服务产生的数据会存入数据库中,重启时会调用数据库中的数据,防止数据流失