- 基于DPDK+VPP实现高性能防火墙

技术探索者

DPDKvppdpdk

0.数据平面和用户态协议栈传统基于linuxnetfilter实现防火墙,虽然方便,但是性能很差。于是pfring/netmap/dpdk等机制,都要bypass掉内核协议栈。多年来,各大操作系统(Linux/Windows/Freebsd)的网络协议栈一直都在内核中实现。其实网络协议栈只是一个应用,而不是操作系统的范畴,没有人规定网络协议栈一定是要早内核实现的。这些操作系统的开发者们将一切和具体

- suricata之pfring收包模式源码分析

小虎随笔

suricata概述及源码分析suricata

#ifndef__SOURCE_PFRING_H__#define__SOURCE_PFRING_H__#definePFRING_IFACE_NAME_LENGTH48typedefstructPfringThreadVars_PfringThreadVars;/*PfringIfaceConfigflags*/#definePFRING_CONF_FLAGS_CLUSTER(1name);ex

- pfring之学习——cap文件查看解析与步骤

任薛纪

PF_Ring学习笔记

原文:http://hi.baidu.com/ah__fu/item/10400911b071c9041994ec3b/*引子:近期颓废得厉害。好多朋友向我要一个读取CAP文件的类,一方面工作繁忙,另一方面有空了就懒洋洋的不想动。终于好好收拾了一下心情,把关于我知道的有关CAP文件的东东拿出来和朋友们分享。*/1、cap文件格式说明我所发现的情况是:windows下的ethereal和Linux下

- pfring的编译 libpcap缓冲区修改

soipray

绝密

1)下载PF_RING:gitclonehttps://github.com/ntop/PF_RING.git2)下载完后,在PF_RING/kernel下面make编译pf_ring,生成pf_ring.ko3)insmodpf_ring.kothansparent_mode=14)apt-getinstallbision5)apt-getinstallflex6)cd进入PF_RING-dev

- mmap内存映射---(八)

smilestone322

网络编程开源技术

在应用空间采用mmap进行内存映射时,内核调用的是ring_mmap函数;例如:我们在前面讲解时,讲解了pfring_open_consumer函数,这个函数里面调用mmap如下:ring->buffer=(char*)mmap(NULL,memSlotsLen,PROT_READ|PROT_WRITE,MAP_SHARED,ring->fd,0);在内核采用ring_mmap函数进行处理;该函数

- Ubuntu16.04和18.04安装pfring

无名小卒~

linuxubuntu软件移植安装使用

官方wiki:http://www.ntop.org/guides/pf_ring/index.html其他:高速的网络抓包库PF_ring介绍及编译安装Ubuntu16.04LTS安装pfringPF_RING总结https://blog.csdn.net/ygm_linux/article/category/6802624下载pfring源码包下载地址:https://github.com/n

- PFring浅析

lyq_csdn

来自:https://www.cnblogs.com/lxgeek/p/3893790.html1.背景目前收包存在的问题:第一:inpterruptlivelock,当收到包的时候,网卡驱动程序就会产生一次中断。在大流量的情况下,操作系统将花费大量时间用于处理中断,而只有少量的时间用于其他任务。第二:将包从网卡移动到用户层花费的时间太久。2.PF_RING的目标1.充分利用devicepolli

- pfRing透明工作模式

与时俱进2014

PFRING

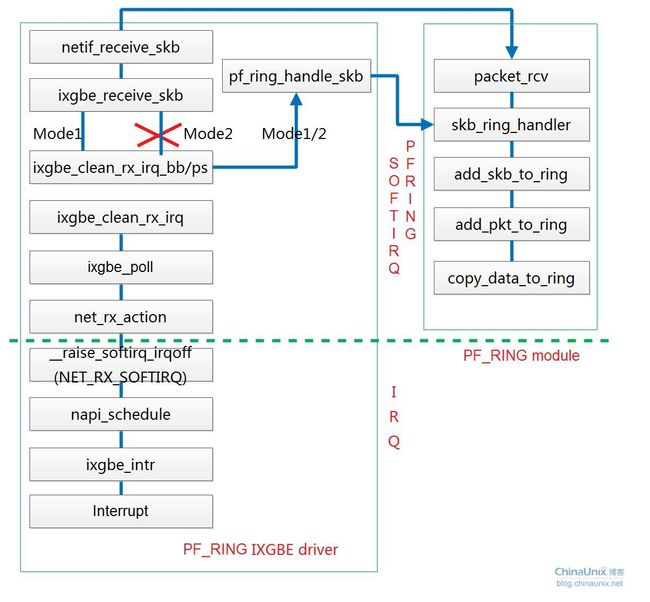

特别声明:文中所述内容纯属个人理解,如有错误,请大家指正。欢迎交流pf_ring有三种透明模式(transparent_mode),为0时走的是Linux标准的NAPI包处理流程。为1时,包既走Linux标准包处理流程,也copy给pf_ring一份。为2时,驱动只将包拷贝给pf_ring,内核则不会接收到这些包。从性能角度而言,三种模式的效率依次升高。(1)通用网卡驱动对于通用网卡驱动,只有tr

- 查看pfring(pf_ring)的配置

Gliscor

当pfring(pf_ring)被激活时,在proc文件系统下会建立一个/proc/net/pf_ring目录,其中存放着pfring(pf_ring)的配置信息;#ls/proc/net/pf_ring/infoplugins_info#cat/proc/net/pf_ring/infoVersion:4.7.1Ringslots:4096Slotversion:13CaptureTX:Yes[

- pfring(pf_ring)运行的几种模式

Gliscor

Linux

插入pfring(pf_ring)模块时可以加入以下参数:insmod/kernel/pf_ring.ko[transparent_mode=0|1|2][min_num_slots=x][enable_tx_capture=1|0][enable_ip_defrag=1|0][quick_mode=1|0]其中,transparent_mode指定pfring的运行模式;transparent_

- Ubuntu 16.04 LTS 安装pfring

CGniao

linux网络

1、下载pfring源码包,安装使用的是6.4.1版本2、主要的目录结构如下:PF_RING-6.4.1/drivers/kernel/userland/Makefile3、在主目录下直接make,发现报错。缺三个工具sudoapt-getinstallflexsudoapt-getbisonsudoapt-getbyacc4、再次编译时发现报了关于undefined“pcap_lex”的错,查资

- pfring(pf_ring)编译安装

Gliscor

Linux

1、pfring(pf_ring)简介pfring(pf_ring)主页http://www.ntop.org/products/pf_ring/;pfring(pf_ring)是一种加速处理数据包的实现方法,能够比较有效地提高网卡获取和发送数据包的速度,类似所谓的“零拷贝”技术;pfring(pf_ring)的安装包中带有支持pfring(pf_ring)的libpcap,与原版的libpcap

- 网络设备开军火发库(libnet,libpcap,pfring,dpdk)

SHUIKEBING

VC

1缘起实际工作中开发网络设备时,常用到的一些开源网络库,做一些底层的包的捕获、发送、修改等。下面简单介绍一下有哪些开源工具,以及相应的简单用法。有一些特殊的数据包要做特殊处理,如vlan环境下的数据包。2libnet(发包)2.1简介libnet是一个小型的接口函数库,主要用C语言写成,提供了低层网络数据包的构造、处理和发送功能。libnet的开发目的是:建立一个简单统一的网络编程接口以屏蔽不同操

- linux报文高速捕获技术对比--napi/libpcap/afpacket/pfring/dpdk/xdp

网络安全研发随想

网络安全linux内核编程

1.传统linux网络协议栈流程和性能分析Linux网络协议栈是处理网络数据包的典型系统,它包含了从物理层直到应用层的全过程。数据包到达网卡设备。网卡设备依据配置进行DMA操作。(第1次拷贝:网卡寄存器->内核为网卡分配的缓冲区ringbuffer)网卡发送中断,唤醒处理器。驱动软件从ringbuffer中读取,填充内核skbuff结构(第2次拷贝:内核网卡缓冲区ringbuffer->内核专用数

- 基于DPDK+VPP实现高性能防火墙

网络安全研发随想

网络安全云计算和虚拟化

0.数据平面和用户态协议栈传统基于linuxnetfilter实现防火墙,虽然方便,但是性能很差。于是pfring/netmap/dpdk/xdp等机制,都要bypass掉内核协议栈。多年来,各大操作系统(Linux/Windows/Freebsd)的网络协议栈一直都在内核中实现。其实网络协议栈只是一个应用,而不是操作系统的范畴,没有人规定网络协议栈一定是要早内核实现的。这些操作系统的开发者们将一

- Suricata源码阅读笔记:数据包源

weixin_34221036

2019独角兽企业重金招聘Python工程师标准>>>简介Suricata支持多种数据包源:pcap(实时/文件)、nfq、ipfw、mpipe、af-packet、pfring、dag(实时/文件)、napatech。每种数据包源的支持都对应于一个线程模块(ThreadModule),得益于这种其模块化的架构,增加一个新的数据源支持只需要添加一个新的线程模块即可。这里,我将主要记录最常见的pca

- Suricata安装教程

姚贤贤

安全

1.安装必要库(1)检查是否安装了jansson,这是Suricata输出的日志文件eve.json必备库可参考:彻底解决SuricataEve-logsupportnotcompiledin问题(2)安装pfring2.安装Suricatahttps://suricata-ids.org/download/下载安装包(1)解压安装包tar-zxfsuricata-4.1.0.tar.gz(2)编

- Suricata安装常见问题解决

姚贤贤

安全

(1)安装正常,运行报errorwhileloadingsharedlibraries:libpfring.so,nofileornodir查看find/-name“libpfring.so”,查看/usr/local/lib/是否存在libpfring.so,如果不存在则:ln-s/opt/pfring/lib/libpfring.a/usr/local/lib/libpfring.aln-s/

- libpcap和pfring应用程序--Pcap_open_live(二)

smilestone322

网络编程开源技术

首先以libpcap为主线,先通过pcap_open_live函数,做一些初始化的操作,比如打开网卡,设置好读取数据包的回调函数等等,然后就可以通过pcap_next,pcap_next_ex,pcap_dispatch,pcap_loop来捕获数据包了。本文的主要宗旨是分析源码,从应用层的libpcap,pfring一直分析到内核的PF_RING,通过对源码的讲解,使得我们深入的理解PF_RIN

- suricata使用pfring监听多个网卡报错问题分析解决

leejia1989

suricatapfringpfring_openerrorExceededthemaximum流量分析

问题场景我们使用suricata来做流量分析,suricata部署在一台多网卡的48核心的物理机上,由于业务需要,suricata监听流量的网卡从5块提升为了6块,新加了网卡enp176s0f1,然后发现suricata的日志中有多条类似报错:-[ERRCODE:SC_ERR_PF_RING_OPEN(34)]-Failedtoopenenp176s0f1:pfring_openerror.Che

- 报文处理中的主动和被动轮询

fan_hai_ping

pf_ring

如果你希望避免浪费CPU循环,当你没有事情做时(例如,没有报文等待处理),你应该调用pfring_poll()进行轮询,当有报文需要处理时要求系统唤醒程序。如果你创建一个主动轮询循环时,你可能希望做一些事情,就像下面:while(){usleep(1);} 减少CPU循环花费(理论上)一小会(1ms)时间,最佳的实践是usleep()指定的持续时间(或者你希望使用nanosleep()替代usle

- Suricata源码阅读笔记:数据包源

背着笔记本流浪

Suricata

简介Suricata支持多种数据包源:pcap(实时/文件)、nfq、ipfw、mpipe、af-packet、pfring、dag(实时/文件)、napatech。每种数据包源的支持都对应于一个线程模块(ThreadModule),得益于这种其模块化的架构,增加一个新的数据源支持只需要添加一个新的线程模块即可。这里,我将主要记录最常见的pcap实时数据源的实现细节,包括相关数据结构、运行流程,以

- pfring(pf_ring)编译安装

gliscor

pfringlibpcap-ringpf_ring

1、pfring(pf_ring)简介pfring(pf_ring)主页http://www.ntop.org/products/pf_ring/;pfring(pf_ring)是一种加速处理数据包的实现方法,能够比较有效地提高网卡获取和发送数据包的速度,类似所谓的“零拷贝”技术;pfring(pf_ring)的安装包中带有支持pfring(pf_ring)的libpcap,与原版的libpcap

- mmap内存映射---(八)

smilestone322

在应用空间采用mmap进行内存映射时,内核调用的是ring_mmap函数;例如:我们在前面讲解时,讲解了pfring_open_consumer函数,这个函数里面调用mmap如下: ring->buffer=(char*)mmap(NULL,memSlotsLen,PROT_READ|PROT_WRITE, MAP_SHARED,ring

- socket的创建(六)

smilestone322

Socket的创建函数,在PF_RING,创建sokcet的函数为ring_create,当pfring.c中通过sokcet函数建立socket时,内核调用的ring_create函数,ring_create源码如下:staticintring_create(#if(LINUX_VERSION_CODE>=KERNEL_VERSION(2,6,24)) str

- PF_RING 内核源码(四)

smilestone322

终于开始讲解内核了,唉,长舒一口气,libpcap+pfring都讲解了40页,PF_RING就更难了。

- libpcap接收数据包(三)

smilestone322

本文以应用程序的api调用为主线,分析libpcap和pfring源码,当然还有内核PF_RING的源码在以后也会分析,以后可能我会分析从网卡驱动一直分析到应用层,争取把这些都讲清楚。Linux开源就是好,呵呵,闲话少说,继续分析,首先分析pcap_next函数吧,搞过winpcap的都知道这个是数据包的函数,一次只读一个数据包。constu_char*pcap_next(pcap_t*p,str

- libpcap和pfring应用程序--Pcap_open_live(二)

smilestone322

首先以libpcap为主线,先通过pcap_open_live函数,做一些初始化的操作,比如打开网卡,设置好读取数据包的回调函数等等,然后就可以通过pcap_next,pcap_next_ex,pcap_dispatch,pcap_loop来捕获数据包了。本文的主要宗旨是分析源码,从应用层的libpcap,pfring一直分析到内核的PF_RING,通过对源码的讲解,使得我们深入的理解PF_RIN

- java解析APK

3213213333332132

javaapklinux解析APK

解析apk有两种方法

1、结合安卓提供apktool工具,用java执行cmd解析命令获取apk信息

2、利用相关jar包里的集成方法解析apk

这里只给出第二种方法,因为第一种方法在linux服务器下会出现不在控制范围之内的结果。

public class ApkUtil

{

/**

* 日志对象

*/

private static Logger

- nginx自定义ip访问N种方法

ronin47

nginx 禁止ip访问

因业务需要,禁止一部分内网访问接口, 由于前端架了F5,直接用deny或allow是不行的,这是因为直接获取的前端F5的地址。

所以开始思考有哪些主案可以实现这样的需求,目前可实施的是三种:

一:把ip段放在redis里,写一段lua

二:利用geo传递变量,写一段

- mysql timestamp类型字段的CURRENT_TIMESTAMP与ON UPDATE CURRENT_TIMESTAMP属性

dcj3sjt126com

mysql

timestamp有两个属性,分别是CURRENT_TIMESTAMP 和ON UPDATE CURRENT_TIMESTAMP两种,使用情况分别如下:

1.

CURRENT_TIMESTAMP

当要向数据库执行insert操作时,如果有个timestamp字段属性设为

CURRENT_TIMESTAMP,则无论这

- struts2+spring+hibernate分页显示

171815164

Hibernate

分页显示一直是web开发中一大烦琐的难题,传统的网页设计只在一个JSP或者ASP页面中书写所有关于数据库操作的代码,那样做分页可能简单一点,但当把网站分层开发后,分页就比较困难了,下面是我做Spring+Hibernate+Struts2项目时设计的分页代码,与大家分享交流。

1、DAO层接口的设计,在MemberDao接口中定义了如下两个方法:

public in

- 构建自己的Wrapper应用

g21121

rap

我们已经了解Wrapper的目录结构,下面可是正式利用Wrapper来包装我们自己的应用,这里假设Wrapper的安装目录为:/usr/local/wrapper。

首先,创建项目应用

&nb

- [简单]工作记录_多线程相关

53873039oycg

多线程

最近遇到多线程的问题,原来使用异步请求多个接口(n*3次请求) 方案一 使用多线程一次返回数据,最开始是使用5个线程,一个线程顺序请求3个接口,超时终止返回 缺点 测试发现必须3个接

- 调试jdk中的源码,查看jdk局部变量

程序员是怎么炼成的

jdk 源码

转自:http://www.douban.com/note/211369821/

学习jdk源码时使用--

学习java最好的办法就是看jdk源代码,面对浩瀚的jdk(光源码就有40M多,比一个大型网站的源码都多)从何入手呢,要是能单步调试跟进到jdk源码里并且能查看其中的局部变量最好了。

可惜的是sun提供的jdk并不能查看运行中的局部变量

- Oracle RAC Failover 详解

aijuans

oracle

Oracle RAC 同时具备HA(High Availiablity) 和LB(LoadBalance). 而其高可用性的基础就是Failover(故障转移). 它指集群中任何一个节点的故障都不会影响用户的使用,连接到故障节点的用户会被自动转移到健康节点,从用户感受而言, 是感觉不到这种切换。

Oracle 10g RAC 的Failover 可以分为3种:

1. Client-Si

- form表单提交数据编码方式及tomcat的接受编码方式

antonyup_2006

JavaScripttomcat浏览器互联网servlet

原帖地址:http://www.iteye.com/topic/266705

form有2中方法把数据提交给服务器,get和post,分别说下吧。

(一)get提交

1.首先说下客户端(浏览器)的form表单用get方法是如何将数据编码后提交给服务器端的吧。

对于get方法来说,都是把数据串联在请求的url后面作为参数,如:http://localhost:

- JS初学者必知的基础

百合不是茶

js函数js入门基础

JavaScript是网页的交互语言,实现网页的各种效果,

JavaScript 是世界上最流行的脚本语言。

JavaScript 是属于 web 的语言,它适用于 PC、笔记本电脑、平板电脑和移动电话。

JavaScript 被设计为向 HTML 页面增加交互性。

许多 HTML 开发者都不是程序员,但是 JavaScript 却拥有非常简单的语法。几乎每个人都有能力将小的

- iBatis的分页分析与详解

bijian1013

javaibatis

分页是操作数据库型系统常遇到的问题。分页实现方法很多,但效率的差异就很大了。iBatis是通过什么方式来实现这个分页的了。查看它的实现部分,发现返回的PaginatedList实际上是个接口,实现这个接口的是PaginatedDataList类的对象,查看PaginatedDataList类发现,每次翻页的时候最

- 精通Oracle10编程SQL(15)使用对象类型

bijian1013

oracle数据库plsql

/*

*使用对象类型

*/

--建立和使用简单对象类型

--对象类型包括对象类型规范和对象类型体两部分。

--建立和使用不包含任何方法的对象类型

CREATE OR REPLACE TYPE person_typ1 as OBJECT(

name varchar2(10),gender varchar2(4),birthdate date

);

drop type p

- 【Linux命令二】文本处理命令awk

bit1129

linux命令

awk是Linux用来进行文本处理的命令,在日常工作中,广泛应用于日志分析。awk是一门解释型编程语言,包含变量,数组,循环控制结构,条件控制结构等。它的语法采用类C语言的语法。

awk命令用来做什么?

1.awk适用于具有一定结构的文本行,对其中的列进行提取信息

2.awk可以把当前正在处理的文本行提交给Linux的其它命令处理,然后把直接结构返回给awk

3.awk实际工

- JAVA(ssh2框架)+Flex实现权限控制方案分析

白糖_

java

目前项目使用的是Struts2+Hibernate+Spring的架构模式,目前已经有一套针对SSH2的权限系统,运行良好。但是项目有了新需求:在目前系统的基础上使用Flex逐步取代JSP,在取代JSP过程中可能存在Flex与JSP并存的情况,所以权限系统需要进行修改。

【SSH2权限系统的实现机制】

权限控制分为页面和后台两块:不同类型用户的帐号分配的访问权限是不同的,用户使

- angular.forEach

boyitech

AngularJSAngularJS APIangular.forEach

angular.forEach 描述: 循环对obj对象的每个元素调用iterator, obj对象可以是一个Object或一个Array. Iterator函数调用方法: iterator(value, key, obj), 其中obj是被迭代对象,key是obj的property key或者是数组的index,value就是相应的值啦. (此函数不能够迭代继承的属性.)

- java-谷歌面试题-给定一个排序数组,如何构造一个二叉排序树

bylijinnan

二叉排序树

import java.util.LinkedList;

public class CreateBSTfromSortedArray {

/**

* 题目:给定一个排序数组,如何构造一个二叉排序树

* 递归

*/

public static void main(String[] args) {

int[] data = { 1, 2, 3, 4,

- action执行2次

Chen.H

JavaScriptjspXHTMLcssWebwork

xwork 写道 <action name="userTypeAction"

class="com.ekangcount.website.system.view.action.UserTypeAction">

<result name="ssss" type="dispatcher">

- [时空与能量]逆转时空需要消耗大量能源

comsci

能源

无论如何,人类始终都想摆脱时间和空间的限制....但是受到质量与能量关系的限制,我们人类在目前和今后很长一段时间内,都无法获得大量廉价的能源来进行时空跨越.....

在进行时空穿梭的实验中,消耗超大规模的能源是必然

- oracle的正则表达式(regular expression)详细介绍

daizj

oracle正则表达式

正则表达式是很多编程语言中都有的。可惜oracle8i、oracle9i中一直迟迟不肯加入,好在oracle10g中终于增加了期盼已久的正则表达式功能。你可以在oracle10g中使用正则表达式肆意地匹配你想匹配的任何字符串了。

正则表达式中常用到的元数据(metacharacter)如下:

^ 匹配字符串的开头位置。

$ 匹配支付传的结尾位置。

*

- 报表工具与报表性能的关系

datamachine

报表工具birt报表性能润乾报表

在选择报表工具时,性能一直是用户关心的指标,但是,报表工具的性能和整个报表系统的性能有多大关系呢?

要回答这个问题,首先要分析一下报表的处理过程包含哪些环节,哪些环节容易出现性能瓶颈,如何优化这些环节。

一、报表处理的一般过程分析

1、用户选择报表输入参数后,报表引擎会根据报表模板和输入参数来解析报表,并将数据计算和读取请求以SQL的方式发送给数据库。

2、

- 初一上学期难记忆单词背诵第一课

dcj3sjt126com

wordenglish

what 什么

your 你

name 名字

my 我的

am 是

one 一

two 二

three 三

four 四

five 五

class 班级,课

six 六

seven 七

eight 八

nince 九

ten 十

zero 零

how 怎样

old 老的

eleven 十一

twelve 十二

thirteen

- 我学过和准备学的各种技术

dcj3sjt126com

技术

语言VB https://msdn.microsoft.com/zh-cn/library/2x7h1hfk.aspxJava http://docs.oracle.com/javase/8/C# https://msdn.microsoft.com/library/vstudioPHP http://php.net/manual/en/Html

- struts2中token防止重复提交表单

蕃薯耀

重复提交表单struts2中token

struts2中token防止重复提交表单

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 2015年7月12日 11:52:32 星期日

ht

- 线性查找二维数组

hao3100590

二维数组

1.算法描述

有序(行有序,列有序,且每行从左至右递增,列从上至下递增)二维数组查找,要求复杂度O(n)

2.使用到的相关知识:

结构体定义和使用,二维数组传递(http://blog.csdn.net/yzhhmhm/article/details/2045816)

3.使用数组名传递

这个的不便之处很明显,一旦确定就是不能设置列值

//使

- spring security 3中推荐使用BCrypt算法加密密码

jackyrong

Spring Security

spring security 3中推荐使用BCrypt算法加密密码了,以前使用的是md5,

Md5PasswordEncoder 和 ShaPasswordEncoder,现在不推荐了,推荐用bcrpt

Bcrpt中的salt可以是随机的,比如:

int i = 0;

while (i < 10) {

String password = "1234

- 学习编程并不难,做到以下几点即可!

lampcy

javahtml编程语言

不论你是想自己设计游戏,还是开发iPhone或安卓手机上的应用,还是仅仅为了娱乐,学习编程语言都是一条必经之路。编程语言种类繁多,用途各 异,然而一旦掌握其中之一,其他的也就迎刃而解。作为初学者,你可能要先从Java或HTML开始学,一旦掌握了一门编程语言,你就发挥无穷的想象,开发 各种神奇的软件啦。

1、确定目标

学习编程语言既充满乐趣,又充满挑战。有些花费多年时间学习一门编程语言的大学生到

- 架构师之mysql----------------用group+inner join,left join ,right join 查重复数据(替代in)

nannan408

right join

1.前言。

如题。

2.代码

(1)单表查重复数据,根据a分组

SELECT m.a,m.b, INNER JOIN (select a,b,COUNT(*) AS rank FROM test.`A` A GROUP BY a HAVING rank>1 )k ON m.a=k.a

(2)多表查询 ,

使用改为le

- jQuery选择器小结 VS 节点查找(附css的一些东西)

Everyday都不同

jquerycssname选择器追加元素查找节点

最近做前端页面,频繁用到一些jQuery的选择器,所以特意来总结一下:

测试页面:

<html>

<head>

<script src="jquery-1.7.2.min.js"></script>

<script>

/*$(function() {

$(documen

- 关于EXT

tntxia

ext

ExtJS是一个很不错的Ajax框架,可以用来开发带有华丽外观的富客户端应用,使得我们的b/s应用更加具有活力及生命力。ExtJS是一个用 javascript编写,与后台技术无关的前端ajax框架。因此,可以把ExtJS用在.Net、Java、Php等各种开发语言开发的应用中。

ExtJs最开始基于YUI技术,由开发人员Jack

- 一个MIT计算机博士对数学的思考

xjnine

Math

在过去的一年中,我一直在数学的海洋中游荡,research进展不多,对于数学世界的阅历算是有了一些长进。为什么要深入数学的世界?作为计算机的学生,我没有任何企图要成为一个数学家。我学习数学的目的,是要想爬上巨人的肩膀,希望站在更高的高度,能把我自己研究的东西看得更深广一些。说起来,我在刚来这个学校的时候,并没有预料到我将会有一个深入数学的旅程。我的导师最初希望我去做的题目,是对appe