理解PCM音频数据,使用QAudioOutput播放音频的两种方法

【写在前面】

因为最近需要写FFmpeg播放音频的文章,所以就先写了这篇文章。

并且,FFmpeg解码出来的音频是PCM原始音频数据。

然后,我使用 Qt 的 QAudioOutput 作为底层音频输出(输出设备)。

本篇主要内容:

1、音频基础概念

2、PCM数据格式

3、QAudioOutput 的使用方法( 两种 )

【正文开始】

- 在介绍PCM之前,必须先了解一些音频基础概念:

采样率( Sample Rate ):每秒采样的频率,即每秒样本数,单位HZ ,常见的频率有22050HZ、44100HZ( CD级 )。并且人耳的听力范围是20HZ ~ 20000HZ,因此超过48000HZ就没有意义了( 根据采样定理 )。

采样定理:采样在进行模拟/数字信号的转换过程中,当采样频率fs.max大于信号中最高频率fmax的2倍时(fs.max>2fmax),采样之后的数字信号完整地保留了原始信号中的信息,一般实际应用中保证采样频率为信号最高频率的2.56~4倍,采样定理又称奈奎斯特定理。

样本大小( Sample Size ):每个样本的大小,也就是振幅,假如样本大小为16 Bit = 2 ^ 16 = 65536,即能够记录 65535 个数,常见的有 8Bit、16Bit( CD级 ),而到了 32Bit 意义就不大了。

声道( Sound Channel ):指声音在录制或播放时,在不同空间位置采集或回放的相互独立的音频信号,常见的有单声道,双声道,四声道,这个倒是声道越多效果越好。

比特率( Bit Rate ):单位( bps 比特每秒 ),可以使用 比特率 = 采样率 x 样本大小 x 声音通道数 来计算。

字节序( Byte Ordering ):字节序,这个大家应该都知道,分大端和小端,一般都是小端字节序(低位低地址,高位高地址)。

- 好了,现在开始介绍 PCM 格式:

PCM 全名脉冲编码调制( Pulse Code Modulation ),它是原始的音频脉冲数据,在一般情况下,一帧PCM数据包含2048个样本( 数据帧,注意是一帧而不是一秒 )。

因此,对于一帧PCM数据,使用小端字节序存储为(每个 [ ] 为一个样本):

内存地址: | 低地址 | >>>>>>> | 高地址 |

8Bit 单声道:[ 8 bit ] - [ 8 bit ] - [ 8 bit ] - [ 8 bit ] } 总 2048个。

8Bit 双声道:[ 8 bit 声道1 ] - [ 8 bit 声道2 ] - [ 8 bit 声道1 ] - [ 8 bit 声道2 ] } 总 2048个。

16Bit 单声道:[ 8 bit 低位 + 8 bit 高位 ] - [ 8 bit 低位 + 8 bit 高位 ] - [ 8 bit 低位 + 8 bit 高位 ] - [ 8 bit 低位 + 8 bit 高位 ] } 总 2048个。

16Bit 双声道:[ 8 bit 低位 + 8 bit 高位 声道1 ] - [ 8 bit 低位 + 8 bit 高位 声道2 ] - [ 8 bit 低位 + 8 bit 高位 声道1 ] - [ 8 bit 低位 + 8 bit 高位 声道2 ] } 总 2048个。

到这里,我们已经大概了解了PCM数据格式,现在可以尝试手动生成一份PCM数据:

QByteArray generateRandomPCM()

{

qsrand(uint(time(nullptr)));

//幅度,因为sampleSize = 16bit

qint16 amplitude = INT16_MAX;

//单声道

int channels = 1;

//采样率

int samplerate = 8000;

//持续时间ms

int duration = 20000;

//总样本数

int n_samples = int(channels * samplerate * (duration / 1000.0));

QByteArray data;

QDataStream out(&data, QIODevice::WriteOnly);

out.setByteOrder(QDataStream::LittleEndian);

for (int i = 0; i < n_samples; i++) {

qint16 sample = qrand() % amplitude;

out << sample;

}

QFile file("raw");

file.open(QIODevice::WriteOnly);

file.write(data);

file.close();

return data;

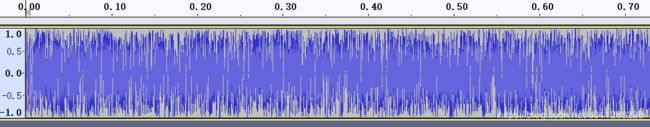

}利用这个函数,可以生成一份 8000HZ,16Bit,单声道,持续 20s的随机PCM数据,部分波形如下:

呃。。这种都是噪音,听不出什么来,于是我尝试生成一些有规律的:

QByteArray generatePCM()

{

//幅度,因为sampleSize = 16bit

qint16 amplitude = INT16_MAX;

//单声道

int channels = 1;

//采样率

int samplerate = 8000;

//持续时间ms

int duration = 20;

//总样本数

int n_samples = int(channels * samplerate * (duration / 1000.0));

//声音频率

int frequency = 100;

bool reverse = false;

QByteArray data;

QDataStream out(&data, QIODevice::WriteOnly);

out.setByteOrder(QDataStream::LittleEndian);

for (int i = 0; i < 1000; i++) {

for (int j = 0; j < n_samples; j++) {

qreal radians = qreal(2.0 * M_PI * j * frequency / qreal(samplerate));

qint16 sample = qint16(qSin(radians) * amplitude);

out << sample;

}

if (!reverse) {

if (frequency < 2000) {

frequency += 100;

} else reverse = true;

} else {

if (frequency > 100) {

frequency -= 100;

} else reverse = false;

}

}

QFile file("raw");

file.open(QIODevice::WriteOnly);

file.write(data);

file.close();

return data;

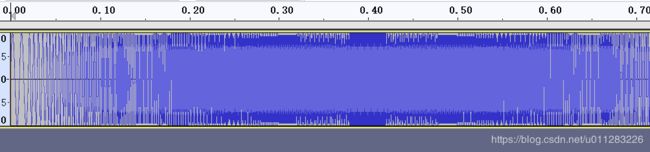

}这种生成的音频就是,频率(声调)由低到高再到低,部分波形如下:

到这里,PCM相关的就讲解完了。

- 现在PCM数据有了,那么如何在Qt中播放它呢?答案是 QAudioOutput。

QAudioOutput是Qt中播放音频的类( 另一个是QSound,但只支持WAV ),要使用它,需要在pro中加入 QT += multimedia

我们先来看看代码:

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

QByteArray pcm1 = generatePCM();

QAudioFormat format;

format.setCodec("audio/pcm");

format.setSampleRate(8000);

format.setSampleSize(16);

format.setSampleType(QAudioFormat::SignedInt);

format.setChannelCount(1);

format.setByteOrder(QAudioFormat::LittleEndian);

QAudioOutput output(format, qApp);

QIODevice *device = output.start();

QTimer *timer_play = new QTimer(qApp);

timer_play->setTimerType(Qt::PreciseTimer);

QObject::connect(timer_play, &QTimer::timeout, [&]{

if (pcm1.size() > 0) {

int readSize = output.periodSize();

int chunks = output.bytesFree() / readSize;

while (chunks) {

QByteArray samples = pcm1.mid(0, readSize);

int len = samples.size();

pcm1.remove(0, len);

if (len) device->write(samples);

if (len != readSize) break;

chunks--;

}

}

});

timer_play->start(100);

return a.exec();

}1、创建一个 QAudioFormat ,它描述了音频的格式,setCodec() 只支持 PCM,而其他的参数根据前面所讲,你应该知道是什么了吧。

2、根据 QAudioFormat 创建一个 QAudioOutput,它是用来管理音频设备( 即声卡 )的。

3、使用 start() 返回一个指向实际音频设备的指针,往这个里面写入数据就能够播放出声音了。

4、我使用定时器来定时写入数据,这样可以保证声音是连续的。

5、periodSize() 返回一个周期所必需要的数据量,而 bytesFree() 返回内部缓冲区的空闲空间的字节数,也就是说,我们只需要每次写入所需的数据量 periodSize(),然后直到填充满内部缓沖 bytesFree() ,即可实现连续播放。

至此,第一种 QAudioOutput 的使用方法讲解完毕。

- 第二种 QAudioOutput 的使用方法:

QAudioOutput 的 start() 函数的重载版本 start(QIODevice *),它需要传入一个QIODevice指针,然后由 QAudioOutput 进行读取。

因此,我们需要实现一个自己的IODevice,并实现 readData() 和 writeData() (纯虚函数,必须实现):

class AudioDevice : public QIODevice

{

public:

AudioDevice(const QByteArray &data, QObject *parent = nullptr) : QIODevice(parent), m_data(data) { }

~AudioDevice() { }

virtual qint64 readData(char *data, qint64 maxlen);

virtual qint64 writeData(const char *data, qint64 len){

Q_UNUSED(data);

Q_UNUSED(len);

return 0;

}

private:

QByteArray m_data;

};

qint64 AudioDevice::readData(char *data, qint64 maxlen)

{

if (m_data.size() >= maxlen) {

QByteArray d = m_data.mid(0, int(maxlen));

memcpy(data, d.data(), size_t(d.size()));

m_data.remove(0, int(maxlen));

return d.size();

} else {

QByteArray d = m_data;

memcpy(data, d.data(), size_t(d.size()));

m_data.clear();

return d.size();

}

}因为 QAudioOutput 需要数据时在提供的 QIODdevice 中读取,所以实现 readData() 即可。

然后我们就可以使用它了:

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

QAudioFormat format;

format.setCodec("audio/pcm");

format.setSampleRate(8000);

format.setSampleSize(16);

format.setSampleType(QAudioFormat::SignedInt);

format.setChannelCount(1);

format.setByteOrder(QAudioFormat::LittleEndian);

QAudioOutput output(format, qApp);

QByteArray pcm1 = generatePCM();

AudioDevice *device = new AudioDevice(pcm1, qApp);

device->open(QIODevice::ReadOnly);

output.start(device);

return a.exec();

}【结语】

其实说起来,QAudioOutput的两种方并没有太大的区别,所以使用哪种就看个人喜好了。

然后本篇已经很详细的讲了音频基础,PCM的格式以及如何简单的生成它。(啊。写了一天,累死我了。。![]() )

)

最后,所有的代码在:https://download.csdn.net/download/u011283226/11789311 (可能需要点积分,但我不想放在Github上Ծ‸ Ծ )。