ActiveMQ+Zookeeper集群配置文档

Zookeeper + ActiveMQ 集群整合配置文档

一:使用ZooKeeper实现的MasterSlave实现方式

是对ActiveMQ进行高可用的一种有效的解决方案, 高可用的原

理:使用ZooKeeper(集群)注册所有的ActiveMQ

Broker。只有其中的一个Broker可以对外提供服务( 也就是Master节点) ,其

他的Broker处于待机状态,被视为Slave。如果Master因故障而不能提供服务,

则利用ZooKeeper的内部选举机制会从Slave中选举出一个Broker充当Master节

点,继续对外提供服务。

官网文档如下:

http://activemq.apache.org/replicated-leveldb-store.html

二:部署方案, ActiveMQ集群环境准备:

( 1) 首先我们下载apache-activemq-5.11.1-

bin.tar.gz,到我们的一台主节点上去,然后我们在( 192.168.1.111一个节点

上实现集群即可)

( 2) Zookeeper方案

| 主机IP | 消息端口 | 通信端口 | 节点目录/usr/local/下 |

| 192.168.1.111 | 2181 | 2888:3888 | zookeeper |

| 192.168.1.112 | 2181 | 2888:3888 | zookeeper |

| 192.168.1.113 | 2181 | 2888:3888 | zookeeper |

( 3) ActiveMQ方案

| 主机IP | 集群通信端口 | 消息端口 | 控制台端口 | 节点目录/usr/local/下 |

| 192.168.1.111 | 62621 | 51511 | 8161 | activemq-cluster/node1/ |

| 192.168.1.111 | 62622 | 51512 | 8162 | activemq-cluster/node2/ |

| 192.168.1.111 | 62623 | 51513 | 8163 | activemq-cluster/node3/ |

1:首先搭建zookeeper环境

在192.168.1.111节点下software下,解压zookeeper-3.4.5.tar.gz文件,然后改名,操作如下:(在三台机器上都进行这样的配置)

命令: mv zookeeper-3.4.5 zookeeper

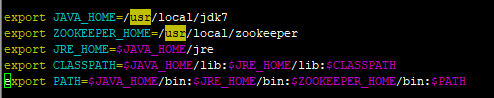

配置环境变量:vim /etc/profile

添加:export ZOOKEEPER_HOME=/usr/local/zookeeper,并添加PATH

使环境变量生效:source /etc/profile

然后:cd zookeeper/conf

mv zoo_sample.cfg zoo.cfg

vi zoo.cfg

找到datadir修改为:/usr/local/zookeeper/data

在最下面添加:server.0=192.168.1.111:2888:3888

server.1=192.168.1.112:2888:3888

server.2=192.168.1.113:2888:3888

建立zookeeper/data文件夹,并cd进入

执行vim myid

第一行添加0即可

在112中添加1,113中添加2

对应上面的servier.0 server.1 server.2

搭建完成

如果没有设置防火墙策略,则关闭所有机器的防火墙 service iptables stop

三台机器上运行:zkServer.sh start

任意一台运行:zkCli.sh可以连接上客户端

日志在zookeeper.out文件里

2:继续搭建activemq环境

( 1) 在192.168.1.111节点下,创建/usr/local/activemq-cluster文件夹,解压apache-activemq-5.11.1-

bin.tar.gz文件,然后对解压好的文件改名,操作如下:

1 命令: mkdir /usr/local/activemq-cluster

2 命令: cd software/

3 命令: tar -zxvf apache-activemq-5.11.1-bin.tar.gz -C

/usr/local/activemq-cluster/

4 命令: cd /usr/local/activemq-cluster/

5 命令: mv apache-activemq-5.11.1/ node1

如此操作,再次反复解压apache-activemq-5.11.1-

bin.tar.gz文件到/usr/local/activemqcluster/下,建立node2和node3文件夹,如下:

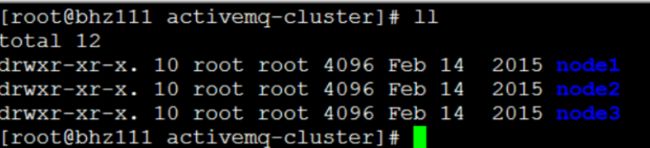

( 2) 那我们现在已经解压好了三个mq节点也就是node1、 node2、 node3,下面

我们要做的事情就是更改每个节点不同的配置和端口(由于是在一台机器上实

现集群)。

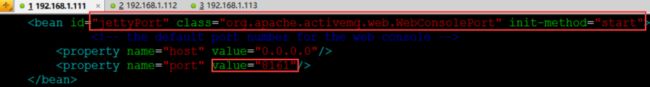

1 修改控制台端口(默认为8161) ,在mq安装路径下的conf/jetty.xml进

行修改即可。(三个节点都要修改,并且端口都不同)

1命令: cd /usr/local/activemq-cluster/node1/conf/

2命令: vim /usr/local/activemq-cluster/node1/conf/jetty.xml

三个节点都需要修改为8161、8162、8163!!!

2 集群配置文件修改:我们在mq安装路径下的conf/activemq.xml进行修

改其中的持久化适配器,修改其中的bind、 zkAddress、 hostname、 zkPath。

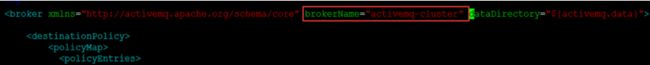

然后也需要修改mq的brokerName,并且每个节点名称都必须相同。

命令: vim /usr/local/activemq-cluster/node1/conf/activemq.xml

第一处修改: brokerName=”activemq-cluster”(三个节点都需要修改,这里就是统一三个节点的名字,集群需要相同的名字,随便起个自己喜欢的,三个节点一样的就可以。)

第二处修改:先注释掉适配器中的kahadb

第三处修改:添加新的leveldb配置如下(三个节点都需要修改):

Node1:

replicas="3"

bind="tcp://0.0.0.0:62621"

zkAddress="192.168.1.111:2181,192.168.1.112:2181,192.168.1.113:2181"

hostname="bhz111"

zkPath="/activemq/leveldb-stores"

/>

Node2:

replicas="3"

bind="tcp://0.0.0.0:62622"

zkAddress="192.168.1.111:2181,192.168.1.112:2181,192.168.1.113:2181"

hostname="bhz111"

zkPath="/activemq/leveldb-stores"

/>

Node3:

replicas="3"

bind="tcp://0.0.0.0:62623"

zkAddress="192.168.1.111:2181,192.168.1.112:2181,192.168.1.113:2181"

hostname="bhz111"

zkPath="/activemq/leveldb-stores"

/>

第四处修改:(修改通信的端口,避免冲突)

命令: vim /usr/local/activemq-cluster/node1/conf/activemq.xml

修改这个文件的通信端口号(比如与java通信端口), 三个节点都需要修改( 51511,51512,51513)

注释:directory 代表数据存储的路径,replicas =3 代表 有3个集群节点。bind端口代表集群之间通信端口。

zkAddress 代表和 zookeeper 集成地址,集成了三个zookeeper,zookeeper最好用奇数个,有利于内部结构优化。

Ok,到此为止,我们的activemq集群环境已经搭建完毕!

三:测试启动activemq集群:

第一步:启动zookeeper集群,命令: zkServer.sh start

第二步:启动mq集群:顺序启动mq:命令如下:

/usr/local/activemq-cluster/node1/bin/activemq start(关闭stop)

/usr/local/activemq-cluster/node2/bin/activemq start(关闭stop)

/usr/local/activemq-cluster/node3/bin/activemq start(关闭stop)

第三步:查看日志信息:

tail -f /usr/local/activemq-cluster/node1/data/activemq.log

tail -f /usr/local/activemq-cluster/node2/data/activemq.log

tail -f /usr/local/activemq-cluster/node3/data/activemq.log

如果不报错,我们的集群启动成功,可以使用控制台查看!

要想直接执行zkCli zookeeper 客户端要配置/etc/profile 环境变量

![]()

第四步:集群的brokerUrl配置进行修改即可:

failover:(tcp://192.168.1.111:51511,tcp://192.168.1.111:51512,tcp://1

92.168.1.111:51513)?Randomize=false

/usr/local/activemq-cluster/node1/bin/activemq stop

/usr/local/activemq-cluster/node2/bin/activemq stop

/usr/local/activemq-cluster/node3/bin/activemq stop

zkServer.sh stop

Java 测试代码如下:

发送端

package bhz.mq.cluster;

import javax.jms.Connection;

import javax.jms.ConnectionFactory;

import javax.jms.DeliveryMode;

import javax.jms.Destination;

import javax.jms.MessageProducer;

import javax.jms.Session;

import javax.jms.TextMessage;

import org.apache.activemq.ActiveMQConnectionFactory;

public class Sender {

public static void main(String[] args) {

try {

//第一步:建立ConnectionFactory工厂对象,需要填入用户名、密码、以及要连接的地址,均使用默认即可,默认端口为"tcp://localhost:61616"

ConnectionFactory connectionFactory = new ActiveMQConnectionFactory(

ActiveMQConnectionFactory.DEFAULT_USER,

ActiveMQConnectionFactory.DEFAULT_PASSWORD,

"failover:(tcp://192.168.1.111:51511,tcp://192.168.1.111:51512,tcp://192.168.1.111:51513)?Randomize=false");

//第二步:通过ConnectionFactory工厂对象我们创建一个Connection连接,并且调用Connection的start方法开启连接,Connection默认是关闭的。

Connection connection = connectionFactory.createConnection();

connection.start();

//第三步:通过Connection对象创建Session会话(上下文环境对象),用于接收消息,参数配置1为是否启用是事务,参数配置2为签收模式,一般我们设置自动签收。

Session session = connection.createSession(Boolean.FALSE, Session.AUTO_ACKNOWLEDGE);

//第四步:通过Session创建Destination对象,指的是一个客户端用来指定生产消息目标和消费消息来源的对象,在PTP模式中,Destination被称作Queue即队列;在Pub/Sub模式,Destination被称作Topic即主题。在程序中可以使用多个Queue和Topic。

Destination destination = session.createQueue("first");

//第五步:我们需要通过Session对象创建消息的发送和接收对象(生产者和消费者)MessageProducer/MessageConsumer。

MessageProducer producer = session.createProducer(null);

//第六步:我们可以使用MessageProducer的setDeliveryMode方法为其设置持久化特性和非持久化特性(DeliveryMode),我们稍后详细介绍。

//producer.setDeliveryMode(DeliveryMode.NON_PERSISTENT);

//第七步:最后我们使用JMS规范的TextMessage形式创建数据(通过Session对象),并用MessageProducer的send方法发送数据。同理客户端使用receive方法进行接收数据。最后不要忘记关闭Connection连接。

for(int i = 0 ; i < 500000 ; i ++){

TextMessage msg = session.createTextMessage("我是消息内容" + i);

// 第一个参数目标地址

// 第二个参数 具体的数据信息

// 第三个参数 传送数据的模式 持久化和非持久化

// 第四个参数 优先级

// 第五个参数 消息的过期时间

producer.send(destination, msg, DeliveryMode.NON_PERSISTENT, 0 , 1000L);

System.out.println("发送消息:" + msg.getText());

Thread.sleep(1000);

}

if(connection != null){

connection.close();

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

接收端

package bhz.mq.cluster;

import javax.jms.Connection;

import javax.jms.ConnectionFactory;

import javax.jms.Destination;

import javax.jms.MapMessage;

import javax.jms.Message;

import javax.jms.MessageConsumer;

import javax.jms.Session;

import javax.jms.TextMessage;

import org.apache.activemq.ActiveMQConnectionFactory;

public class Receiver {

public static void main(String[] args) {

try {

//第一步:建立ConnectionFactory工厂对象,需要填入用户名、密码、以及要连接的地址,均使用默认即可,默认端口为"tcp://localhost:61616"

ConnectionFactory connectionFactory = new ActiveMQConnectionFactory(

ActiveMQConnectionFactory.DEFAULT_USER,

ActiveMQConnectionFactory.DEFAULT_PASSWORD,

"failover:(tcp://192.168.1.111:51511,tcp://192.168.1.111:51512,tcp://192.168.1.111:51513)?Randomize=false");

//第二步:通过ConnectionFactory工厂对象我们创建一个Connection连接,并且调用Connection的start方法开启连接,Connection默认是关闭的。

Connection connection = connectionFactory.createConnection();

connection.start();

//第三步:通过Connection对象创建Session会话(上下文环境对象),用于接收消息,参数配置1为是否启用是事务,参数配置2为签收模式,一般我们设置自动签收。

Session session = connection.createSession(Boolean.FALSE, Session.AUTO_ACKNOWLEDGE);

//第四步:通过Session创建Destination对象,指的是一个客户端用来指定生产消息目标和消费消息来源的对象,在PTP模式中,Destination被称作Queue即队列;在Pub/Sub模式,Destination被称作Topic即主题。在程序中可以使用多个Queue和Topic。

Destination destination = session.createQueue("first");

//第五步:通过Session创建MessageConsumer

MessageConsumer consumer = session.createConsumer(destination);

while(true){

TextMessage msg = (TextMessage)consumer.receive();

if(msg == null) break;

System.out.println("收到的内容:" + msg.getText());

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

和zookeeper 集成 连接activemq的时候代码里要加这个failover:

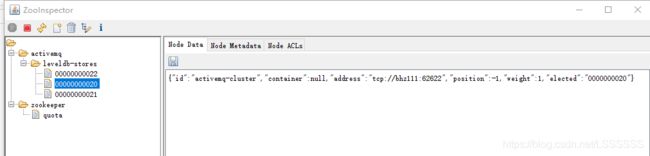

用Java 写的工具zookeeper-dev-ZooInspector.jar 可以连接zookeeper 查看下面挂的activemq信息。

elected:0000000020代表主节点是20节点。

接受端和发送端都启动后,会传递消息,这时候kill掉主节点,会自动选取一个21或者22作为主节点,消息继续发送不会断。

以上完成的其实都是高可用,下面第四个才是集群

第四:负载均衡配置如下:

配置在activemq.xml 中标签

集群1链接集群2:

duplex="false"/>

集群2链接集群1:

duplex="false"/>