池化层学习笔记(C++实现)

参考文章:《深度学习笔记5:池化层的实现》

池化层的理解:

池化层是卷积神经网络中常用的操作,属于前馈神经网络的一部分。主要功能:

1. 降低参数规模,防止过拟合 2. 提高模型鲁棒性(当图像有小的平移时,maxpooling结果不变)主要方法

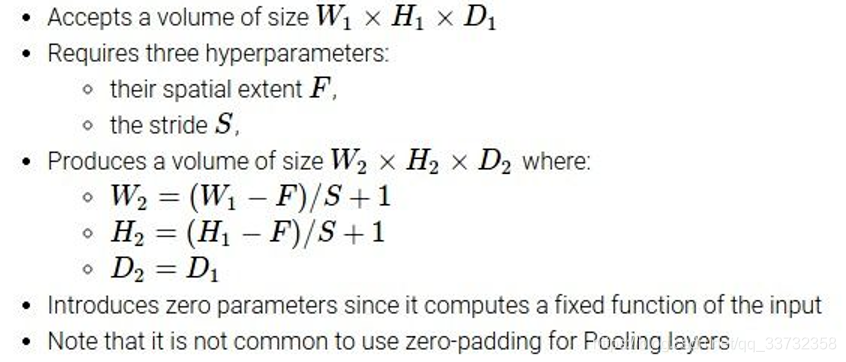

3. Max-pooling:最大池化 4. Mean-pooling:平均池化目标矩阵的尺寸

C++代码实现

#include "pch.h"

#include