- day11 学习笔记

豆豆

学习笔记python

文章目录前言一、类方法二、静态方法三、构造方法四、魔术方法前言通过今天的学习,我掌握了更多Python中有关面向对象编程思想中方法的概念与操作,包括类方法,静态方法,构造方法,魔术方法一、类方法类方法是属于类的行为,一般使用类而非对象进行调用类方法需要使用@classmethod装饰器定义类方法至少有一个形参用于绑定类,约定为cls类和该类的实例都可以调用类方法,但一般不用实例进行调用类方法不能访

- 手机号码归属地API:助力数字化服务的利器

api

前言在当今数字化时代,手机号码已成为人们日常生活中不可或缺的一部分,而手机号码归属地API作为一种高效、便捷的网络服务接口,正逐渐成为众多行业提升用户体验和服务质量的重要工具。什么是手机号码归属地API?手机号码归属地API是一种允许开发者通过编程方式查询手机号码注册地信息的网络服务接口。它通常由第三方服务提供商通过HTTP请求的方式提供。通过这种API,开发者可以快速获取手机号码的归属地信息,包

- 低空经济-低空智联网技术体系白皮书

yili_sha11

人工智能

目录低空定义低空政策低空市场规模低空应用场景通信需求监管需求低空智联网技术体系低空定义低空经济是指在3000米以下,以低空空域为依托,以各种有人和无人驾驶航空器的低空飞行活动为牵引,辐射带动相关领域融合发展的综合性经济形态低空政策在国家层面,2021年2月,中共中央、国务院印发《国家综合立体交通网规划纲要》,提出“发展交通运输平台经济、枢纽经济、通道经济、低空经济”,首次将“低空经济”概念写入国家

- AT89C52交通灯设计

跟着我跳

mongodb数据库

1.设计目的、作用1、掌握C52单片机最小系统的设计;2、掌握按键电路设计,数码管的使用;3、掌握C52的编程方式;4、掌握C52各引脚的作用;5、进一步加强对焊接技术的练习。2.设计要求基于AT89C52单片机的交通灯主要具有如下功能:基本要求如下:1、按键1为交通灯“深夜模式”开/关,按下后进入深夜模式,4个方向LED(黄)闪烁;再次按下后则退出深夜模式,交通灯正常运行。2、按键2为“时间调整

- WinPcap编程——APR欺骗

4ct10n

VC++winpcap编程arp

一实验要求利用WinPcap编程,实现基于ARP欺骗的中间人攻击。1)利用WinPcap,分别向被欺骗主机和网关发送APR请求包,达到同时欺骗目标主机和网关的目的;2)所有目标主机和网关之间的数据都会被我们劫持,过滤两者之间的所有http交互数据包,并保存为文件。(http包的过滤可用80端口来标识)二实验原理1选择网卡及过滤规则在这里特别注以下几点:1.charpacket_filter[]="

- 网络编程--服务器双客户端聊天

疾跑哥布林升级版

java算法开发语言

写一个服务器和客户端运行服务器和2个客户端,实现聊天功能客户端1和客户端2进行聊天,客户端1将聊天数据发送给服务器,服务器将聊天数据转发给客户端2要求:服务器使用select模型实现,客户端1使用poll模型实现,客户端2使用多线程实现服务器:#include//将client存入数组arr中的最后一个位置上,存完之后,arr数组的长度记得自增voidinsert_client(intarr[],

- 2025年零基础入门学网络安全(详细),看这篇就够了

网安大师兄

web安全安全网络网络安全密码学

基于入门网络安全/黑客打造的:黑客&网络安全入门&进阶学习资源包一、自学网络安全学习的误区和陷阱1.不要试图先成为一名程序员(以编程为基础的学习)再开始学习我在之前的回答中,我都一再强调不要以编程为基础再开始学习网络安全,一般来说,学习编程不但学习周期长,而且实际向安全过渡后可用到的关键知识并不多一般人如果想要把编程学好再开始学习网络安全往往需要花费很长时间,容易半途而废。而且学习编程只是工具不是

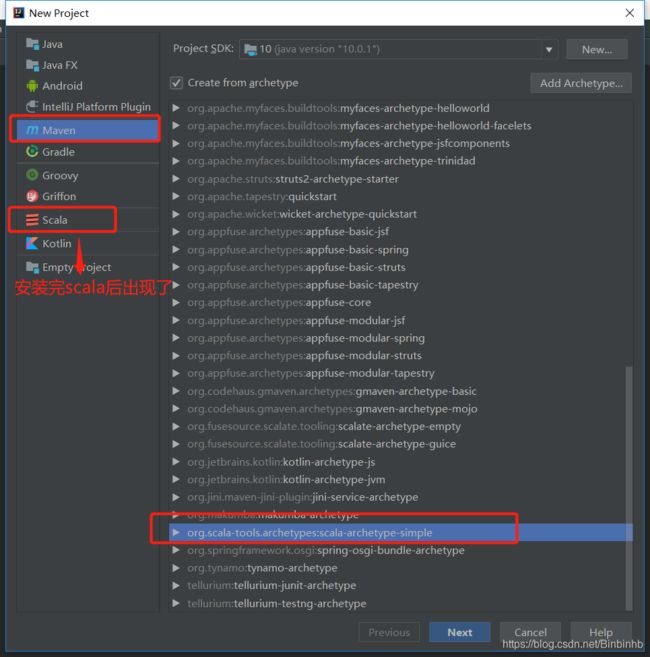

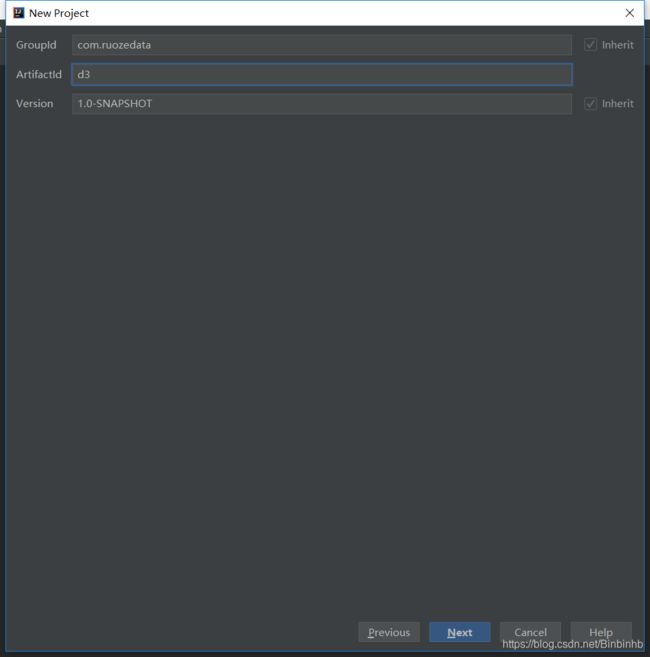

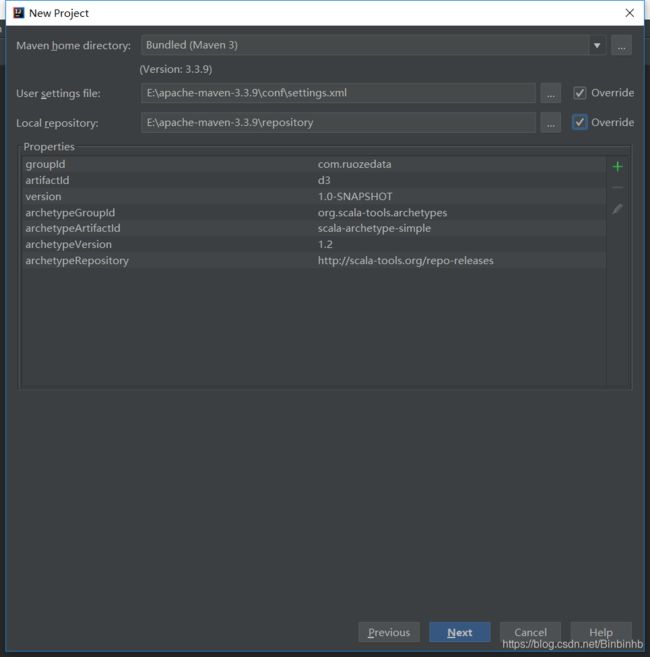

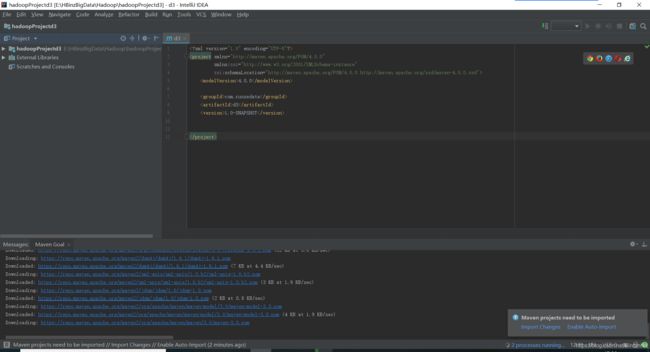

- #Hadoop全分布式安装 #mysql安装 #hive安装

砸吧砸吧

hadoophiveyarnmysql

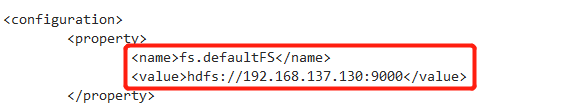

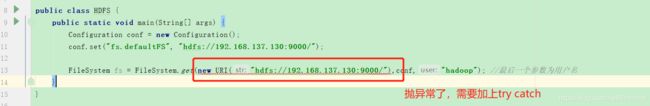

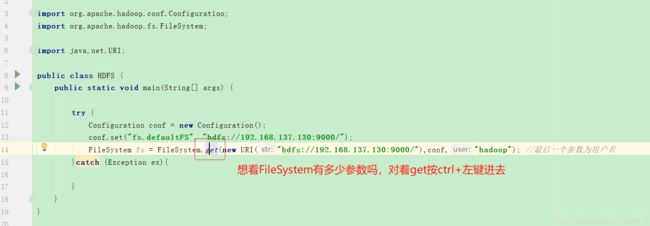

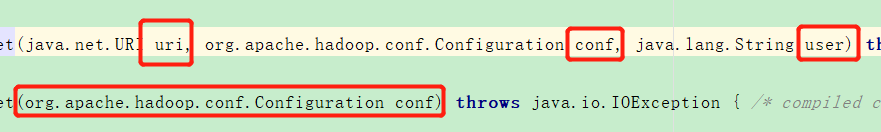

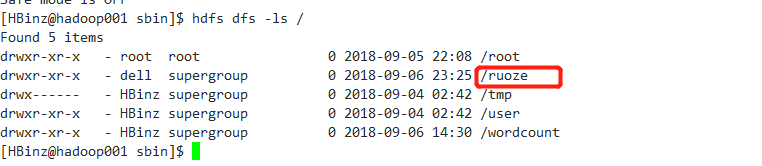

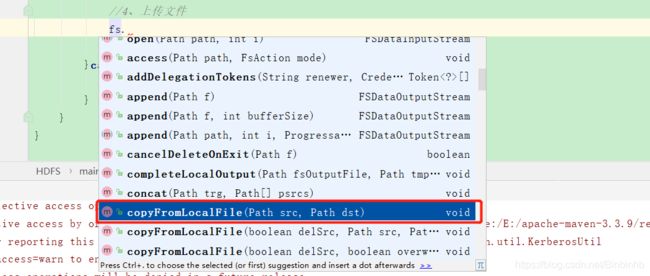

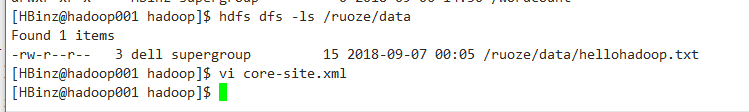

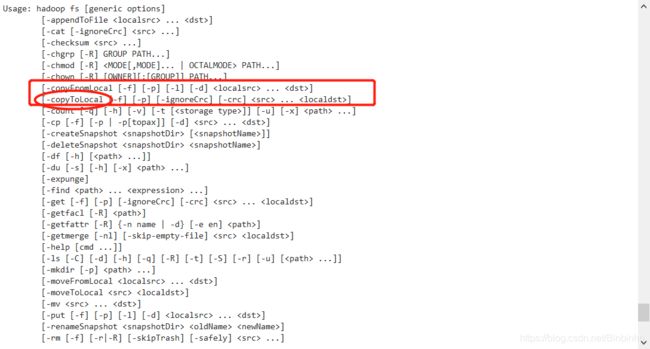

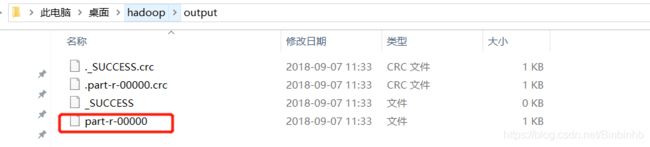

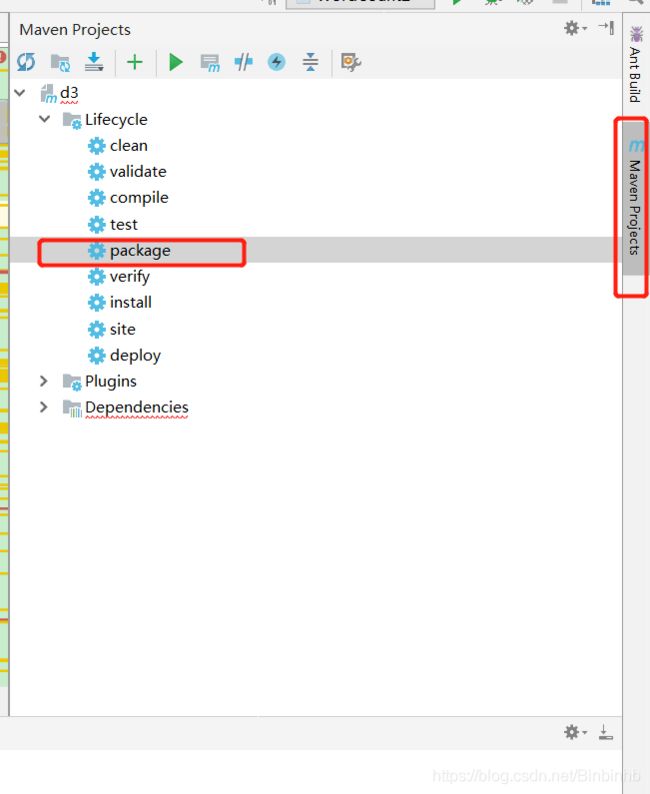

分布式(多台机器部署不同组件)与集群(多台机器部署相同组件)概念。Linux基础命令linux具有文件数:目录、文件,从根目录开始,路径具有唯一性。pwd:显示当前路径特殊符号:/:根目录.:隐藏文件,如果路径以.开始,表示当前目录下..:当前目录下的上一级~:当前目录的home目录--help:帮助命令使用linux常用操作命令tab键:自动补全ls:显示指定目录内容默认:当前路径-a:显示所有

- 并发爬虫实战:多线程高效抓取王者荣耀全英雄皮肤

YiFoEr_Liu

爬虫案例实操爬虫部署python爬虫python大数据

一、场景与挑战在网络爬虫开发中,我们常常面临以下挑战:需要处理成百上千个页面的数据抓取目标服务器存在反爬机制和请求频率限制单线程模式下载效率低下,难以充分利用带宽本文以王者荣耀英雄皮肤下载为例(日访问量超过1亿的热门游戏),演示如何通过Python并发编程实现高效数据抓取。二、技术选型分析2.1为什么选择并发线程?I/O密集型场景:网络请求占比90%以上GIL限制:Python线程适合I/O密集型

- 深入理解正则表达式:语法全解析

谢兴豪

本文还有配套的精品资源,点击获取简介:正则表达式是一种用于文本匹配的模式,广泛应用在文本处理、数据验证等领域。本文将全面探讨正则表达式的语法细节,包括字符匹配、元字符、字符类、量词、分组与反向引用、选择与否定、位置锚点、预定义字符集、模式修饰符、回溯控制以及正向先行断言和正向后行断言。掌握这些知识有助于提高编程效率和代码质量。1.正则表达式简介正则表达式是IT行业中的“瑞士军刀”,它们在文本处理、

- 探索 ESP32:物联网时代的全能微控制器

菜只因C

物联网

引言:从ESP8266到ESP32的进化之路在物联网(IoT)蓬勃发展的今天,嵌入式设备需要兼具高性能、低功耗和联网能力。乐鑫科技(RobinLi)推出的ESP32系列芯片,正是这一需求下的产物。自2016年发布以来,ESP32凭借其卓越的综合性能,迅速成为物联网开发者的首选平台。本文将从硬件架构、核心功能、开发生态到实际应用,全面解析这款"物联网心脏"的奥秘。一、ESP32的硬件架构解析1.1双

- 正则表达式:编程中的瑞士军刀,如何借助智能工具实现高效开发

inscode_039

最新接入DeepSeek-V3模型,点击下载最新版本InsCodeAIIDE正则表达式:编程中的瑞士军刀,如何借助智能工具实现高效开发正则表达式(RegularExpression,简称regex或regexp)是一种用于匹配字符串的模式描述语言。它广泛应用于文本处理、数据验证、搜索和替换等场景中。然而,正则表达式的复杂性和晦涩性常常让编程初学者望而却步。幸运的是,随着AI技术的进步,像InsCo

- 防火墙综合实验

earthtoearth

防火墙安全实验配置网络运维安全网络安全

一、实验目的及拓扑实验目的:1、内网设立两台防火墙实现双机热备2、防火墙设置二个虚拟系统,VRF_A对应PC1和服务器,VRF_B对应PC2,虚拟防火墙内部实现对服务器的访问3、PC1访问外网通过防火墙1,PC2访问外网通过防火墙24、将服务器向外网通过NATSERVER进行地址映射,使外网能够访问内网服务器5、在防火墙VRF_A虚墙上设置超级用户后设置相应功能二、基础配置(一)交换网络配置1、在

- 正则表达式:文本处理的瑞士军刀

六七_Shmily

数据结构与算法分析算法

正则表达式:文本处理的瑞士军刀正则表达式(RegularExpression,简称Regex)是一种用于匹配、查找和操作文本的强大工具。它通过定义一种特殊的字符串模式,可以快速地在文本中搜索、替换或提取符合特定规则的内容。正则表达式广泛应用于编程、文本编辑、数据处理等领域,是每个开发者必备的技能之一。一、正则表达式的核心概念1.模式(Pattern)正则表达式的核心是一个模式字符串,它定义了需要匹

- python的离线安装包下载

Lake说科技

python服务器linux开发语言运维

Python,安装相关视频讲解:python的or运算赋值用法用python编程Excel有没有用处?011_编程到底好玩在哪?查看python文件_输出py文件_cat_运行python文件_shel如何实现Python的离线安装包下载一、流程:步骤说明1确定需要下载的Python安装包版本2下载对应版本的离线安装包3将下载好的安装包传输至目标机器4在目标机器上进行安装二、具体步骤及代码:步骤1

- 【MATLAB】simulink中的S-function

龙泽金

matlab开发语言

1.简介S-function(系统函数)在MATLAB的Simulink中具有重要作用。它是一种可以用多种编程语言(如C、C++、Fortran等)编写的函数,用于自定义模块的行为。通过编写S-function,可以实现特定的算法、逻辑或复杂的动态特性,来扩展Simulink的功能。S-function可以处理输入信号,进行计算,并产生输出信号。它能够实现对模型中特定部分的精细控制和定制化,以满足

- 使用Python下载抖音短视频:完整教程与代码解析

cnh6070

短视频python音视频开发语言

抖音作为全球领先的短视频平台,拥有海量的优质内容。然而,抖音官方并未提供直接下载视频的功能,这给一些用户带来了不便。幸运的是,通过Python编程,我们可以实现抖音视频的下载。本文将详细介绍如何使用Python下载抖音短视频,并解析一个完整的代码示例。一、准备工作在开始之前,你需要确保已经安装了Python环境,并且安装了以下必要的Python库:requests:用于发送网络请求,获取网页内容或

- 时制转换

TXHNY

C语言习题

现在输入一个24小时制的时间,请编程将其转换为12小时制时间格式,输出转换后的时间,原来时间如果是上午,那么需要在转换时间之后输出空格和AM,原来时间如果是下午,在转换时间之后输出空格和PM,输出具体参考样例。注:在24小时制中,[00:00~12:00]认为是上午,[12:01~23:59]认为是下午。提示:输出时间:分钟的格式请使用printf("%02d:%02dAM或PM"),%02d表示

- PTA基础编程集7-20 打印九九口诀表 (15分)

ohhTechSoon

PTA基础编程集

7-20打印九九口诀表(15分)下面是一个完整的下三角九九口诀表:11=112=222=413=323=633=914=424=834=1244=1615=525=1035=1545=2055=2516=626=1236=1846=2456=3066=3617=727=1437=2147=2857=3567=4277=4918=828=1638=2448=3258=4068=4878=5688=6

- 基于Python的智能决策支持系统:实现智能化决策的关键要素

AI天才研究院

DeepSeekR1&大数据AI人工智能大模型自然语言处理人工智能语言模型编程实践开发语言架构设计

文章目录基于Python的智能决策支持系统:实现智能化决策的关键要素11.背景介绍2.核心概念与联系数据收集与预处理模型构建与训练决策规则生成与优化决策结果评估与反馈3.核心算法原理具体操作步骤数据挖掘算法机器学习算法优化算法4.数学模型和公式详细讲解举例说明线性回归模型最小二乘法5.项目实践:代码实例和详细解释说明6.实际应用场景金融领域医疗领域供应链管理智能制造7.工具和资源推荐编程语言和开发

- 西门子PLC S7-1200实例详解:涉及安川机器人通信、伺服电机控制及传感器数据轮询

DMQAfdLc

机器人大数据

西门子PLCS7-1200程序实例解析:电气编程者的技术之旅随着科技的飞速发展,工业自动化已成为现代制造业的核心。西门子PLC以其卓越的性能和广泛的应用,成为了工业控制领域的佼佼者。在本次技术博客中,我们将深入探讨西门子PLCS7-1200在博图版本V15下的应用实例,为电气编程者提供宝贵的学习借鉴。一、西门子PLC与安川机器人TCPIP通讯在工业自动化领域,PLC与机器人之间的通讯至关重要。西门

- 高云FPGA的管脚约束文件的复制

在岸上走的鱼

fpga开发嵌入式硬件硬件架构

问:Gowin里面能不能直接拷贝一个管脚约束文件进去用?答:可以直接拷贝,但是拷贝前后两个工程对应的芯片必须要是同一个芯片拷贝方法:第一步:按照被拷贝约束文件对应的芯片新建一个工程,然后将原工程文件夹“src”里面的“.cst”文件拷到新建工程的相同目录下,第二步:回到新建工程目录下,点击芯片名右击,如下图:将“.V”文件和“.cst”文件一同加入这个工程,最后综合,布局布线就可以了,注意:有时拷

- Pytorch使用手册—扩展 TorchScript 使用自定义 C++ 操作符(专题五十三)

AI专题精讲

Pytorch入门到精通pytorchc++人工智能

提示本教程自PyTorch2.4起已弃用。有关PyTorch自定义操作符的最新指南,请参阅PyTorch自定义操作符。PyTorch1.0版本引入了一种名为TorchScript的新编程模型。TorchScript是Python编程语言的一个子集,可以被TorchScript编译器解析、编译和优化。此外,编译后的TorchScript模型可以选择序列化为磁盘文件格式,随后你可以从纯C++(以及Py

- Hadoop(在Linux中安装jdk)

錠诗味

linuxhadoop运维

安装之前需准备:1.需要远程连接软件2.需要jdk3.需要准备两个文件夹01/export/software安装包02/export/servers解压文件夹现在正式开始安装1.将压缩包存放在/export/software目录下2.进入到software目录进行解压cd/export/software(切换目录)tar-zxvfjdk-8u202-linux-x64.tar.gz-C/expor

- 数据仓库和非结构化数据。

weixin_30631587

数据库

数据仓库包含标准化数据。还包含外部数据/非结构化数据如果外部数据量小可以保持数据库内部或者专用服务器。如果量大只能记住地址,在etl加载当然也有需求是实时数据比如股票汇率拿只能etl过程处理非结构化数据包含图片,视频音频如果是传统数据库db2oracle存在里面是不合适的。存储影响性能如果是hadoop无所谓影响不大,但是从使用者的角度非结构化数据只能转换关系使用建一张元数据表存储非结构化存储位置

- Cursor 终极使用指南:从零开始走向AI编程

芯作者

DD:日记人工智能机器学习深度学习AI编程

在数字化浪潮席卷全球的今天,人工智能(AI)已不再是遥不可及的概念,而是逐渐融入我们日常生活的方方面面。作为未来技术的核心驱动力,AI编程成为了众多开发者和技术爱好者争相探索的领域。而在这场技术革命中,Cursor——这一看似简单却功能强大的编程工具,正悄然成为连接初学者与AI编程高手的桥梁。本文将带你从零开始,逐步解锁Cursor的终极使用指南,让你在AI编程的道路上越走越远。一、初识Curso

- 六十天前端强化训练之第二十一天大师级详解 React Context API:从原理到实战

编程星辰海

#前端前端react.jsjavascriptReactContextAPI

=====欢迎来到编程星辰海的博客讲解======看完可以给一个免费的三连吗,谢谢大佬!目录一、庖丁解牛:深入理解ContextAPI1.1设计哲学与运转机制工作原理三步曲:1.2核心三剑客详解1.3性能优化要诀二、手把手实现主题切换系统2.1完整代码实现(逐行注释版)2.2配套CSS样式设计三、关键知识点拆解3.1状态初始化策略3.2CSS变量注入原理3.3性能优化实践3.4可访问性最佳实践四、

- 编程-设计模式 30:拦截过滤器模式(Interceptor Filter Pattern)

漆黑的莫莫

编程设计模式J2EE设计模式设计模式

设计模式30:拦截过滤器模式(InterceptorFilterPattern)定义与目的定义:拦截过滤器模式是一种用于Web应用程序中的模式,它提供了一种机制来拦截请求和响应,并在它们到达目标处理程序之前执行一些预处理任务,在响应返回客户端之前执行一些后处理任务。目的:该模式的主要目的是通过将请求处理逻辑与请求的预处理和后处理任务分离,提高应用程序的模块化程度和可维护性。实现示例假设我们有一个简

- 暗光增强技术研究进展与产品落地综合分析(2023-2025)

AndrewHZ

深度学习新浪潮图像处理算法动态范围计算机视觉深度学习transformer暗光增强

一、引言暗光增强技术作为计算机视觉与移动影像领域的核心研究方向之一,近年来在算法创新、硬件适配及产品落地方面取得了显著进展。本文从技术研究与产业应用两个维度,系统梳理近三年(2023-2025)该领域的关键突破,并对比分析主流手机厂商的影像技术优劣势。二、暗光增强技术研究进展1.算法创新:从传统模型到深度学习(1)Retinex理论的深度结合清华与ETH联合提出的Retinexformer(202

- JAVA论文相关技术介绍(JAVA技术)

Curry Peng

java开发语言

3.JAVA技术Java是一种广泛使用的编程语言,具有以下显著特点和优势:面向对象编程(OOP):支持封装、继承和多态等特性,使代码更具模块化、可维护性和可扩展性。平台独立性:Java程序可以在不同的操作系统和硬件平台上运行,只需安装相应的Java运行环境(JRE)。安全性:提供了强大的安全机制,包括访问控制、字节码验证等,确保程序的安全性和稳定性。丰富的类库:拥有大量预先编写好的类和接口,涵盖了

- PHP,安卓,UI,java,linux视频教程合集

cocos2d-x小菜

javaUIPHPandroidlinux

╔-----------------------------------╗┆

- 各表中的列名必须唯一。在表 'dbo.XXX' 中多次指定了列名 'XXX'。

bozch

.net.net mvc

在.net mvc5中,在执行某一操作的时候,出现了如下错误:

各表中的列名必须唯一。在表 'dbo.XXX' 中多次指定了列名 'XXX'。

经查询当前的操作与错误内容无关,经过对错误信息的排查发现,事故出现在数据库迁移上。

回想过去: 在迁移之前已经对数据库进行了添加字段操作,再次进行迁移插入XXX字段的时候,就会提示如上错误。

&

- Java 对象大小的计算

e200702084

java

Java对象的大小

如何计算一个对象的大小呢?

- Mybatis Spring

171815164

mybatis

ApplicationContext ac = new ClassPathXmlApplicationContext("applicationContext.xml");

CustomerService userService = (CustomerService) ac.getBean("customerService");

Customer cust

- JVM 不稳定参数

g21121

jvm

-XX 参数被称为不稳定参数,之所以这么叫是因为此类参数的设置很容易引起JVM 性能上的差异,使JVM 存在极大的不稳定性。当然这是在非合理设置的前提下,如果此类参数设置合理讲大大提高JVM 的性能及稳定性。 可以说“不稳定参数”

- 用户自动登录网站

永夜-极光

用户

1.目标:实现用户登录后,再次登录就自动登录,无需用户名和密码

2.思路:将用户的信息保存为cookie

每次用户访问网站,通过filter拦截所有请求,在filter中读取所有的cookie,如果找到了保存登录信息的cookie,那么在cookie中读取登录信息,然后直接

- centos7 安装后失去win7的引导记录

程序员是怎么炼成的

操作系统

1.使用root身份(必须)打开 /boot/grub2/grub.cfg 2.找到 ### BEGIN /etc/grub.d/30_os-prober ### 在后面添加 menuentry "Windows 7 (loader) (on /dev/sda1)" {

- Oracle 10g 官方中文安装帮助文档以及Oracle官方中文教程文档下载

aijuans

oracle

Oracle 10g 官方中文安装帮助文档下载:http://download.csdn.net/tag/Oracle%E4%B8%AD%E6%96%87API%EF%BC%8COracle%E4%B8%AD%E6%96%87%E6%96%87%E6%A1%A3%EF%BC%8Coracle%E5%AD%A6%E4%B9%A0%E6%96%87%E6%A1%A3 Oracle 10g 官方中文教程

- JavaEE开源快速开发平台G4Studio_V3.2发布了

無為子

AOPoraclemysqljavaeeG4Studio

我非常高兴地宣布,今天我们最新的JavaEE开源快速开发平台G4Studio_V3.2版本已经正式发布。大家可以通过如下地址下载。

访问G4Studio网站

http://www.g4it.org

G4Studio_V3.2版本变更日志

功能新增

(1).新增了系统右下角滑出提示窗口功能。

(2).新增了文件资源的Zip压缩和解压缩

- Oracle常用的单行函数应用技巧总结

百合不是茶

日期函数转换函数(核心)数字函数通用函数(核心)字符函数

单行函数; 字符函数,数字函数,日期函数,转换函数(核心),通用函数(核心)

一:字符函数:

.UPPER(字符串) 将字符串转为大写

.LOWER (字符串) 将字符串转为小写

.INITCAP(字符串) 将首字母大写

.LENGTH (字符串) 字符串的长度

.REPLACE(字符串,'A','_') 将字符串字符A转换成_

- Mockito异常测试实例

bijian1013

java单元测试mockito

Mockito异常测试实例:

package com.bijian.study;

import static org.mockito.Mockito.mock;

import static org.mockito.Mockito.when;

import org.junit.Assert;

import org.junit.Test;

import org.mockito.

- GA与量子恒道统计

Bill_chen

JavaScript浏览器百度Google防火墙

前一阵子,统计**网址时,Google Analytics(GA) 和量子恒道统计(也称量子统计),数据有较大的偏差,仔细找相关资料研究了下,总结如下:

为何GA和量子网站统计(量子统计前身为雅虎统计)结果不同?

首先:没有一种网站统计工具能保证百分之百的准确出现该问题可能有以下几个原因:(1)不同的统计分析系统的算法机制不同;(2)统计代码放置的位置和前后

- 【Linux命令三】Top命令

bit1129

linux命令

Linux的Top命令类似于Windows的任务管理器,可以查看当前系统的运行情况,包括CPU、内存的使用情况等。如下是一个Top命令的执行结果:

top - 21:22:04 up 1 day, 23:49, 1 user, load average: 1.10, 1.66, 1.99

Tasks: 202 total, 4 running, 198 sl

- spring四种依赖注入方式

白糖_

spring

平常的java开发中,程序员在某个类中需要依赖其它类的方法,则通常是new一个依赖类再调用类实例的方法,这种开发存在的问题是new的类实例不好统一管理,spring提出了依赖注入的思想,即依赖类不由程序员实例化,而是通过spring容器帮我们new指定实例并且将实例注入到需要该对象的类中。依赖注入的另一种说法是“控制反转”,通俗的理解是:平常我们new一个实例,这个实例的控制权是我

- angular.injector

boyitech

AngularJSAngularJS API

angular.injector

描述: 创建一个injector对象, 调用injector对象的方法可以获得angular的service, 或者用来做依赖注入. 使用方法: angular.injector(modules, [strictDi]) 参数详解: Param Type Details mod

- java-同步访问一个数组Integer[10],生产者不断地往数组放入整数1000,数组满时等待;消费者不断地将数组里面的数置零,数组空时等待

bylijinnan

Integer

public class PC {

/**

* 题目:生产者-消费者。

* 同步访问一个数组Integer[10],生产者不断地往数组放入整数1000,数组满时等待;消费者不断地将数组里面的数置零,数组空时等待。

*/

private static final Integer[] val=new Integer[10];

private static

- 使用Struts2.2.1配置

Chen.H

apachespringWebxmlstruts

Struts2.2.1 需要如下 jar包: commons-fileupload-1.2.1.jar commons-io-1.3.2.jar commons-logging-1.0.4.jar freemarker-2.3.16.jar javassist-3.7.ga.jar ognl-3.0.jar spring.jar

struts2-core-2.2.1.jar struts2-sp

- [职业与教育]青春之歌

comsci

教育

每个人都有自己的青春之歌............但是我要说的却不是青春...

大家如果在自己的职业生涯没有给自己以后创业留一点点机会,仅仅凭学历和人脉关系,是难以在竞争激烈的市场中生存下去的....

&nbs

- oracle连接(join)中使用using关键字

daizj

JOINoraclesqlusing

在oracle连接(join)中使用using关键字

34. View the Exhibit and examine the structure of the ORDERS and ORDER_ITEMS tables.

Evaluate the following SQL statement:

SELECT oi.order_id, product_id, order_date

FRO

- NIO示例

daysinsun

nio

NIO服务端代码:

public class NIOServer {

private Selector selector;

public void startServer(int port) throws IOException {

ServerSocketChannel serverChannel = ServerSocketChannel.open(

- C语言学习homework1

dcj3sjt126com

chomework

0、 课堂练习做完

1、使用sizeof计算出你所知道的所有的类型占用的空间。

int x;

sizeof(x);

sizeof(int);

# include <stdio.h>

int main(void)

{

int x1;

char x2;

double x3;

float x4;

printf(&quo

- select in order by , mysql排序

dcj3sjt126com

mysql

If i select like this:

SELECT id FROM users WHERE id IN(3,4,8,1);

This by default will select users in this order

1,3,4,8,

I would like to select them in the same order that i put IN() values so:

- 页面校验-新建项目

fanxiaolong

页面校验

$(document).ready(

function() {

var flag = true;

$('#changeform').submit(function() {

var projectScValNull = true;

var s ="";

var parent_id = $("#parent_id").v

- Ehcache(02)——ehcache.xml简介

234390216

ehcacheehcache.xml简介

ehcache.xml简介

ehcache.xml文件是用来定义Ehcache的配置信息的,更准确的来说它是定义CacheManager的配置信息的。根据之前我们在《Ehcache简介》一文中对CacheManager的介绍我们知道一切Ehcache的应用都是从CacheManager开始的。在不指定配置信

- junit 4.11中三个新功能

jackyrong

java

junit 4.11中两个新增的功能,首先是注解中可以参数化,比如

import static org.junit.Assert.assertEquals;

import java.util.Arrays;

import org.junit.Test;

import org.junit.runner.RunWith;

import org.junit.runn

- 国外程序员爱用苹果Mac电脑的10大理由

php教程分享

windowsPHPunixMicrosoftperl

Mac 在国外很受欢迎,尤其是在 设计/web开发/IT 人员圈子里。普通用户喜欢 Mac 可以理解,毕竟 Mac 设计美观,简单好用,没有病毒。那么为什么专业人士也对 Mac 情有独钟呢?从个人使用经验来看我想有下面几个原因:

1、Mac OS X 是基于 Unix 的

这一点太重要了,尤其是对开发人员,至少对于我来说很重要,这意味着Unix 下一堆好用的工具都可以随手捡到。如果你是个 wi

- 位运算、异或的实际应用

wenjinglian

位运算

一. 位操作基础,用一张表描述位操作符的应用规则并详细解释。

二. 常用位操作小技巧,有判断奇偶、交换两数、变换符号、求绝对值。

三. 位操作与空间压缩,针对筛素数进行空间压缩。

&n

- weblogic部署项目出现的一些问题(持续补充中……)

Everyday都不同

weblogic部署失败

好吧,weblogic的问题确实……

问题一:

org.springframework.beans.factory.BeanDefinitionStoreException: Failed to read candidate component class: URL [zip:E:/weblogic/user_projects/domains/base_domain/serve

- tomcat7性能调优(01)

toknowme

tomcat7

Tomcat优化: 1、最大连接数最大线程等设置

<Connector port="8082" protocol="HTTP/1.1"

useBodyEncodingForURI="t

- PO VO DAO DTO BO TO概念与区别

xp9802

javaDAO设计模式bean领域模型

O/R Mapping 是 Object Relational Mapping(对象关系映射)的缩写。通俗点讲,就是将对象与关系数据库绑定,用对象来表示关系数据。在O/R Mapping的世界里,有两个基本的也是重要的东东需要了解,即VO,PO。

它们的关系应该是相互独立的,一个VO可以只是PO的部分,也可以是多个PO构成,同样也可以等同于一个PO(指的是他们的属性)。这样,PO独立出来,数据持

![]()

![]()