对极大似然估计、梯度下降、线性回归、逻辑回归的理解

极大似然

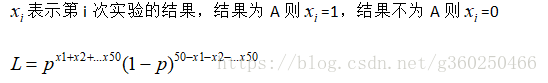

我对极大似然估计条件概率(后验概率)和先验概率的的理解:假设一次实验,可能出现两种结果,A或者B

总共进行了50次实验,A出现了20次,B出现了30次,那么求A的概率p。

问题来了,怎么求一个合理的p值呢

L表示A出现的概率为p的情况下,进行50次实验,各种情况的概率。

这个很好理解,假如出现20次A,30次B,则x1+x2+...+x50=20,出现为1,不出现为0,所以出现了20次。

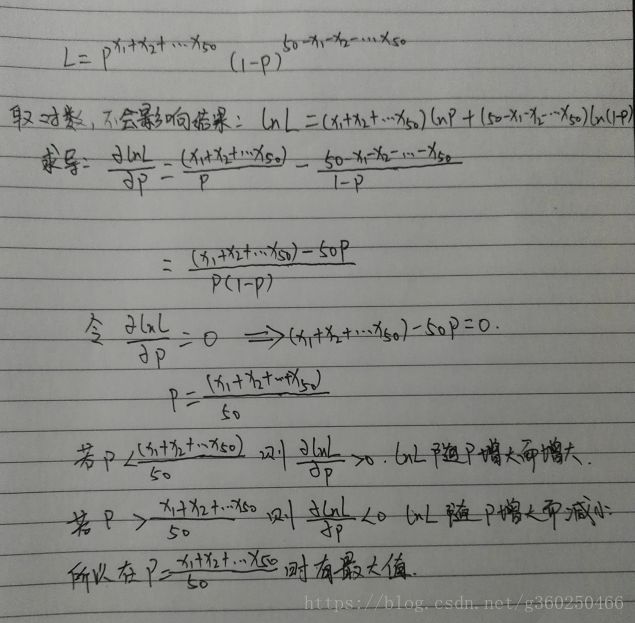

所以:

当L最大时,才说明这些样本出现的情况是最可能的,这样的情况下,A的概率才是最合理的。假如L很小,则说明这些样本出现的情况很极端,此时A的概率是很不合理的。

当实验次数变为N的时候,A出现的次数变为m的时候那么最大似然估计A的先验概率就为m/N

同样的,当实验出现的类别变为A、B、C...等多类的时候可以将A的概率设为p,其他类的该类为(1-p),同样可以按照上图推导出来A的先验概率为m/N

用极大似然来估计条件概率也和上图是一样的方法,只是N为在某一条件的样本总数,而m为这一条件下A出现的数量。

梯度下降

在这里先声明一点,矩阵和向量的关系:

向量就是n行1列的特殊矩阵

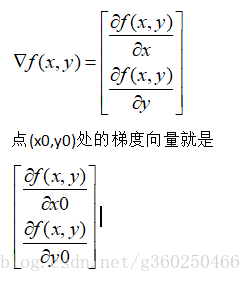

再来从数学角度看一下梯度的定义。在微积分里面,对多元函数的参数求∂偏导数,把求得的各个参数的偏导数以向量的形式写出来,就是梯度。所谓的用向量表示出来就是写成矩阵的形式。比如函数f(x,y), 分别对x,y求偏导数,求得的梯度向量就是(∂f/∂x, ∂f/∂y)T,简称grad f(x,y)或者▽f(x,y)。

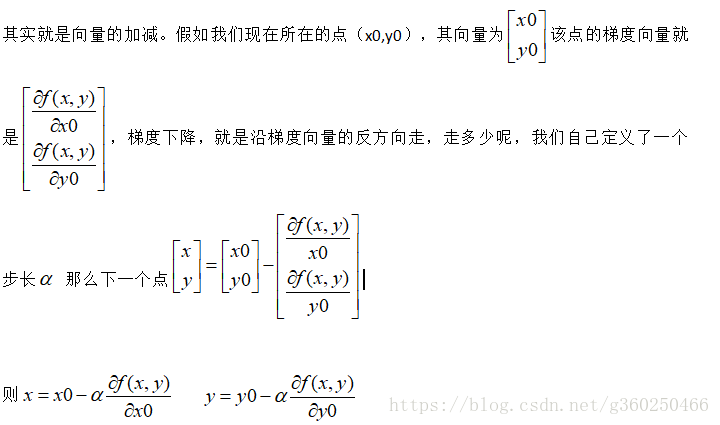

从几何意义上讲,梯度就是函数变化增加最快的地方。具体来说,对于函数f(x,y),在点(x0,y0),沿着梯度向量的方向就是(∂f/∂x0, ∂f/∂y0)T的方向是f(x,y)增加最快的地方。或者说,沿着梯度向量的方向,更加容易找到函数的最大值。反过来说,沿着梯度向量相反的方向,也就是 -(∂f/∂x0, ∂f/∂y0)T的方向,梯度减少最快,也就是更加容易找到函数的最小值。(记住这句话就行了,不要问为什么,徒增烦恼,这句话也没几个字,反正,梯度的反方向就是下降最快的方向。)

梯度下降的求解

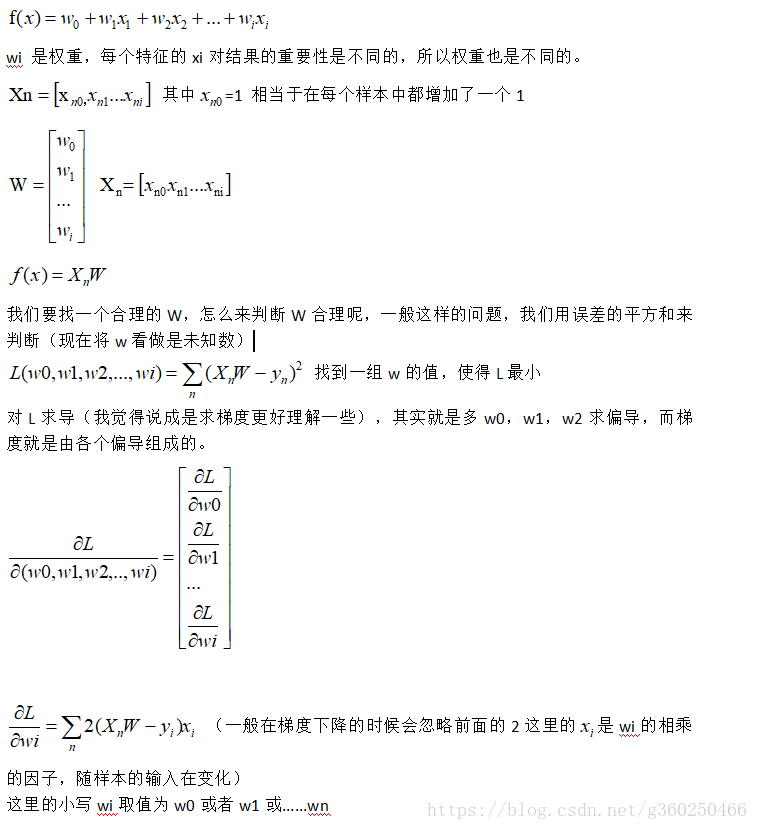

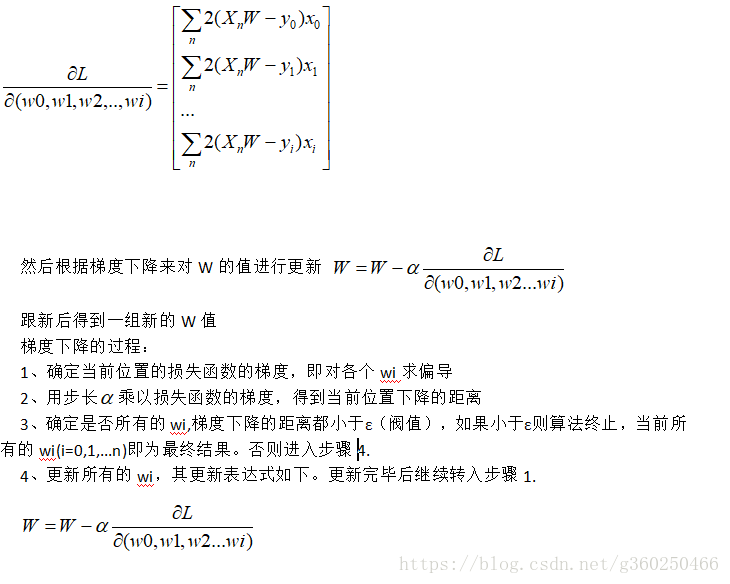

线性回归

从线性回归来看梯度下降

假设n个样本X1={x11,x12,x13,x1i:y1},X2={x21,x22,x23,x2i:y2}......Xn={xn1,xn2,xn3,xni:yn}

对于n维模型的线性回归模型

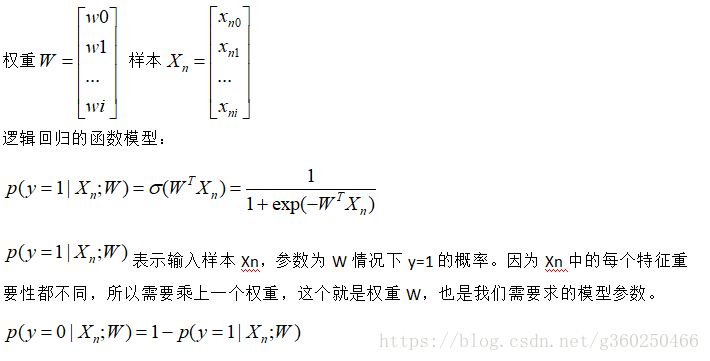

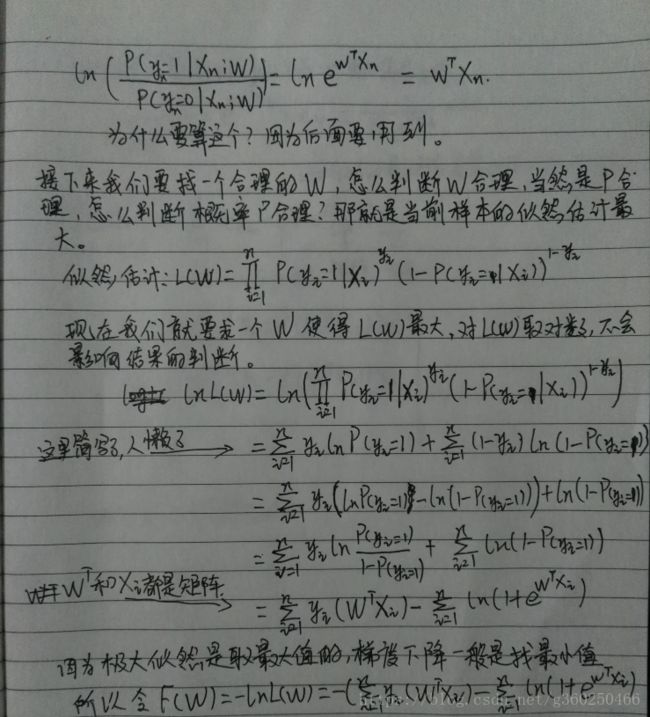

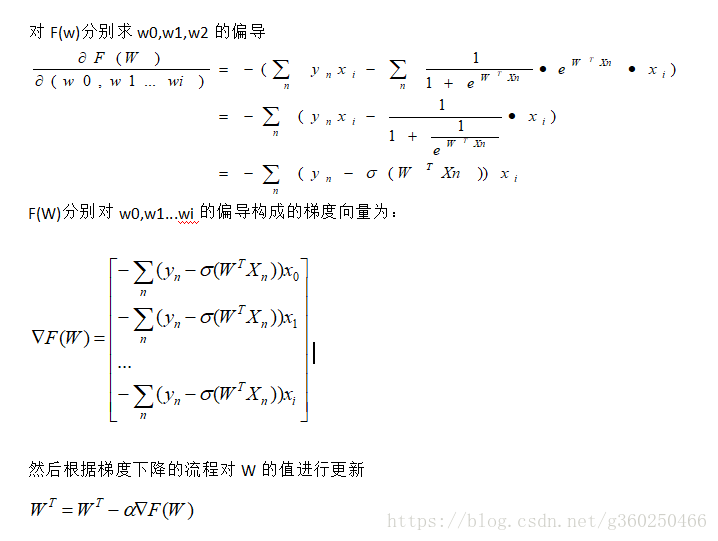

逻辑回归

逻辑回归和线性回归的不同点在于,线性回归的因变量y是连续值也是对连续值做预测(如房价,年龄、温度等)。逻辑回归是对0-1型的分类问题进行预测,如(判断男女等),逻辑回归经常用于二分类问题。

假如我们的样本是{Xn:yn} ,yn是0或者1,Xn是i为特征向量

X1={x11,x12,x13,x1i:y1},X2={x21,x22,x23,x2i:y2}......Xn={xn1,xn2,xn3,xni:yn}