ubuntu20–(2)–Windows 10 自带linux子系统-安装hbase-未完待续

hbase版本与Hadoop版本支持关系(官方)_刘本龙的专栏-CSDN博客_hbase hadoop版本

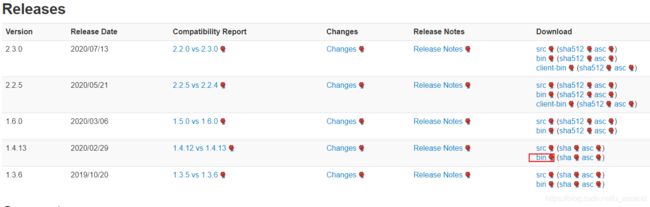

下载安装hbase

本次安装的是1.4.13(工作中用到的版本)

打开官网下载页面Apache HBase – Apache HBase Downloads

cd /usr/local/bin/

sudo wget https://mirror.bit.edu.cn/apache/hbase/1.4.13/hbase-1.4.13-bin.tar.gz

如果网络不好请切换其它连接。

解压:sudo tar -xvf hbase-1.4.13-bin.tar.gz

设置环境变量

vim ~/.bashrc

hbase环境变量

export HBASE_HOME=/usr/local/hbase

export HBASE_CONF_DIR= H B A S E H O M E / c o n f e x p o r t H B A S E C L A S S P A T H = HBASE_HOME/conf export HBASE_CLASS_PATH= HBASEHOME/confexportHBASECLASSPATH=HBASE_CONF_DIR

export PATH= P A T H : PATH: PATH:HBASE_HOME/bin

让环境变量生效

source ~/.bashrc

sudo vim /usr/local/bin/hbase-1.4.13/conf/hbase-env.sh

去掉注释并修改 export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

编辑配置文件

sudo vim /usr/local/bin/hbase-1.4.13/conf/hbase-site.xml

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://127.0.0.1:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.master.info.port</name>

<value>60010</value>

</property>

<property>

<name>hbase.tmp.dir</name>

<value>/usr/local/bin/hbase-1.4.13-data/tmp</value>

</property>

</configuration>

下载安装hadoop

1、下载

cd /usr/local/bin/

sudo wget -O hadoop http://archive.apache.org/dist/hadoop/core/hadoop-2.7.7/hadoop-2.7.7.tar.gz

2、配置

常用文件夹

sudo mkdir /usr/local/bin/hadoop-2.7.7-data -p

sudo mkdir /usr/local/bin/hadoop-2.7.7-data/tmp

sudo mkdir /usr/local/bin/hadoop-2.7.7-data/var

sudo mkdir /usr/local/bin/hadoop-2.7.7-data/dfs

sudo mkdir /usr/local/bin/hadoop-2.7.7-data/dfs/name

sudo mkdir /usr/local/bin/hadoop-2.7.7-data/dfs/data

2.1、修改core-site.xml

cd /usr/local/bin/hadoop-2.7.7/etc/hadoop

sudo vim core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/bin/hadoop-2.7.7-data/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://DESKTOP-haopd:9000</value>

</property>

</configuration>

2.2、修改hadoop-env.sh

sudo vim /usr/local/bin/hadoop-2.7.7/etc/hadoop/hadoop-env.sh

修改:export JAVA_HOME=${JAVA_HOME} 为

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

2.3、修改hdfs-site.xml

sudo vim /usr/local/bin/hadoop-2.7.7/etc/hadoop/hdfs-site.xml

<configuration>

<property>

<name>dfs.name.dir</name>

<value>/usr/local/bin/hadoop-2.7.7-data/dfs/name</value>

<description>Path on the local filesystem where theNameNode stores the namespace and transactions logs persistently.</description>

</property>

<property>

<name>dfs.data.dir</name>

<value>/usr/local/bin/hadoop-2.7.7-data/dfs/data</value> <description>Comma separated list of paths on the localfilesystem of a DataNode where it should store its blocks.</description>

</property>

<property> <name>dfs.replication</name> <value>2</value>

</property>

<property> <name>dfs.permissions</name> <value>false</value> <description>need not permissions</description> </property>

</configuration>

说明:dfs.permissions配置为false后,可以允许不要检查权限就生成dfs上的文件,方便倒是方便了,但是你需要防止误删除,请将它设置为true,或者直接将该property节点删除,因为默认就是true。

2.4、修改mapred-site.xml

如果没有 mapred-site.xml 该文件,就复制mapred-site.xml.template文件并重命名为mapred-site.xml。

cp mapred-site.xml.template mapred-site.xml

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>DESKTOP-haopd:9001</value>

</property>

<property>

<name>mapred.local.dir</name>

<value>/usr/local/bin/hadoop-2.7.7-data/var</value>

</property>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

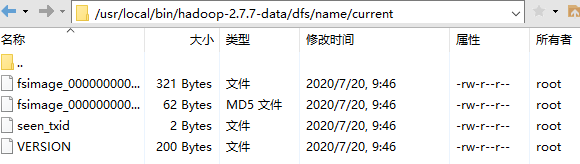

3、启动

cd /usr/local/bin/hadoop-2.7.7/bin

./hdfs namenode -format

初始化成功后,可以在/usr/local/bin/hadoop-2.7.7-data/dfs/name 目录下(该路径在hdfs-site.xml文件中进行了相应配置,并新建了该文件夹)新增了一个current 目录以及一些文件。

启动Hadoop 主要是启动HDFS和YARN

切换到/usr/local/bin/hadoop-2.7.7/sbin目录

启动HDFS

输入:sudo start-dfs.sh

如果提示没有权限,切换到对应的目录

sudo chmod 777 .ssh

启动YARN

输入:start-yarn.sh

输入 jps 查看是否成功启动

jps

输出

3507 NodeManager

3172 ResourceManager

3623 Jps

浏览器输入:http://172.18.116.6:8088/cluster

[大数据学习系列之一 ----- Hadoop环境搭建(单机) - 虚无境 - 博客园](https://www.cnblogs.com/xuwujing/p/8017108.html)

[在Ubuntu上安装Hbase - small—dong - 博客园](https://www.cnblogs.com/wxd-ld/p/11116111.html)